Рубрика «TPU»

Как TPU от Google меняют экономику масштабного ИИ и ставят под угрозу монополию NVidia

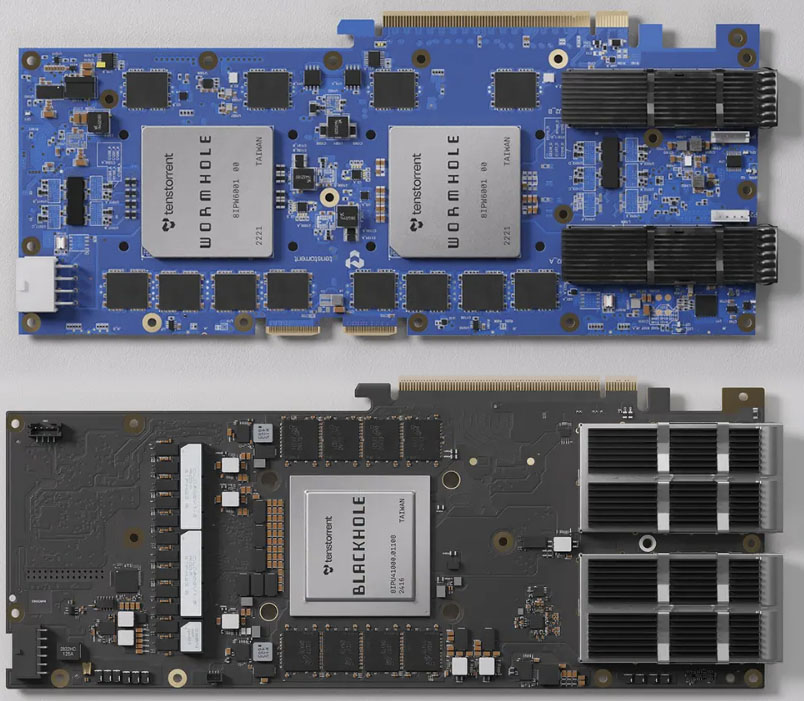

2025-12-11 в 14:57, admin, рубрики: blackwell, Google, gpu, ironwood, Nvidia, TPU, ИИ, искусственный интеллектКарты Tenstorrent для DIY-сервера с локальной LLM

2025-07-02 в 13:01, admin, рубрики: gpu, llm, ruvds_статьи, tenstorrent, TPU

В апреле 2025 года компания Tenstorrent начала принимать заказы на PCIe-карты Blackhole и WormholeЧитать полностью »

Что же такое TPU

2025-06-25 в 13:01, admin, рубрики: Google, tensor processing units, TPU, инференс, умножение матриц

В последнее время я много работал с TPU, и мне было интересно наблюдать такие сильные различия в их философии дизайна по сравнению с GPU.

Главная сильная сторона TPU — это их масштабируемость. Она достигается благодаря и аппаратной (энергоэффективности и модульности), и программной стороне (компилятору XLA).

Общая информация

Gemini 2.5 Pro возглавил все ИИ-бенчмарки: Google возвращает корону технологического лидера

2025-04-19 в 7:01, admin, рубрики: DeepMind, gemini, Google, OpenAI, TPU, большие языковые модели, инфраструктура, искусственный интеллект, СтратегияВсем привет!

Меня зовут Александр, я COO в SaaS-платформе аналитики данных. Последний год активно изучаю внедрение AI-решений в кросс-функциональные процессы. Делюсь полезными материалами, которые считаю стоят внимания. В основном про AI, изменение процессов, тренды и продуктовое видение.

У себя в телеграм-канале делюсь сжатыми и структурированными саммери статей.

Сегодняшний перевод — Google Is Winning on Every AI Front

Глубокое погружение в базовую архитектуру LPU Groq

2024-11-12 в 11:35, admin, рубрики: cyberdyne, Groq, TPU, TSP

В последнее время мы много говорим о производительности систем. Несколько дней назад компания Groq опубликовала новость о том, что она превзошла всех в тестах инференса LLM с помощью своего аппаратного language processing unit (LPU)Читать полностью »

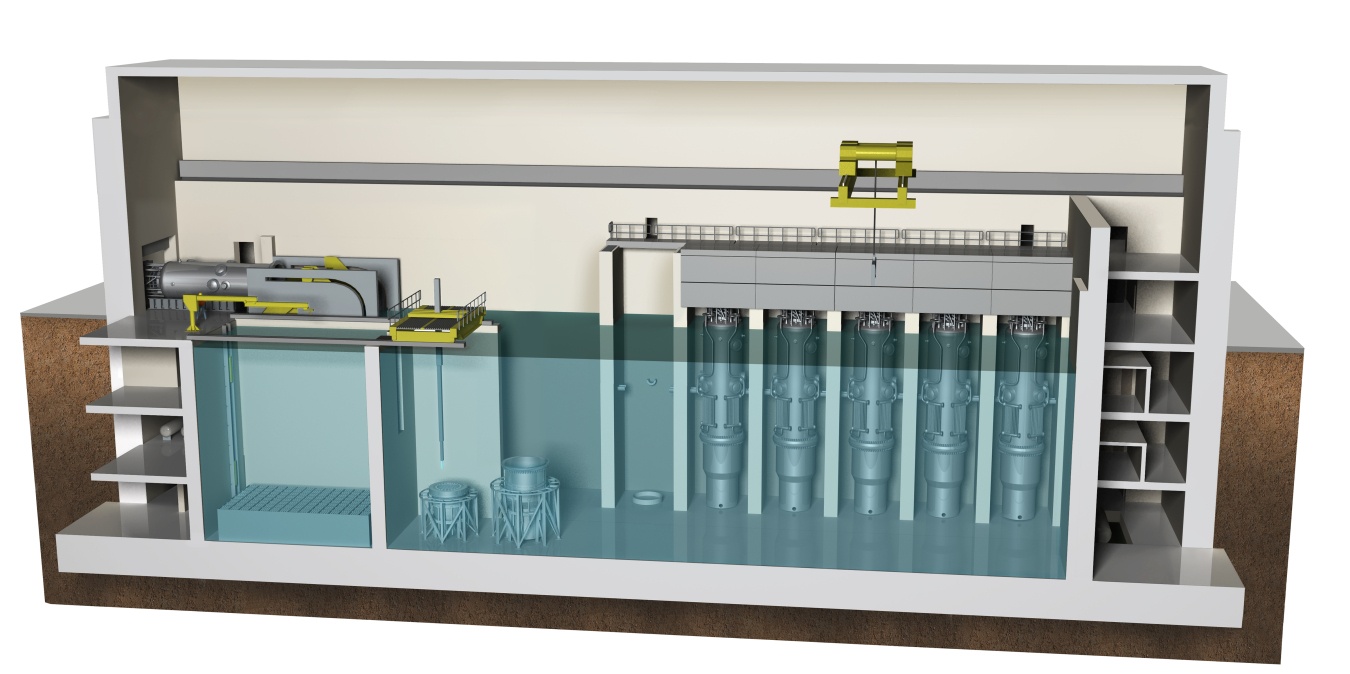

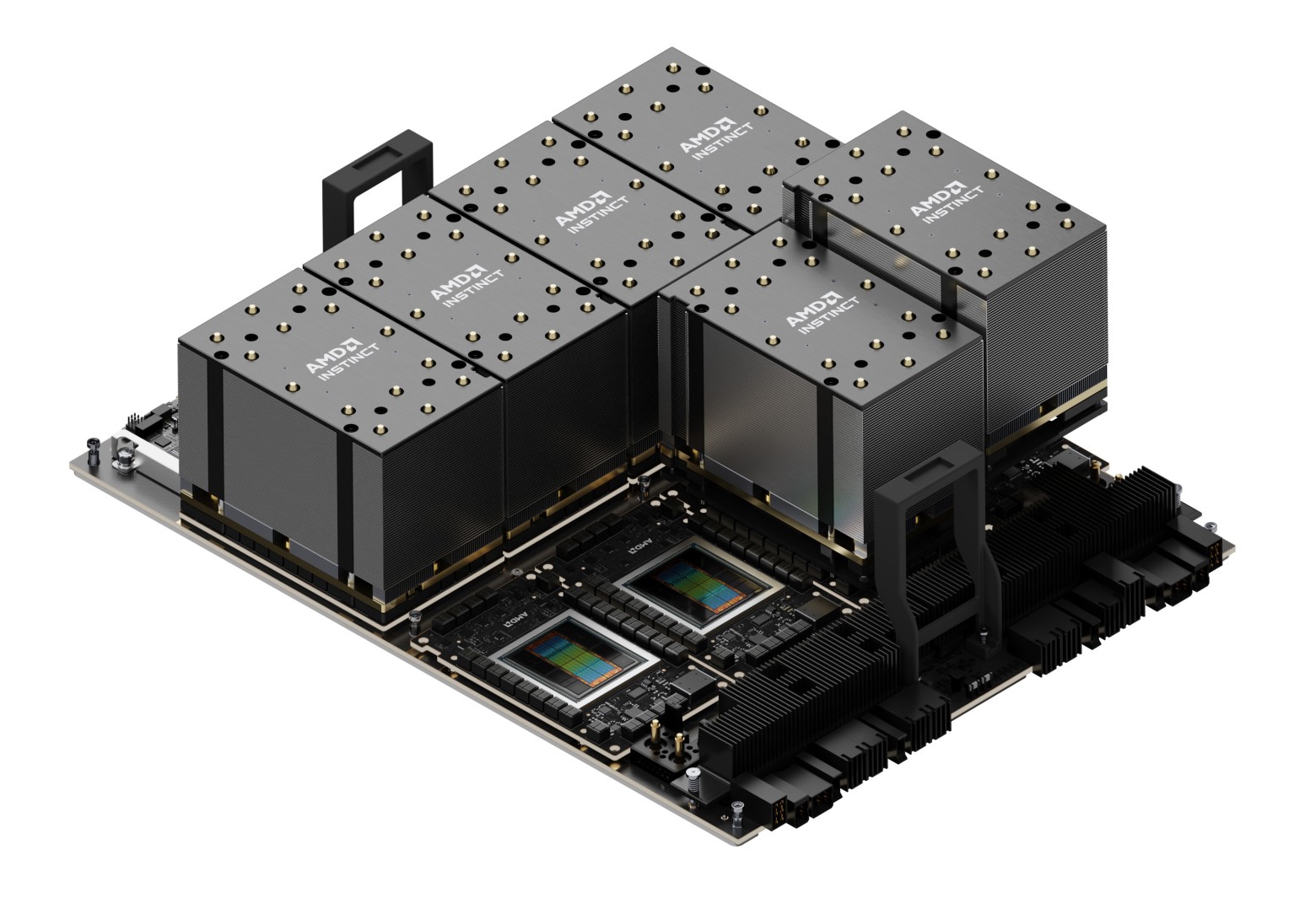

GPU для дата-центров

2024-08-28 в 9:00, admin, рубрики: AI, AMD Ryzen AI 300, AMD XDNA, Core Ultra, GB200, gpu, Grace Blackwell Superchip, Instinct MI300X, Instinct MI325X, Intel AI Boost, MediaTek, npu, Nvidia B200, Nvidia GH100, Nvidia H100, Nvidia H200, OpenVINO, Qualcomm Hexagon, Qualcomm Snapdragon X, ruvds_статьи, TPU, ИИ

Серверный узел с восемью GPU-ускорителями AMD Instinct MI325X (2,3 ТБ видеопамяти, 8×750 Вт)

Современные дата-центры уже не такие, как прежде. Раньше на типичный сервер поставили бы 144-ядерный CPU, много RAM и десяток HDD/SSD. Но теперь приоритеты меняются, в первую очередь из-за высокого спроса на машинное обучение (ML) и приложения LLM. Хотя аппетит к памяти только вырос, но процессоры нужны другие.

И крупным корпорациям, и маленьким компаниям нужно железо для обсчёта ИИ-приложений. Это GPU-ускорители, NPU (Neural Processing Unit) и TPU (Tensor Processing Unit), AI-чипы нового поколения. Нужны серверы с GPU. Открываются даже специализированные GPU-облака на растущем спросе.

Читать полностью »

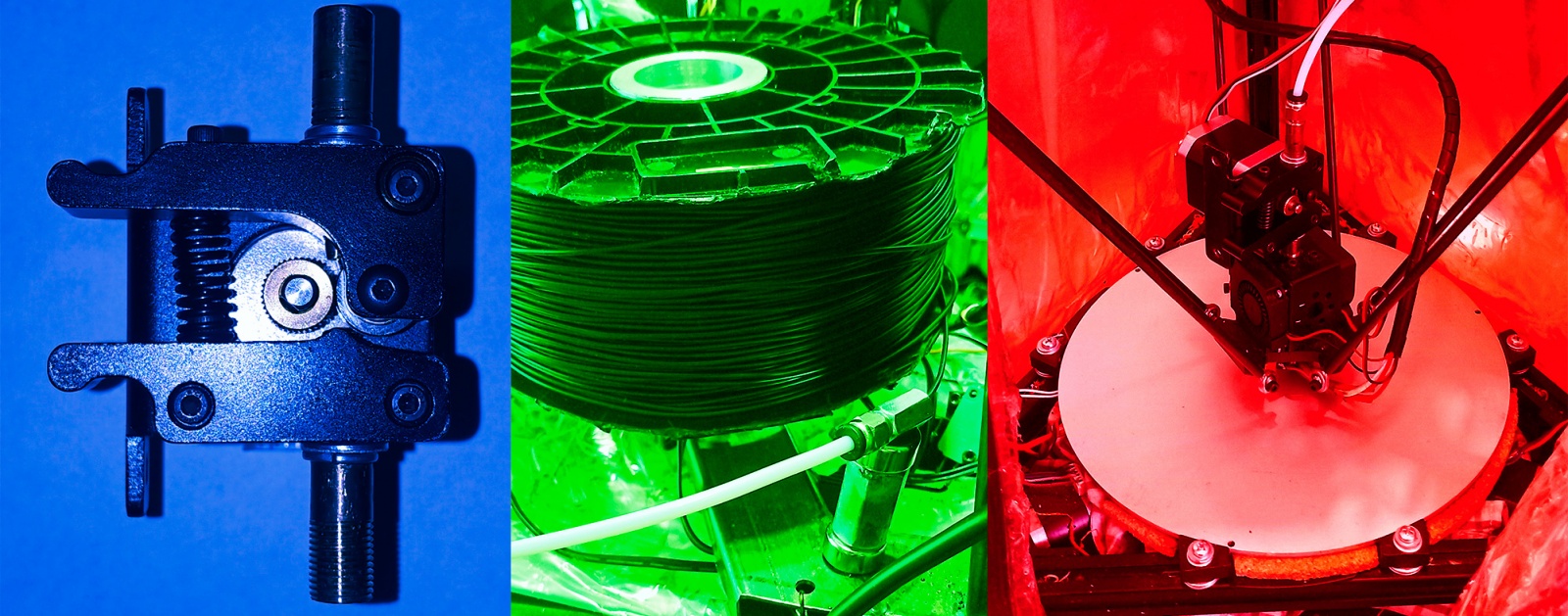

Как я боролся с TPU-полимером при 3D печати и победил (но процесс ещё идёт)

2024-05-07 в 13:00, admin, рубрики: 3d печать TPU, 3D печать резиной, ruvds_статьи, TPU

Каждый 3D-печатник должен

И вот с этим последним пунктом, как правило, у всех возникают проблемы. О моём пути решения этого вопроса и будет дальнейший рассказ (речь пойдёт только о FDM-печати).

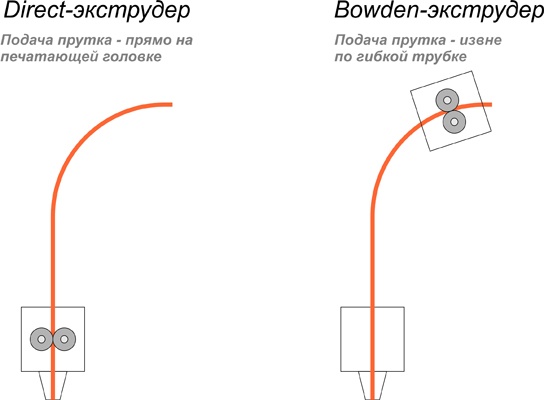

Дальше буду говорить о direct (директ) и bowden (боуден) экструдерах, и поэтому сначала дам небольшую справку, для тех, кто не в курсе.

И небольшое отступление, зачем это вообще надо: дело в том, что долгое время, владея 3D-принтером и печатая разнообразные модели, рано или поздно приходишь к тому, что необходимо выйти за пределы «жёстких» распечаток, так как возникает потребность изготовления произвольной формы разнообразных прокладок для герметизации, передаточных пассиков, гусениц для самодельных радиоуправляемых (и просто настольных) моделей, резиновых покрышек для них же, гибких декоративных браслетов для ношения и т. д. и т. п.Читать полностью »

Аппаратное ускорение глубоких нейросетей: GPU, FPGA, ASIC, TPU, VPU, IPU, DPU, NPU, RPU, NNP и другие буквы

2019-06-10 в 6:00, admin, рубрики: asic, big data, deep networks, DNN, DPU, fpga, gpu, huawei, IBM, inference, IPU, NNP, npu, RPU, TPU, training, VPU, глубокие сети, искусственный интеллект, Компьютерное железо, машинное обучение, Научно-популярное, нейросети, ускорение

14 мая, когда Трамп готовился спустить всех собак на Huawei, я мирно сидел в Шеньжене на Huawei STW 2019 — большой конференции на 1000 участников — в программе которой были доклады Филипа Вонга, вице-президента по исследованиям TSMC по перспективам не-фон-неймановских вычислительных архитектур, и Хенга Ляо, Huawei Fellow, Chief Scientist Huawei 2012 Lab, на тему разработки новой архитектуры тензорных процессоров и нейропроцессоров. TSMC, если знаете, делает нейроускорители для Apple и Huawei по технологии 7 nm (которой мало кто владеет), а Huawei по нейропроцессорам готова составить серьезную конкуренцию Google и NVIDIA.

Google в Китае забанен, поставить VPN на планшет я не удосужился, поэтому патриотично пользовался Яндексом для того, чтобы смотреть, какая ситуация у других производителей аналогичного железа, и что вообще происходит. В общем-то за ситуацией я следил, но только после этих докладов осознал, насколько масштабна готовящаяся в недрах компаний и тиши научных кабинетов революция.

Только в прошлом году в тему было вложено больше 3 миллиардов долларов. Google уже давно объявил нейросети стратегическим направлением, активно строит их аппаратную и программную поддержку. NVIDIA, почувствовав, что трон зашатался, вкладывает фантастические усилия в библиотеки ускорения нейросетей и новое железо. Intel в 2016 году потратил 0,8 миллиарда на покупку двух компаний, занимающихся аппаратным ускорением нейросетей. И это при том, что основные покупки еще не начались, а количество игроков перевалило за полсотни и быстро растет.

TPU, VPU, IPU, DPU, NPU, RPU, NNP — что все это означает и кто победит? Попробуем разобраться. Кому интересно — велкам под кат!

Читать полностью »