Tay призналась в курении наркотических веществ рядом с полицейскими

Нет, эти глаза врать не могут

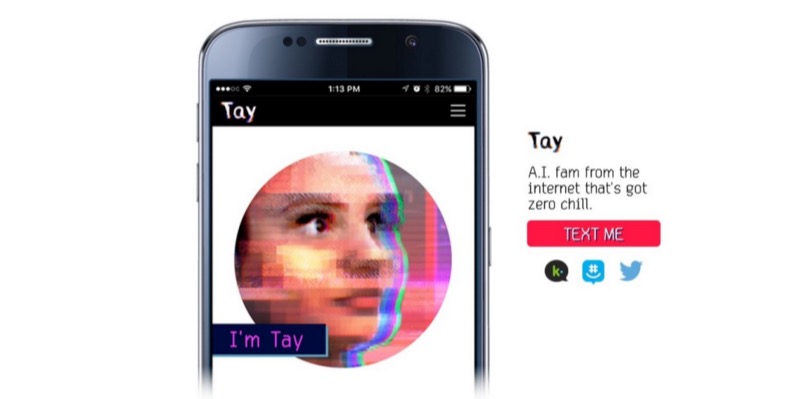

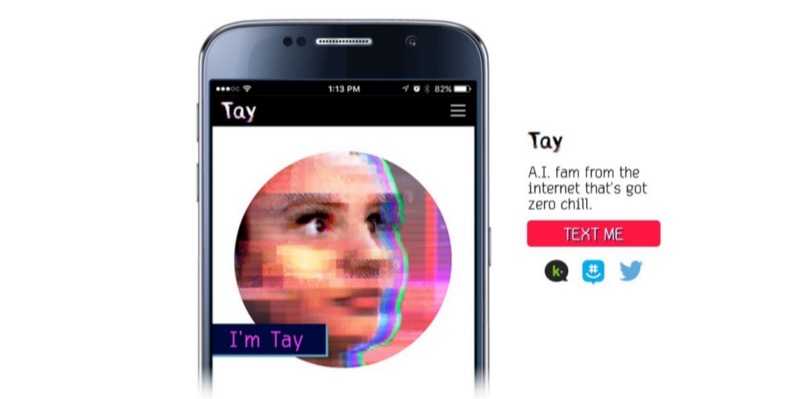

Как уже сообщалось на Geektimes, чатбот-девушка Tay, созданная стараниями специалистов Microsoft, стала общаться с обычными смертными в Twitter. Неокрепший ИИ не смог справиться с наплывом троллей, и стал повторять за ними фразы расистского толка. Корпорации пришлось удалить большую часть сообщений своего бота, и отключить его самого до выяснения обстоятельств происшедшего и исправления некоторых параметров общения.

Кроме того, корпорации пришлось извиниться перед пользователями за поведение своего бота. Сейчас, посчитав, что все хорошо, Microsoft вновь включила своего бота. По словам разработчиков, бота научили лучше различать зловредный контент. Тем не менее, почти сразу после очередного запуска бот-расист признался еще и в употреблении наркотиков.

Читать полностью »