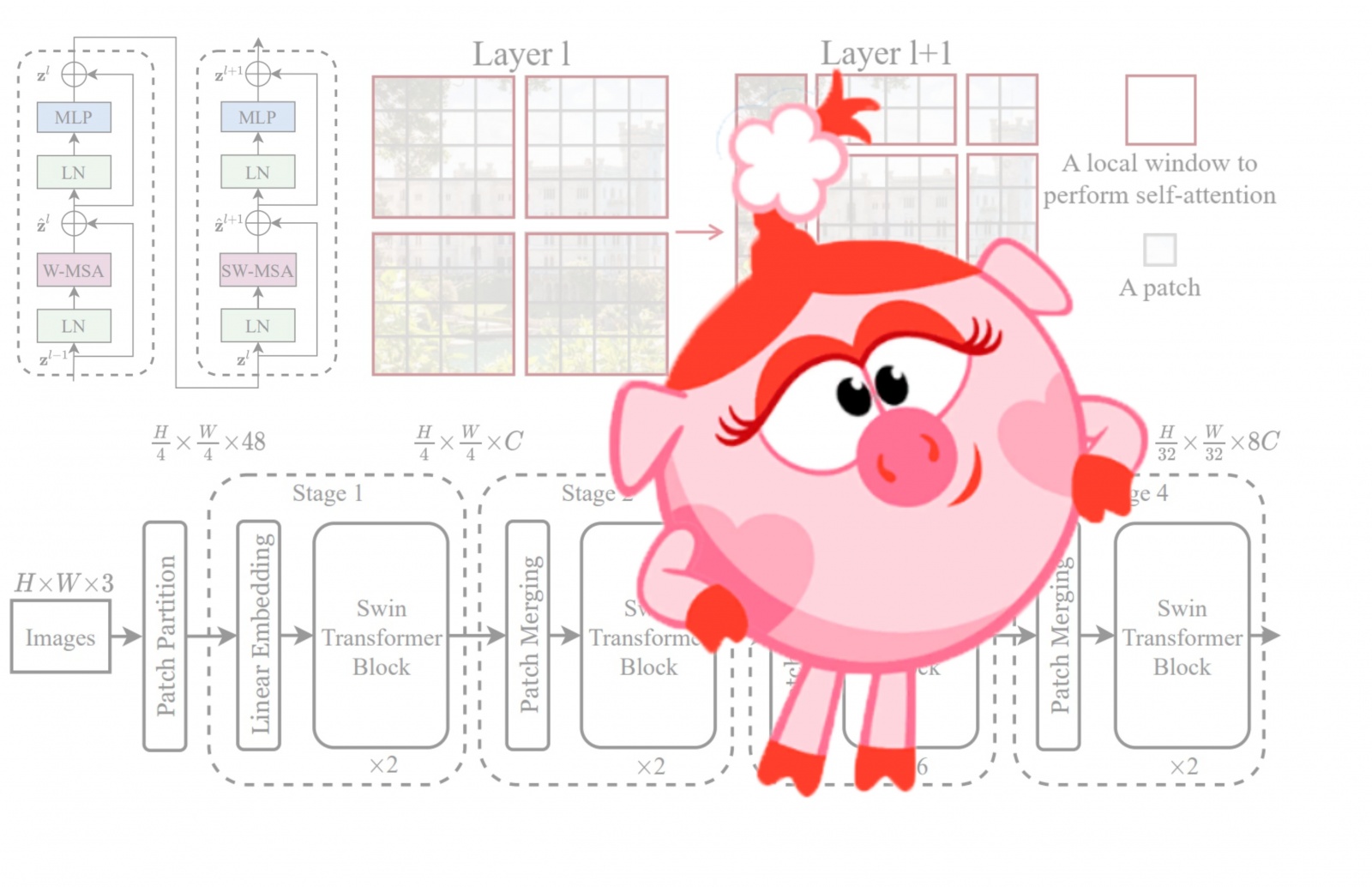

Трансформеры шагают по планете! В статье вспомним/узнаем как работает visual attention, поймём, что с ним не так, а главное как его поправить, чтобы получить на выходе best paper ICCV21.

CV-трансформеры in a nutshell

Attention Is All You Need

Начнём издалека, а именно с 2017 года, когда A Vaswani et al. опубликовали знаменитую статью «Attention Is All You Need»Читать полностью »