Я – начальник отдела разработки небольшой государственной компании, и в последнее время мне снова пришлось провести несколько десятков созвонов-собеседований, с которых мне удалось отобрать только одного человека. О том, почему выпускники скиллбоксов присылают резюме пачками, но выхлоп от обучения собственных юристов компании оказывается выше, чем от собеседований по вакансии – эта статья.

Рубрика «строки»

Базовое программирование, или Почему джуны не могут пройти к нам собеседование

2024-12-08 в 8:24, admin, рубрики: javascript, php, войти в IT, массивы, строкиstrlcpy, или как CPU противоречат здравому смыслу

2024-08-24 в 7:33, admin, рубрики: memcpy, strlen, работа со строками, строки

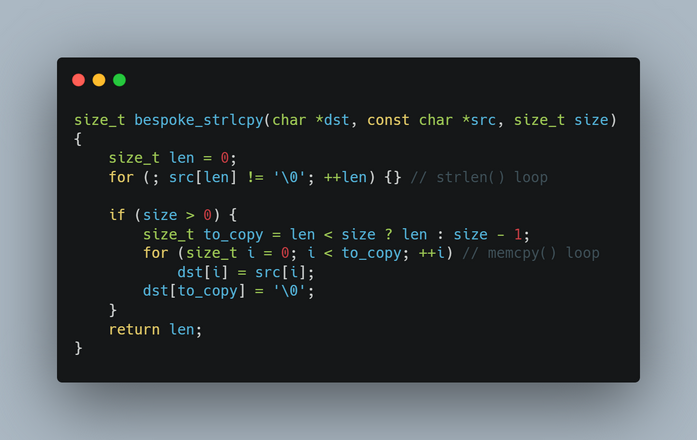

Один из моих старых постов о strlcpy недавно вызвал обсуждения на различных форумах. Вероятно, с этим как-то связан выпуск новой версии POSIX. Многие авторы приводили один контраргумент, который я слышал и раньше:

-

В общем случае, когда исходная строка умещается в конечный буфер,

strlcpyбудет обходить строку только один раз, а Читать полностью »

4 типовые ловушки в работе со строками в С и С++ и как их избежать

2024-07-30 в 11:35, admin, рубрики: безопасность данных, С++, строки, уязвимости

Некорректное использование строк может стать настоящей ахиллесовой пятой защиты программы. Поэтому так важно применять актуальные подходы к их обработке. Под катом разберём несколько паттернов ошибок при работе со строками, поговорим о знаменитой уязвимости Heartbleed и узнаем, как сделать код безопаснее.

Эволюция форматирования строк в Python

2024-07-16 в 8:23, admin, рубрики: f-строки, python, python3, интерполяция, Программирование, строки, форматирование, форматирование текста, эволюцияЧасто при написании кода на Python нам требуется представить объект определенным образом или включить значения каких-либо выражений внутрь строки. Для этого мы можем использовать форматирование строк. При этом в Python существуют сразу три способа форматирования строк:

-

оператор

% -

строковый метод

format() -

f-строки

Собственный строковый тип на Rust

2023-09-18 в 13:00, admin, рубрики: ruvds_перевод, small string optimisation, string, строки, строковые типы, структуры данных

Писать компиляторы — моё хобби, ничего не могу с собой поделать. Поэтому я пишу и много парсеров. В программировании систем обычно лучше попытаться сделать память общей, чем использовать её многократно, поэтому мои типы AST обычно выглядят так.

pub enum Expr<'src> {

Int(u32)

Ident(&'src str),

// ...

}

Когда мы парсим идентификатор, то вместо копирования его названия в новую String мы заимствуем его из входной исходной строки. Это позволяет избежать дополнительных распределений, дополнительного копирования и экономит слово на представлении данных. Компиляторы могут быть очень требовательны к памяти, поэтому стоит выбирать краткое представление.

Читать полностью »

Как изменять строки в dotnet

2023-02-25 в 11:44, admin, рубрики: .net, C#, csharp, dotnet, invoke, span, изменение строк, ненормальное программирование, строкиСтроки в dotnet являются предназначенной только для чтения последовательностью Char-ов. Об этом явно написано в документации MicrosoftЧитать полностью »

Поговорим о фичах в предварительной версии C# 11

2022-02-28 в 20:55, admin, рубрики: .net, C#, csharp, null, open source, skillfactory, Блог компании SkillFactory, дизайн, интерполяция, итераторы, проверки, Программирование, строки, строки кода

К старту курса по разработке на C# рассказываем о новых конструкциях в предварительной версии языка C# 11. Среди них шаблоны списка, проверка Parameter на null и возможность переноса строки при интерполяции строк. За подробностями приглашаем под кат.

7 ложных предположений о том, как устроены строки

2021-09-06 в 14:40, admin, рубрики: ASCII, security, software security, Unicode, безопасность, безопасность по, Блог компании Typeable, информационная безопасность, кодировки, кодировки текста, обработка строк, обработка текстов, Программирование, строки, текст, уязвимости, ЮникодКак Unicode уничтожает большинство ваших предположений о том, как на самом деле работают строки

Когда речь идет о написании чего-то простого, мы, программисты, обычно действуем интуитивно. В случае с простыми вещами мы полагаемся на четкий набор предположений вместо конкретных знаний о том, как эти вещи работают. Например, мы предполагаем, что если b = a + 1, то b больше a, или что если мы применим функцию malloc для какого-то буфера, то получим необходимое количество памяти для записи. Мы не заглядываем в документацию всякий раз, когда имеем дело с мелочами.

Мы делаем так, потому что тотальная проверка замедлит работу. Однако если бы мы все-таки провели проверку, мы бы обнаружили, что обычно ошибаемся в своих предположениях. Существует арифметическое переполнение, в результате которого a + 1 может быть значительно меньше, чем a. Иногда malloc дает нам null вместо буфера и мы оказываемся в пролете.

Нам обычно приходится обжечься на таких вещах, чтобы хотя бы немного изменить свои предположения. И даже тогда мы обычно исправляем их весьма условно.

Столкнувшись с досадной ошибкой переполнения, мы можем скорректировать свое предположение о целых числах в виде «a + 1 больше a, если отсутствует вероятность, при которой a представляет собой очень большое число». И мы действуем исходя из этого, вместо того, чтобы обдумать четкие правила, по которым работает переполнение.

Уточненные предположения – это опыт. Чаще всего они позволяют нам работать быстрее и правильнее. Однако мы можем вообще переместить некоторые вещи, например, правильную обработку malloc, из нашей внутренней категории «простые вещи» во внутреннюю категорию «сложные вещи». И тогда мы действительно можем пойти и уточнить, как они работают.

Поиск анаграмм и сабанаграмм во всех словах языка

2020-03-29 в 14:17, admin, рубрики: java, trie, Алгоритмы, анаграмма, деревья, задачи, задачи для программистов, Занимательные задачки, префиксное дерево, Программирование, строкиРешение задач с анаграммами натолкнуло на мысль:

Сколько останется слов, если удалить все анаграммы и сабанграммы из словаря русского языка

В найденном словаре больше 1,5 млн слов в различных формах

Можно сравнить каждое слово с каждым, но для 1,5 млн записей это долго и неоптимально.

В мире с бесконечной памятью можно сгенерировать подстроки всех перестановок каждого слова и проверить наш словарь на них

Но есть ли решение получше?

Читать полностью »

Оптимизация строк в ClickHouse. Доклад Яндекса

2020-03-18 в 10:22, admin, рубрики: clickhouse, mysql, string, Администрирование баз данных, Блог компании Яндекс, высокая производительность, строки, типы данныхАналитическая СУБД ClickHouse обрабатывает множество разных строк, потребляя ресурсы. Для ускорения работы системы постоянно добавляются новые оптимизации. Разработчик ClickHouse Николай Кочетов рассказывает о строковом типе данных, в том числе о новом типе, LowCardinality, и объясняет, как можно ускорить работу со строками.

— Сначала давайте разберемся, как можно хранить строки.

Читать полностью »