Сразу скажу главное — заявление про «цену дисковой» касается только специальных акционных цен на Unity, которые EMC дало нам как официальному партнеру в России под промо новой модели СХД. Акция касается не всех, детали в почту. Обычные же цены — просто крепкий хороший midrange под свою специфику.

Итак, поехали. EMC уже много лет неравнодушна к флешам, но в прошлом году конкретно заморочилась, решив, что будущее за ним. И выпустило рабочую и не очень дорогую штуку. Это почти что обычный мидрейндж с SSD-дисками (нюансы чуть позже). Никаких «втыкаем лом, а она продолжает работать», но зато внушительная производительность под базы данных и виртуалки плюс разные мелкие фишки.

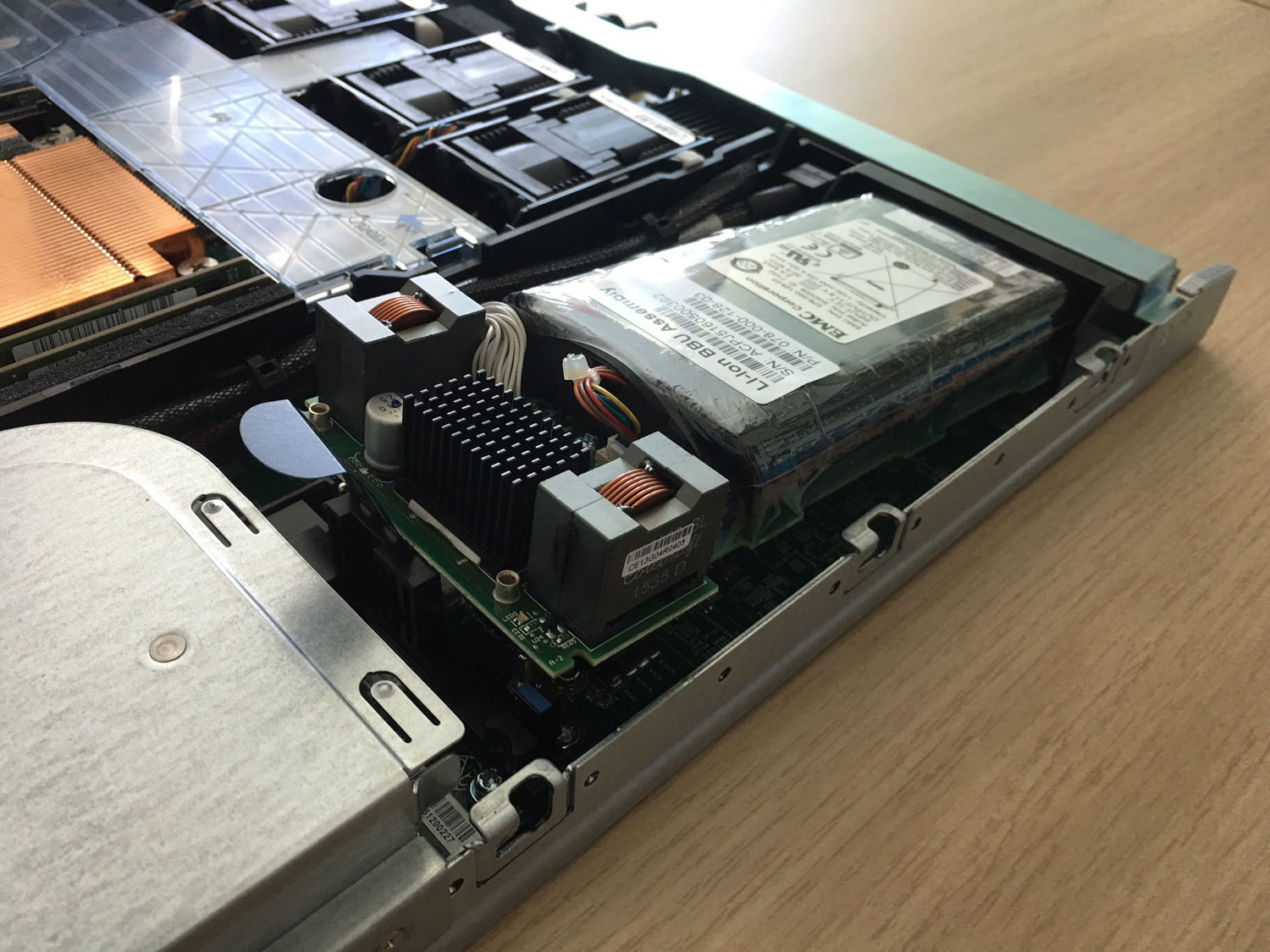

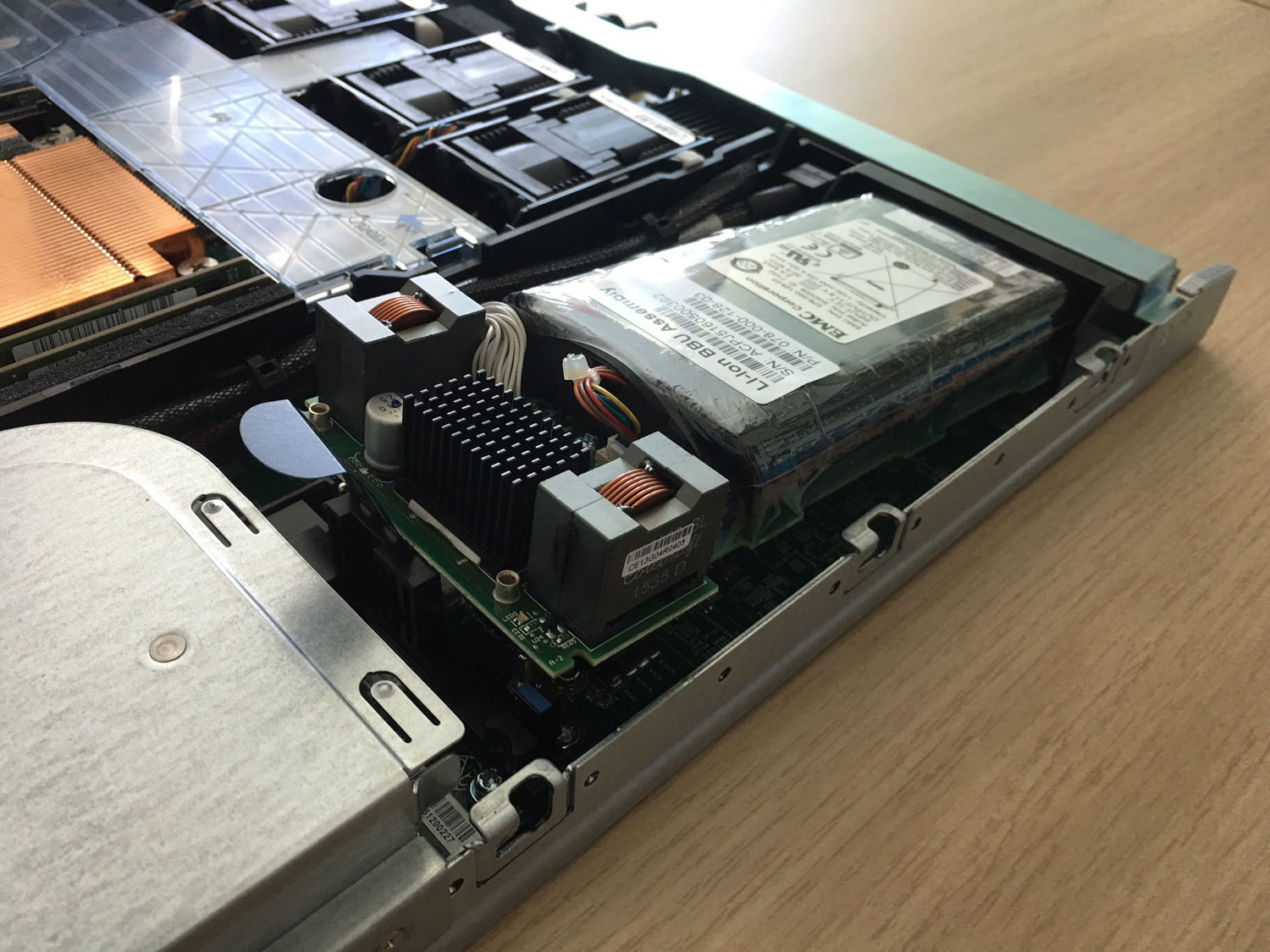

Вот яркий пример оптимизации — раньше тут был отдельный ИБП-модуль в своём кожухе, и он менялся «на горячую». А теперь — Li-ion батарея с полиэтиленовой защитой от протечки внутри контроллера.

А ещё они наступили многим вендорам на любимую мозоль и сделали цену поддержки одинаковой на всё время. А то, знаете ли, многие большие вендоры любят ставить такую цену на 4-й и 5-й год, что проще заменить железо на новое. Ну и да, у этих ребят выход из строя диска по износу считается гарантийным случаем, не в пример некоторым любителем звездочек и мелкого шрифта в гарантийной политике.

Всё, теперь пошли втыкать в неё лом и тестировать. Забегая вперёд скажу, что с 9 дисков сняли 80 тысяч иопсов. Читать полностью »