Представьте, что мы хотим написать на обычном SQL запрос не в базу данных, а к логам. В работе может возникнуть задача анализа логов, для которой потребуется делать запросы на SQL к неструктурированному набору данных, который даже не находится в СУБД. В этой заметке я расскажу о примере использования Spark SQL для выявления правил (логики) выбора необходимых документов из большого хранилища.

Рубрика «spark» - 6

Анализ логов с помощью SQL?

2016-07-10 в 12:35, admin, рубрики: data mining, php, spark, sql, Разработка веб-сайтовОсновная цель статьи — поделиться практическим опытом создания и анализа индексов с помощью Spark SQL. Разумеется, это настолько обширная тема, что данная статья только поверхностно коснётся основных подходов в контексте упомянутой задачи. Создание индексов часто требуется после сложного анализа огромного числа документов. Допустим, аналитическая система записывает в лог уникальный идентификатор документа и ряд его метрик. Необходимо проанализировать этот отчёт, чтобы выбрать только необходимые идентификаторы документов.

Spark Summit 2016: обзор и впечатления

2016-07-04 в 11:34, admin, рубрики: analytics, Apache Spark, big data, data mining, data science, machine learning, spark, wrike, Анализ и проектирование систем, Блог компании Wrike, хранение данных

В июне прошло одно из самых крупных мероприятий мира в сфере big data и data science — Spark Summit 2016 в Сан-Франциско. Конференция собрала две с половиной тысячи человек, включая представителей крупнейших компаний (IBM, Intel, Apple, Netflix, Amazon, Baidu, Yahoo, Cloudera и так далее). Многие из них используют Apache Spark, включая контрибьюторов в open source и вендоров собственных разработок в big data/data science на базе Apache Spark.

Мы в Wrike активно используем Spark для задач аналитики, поэтому не могли упустить возможности из первых рук узнать, что происходит нового на этом рынке. С удовольствием делимся своими наблюдениями.

Отчет с Moscow Data Science Meetup 27 мая

2016-06-24 в 14:45, admin, рубрики: big data, data science, kaggle, mail.ru, spark, Алгоритмы, Блог компании Mail.Ru Group, машинное обучение

27 мая в офисе Mail.Ru Group прошёл очередной Moscow Data Science Meetup. На встрече собирались представители крупных российских компаний и научных организаций, а также энтузиасты в области машинного обучения, рекомендательных систем анализа социальных графов и смежных дисциплин. Гости делились друг с другом своим опытом решения практических задач анализа данных. Предлагаем вашему вниманию видеозаписи и презентации трёх докладов, представленных на встрече.

Читать полностью »

Началось соревнование «Make with Ada» для разработчиков встраиваемых систем

2016-06-21 в 17:39, admin, рубрики: spark, верификация, конкурс, параллельное программирование, программирование микроконтроллеров, Совершенный код, Спортивное программирование, Тестирование IT-систем

AdaCore организует новый конкурс для разработчиков. Как и в прошлые разы, на подготовку даётся существенно больше времени, чем в олимпиадах по иноформатике. Это как раз подходит тем, кому не нравятся соревнования по быстрому написанию страшного кода, который потом только выбросить.

Сегодня на повестке дня — разработка для ARM на голом железе и технологии верификации. Общий призовой фонд — более 8000€.

Читать полностью »

Курс молодого бойца для Spark-Scala

2016-06-07 в 13:50, admin, рубрики: big data, data mining, data science, Hadoop, scala, spark, Блог компании Retail Rocket, машинное обучениеКоманда Retail Rocket использует узкоспециализированный стек технологий Hadoop + Spark для вычислительного кластера, о котором мы уже писали обзорный материал в самом первом посте нашего инженерного блога на Хабре.

Готовых специалистов для таких технологий найти довольно сложно, особенно, если учесть, что программируем мы исключительно на Scala. Поэтому я стараюсь найти не готовых специалистов, а людей, имеющих минимальный опыт работы, но обладающих большим потенциалом. Мы берем даже людей с частичной занятостью, чтобы было удобно совмещать учебу и работу, если кандидат — студент последних курсов.

21 популярная и 21 непопулярная технология в IT

2016-03-31 в 13:14, admin, рубрики: android, big data, cpu, css, docker, flash, geekbrains, github, gpu, Hadoop, iaas, iOS, javascript, node.js, paas, php, ruby, spark, Блог компании GeekBrains, ИИ, препроцессоры, Программирование, Сетевые технологии, технологии

Популярно или не очень? Посмотрим, что приходит и уходит в мире разработки.

Программисты любят иронизировать над миром моды, где ветра трендов дуют туда-сюда. Юбки становятся длиннее и короче, цвета приходят и уходят, галстуки становятся шире, потом уже. Но в мире технологий строгость, наука, математика и точность господствуют над причудой.

Это не значит, что программирование — профессия, лишенная тенденций. Разница в том, что тенденции программирования управляются большей эффективностью, увеличенной вариативностью и простотой использования. Новые технологии по большей части затмевают предыдущие. Это меритократия, а не власть прихоти.

Дальше список популярного и не очень популярного среди программистов сегодня. Не все согласятся с этим списком. Это то, что делает программирование бесконечно увлекательной профессией: быстрые изменения, жаркие дебаты и внезапные возвращения.Читать полностью »

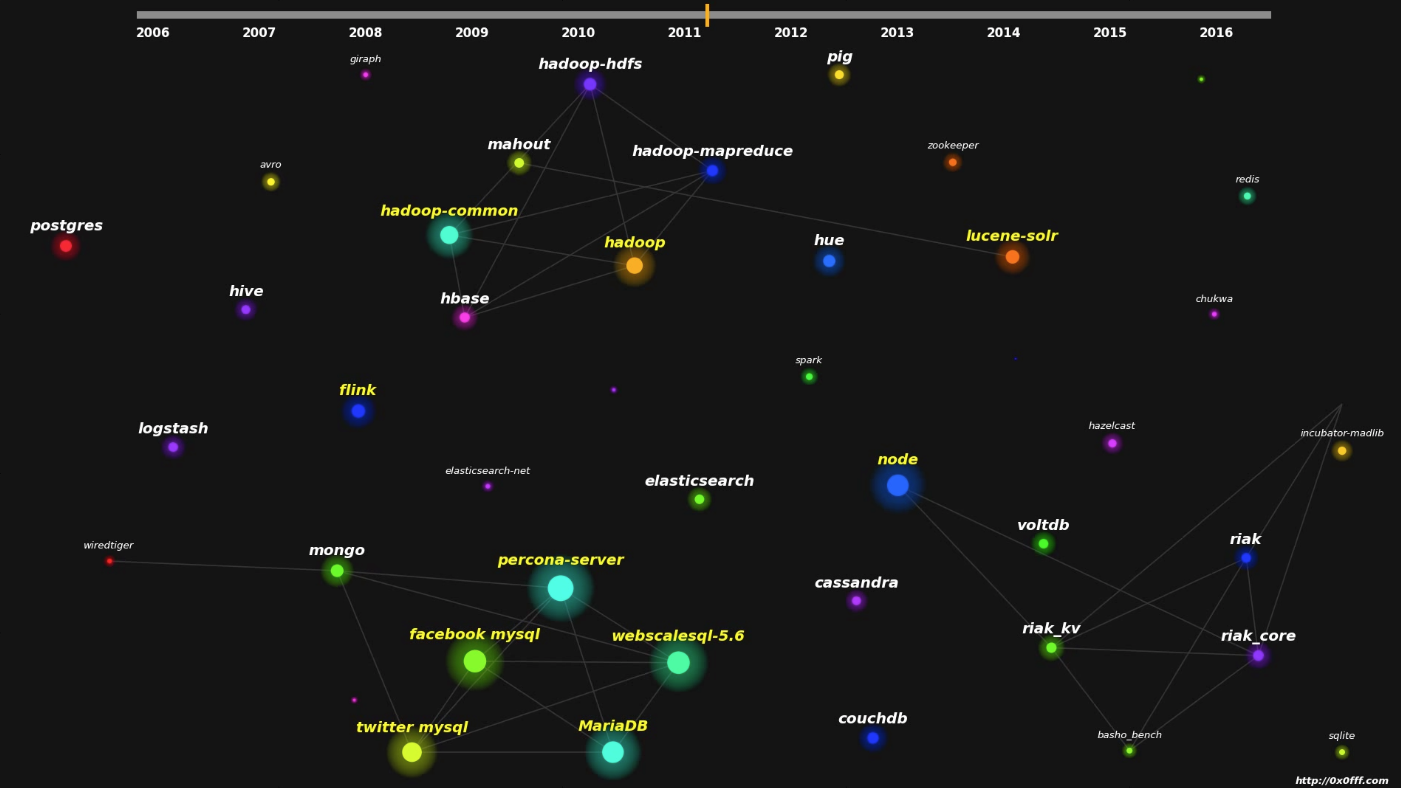

Визуализация инструментов обработки данных с Github

2016-03-29 в 9:31, admin, рубрики: big data, github, Hadoop, mysql, nosql, postgres, postgresql, spark, sql, visualizationВ своей работе вы используете MySQL, Postgres или Mongo, а может даже Apache Spark? Хотите знать с чего начинались эти проекты и куда они движутся сейчас? В этой статье я представлю соответствующую визуализацию

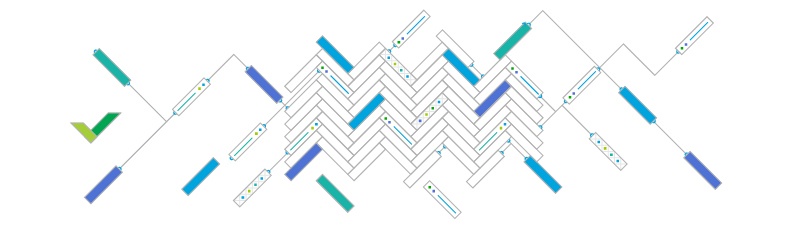

Как использовать Parquet и не поскользнуться

2016-03-21 в 22:22, admin, рубрики: analysis data, analytics, Apache, big data, data formats, distributed computing, parquet, spark, Анализ и проектирование систем, Блог компании Wrike, хранение данных, метки: parquet

О хранении данных в Parquet-файлах не так много информации на Хабре, поэтому надеемся, рассказ об опыте Wrike по его внедрению в связке со Spark вам пригодится.

В частности, в этой статье вы узнаете:

— зачем нужен “паркет”;

— как он устроен;

— когда стоит его использовать;

— в каких случаях он не очень удобен.