Статья в большей степени ориентирована на тех, кто администрирует или создает гибридное системное окружение, где основой является Windows домен и требуется иметь возможность авторизации пользователей на других платформах и системах с централизованной системой хранения учетных данных. В большинстве случаев проблем у вас не будет, но вот если вам понадобиться реализовать авторизацию, к примеру, с использованием CRAM-MD5 или другой схемы авторизации (которой нет в AD), да и вообще не поддерживающей LDAP (или не понимающие LDAP в понимание Microsoft), то эта статья для вас.

Читать полностью »

Рубрика «системное администрирование» - 303

Microsoft ActiveDirectory — обновление паролей пользователей во внешних хранилищах

2014-10-06 в 11:01, admin, рубрики: ActiveDirectory, linux, PCNS, powershell, Серверное администрирование, системное администрированиеВыбираем панель управления хостингом

2014-10-03 в 8:21, admin, рубрики: ajenti-v, control panel, cpanel, ispconfig, ispmanager, plesk manager, selectel, vesta, Блог компании Селектел, панель управления хостингом, селектел, системное администрирование, хостинг

Панелью управления хостингом называется программный инструмент, позволяющий через графический интерфейс управлять веб-сервером и размещенными на нем сайтами. C помощью панели управления можно выполнять такие операции, как управление почтовыми сервисами, FTP-аккаунтами, базами данных, добавление и удаление доменов и поддоменов, загрузка файлов, просмотр статистики по трафику, настройка предустановленных скриптов и другие.

Как отдельный продукт панели управления хостингом стали широко использоваться в конце 1990-х годов. За прошедшее с тех пор время они очень изменились и усовершенствовались. Сегодня на рынке представлено огромное количество решений для управления хостингом — как свободных, так и проприетарных. Как из всего этого многообразия выбрать действительно стоящий продукт?

В Интернете можно найти публикации, в которых сравниваются имеющиеся панели (вот, например, неплохой переводной материал; см. также здесь). Мы решили составить собственный обзор, в котором акценты расставлены несколько по-иному, чем в опубликованных ранее. Одним из основных критериев, положенных в основу нашего обзора, является поддержка панелями веб-серверов и их комбинаций. Кроме того, в нашей статье мы рассматриваем продукты, в публикации по ссылкам выше не вошедшие.

Читать полностью »

ЛОЦМАН: Пишем свой WorkFlow-конфигуратор. Начало

2014-10-01 в 9:30, admin, рубрики: pypyodbc, pyside, python, qt, sql, системное администрированиеВведение

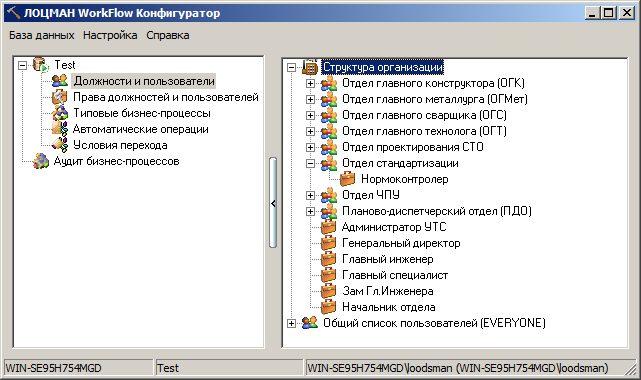

Я работаю в организации, которая начала внедрять ПО от компании АСКОН, если быть точным, то «Комплекс решений АСКОН 2013» (далее «Комплекс») + КОМПАС. Я занимаюсь администрированием этого «Комплекса». «Комплекс» имеет трехуровневую архитектуру (Клиент-Сервер приложений-Сервер БД). Ключевым продуктом «Комплекса» является ЛОЦМАН:PLM, также имеется набор утилит администрирования. Одна из утилит администрирования называется «ЛОЦМАН WorkFlow Конфигуратор» (далее WF-конфигуратор).

Рисунок 1 — ЛОЦМАН WorkFlow конфигуратор

В ходе работы были выявлены основные недостатки WF-конфигуратора:

- Нет русскоязычного поиска по ФИО, есть только по логину (причем только в виде доменлогин, кстати в «Центре управления комплексом», там где добавляются пользователи в систему, вообще нет никакого поиска...);

- При большом количестве пользователей (>1K) он стал ужасно тормозить (около 4 минут на операцию добавления пользователя).

Поскольку пользователей приходилось добавлять часто и много, пришлось придумать, как оптимизировать этот процесс.

Читать полностью »

Курсы информационных технологий Яндекса. Жизнь до и после

2014-09-29 в 11:35, admin, рубрики: iaas, openstack, Yandex, Блог компании Яндекс, системное администрирование, Учебный процесс в ITПривет! Меня зовут Данил Ахметов, и ещё год назад я не был сотрудником Яндекса. А сейчаc работаю в команде, которая разрабатывает внутреннее IaaS-решение масштаба всего Яндекса. Попал я в неё не сразу — сначала были Курсы информационных технологий и стажировка в одном из самых критичных в смысле отказоустойчивости направлений — баннерной системе.

Так как недавно Яндекс объявил новый набор на КИТ, я решил рассказать вам о том, какой опыт я там получил и что они могут дать вам. Регистрация открыта до 7 октября, и, хотя мест уже не так много, я надеюсь, что кому-то мой рассказ поможет решиться пойти учиться и, может быть, немного изменить свою жизнь.

Пару лет назад я закончил Ульяновский государственный университет по специальности «Прикладная информатика». Дипломную работу писал о кластерах, суперкомпьютерах и перспективах распределенных вычислений. Меня пригласили админить в не очень большую компанию, разрабатывающую юридическую справочно-информационную систему. Работа была интересной, была почти полная свобода в решении имеющихся задач — все шло своим чередом. Вряд ли бы многое изменилось, если бы 18 октября 2013 года тимлид отдела разработки веб-версии справочного продукта не прислал мне ссылку на страницу предстоящего КИТа, четвертого по счету.

Читать полностью »

Окружение, опережающее мысль

2014-09-29 в 10:38, admin, рубрики: launchy, plumb, putty, Оболочки, оптимизация рабочего времени, системное администрирование  Если эффективной работе в cli/bash/vim посвящены сотни статей, то теме организации рабочего окружения сисадмина — едва ли несколько штук. Чаще всего это скриншоты какого-нибудь Enlightenment с 1 прозрачным терминалом, часам, календарем, 15 виджетами загрузки CPU и голой анимешной бабой на фоне. Подходит для фильма «Хакеры», не подходит для работы. Нам требуется, чтобы терминал появлялся еще до того, как мы об этом подумали, выполнял свою работу и исчезал бесследно до следующего такта.

Если эффективной работе в cli/bash/vim посвящены сотни статей, то теме организации рабочего окружения сисадмина — едва ли несколько штук. Чаще всего это скриншоты какого-нибудь Enlightenment с 1 прозрачным терминалом, часам, календарем, 15 виджетами загрузки CPU и голой анимешной бабой на фоне. Подходит для фильма «Хакеры», не подходит для работы. Нам требуется, чтобы терминал появлялся еще до того, как мы об этом подумали, выполнял свою работу и исчезал бесследно до следующего такта.

Читать полностью »

Отслеживаем удаление файлов на PowerShell

2014-09-29 в 1:56, admin, рубрики: powershell, аудит файловых серверов, системное администрированиеПривет! Тема моего поста уже поднималась здесь, но мне есть, что добавить.

Когда наше файловое хранилище разменяло третий терабайт, все чаще наш отдел стал получать просьбы выяснить, кто удалил важный документ или целую папку с документами. Нередко это происходит по чьему-то злому умыслу. Бэкапы — это хорошо, но страна должна знать своих героев. А молоко вдвойне вкусней, когда мы можем написать его на PowerShell.

Пока разбирался, решил записать для коллег по цеху, а потом подумал, что может пригодиться кому-то еще. Материал получился смешанный. Кто-то найдет для себя готовое решение, кому-то пригодятся несколько неочевидные методы работы с PowerShell или планировщиком задач, а кто-то проверит на быстродействие свои скрипты.

В процессе поиска решения задачи прочитал статью за авторством Deks. Решил взять ее за основу, но некоторые моменты меня не устраивали.

- Во-первых, время генерации отчета за четыре часа на 2-терабайтном хранилище, с которым одновременно работает около 200 человек, составило около пяти минут. И это притом, что лишнего у нас в логи не пишется. Это меньше, чем у Deks, но больше, чем хотелосю бы, потому что...

- Во-вторых, все то же самое нужно было реализовать еще на двадцати серверах, гораздо менее производительных, чем основной.

- В-третьих, вызывал вопросы график запуска генерации отчетов.

- И в-четвертых, хотелось исключить себя из процесса доставки собранной информации конечным потребителям (читай: автоматизировать, чтобы мне с этим вопросом больше не звонили).

Но ход мыслей Deks мне понравился...

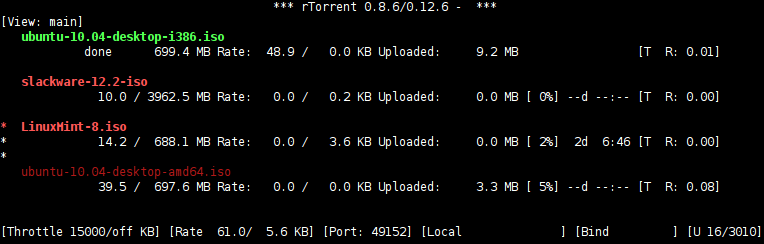

Разбираемся с rtorrent всерьёз

2014-09-28 в 0:49, admin, рубрики: linux, Peer-to-Peer, rtorrent, документация, настройка, ненормальное программирование, системное администрирование, торрент-клиентОб установке и базовой настройке rtorrent на хабре хватает статей, как и споров о том, стоит ли вообще связываться с хардкорным rtorrent или лучше обойтись чем-нибудь более дружественным к пользователю. Лично я много лет назад пересмотрел все качалки и в результате rtorrent оказался самым стабильным и эффективным. Интерфейс у него не самый удобный, но достаточно понятный и юзабельный чтобы это не стало серьёзной проблемой. Альтернативные интерфейсы вроде rutorrent у меня как-то не прижились - ставить php только ради rutorrent неохота, а остальные варианты выглядят совсем слабо (и ни одного кроме rutorrent даже нет в портаж Gentoo).

Одно из основных преимуществ rtorrent — очень гибкие возможности по его настройке и автоматизации. К сожалению, синтаксис ~/.rtorrent.rc достаточно нестандартный, нормальная документация отсутствует, поэтому обычно настройка сводится к поиску и копированию (попытка что-то в них изменить кроме констант/путей к каталогам обычно проваливается) готовых рецептов или вообще ограничивается редактированием констант в базовой конфигурации.

На днях я решил, что так дальше продолжаться не может — мы очень много лет знакомы, он для меня столько хорошего выкачал, а я всё никак не познакомлюсь с ним по-ближе! Не скажу, что досконально с ним разобрался, но по крайней мере я смог реализовать все свои идеи по автоматизации rtorrent, и сделал это понимая, что и почему я делаю, без шаманства с чужими рецептами.

Fail2ban [incremental]: Лучше, быстрее, надежнее

2014-09-26 в 15:39, admin, рубрики: ban-time-incr, fail2ban, linux, информационная безопасность, системное администрирование ![Fail2ban [incremental]: Лучше, быстрее, надежнее fail2ban image](https://www.pvsm.ru/images/blank.gif)

Про fail2ban написано уже много, в том числе и на хабре. Эта статья немного о другом — как сделать защиту им еще надежнее и о еще пока неизвестных в широких кругах новых функциях fail2ban. Добавлю сразу — речь пойдет пока про development branch, хотя уже долго проверенный в бою.

Краткое вступление

В большинстве своем fail2ban устанавливается из дистрибутива (как правило это какая-нибудь стабильная старая версия) и настраивается по манам из интернета за несколько минут. Затем годами работает, без вмешательства админа. Нередко даже логи, за которыми вроде как следит fail2ban, не просматриваются.

Так вот, сподвигнуть на написание этого поста меня заставил случай, произошедший с одним сервером моего хорошего знакомого. Классика жанра — пришла абуза, за ней вторая и пошло поехало. Хорошо еще злоумышленник попался ленивый — логи не потер, да и повезло еще крупно, что logrotate был настроен, чтобы хранить логи месяцами.

Оказалось все довольно банально, подобрали пароль к его админской почте, который по совместительству был паролем для ssh (естественно без ключа). Не рут, но судоер, со всеми вытекающими. Первый его вопрос был: как подобрали — у меня же fail2ban там. И вот здесь как раз засада: не все представляют себе, что подбором паролей сегодня занимаются уже не отдельные компьютеры, а целые бот-сети, кстати поумневшие донельзя. Так вот по логам выяснили, что тут как раз такой случай: перебирала бот-сеть, причем на практике выяснившая его настройки в fail2ban (maxRetry=5, findTime=600 и banTime=600). Т.е. чтобы избежать бана, сеть делала 4 попытки в течении 10 минут с каждого IP. На минуточку в сети порядка 10 тысяч уникальных IP = что-то более 5 с половиной миллионов паролей в сутки.

Кроме того его почтовик делал большую глупость — а именно паузу до 10 секунд, при логине с неправильным именем. Т.е. выяснить, что некоторые имена, в том числе admin, реально имеются, этой сетке не составило труда. Далее шел целенаправленный перебор только паролей для имеющихся имен.

Подробнее на «ремонте» останавливаться не буду — это история долгая, и вообще тема для отдельной статьи. Скажу только, что все почистили и все разрешилось малой кровью, да и отделался он практически «легким» испугом.

Так вот, мысль написать статью возникла после того, как мне (частично заслужено) было высказано: «Так ты про такое знал и ничего не сказал, не предупредил. Да еще и решение есть и не поделился. Ну и сволочь ты». Короче, посему посту — быть.

Jump start 7 октября. Модернизация ИТ-инфраструктуры компании с помощью Windows Server 2012 R2

2014-09-26 в 7:10, admin, рубрики: active directory, powershell, storage, windows server 2012 r2, Блог компании Microsoft, ит-инфраструктура, системное администрирование, СХДУважаемые коллеги!

Предлагаем вашему вниманию онлайн мероприятие, посвященное вопросам модернизации ИТ-инфраструктуры организации с помощью Windows Server 2012 R2.

SSD + raid0 — не всё так просто

2014-09-25 в 11:48, admin, рубрики: CDN, LSI, raid, raid0, ssd, ucdn, webzilla, Блог компании Webzilla, Железо, системное администрирование, спасибо за чтение, СХДВступление

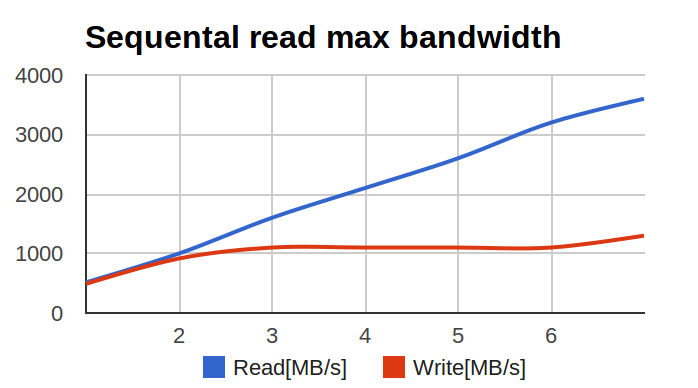

Коллеги с соседнего отдела (UCDN) обратились с довольно интересной и неожиданной проблемой: при тестировании raid0 на большом числе SSD, производительность менялась вот таким вот печальным образом:

По оси X — число дисков в массиве, по оси Y — мегабайтов в секунду.

Я начал изучать проблему. Первичный диагноз был простой — аппаратный рейд не справился с большим числом SSD и упёрся в свой собственный потолок по производительности.

После того, как аппаратный рейд выкинули и на его место поставили HBA, а диски собрали в raid0 с помощью linux-raid (его часто называют 'mdadm' по названию утилиты командной строки), ситуация улучшилась. Но не прошла полностью -цифры возросли, но всё ещё были ниже рассчётных. При этом ключевым параметром были не IOPS'ы, а многопоточная линейная запись (то есть большие куски данных, записываемых в случайные места).

Ситуация для меня была необычной — я никогда не гонялся за чистым bandwidth рейдов. IOPS'ы — наше всё. А тут — надо многомногомного в секунду и побольше.

Адские графики

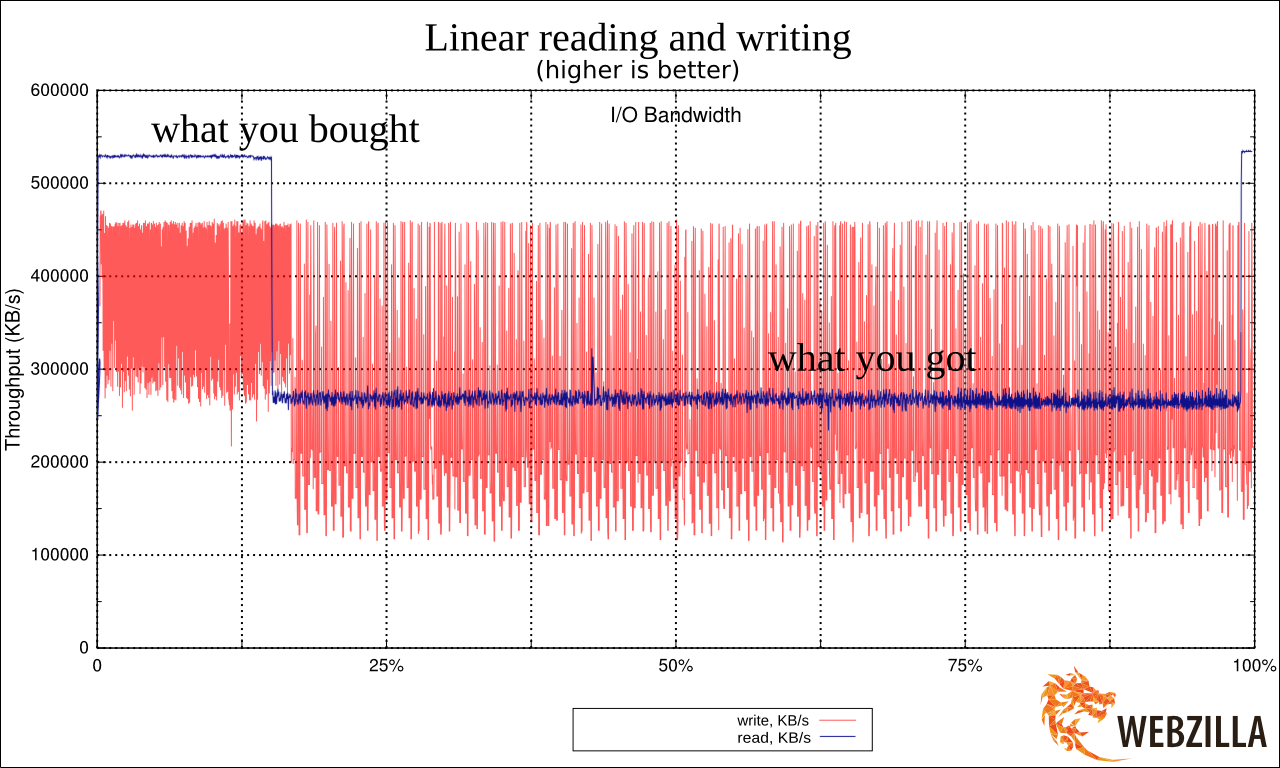

Я начал с определения baseline, то есть производительности единичного диска. Делал я это, скорее, для очистки совести.

Вот график линейного чтения с одной SSD.

Увидев результат я реально взвился. Потому что это очень сильно напоминало ухищрения, на которые идут производители дешёвых USB-флешек. Они помещают быструю память в районы размещения FAT (таблицы) в FAT32 (файловой системе) и более медленную — в район хранения данных. Это позволяет чуть-чуть выиграть по производительности при работе с мелкими операциями с метаданными, при этом предполагая, что пользователи, копирующие большие файлы во-первых готовы подождать, а во вторых сами операции будут происходить крупными блоками. Подробнее про это душераздирающее явление: lwn.net/Articles/428584/

Читать полностью »