Привет. Данный пост предназначен для любителей халявы и содержит готовый рецепт по получению доменного имени, услуг DNS-сервера и SSL-сертификата с затратами 0 рублей 0 копеек. Бесплатный сыр бывает только в мышеловке и это правда, так что рецепт скорее для тех кто хочет красивую ссылку на свой личный небольшой проект с поддержкой https а не для серьёзных проектов.

Читать полностью »

Рубрика «Серверное администрирование» - 132

Получаем доменное имя, DNS и SSL сертификат нахаляву

2016-07-02 в 21:24, admin, рубрики: DNS, http, HTTPS, SSL, Администрирование доменных имен, бесплатно, домен, имя, криптография, Серверное администрирование, сертификатСервер Lenovo поставил шесть мировых рекордов

2016-06-30 в 14:00, admin, рубрики: Lenovo, Блог компании Lenovo, ит-инфраструктура, Серверное администрированиеВсе наши уважаемые пользователи, которые используют в работе серверы Lenovo — можете вздохнуть спокойно, ведь вам есть, чем гордиться. Серверы System x побили (внимание!) шесть мировых рекордов в различных дисциплинах. Каких именно? Подробности под катом.

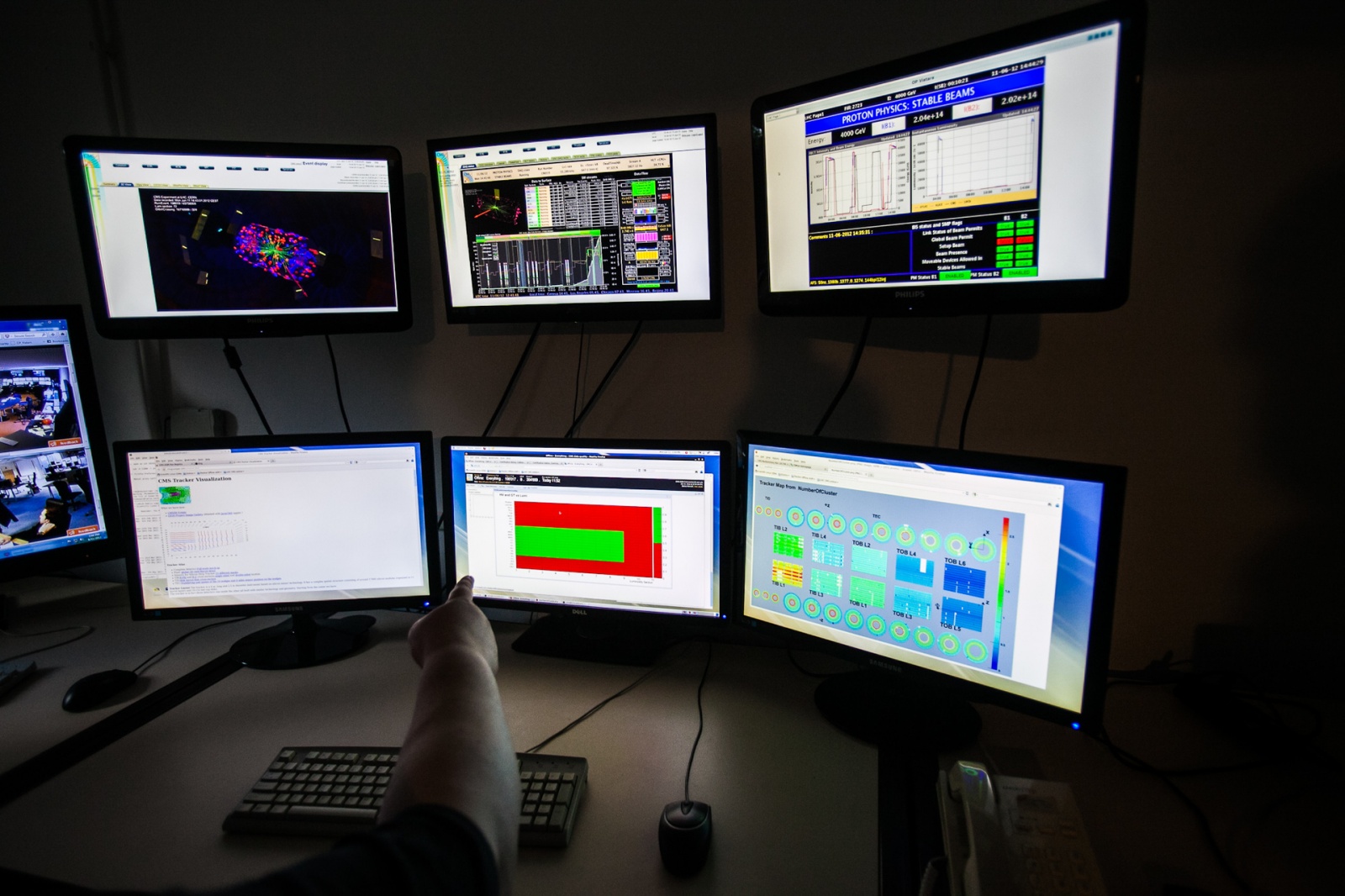

Мониторинг и система управления ЦОД

2016-06-30 в 7:36, admin, рубрики: 3D Data Visualizer, DCIM, FieldView Solutions, HPE Helion CloudSystem, Nlyte Software, oneview, Panoramic Powe, Siemens Building Technology, Sunbird dcTrack, Sunbird Software, ZNV Technology, Блог компании ua-hosting.company, информационная безопасность, ит-инфраструктура, Серверное администрирование, системное администрирование, метки: 3D Data Visualizer, DCIM, FieldView Solutions, HPE Helion CloudSystem, Nlyte Software, ONEView, Panoramic Powe, Siemens Building Technology, Sunbird dcTrack, Sunbird Software, ZNV TechnologyВсе больше информации появляется в интернете о интеграции компаний которые занимаются программным обеспечением, для управления инфраструктурой дата центра. Совсем недавно появилась информация о слиянии двух компаний Nlyte Software и FieldView Solutions. Компания DCIM на рынке уже больше 10 лет и на данный момент в ее состав входить более шести десятков поставщиков программного обеспечения для ЦОД. В ближайшее время планируется сократить число поставщиков, но данное решение не повлияет на общую ситуацию компании. Все больше и больше компаний привлекает возможность получить сверх прибыль, к ним относятся, как крупные компании так и стартапы. Вендоры не спешат выйти на рынок DCIM, и набираясь опыта на простих системах мониторинга и управления инфраструктурой дата центра.

Реализуем http-2 server push с помощью nghttp2

2016-06-29 в 18:29, admin, рубрики: http/2, HTTPS, nghttp2, nghttpx, SSL, высокая производительность, Разработка веб-сайтов, Серверная оптимизация, Серверное администрированиеВсем привет, сегодня я расскажу о том, как настроил server push на своём сайте и добился увеличения скорости рендеринга страниц. Для начала о том, что же такое server push в HTTP/2. Это технология, позволяющая серверу «протолкнуть» дополнительные данные клиенту, в момент запроса основного документа. То есть в обычной ситуации запрашивает браузер html-страничку, затем обрабатывает её и приходит к выводу, что ему для корректного отображения необходимо подгрузить дополнительные файлы: стили, скрипты, изображения. После чего скачивает их и отображает конечный результат. Server push позволяет отправить дополнительные файлы уже в момент получения основного документа, и они уже будут иметься в кэше, когда они потребуются браузеру. За счёт этого возрастает скорость загрузки сайта.

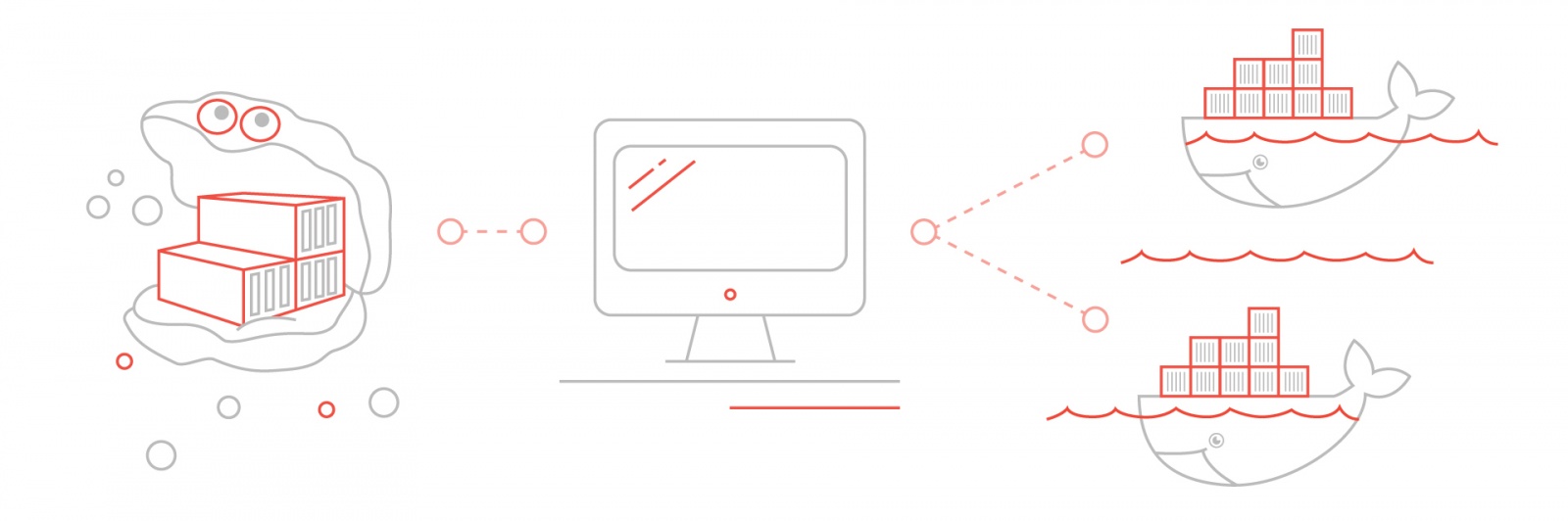

На этот раз схема будет следующая:

51 инструмент для APM и мониторинга серверов

2016-06-29 в 10:00, admin, рубрики: Блог компании Администратор сети, производительность, Серверная оптимизация, Серверное администрирование, системное администрирование, управление производительностью

После создания веб- или мобильного приложения начинается не менее интересный этап: нужно арендовать или приобрести серверы, развернуть на них бэкенд и наблюдать, как твой продукт пользуется бешеной популярностью у пользователей. А чтобы всё шло гладко, необходимо мониторить работу серверов и приложений, контролируя их производительность и устраняя намёки на проблемы. А чтобы не терять время на поиски подходящих инструментов для мониторинга и управления, предлагаем вам — сисадминам и разработчикам — воспользоваться этой подборкой.

Читать полностью »

Автоматизация развертывания Docker-контейнеров на произвольной инфраструктуре

2016-06-27 в 13:44, admin, рубрики: deploy, devops, docker, fabric, python, redmadrobot, Блог компании REDMADROBOT, ит-инфраструктура, Серверное администрированиеКонтейнеризация приложений сегодня является не просто модным трендом. Объективно такой подход позволяет во многом оптимизировать процесс серверной разработки путем унификации поддерживаемых инфраструктур (dev, test, staging, production). Что в итоге приводит к значительному сокращению издержек на протяжении всего цикла жизни серверного приложения.

Хотя большая часть из перечисляемых достоинств Docker является правдой, тех, кто на практике столкнется с контейнерами, может постигнуть легкое разочарование. И так как Docker не является панацеей, а всего лишь входит в список из «лекарственных средств» от рецепта автоматического деплоя, разработчикам приходится осваивать дополнительные технологии, писать дополнительный код и т.д.

Читать полностью »

Пример простой автоматизации letsencrypt

2016-06-27 в 9:06, admin, рубрики: LetsEncrypt, nginx, Настройка Linux, Серверное администрирование, системное администрирование, метки: letsencrypt

Удостоверяющий центр «Let’s Encrypt» (далее просто letsencrypt) вышел из беты пару месяцев назад, пообтерся в реальных условиях, избавился от детских болезней и оброс различными клиентами. И к этому моменту выдал 5 миллионов сертификатов. Самое время внедрять, т.е. получать сертификаты на свои домены и обновлять их в автоматическом режиме. Но как внедрить так, чтобы приблизиться к любимому админскому «поставил и забыл»? Чтобы было просто получать новые сертификаты, а старые при этом обновлялись автоматом? Ну и как добавить немного безопасности в этот процесс?

Ответ под катом.

Читать полностью »

NutanixOS 4.7 — что нового готовится в свежем релизе

2016-06-27 в 5:37, admin, рубрики: 4.7, ABS, AFS, docker, nutanix, openstack, Блог компании Nutanix, виртуализация, Серверное администрирование

Всего 4 месяца прошло с предыдущего релиза, 4.6, и вот на партнерской конференции .NEXT в Лас Вегасе уже рассказали о фичах нового большого релиза, 4.7, который будет «выкачен» уже через несколько дней.

Ну раз руководство почло за добро публично рассказать на конференции о фичах накануне релиза (обычно нас за это очень сильно не хвалят), расскажем о них и мы тут, в России.

Но сперва коротко пробежимся по тем фичам, которые появились в релизе 4.6, совсем, казалось бы, недавно:

Читать полностью »

Gobetween Exec discovery+ Elasticsearch. L4 балансировка с Data Node Discovery

2016-06-25 в 19:56, admin, рубрики: centralized logging, clusterization, elasticsearch, golang, immutable, linux, load balancing, open source, service discovery, ит-инфраструктура, Серверное администрирование, системное администрированиеЗачем все это нужно

Все кто использовал Elasticsearch каластер для своих нужд (особенно для логирования и как основную базу данных) на больших нагрузках сталкивался с проблемами консистентности и масштабируемости. Когда требуется распараллелить нагрузку на Elasticsearch обычно применялись статические решения то типу NGINX+Elasticsearch. Это позволяет распараллелить нагрузку, но выглядит не слишком гибко. Особенно если учесть что ноды могут сами выпадать из кластера и простой хелсчек покажет что все отлично, а на самом деле нода перегружена, исключена из кластера. В любом случае хотелось бы иметь данные о состоянии кластера из первых рук, а не довольствоваться простыми проверками.

Итак, приступим к построению балансировки .

Как мы будем это делать

В данном случае мы будем использовать CAT node API, которое является частъю мощьнейшего CAT API, который является инструментом поиска заголовков по Elasticsearch клстреру.

Мы будем использовать только Gobetween и встроенные механизмы Elasticsearch для балансировки записи /чтения СRUD (DATA) нод при произвольном количестве/статусе нод в кластере.

Запуск worker’ов сервиса с помощью systemd

2016-06-23 в 11:35, admin, рубрики: system administration, systemd, Настройка Linux, Разработка под Linux, Серверное администрирование, системное администрирование, спасибо за чтениеПосле выхода Ubuntu 16.04 (новый LTS релиз), systemd стал реальностью всех основных дистрибутивов Linux, использующихся на серверах. Это означает, что можно закладываться на расширенные возможности systemd, не рискуя оставить часть пользователей приложения «за бортом».

Этот пост о том, как реализовать многоворкерное приложение средствами systemd.

Abstract: Использование шаблонов сервисов и target'ов для запуска нескольких инстансов сервиса (реализация «воркеров»). Зависимость PartOf. Немного про [install] секцию у unit'ов.

Вступление

Многие языки программирования с плохой или никакой многопоточностью (Python, Ruby, PHP, довольно часто C/C++) используют концепцию «воркера». Вместо того, чтобы городить сложные отношения между тредами внутри приложения, они запускают несколько однопоточных копий приложения, каждое из которых берёт на себя кусок нагрузки. Благодаря опции SO_REUSEPORT есть даже возможность «вместе» слушать на одном и том же порту, что покрывает большинство задач, в которых возникает потребность в воркерах (собственно, обычные серверные приложения, реализующие API или обслуживающие веб-сайт).

Но такой подход требует наличия «супервизора», который отвечает за запуск копий, следит за их состоянием, обрабатывает ошибки, завершает при всякого рода stop/reload и т.д. При кажущейся тривиальности — это совершенно не тривиальная задача, полная нюансов (например, если один из воркеров попал в TASK_UNINTERRUPTIBLE или получил SIGSTOP, то могут возникнуть проблемы при restart у не очень хорошо написанного родителя).

Есть вариант запуска без супервизора, но в этом случае задача reload/restart перекладывается на администратора. При модели «один процесс на ядро» перезапуск сервиса на 24-ядерном сервере становится кандидатом в автоматизацию, которая в свою очередь требует обработки всех тех же самых SIGSTOP и прочих сложных нюансов.

Одним из вариантов решения проблемы является использование шаблонов сервисов systemd вместе с зависимостью от общего target'а.

Читать полностью »