В рамках реализации большой задачи по Sentiment Analysis (анализ отзывов) я решил уделить некоторое время дополнительному изучению её отдельного элемента — использованию VotingClassifier из модуля sklearn.ensemble как инструмента для построения ансамбля моделей классификации и повышению итогового качества предсказаний. Почему это важно и какие есть нюансы?

Читать полностью »

Рубрика «scikit-learn» - 2

VotingClassifier в sсikit-learn: построение и оптимизация ансамбля моделей классификации

2018-11-18 в 12:50, admin, рубрики: ensemble models, python, scikit-learn, Алгоритмы, анализ данных, машинное обучениеКак я понял, что ем много сладкого, или классификация товаров по чекам в приложении

2018-11-17 в 15:31, admin, рубрики: classification, clusterization, data mining, python, scikit-learnЗадача

В этой статье мы хотим рассказать, как мы создали решение для классификации названий продуктов из чеков в приложении для учёта расходов по чекам и помощника по покупкам. Мы хотели дать пользователям возможность просматривать статистику по покупкам, собранную автоматически на основе отсканированных чеков, а именно распределить все купленные пользователем товары по категориям. Потому что заставлять пользователя самостоятельно группировать товары — это уже прошлый век. Есть несколько подходов для решения такой задачи: можно попробовать применить алгоритмы кластеризации с разными способами векторного представления слов или классические алгоритмы классификации. Ничего нового мы не изобрели и в этой статье лишь хотим поделиться небольшим гайдом о возможном решении задачи, примерами того, как делать не надо, анализом того, почему не сработали другие методы и с какими проблемами можно столкнуться в процессе.

Читать полностью »

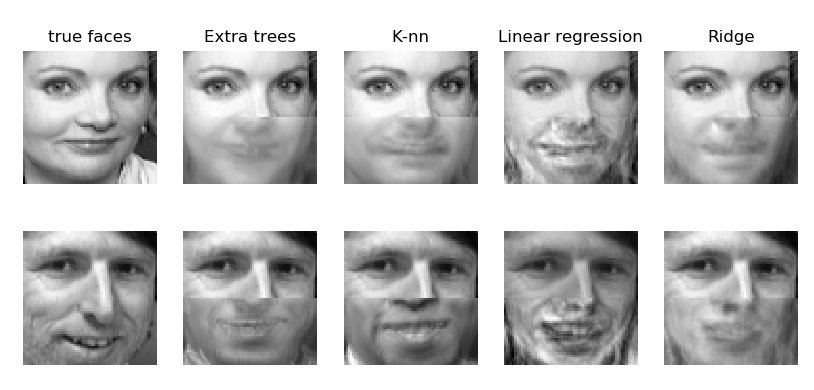

Дорисовывание лиц с помощью машинного обучения

2018-11-04 в 18:22, admin, рубрики: machine learning, python, scikit-learn, машинное обучение, обработка изображенийВ этом примере показано использование различных алгоритмов машинного обучения для завершения изображений. Цель состоит в том, чтобы предсказать нижнюю половину лица, учитывая его верхнюю половину.

Первый столбец изображений показывает настоящие лица. Следующие столбцы иллюстрируют, как деревья (extremely randomized trees), метод k-ближайших соседей (k nearest neighbors/K-nn), линейная регрессия (linear regression) и RidgeCV (ridge regression complete) завершают нижнюю половину этих лиц.

Читать полностью »

Прогнозирование продаж недвижимости. Лекция в Яндексе

2018-08-19 в 13:07, admin, рубрики: catboost, scikit-learn, xgboost, Блог компании Яндекс, линейная регрессия, машинное обучение, Спортивное программированиеУспех в проектах по машинному обучению обычно связан не только с умением применять разные библиотеки, но и с пониманием той области, откуда взяты данные. Отличной иллюстрацией этого тезиса стало решение, предложенное командой Алексея Каюченко, Сергея Белова, Александра Дроботова и Алексея Смирнова в конкурсе PIK Digital Day. Они заняли второе место, а спустя пару недель рассказали о своём участии и построенных моделях на очередной ML-тренировке Яндекса.

Алексей Каюченко:

— Добрый день! Мы расскажем о соревновании PIK Digital Day, в котором мы участвовали. Немного о команде. Нас было четыре человека. Все с абсолютно разным бэкграундом, из разных областей. На самом деле, мы на финале познакомились. Команда сформировалась буквально за день до финала. Я расскажу про ход конкурса, организацию работы. Потом выйдет Сережа, он расскажет про данные, а Саша расскажет уже про сабмишен, про финальный ход работы и про то, как мы двигались по лидерборду.

Соревнование Kaggle Home Credit Default Risk — анализ данных и простые предсказательные модели

2018-06-19 в 20:12, admin, рубрики: big data, data mining, kaggle, LightGBM, python, scikit-learn, машинное обучение, переводНа датафесте 2 в Минске Владимир Игловиков, инженер по машинному зрению в Lyft, совершенно замечательно объяснил, что лучший способ научиться Data Science — это участвовать в соревнованиях, запускать чужие решения, комбинировать их, добиваться результата и показывать свою работу. Собственно в рамках этой парадигмы я и решил посмотреть внимательнее на соревнование по оценке кредитного риска от Home Credit и объяснить (начинающим дата саентистам и прежде всего самому себе), как правильно анализировать подобные датасеты и строить под них модели.

Kaggle Mercedes и кросс-валидация

2017-08-23 в 12:28, admin, рубрики: cross-validation, data mining, kaggle, Mercedes, Mercedes-Benz, python, scikit-learn, scipy, Блог компании Open Data Science, математика, машинное обучение

Всем привет, в этом посте я расскажу о том, как мне удалось занять 11 место в конкурсе от компании Мерседес на kaggle, который можно охарактеризовать как лидера по количеству участников и по эпичности shake-up. Здесь можно ознакомиться с моим решением, там же ссылка на github, здесь можно посмотреть презентацию моего решения в Yandex.

В этом посте пойдет речь о том, как студент консерватории попал в data science, стал призером двух подряд kaggle-соревнований, и каким образом методы математической статистики помогают не переобучиться на публичный лидерборд

Начну я с того, что немного расскажу о задаче и о том, почему я взялся ее решать. Должен сказать, что в data science я человек новый. Лет 7 назад я закончил Физический Факультет СПбГУ и с тех пор занимался тем, что получал музыкальное образование. Идея немного размять мозг и вернуться к техническим задачам впервые посетила меня примерно два года назад, на тот момент я уже работал в оркестре Московской Филармонии и учился на 3 курсе в Консерватории. Начал я с того, что вооружившись книгой Страуструпа стал осваивать C++. Далее были конечно же разные онлайн курсы и примерно год назад я стал склоняться к мысли о том, что Data Science — это пожалуй именно то, чем я хотел бы заниматься в IT. Мое “образование” в Data Science — это курс от Яндекса и Вышки на курсере, несколько курсов из специализации МФТИ на курсере и конечно же постоянное саморазвитие в соревнованиях.

Читать полностью »

Поиск звуковых аномалий

2016-11-22 в 5:00, admin, рубрики: anomaly detection, azure machine learning, azure ml, cnn, CNTK, keras, machine learning, numenta, python, RNN, scikit, scikit-learn, TensorFlow, машинное обучениеПопробуем решить задачу поиска аномалий в звуке.

Примеры аномалий звука:

- Неисправности в работе двигателя.

- Изменения в погоде: дождь, град, ветер.

- Аномалии работа сердца, желудка, суставов.

- Необычный трафик на дороге.

- Неисправности колесных пар у поезда.

- Неисправности при посадке и взлете самолета.

- Аномалии движения жидкости в трубе, в канале.

- Аномалии движения воздуха в системах кондиционирования, на крыле самолета.

- Неисправности автомобиля, велосипеда.

- Неисправности станка, оборудования.

- Расстроенный музыкальный инструмент.

- Неправильно взятые ноты песни.

- Эхолокация кораблей и подводных лодок.

Читать полностью »

Automatic Relevance Determination или машинное обучение когда данных очень мало

2016-10-26 в 6:59, admin, рубрики: bayes, bayesian inference, data mining, feature selection, linear model, linear regression, python, scikit-learn, линейная регрессия, математика, машинное обучениеКогда речь заходит про машинное обучение, обычно подразумевают большие объемы данных — миллионы или даже миллиарды транзакций, из которых надо сделать сложный вывод о поведении, интересах или текущем cостоянии пользователя, покупателя или какого-нибудь аппарата (робота, автомобиля, дрона или станка).

Однако в жизни обычного аналитика самой обычной компании много данных встречается нечасто. Скорее даже наоборот — у вас будет мало или очень мало данных — буквально десятки или сотни записей. Но анализ все же нужно провести. Причем не какой попало анализ, а качественный и достоверный.

Зачастую ситуация усугубляется еще и тем, что вы без труда можете нагенерить для каждой записи много признаков (чаще всего добавляют полиномы, разницу с предыдущим значением и значением за прошлый год, one-hot-encoding для категориальных признаков и т.п.). Вот только совсем нелегко разобраться, какие из них действительно полезны, а какие только усложняют модель и увеличивают ошибки вашего прозноза.

Для этого вы можете воспользоваться методами байесовой статистики, например, Automatic Relevance Determination. Читать полностью »

Как я писал книгу ‘Python Machine Learning’

2016-04-21 в 14:56, admin, рубрики: data science, machine learning, python, scikit-learn, Блог компании Издательский дом «Питер», книги, машинное обучение, Программирование, Профессиональная литератураЗдравствуйте, уважаемыее!

В настоящее время мы всерьез намерены в обозримом будущем порадовать вас серьезной книгой по машинному или глубинному обучению. Среди книг, вызвавших у нас наибольший интерес, особого упоминания заслуживает работа Себастьяна Рашки "Python Machine Learning"

Предлагаем почитать, что сам автор рассказывает об этой книге. Мы позволили себе сократить статью практически вдвое, так как вся ее вторая часть посвящена тонкостям писательского труда и оформления книги, а тематические тонкости и актуальность темы рассмотрены в самом начале. Надеемся, что вам понравится текст, а нам — результаты опроса.

Читать полностью »

16 ядер и 30 Гб под капотом Вашего Jupyter за $0.25 в час

2016-03-31 в 11:33, admin, рубрики: Amazon EC2, Amazon Web Services, data mining, jupyter notebook, python, scikit-learn, виртуализация, хостингЕсли Вам не очень повезло, и на работе нет n-ядерного монстра, которого можно загрузить своими скриптами, то эта статья для Вас. Также если Вы привыкли запускать скрипты на всю ночь (и утром читать, что где-то забыли скобочку, и 6 часов вычислений пропали) — у Вас есть шанс наконец познакомиться с Amazon Web Services.

В этой статье я расскажу, как начать работать с сервисом EC2. По сути это пошаговая инструкция по полуавтоматической аренде спотового инстанса AWS для работы с Jupyter-блокнотами и сборкой библиотек Anaconda. Будет полезно, например, тем, кто в соревнованиях Kaggle все еще пользуется своим игрушечным маком.