В данной статье речь пойдёт о том, как используя разные архитектуры нейронных сетей классифицировать данные полученные со сверхширокополосного радара " XETHRU by NOVELDA X4M02 290056-010 ". Моя работа основана на публикации " UWB-gestures, a public dataset of dynamic hand gestures acquired using impulse radar sensorsЧитать полностью »

Рубрика «RNN»

Нейросетевой подход для классификации событий отслеживаемых сверхширокополосным радаром

2025-04-04 в 23:14, admin, рубрики: attention, cnn, RNN, uwb, искусственный интеллект, радар, радарные датчики, сверхширокополосная радиолокация, сшп, трансформерыПродолжение исследования RNN

2024-10-16 в 16:03, admin, рубрики: gru, LSTM, msmr, python, RNN, SLR, SMR, TensorFlow, transformer, исследованиеС прошлой статьи я внёс несколько изменений:

1. Планировщик был сломан и не изменял скорость. Починил.

2. Остаточное соединение через умножение.

3. WindowedDense для выходной проекции.

4. Добавил clipnorm 1, cutoff_rate 0.4

Как обычно это всё добавляет стабильности и 1% точности.

WindowedDense по неизвестной мне причине добавляет SMR стабильность.

class SMR(layers.Layer):

def __init__(self, units):

super().__init__()

self.state_size = units

self.s_l = layers.Dense(units, use_bias=False)

def get_in_proj(self):

return WindowedDense(self.state_size, 16)

def call(self, i, states):

s = states[0]

s = self.s_l(s)

o = i * (s + 0.1)

return o, [o]Кто знает, что значит GPT в названии ChatGPT, могут дальше не читать

2024-01-09 в 8:40, admin, рубрики: chatgpt, cnn, GAN, gpt, nlp, perceptron, RNN, нейронные сети, нейросети, трансформеры

В настоящее время искусственный интеллект (ИИ) стремительно развивается. Мы являемся свидетелями интеллектуальной мощи таких нейросетей, как GPT-4 Turbo от OpenAI и Gemini Ultra от GoogleЧитать полностью »

Как лучше обучать RNN для прогнозирования временных рядов?

2022-11-26 в 19:27, admin, рубрики: deep learning, gru, LSTM, python, RNN, искусственный интеллект, машинное обучение, финансы в ITПривет!

Два последних года я в рамках магистерской диссертации разбирался с тем, как лучше использовать рекуррентные нейронные сети для прогнозирования временных рядов, и теперь хочу поделиться моим опытом с сообществом.

Я разделил свой рассказ на несколько блоков:

-

Что такое RNN

-

Рекуррентные нейроны

-

Методы обработки временных рядов

-

Стратегии прогнозирования

-

Добавление факторов в RNN

-

Глобальные модели RNN

Как сделать из нейросети журналиста, или «Секреты сокращения текста на Хабре без лишних слов»

2019-12-11 в 12:53, admin, рубрики: ABBYY, diy или сделай сам, natural language processing, pgen, RNN, seq2seq, Блог компании ABBYY, генерация заголовков, искусственный интеллект, машинное обучение, нейросеть, Новости, саммаризация, токены Только не удивляйтесь, но второй заголовок к этому посту сгенерировала нейросеть, а точнее алгоритм саммаризации. А что такое саммаризация?

Только не удивляйтесь, но второй заголовок к этому посту сгенерировала нейросеть, а точнее алгоритм саммаризации. А что такое саммаризация?

Это одна из ключевых и классических задач Natural Language Processing (NLP). Она заключается в создании алгоритма, который принимает на вход текст и на выходе выдаёт его сокращённую версию. Причем в ней сохраняется корректная структура (соответствующая нормам языка) и правильно передается основная мысль текста.

Такие алгоритмы широко используются в индустрии. Например, они полезны для поисковых движков: с помощью сокращения текста можно легко понять, коррелирует ли основная мысль сайта или документа с поисковым запросом. Их применяют для поиска релевантной информации в большом потоке медиаданных и для отсеивания информационного мусора. Сокращение текста помогает в финансовых исследованиях, при анализе юридических договоров, аннотировании научных работ и многом другом. Кстати, алгоритм саммаризации сгенерировал и все подзаголовки для этого поста.

К моему удивлению, на Хабре оказалось совсем немного статей о саммаризации, поэтому я решил поделиться своими исследованиями и результатами в этом направлении. В этом году я участвовал в соревновательной дорожке на конференции «Диалог» и ставил эксперименты над генераторами заголовков для новостных заметок и для стихов с помощью нейронных сетей. В этом посте я вначале вкратце пробегусь по теоретической части саммаризации, а затем приведу примеры с генерацией заголовков, расскажу, какие трудности возникают у моделей при сокращении текста и как можно эти модели улучшить, чтобы добиться выдачи более качественных заголовков.

Читать полностью »

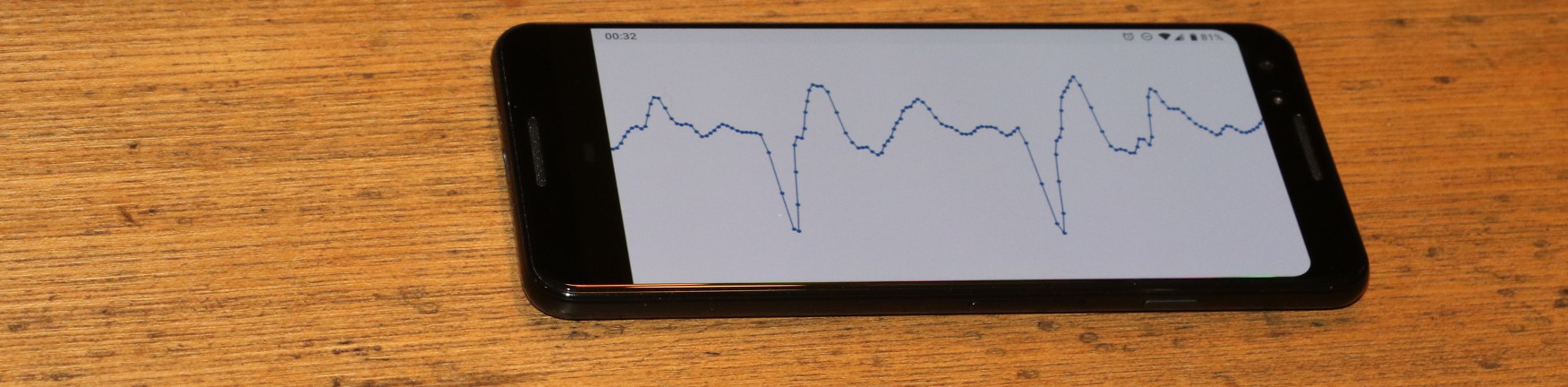

Ищем аномалии и предсказываем сбои с помощью нейросетей

2019-12-02 в 14:27, admin, рубрики: devops, dtw, LSTM, MLP, RNN, автокодировщик, глубокое обучение, искусственный интеллект, Криста, машинное обучение, нейронные сети, нейросети, поиск аномалий, предиктивное обслуживание

Промышленная разработка программных систем требует большого внимания к отказоустойчивости конечного продукта, а также быстрого реагирования на отказы и сбои, если они все-таки случаются. Мониторинг, конечно же, помогает реагировать на отказы и сбои эффективнее и быстрее, но недостаточно. Во-первых, очень сложно уследить за большим количеством серверов – необходимо большое количество людей. Во-вторых, нужно хорошо понимать, как устроено приложение, чтобы прогнозировать его состояние. Следовательно, нужно много людей, хорошо понимающих разрабатываемые нами системы, их показатели и особенности. Предположим, даже если найти достаточное количество людей, желающих заниматься этим, требуется ещё немало времени, чтобы их обучить.

Что же делать? Здесь нам на помощь спешит искусственный интеллект. Речь в статье пойдет о предиктивном обслуживании (predictive maintenance). Этот подход активно набирает популярность. Написано большое количество статей, в том числе и на Хабре. Крупные компании вовсю используют такой подход для поддержки работоспособности своих серверов. Изучив большое количество статьей, мы решили попробовать применить этот подход. Что из этого вышло?

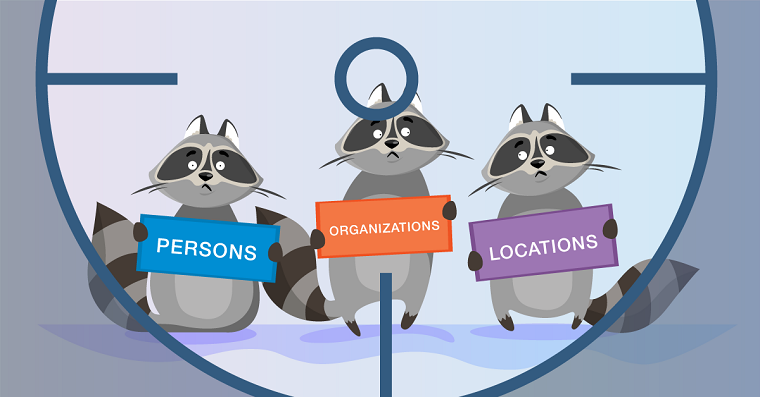

NLP. Основы. Техники. Саморазвитие. Часть 2: NER

2019-05-14 в 12:07, admin, рубрики: ABBYY, machine learning, natural language processing, ner, RNN, Блог компании ABBYY, искусственный интеллект, машинное обучение, нейронные сети, нейросети, токены, эмбеддингиПервую часть статьи об основах NLP можно прочитать здесь. А сегодня мы поговорим об одной из самых популярных задач NLP – извлечении именованных сущностей (Named-entity recognition, NER) – и разберем подробно архитектуры решений этой задачи.

Кодирование речи на 1600 бит-с нейронным вокодером LPCNet

2019-04-03 в 15:53, admin, рубрики: Codec2, LPC. кодирование звука, LPCNet, RNN, wavenet, WaveRNN, Алгоритмы, звук, кепстр, машинное обучение

Это продолжение первой статьи о LPCNet. В первом демо мы представили архитектуру, которая сочетает обработку сигналов и глубокое обучение для повышения эффективности нейронного синтеза речи. На этот раз превратим LPCNet в нейронный речевой кодек с очень низким битрейтом (см. научную статью). Его можно использовать на текущем оборудовании и даже на телефонах.

Впервые нейронный вокодер работает в реальном времени на одном процессорном ядре телефона, а не на высокоскоростном GPU. Итоговый битрейт 1600 бит/с примерно в десять раз меньше, чем выдают обычные широкополосные кодеки. Качество намного лучше, чем у существующих вокодеров с очень низким битрейтом и сопоставимо с более традиционными кодеками, использующими более высокий битрейт.

Читать полностью »

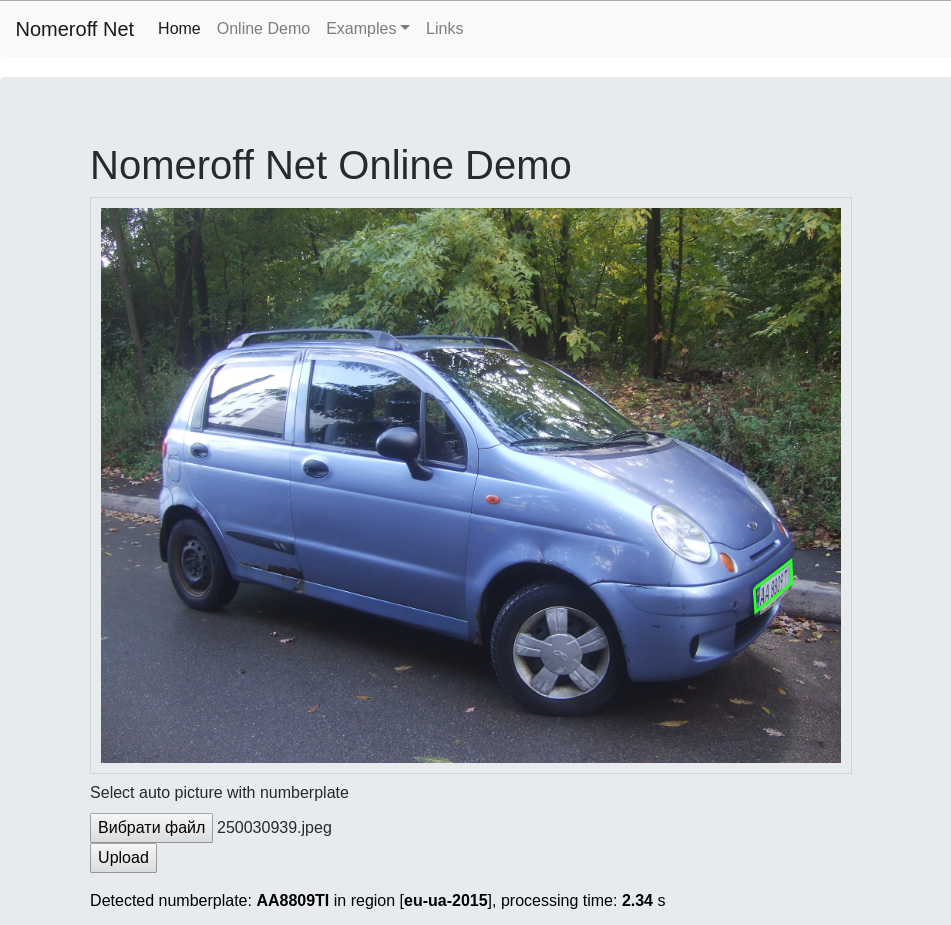

Распознавание номеров. Как мы получили 97% точности для Украинских номеров. Часть 2

2019-03-07 в 12:50, admin, рубрики: cnn, keras, neural networks, ocr, python, RNN, TensorFlow, искусственный интеллект, Компьютерное зрение, машинное обучение

Продолжаем рассказ о том как распознавать номерные знаки для тех кто умеет писать приложение «hello world» на python-е! В этой части научимся тренировать модели, которые ищут регион заданного объекта, а также узнаем как написать простенькую RNN-сеть, которая будет справляться с чтением номера лучше чем некоторые коммерческие аналоги.

В этой части я расскажу как тренировать Nomeroff Net под Ваши данные, как получить высокое качество распознавания, как настроить поддержку GPU и ускорить все на порядок…

Читать полностью »

Kaggle: не можем ходить — будем бегать

2019-03-06 в 5:22, admin, рубрики: cnn, data mining, gru, kaggle, keras, LightGBM, LSTM, machine learning, RNN, scikit-learn, Блог компании Singularis, искусственный интеллект, машинное обучение, рекуррентная нейронная сеть, финансы в ITНасколько сложна тема машинного обучения? Если Вы неплохо математически подкованы, но объем знаний о машинном обучении стремится к нулю, как далеко Вы сможете зайти в серьезном конкурсе на платформе Kaggle?