Удивительно, но факт: несколько изменений в изображении может полностью изменить вывод нейросети, что ломает заложенную разработчиком логику. В данной статье мы не просто подсветим факт существования One Pixel атаки, но и комплексно разберём архитектурные факторы, которые влияют на устойчивость CV-систем к данному семейству атак.

Рубрика «resnet»

Когда несколько пикселей решают всё: One Pixel атака и способы защиты от неё

2025-07-31 в 15:15, admin, рубрики: alexnet, computer vision, efficientnet, inceptionV3, one pixel attack, resnet, Visual transformerДетальный разбор архитектуры современных языковых моделей

2025-06-28 в 17:30, admin, рубрики: GAN, generative adversarial networks, kolmogorov-arnold networks, resnet, архитектуры нейронных сетей, графовые нейросети, Капсульные сетиДоброго времени суток, «Хабр»!

Сегодня мы погрузимся в мир современных языковых моделей, детально изучим их архитектуру и разберемся в принципах работы. Готовы к захватывающему путешествию в мир искусственного интеллекта? Тогда пристегните ремни — мы отправляемся!

Часть 1: ResNet-18 — Архитектура, покорившая глубину

2025-06-25 в 7:26, admin, рубрики: resnet, Компьютерное зрение, машинное обучение, новичкам, сверточные нейронные сетиПролог: Парадокс глубины

Представьте, что вы строите небоскрёб. Каждый новый этаж — это слой нейросети. Но после 20 этажей здание вдруг начинает... рушиться. Так было в компьютерном зрении до 2015 года: чем глубже сеть, тем хуже она работала.

ResNet решил это гениально просто: добавил "лифты" между этажами — остаточные связи (skip-connections). Теперь, если новый слой бесполезен, сеть просто "пропускает" его через эти лифты.

Разберём на простом примере

Как ResNet из картинки делает предсказание?

Допустим у нас есть задача предсказать, что в данном изображении будет "человек" класс (0) или "машина" класс (1).

Исследуем эволюцию архитектур в Computer Vision: Mind Map всех ключевых моделей

2025-03-13 в 16:58, admin, рубрики: computer vision, deep learning, machine learning, mind maps, neural networks, resnet, Transformers, машинное обучение, нейронные сетиСразу к карте? Если вы предпочитаете действовать, а не читать, вот ссылка на Mind Map . Она доступна для изучения прямо сейчас. А если хотите понять контекст и узнать больше о каждой модели — добро пожаловать под кат!

Введение

7 лет хайпа нейросетей в графиках и вдохновляющие перспективы Deep Learning 2020-х

2019-12-25 в 7:01, admin, рубрики: alexnet, AutoML, Batch Normalization, big data, cnn, computer science, data science, deep learning, Deepfake, deeplab, DenseNet, dropout, GAN, hardware acceleration, pytorch, resnet, TensorFlow, vgg, искусственный интеллект, машинное обучение, Научно-популярное, нейросети, скорость прогресса, Статистика в IT

Новый год все ближе, скоро закончатся 2010-е годы, подарившие миру нашумевший ренессанс нейросетей. Мне не давала покоя и лишала сна простая мысль: «Как можно ретроспективно прикинуть скорость развития нейросетей?» Ибо «Тот, кто знает прошлое — тот знает и будущее». Как быстро «взлетали» разные алгоритмы? Как вообще можно оценить скорость прогресса в этой области и прикинуть скорость прогресса в следующем десятилетии?

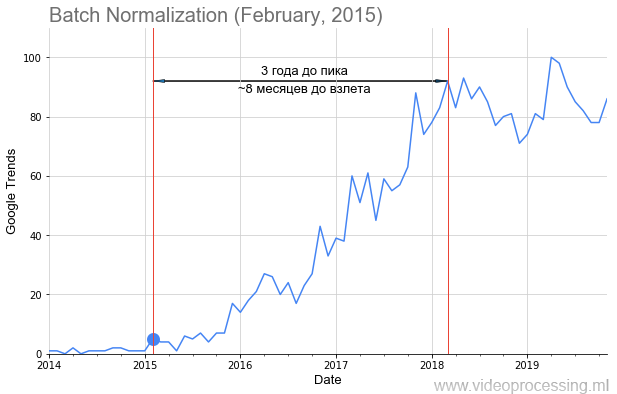

Понятно, что можно примерно посчитать количество статей по разным областям. Метод не идеальный, нужно учитывать подобласти, но в целом можно пробовать. Дарю идею, по Google Scholar (BatchNorm) это вполне реально! Можно считать новые датасеты, можно новые курсы. Ваш же покорный слуга, перебрав несколько вариантов, остановился на Google Trends (BatchNorm).

Мы с коллегами взяли запросы основных технологий ML/DL, например, Batch Normalization, как на картинке выше, точкой добавили дату публикации статьи и получили вполне себе график взлета популярности темы. Но не у всех тем путь усыпан розами взлет такой явный и красивый, как у батчнорма. Некоторые термины, например регуляризацию или skip connections, вообще не получилось построить из-за зашумленности данных. Но в целом тренды собрать удалось.

Кому интересно, что получилось — добро пожаловать под кат!

Читать полностью »

Нейронные сети предпочитают текстуры и как с этим бороться

2019-05-29 в 10:57, admin, рубрики: bag-of-features, bag-of-words, bagnet, datasets, deep learning, image classification, image recognition, ImageNet, machine learning, ods, ods.ai, open data science, resnet, ResNet-50, Блог компании Open Data Science, искусственный интеллект, машинное обучение, мозг, обработка изображений

В последнее время вышло несколько статей с критикой ImageNet, пожалуй самого известного набора изображений, использующегося для обучения нейронных сетей.

В первой статье Approximating CNNs with bag-of-local features models works surprisingly well on ImageNet авторы берут модель, похожую на bag-of-words, и в качестве "слов" используют фрагменты из изображения. Эти фрагменты могут быть вплоть до 9х9 пикселей. И при этом, на такой модели, где полностью отсутствует какая-либо информация о пространственном расположении этих фрагментов, авторы получают точность от 70 до 86% (для примера, точность обычной ResNet-50 составляет ~93%).

Во второй статье ImageNet-trained CNNs are biased towards texture авторы приходят к выводу, что виной всему сам набор данных ImageNet и то, как изображения воспринимают люди и нейронные сети, и предлагают использовать новый датасет – Stylized-ImageNet.

Более подробно о том, что на картинках видят люди, а что нейронные сети Читать полностью »

ResNet50. Своя реализация

2019-05-02 в 14:55, admin, рубрики: resnet, машинное обучение, нейронные сети, обработка изображенийВсем привет. Библиотека нейросети описана в моей прошлой статье. Здесь решил показать как можно использовать обученную сеть из TF (Tensorflow) в своем решении, и стоит ли.

Под катом сравнение с оригинальной реализацией TF, демо приложение для распознавания картинок, ну и… выводы. Кому интересно, прошу.

Читать полностью »

Знакомство с Neural ODE

2019-03-04 в 11:02, admin, рубрики: deep learning, neural networkds, neural ode, python, pytorch, recurrent neural network, resnet, Алгоритмы, Блог компании Open Data Science, математика, машинное обучениеNeural Ordinary Differential Equations

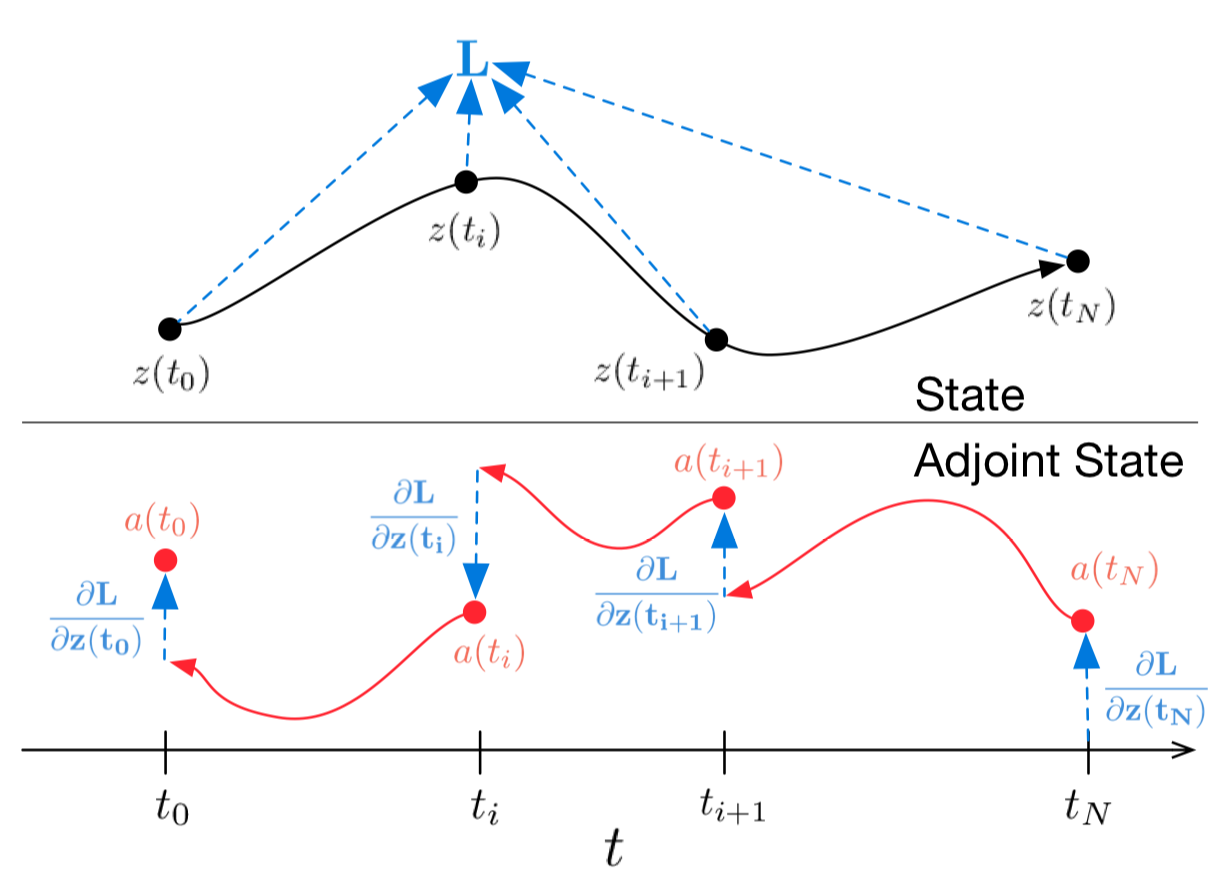

Значительная доля процессов описывается дифференциальными уравнениями, это могут быть эволюция физической системы во времени, медицинское состояние пациента, фундаментальные характеристики фондового рынка и т.д. Данные о таких процессах последовательны и непрерывны по своей природе, в том смысле, что наблюдения — это просто проявления какого-то непрерывно изменяющегося состояния.

Есть также и другой тип последовательных данных, это дискретные данные, например, данные NLP задач. Состояния в таких данных меняется дискретно: от одного символа или слова к другому.

Сейчас оба типа таких последовательных данных обычно обрабатываются рекуррентными сетями, несмотря на то, что они отличны по своей природе, и похоже, требуют различных подходов.

На последней NIPS-конференции была представлена одна очень интересная статья, которая может помочь решить эту проблему. Авторы предлагают подход, который они назвали Нейронные Обыкновенные Дифференциальные Уравнения (Neural ODE).

Здесь я постарался воспроизвести и кратко изложить результаты этой статьи, чтобы сделать знакомство с ее идеей чуть более простым. Мне кажется, что эта новая архитектура вполне может найти место в стандартном инструментарии дата-сайентиста наряду со сверточными и рекуррентными сетями.

Эффективные методы сжатия данных при тренировке нейросетей. Лекция в Яндексе

2018-03-11 в 12:37, admin, рубрики: alexnet, CNTK, cpu, DNN, fragmentation, gist, gpu, gzip, lcp, LSTM, memory management, mxnet, pool, reinforcement learning, relu, resnet, TensorFlow, Блог компании Яндекс, глубокие сети, машинное обучение, сжатие данныхНе так давно в Яндекс приезжал Геннадий Пехименко — профессор Университета Торонто и PhD Университета Карнеги-Меллон. Он прочитал лекцию об алгоритмах кодирования, которые позволяют обходить проблему ограничения памяти GPU при обучении глубоких нейронных сетей.

— Я вхожу в несколько групп Университета Торонто. Одна из них — Computer Systems and Networking Group. Есть еще моя собственная группа — EcoSystem Group. Как видно из названий групп, я не специалист непосредственно в машинном обучении. Но нейронные сети сейчас достаточно популярны, и людям, которые занимаются компьютерной архитектурой и сетями, компьютерными системами, приходится сталкиваться с этими приложениями на постоянной основе. Поэтому последние полтора-два года этой темой я тоже плотно занимаюсь.

Читать полностью »

Спортивный анализ данных, или как стать специалистом по data science

2017-04-26 в 14:05, admin, рубрики: adam, big data, black box, data mining, data science, ImageNet, inceptionV3, kaggle, mxnet, Q-learning, resnet, xgboost, аугментация данных, блендинг, Блог компании Яндекс, валидация, классификация, конкурсы разработчиков, контест, машинное обучение, нейронные сети, распознавание изображений, Спортивное программирование, стекинг, тренировки, черный ящикМеня зовут Пётр Ромов, я — data scientist в Yandex Data Factory. В этом посте я предложу сравнительно простой и надежный способ начать карьеру аналитика данных.

Многие из вас наверняка знают или хотя бы слышали про Kaggle. Для тех, кто не слышал: Kaggle — это площадка, на которой компании проводят конкурсы по созданию прогнозирующих моделей. Её популярность столь велика, что часто под «кэглами» специалисты понимают сами конкурсы. Победитель каждого соревнования определяется автоматически — по метрике, которую назначил организатор. Среди прочих, Kaggle в разное время опробовали Facebook, Microsoft и нынешний владелец — Google. Яндекс тоже несколько раз отметился. Как правило, Kaggle-сообществу дают решать задачи, довольно близкие к реальным: это, с одной стороны, делает конкурс интересным, а с другой — продвигает компанию как работодателя с солидными задачами. Впрочем, если вам скажут, что компания-организатор конкурса задействовала в своём сервисе алгоритм одного из победителей, — не верьте. Обычно решения из топа слишком сложны и недостаточно производительны, а погони за тысячными долями значения метрики не настолько и нужны на практике. Поэтому организаторов больше интересуют подходы и идейная часть алгоритмов.

Kaggle — не единственная площадка с соревнованиями по анализу данных. Существуют и другие: DrivenData, DataScience.net, CodaLab. Кроме того, конкурсы проводятся в рамках научных конференций, связанных с машинным обучением: SIGKDD, RecSys, CIKM.

Для успешного решения нужно, с одной стороны, изучить теорию, а с другой — начать практиковать использование различных подходов и моделей. Другими словами, участие в «кэглах» вполне способно сделать из вас аналитика данных. Вопрос — как научиться в них участвовать?