В наше время словами «искусственный интеллект» называют очень много различных систем — от нейросети для распознавания картинок до бота для игры в Quake. В википедии дано замечательное определение ИИ — это «свойство интеллектуальных систем выполнять творческие функции, которые традиционно считаются прерогативой человека». То есть из определения явно видно — если некую функцию успешно удалось автоматизировать, то она перестаёт считаться искусственным интеллектом.

Тем не менее, когда задача «создать искусственный интеллект» была поставлена впервые, под ИИ подразумевалось нечто иное. Сейчас эта цель называется «Сильный ИИ» или «ИИ общего назначения».

Читать полностью »

Рубрика «reinforcement learning» - 2

Искусственный интеллект общего назначения. ТЗ, текущее состояние, перспективы

2019-09-22 в 21:49, admin, рубрики: AGI, AI, aixi, artificial intelligence, reinforcement learning, ИИ, искусственный интеллектКак я учил змейку играть в себя с помощью Q-Network

2019-08-29 в 13:35, admin, рубрики: deep learning, machine learning, python, Q-learning, reinforcement learning, искусственный интеллект, машинное обучениеОднажды, исследуя глубины интернета, я наткнулся на видео, где человек обучает змейку с помощью генетического алгоритма. И мне захотелось так же. Но просто взять все то же самое и написать на python было бы не интересно. И я решил использовать более современный подход для обучения агентных систем, а именно Q-network. Но начнем с начала.

Обучение с подкреплением

В машинном обучении RL(Reinforcement Learning) достаточно сильно отличается от других направлений. Отличие состоит в том, что классический ML алгоритм обучается уже на готовых данных, в то время как RL, так сказать, сам создает себе эти данные. Идея RL состоит в том, что помимо самого алгоритма, который называют агентом, существует среда(environment), в которую этот агент и помещается. На каждом этапе агент должен совершать какое-то действие(action), а среда отвечает на это наградой(reward) и своим состоянием(state), на основе которого агент и совершает действие.

DQN

Здесь должно быть объяснение того, как алгоритм работает, но я оставлю ссылку на то, где это объясняют умные люди.

Архитектура нейронной сети для реализации алгоритма RL с возможностью задания одновременно выполняющихся действий

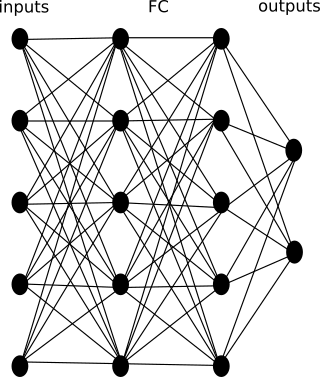

2019-06-05 в 9:58, admin, рубрики: machine learning, reinforcement learning, машинное обучениеОдна из классических схем нейронной сети для реализации алгоритма RL выглядит следующим образом:

Где: inputs – входы в нейронную сеть; FC – (fully connected) архитектура скрытых слоев или CNN — FC – архитектура архитектура скрытых слоев (в зависимости о того, что подается на входы); outputs – выходы сети. Часто выходы сети это softmax слой, который выдает вероятность выполнения одного из действий из набора всех возможных действий.

Недостаток данной архитектуры, в том, что сложно реализовать выбор сразу нескольких одновременно выполняемых действий.

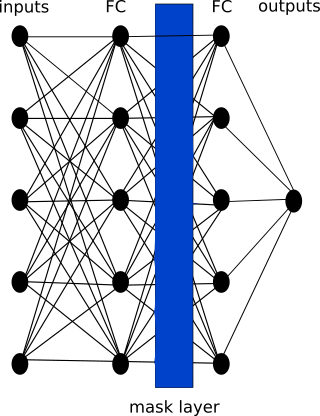

Для решения этой проблемы предлагается архитектура с слоем маски. Предлагаемая архитектура выглядит следующим образом:

Эта архитектура полностью соответствует классической архитектуре, но также включает слой маски действий. Выход у данной архитектуры один – это значение ценности действия (группы одновременно выполняемых действий). Слой маски действий может быть реализован в соответствии с псевдокодом ниже:

Читать полностью »

Интуитивный RL (Reinforcement Learning): введение в Advantage-Actor-Critic (A2C)

2019-03-04 в 9:58, admin, рубрики: data science, deep learning, machine learning, reinforcement learning, искусственный интеллект, машинное обучение, переводыЭто вольный перевод статьи Rudy Gilman и Katherine Wang Intuitive RL: Intro to Advantage-Actor-Critic (A2C).

Специалисты по обучению с подкреплением (RL) подготовили множество отличных учебных пособий. Большинство, однако, описывают RL в терминах математических уравнений и абстрактных диаграмм. Нам нравится думать о предмете с другой точки зрения. Сама RL вдохновлена тем, как учатся животные, так почему бы не перевести лежащий в основе этого механизм RL обратно в природные явления, которые он призван имитировать? Люди учатся лучше всего через истории.

Это история о модели Actor Advantage Critic (A2C). Модель «Действующее лицо-критик» — это популярная форма модели Policy Gradient, которая сама по себе является традиционным алгоритмом RL. Если вы понимаете A2C, вы понимаете глубокий RL.

Открытый курс «Deep Learning на пальцах»

2019-02-05 в 8:05, admin, рубрики: computer vision, deep learning, machine learning, MOOC, nlp, opendatascience, reinforcement learning, Блог компании Open Data Science, машинное обучение, обработка изображенийПосле 18-го февраля начнется открытый и бесплатный курс "Deep Learning на пальцах".

Курс предназначен для того, чтобы разобраться с современным deep learning с нуля, и не требует знаний ни нейросетей, ни machine learning вообще. Лекции стримами на Youtube, задания на Питоне, обсуждения и помощь в лучших русскоязычных чат-сообществах — ODS.ai и ClosedCircles.

После него вы не станете экспертом, но поймете про что все это, сможете применять DL на практике и будете способны разбираться дальше сами. Ну, в лучшем случае.

Одновременно и в том же объеме курс будет читаться для магистрантов Новосибирского Государственного Университета, а также студентов CS центра Новосибирска.

Выглядеть объяснение на пальцах будет примерно так:

Главная ссылка — dlcourse.ai. Подробности ниже.

Что не так с обучением с подкреплением (Reinforcement Learning)?

2019-01-21 в 23:25, admin, рубрики: reinforcement learning, искусственный интеллект, машинное обучение, нейронные сети, обучение с подкреплением

Еще в начале 2018 года вышла статья Deep Reinforcement Learning Doesn't Work Yet ("Обучение с подкреплением пока не работает"). Основная претензия которой сводилась к тому, что современные алгоритмы обучения с подкреплением требуют для решения задачи примерно столько же времени, как и обычный случайный поиск.

Изменилось ли что-то с того времени? Нет.

Обучение с подкреплением считается одним из трех основных путей к созданию сильного ИИ. Но трудности, с которыми сталкивается эта область машинного обучения, и методы, которыми ученые пытаются бороться с этими трудностями, наводят на мысль что, возможно, с самим этим подходом имеются фундаментальные проблемы.

NeurIPS: как покорить лучшую конференцию по ML

2018-11-27 в 11:00, admin, рубрики: Competition, deep learning, machine learning, neural networks, reinforcement learning, Блог компании Open Data Science, искусственный интеллект, конференции, машинное обучениеNeurIPS –– конференция, которая на данный момент считается самым топовым событием в мире машинного обучения. Сегодня я расскажу вам о своем опыте участия в конкурсах NeurIPS: как потягаться с лучшими академиками мира, занять призовое место и опубликовать статью.

Neurotic Bikes: генезис

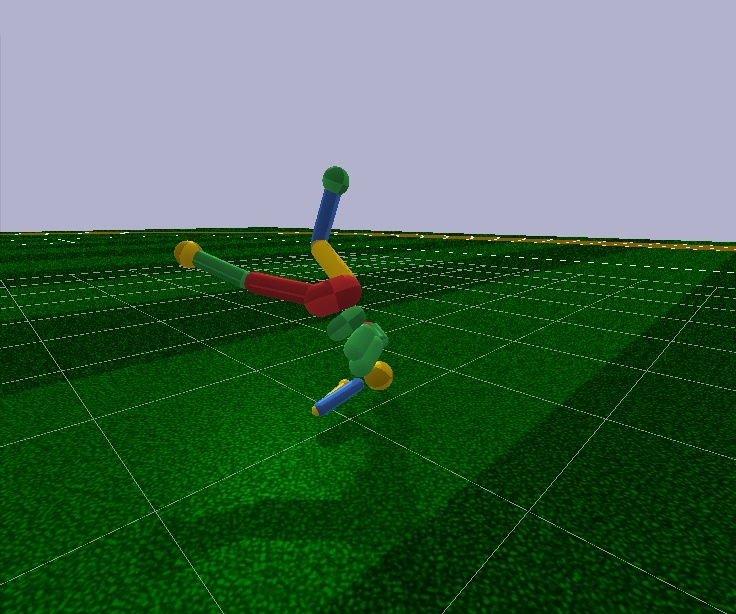

2018-10-17 в 14:13, admin, рубрики: AI, reinforcement learning, искусственный интеллект, машинное обучениеНа днях Youtube посчитал, что мне покажется интересным видео с названием «AI Learns to play Hill Climb Racing». Забавно, ведь за пару минут до этого я закоммитил очередные изменения в проект, где мы с коллегами в перерывах между работой и работой решаем именно эту задачу. Никакого «AI» в том видео, правда, не обнаружилось – автор поразвлекал публику баловством с Box2D и на том успокоился. Тем не менее, предлагаю считать этот факт убедительным доказательством актуальности темы и разобрать устройство нашей погремушки.

Коротко о задаче: транспортное средство – в нашем случае это то ли Чужой, то ли швейная машинка «Зингеръ» на колесах, назовем его просто «агент» – должно проехать по наперлинным одноименным шумом барханам от старта до финиша. Вот так выглядит агент в своей песочнице:

Агент, коснувшийся спиной трека или не демонстрирующий должного рвения в продвижении к цели, снимается с трассы.

Читать полностью »

Эффективные методы сжатия данных при тренировке нейросетей. Лекция в Яндексе

2018-03-11 в 12:37, admin, рубрики: alexnet, CNTK, cpu, DNN, fragmentation, gist, gpu, gzip, lcp, LSTM, memory management, mxnet, pool, reinforcement learning, relu, resnet, TensorFlow, Блог компании Яндекс, глубокие сети, машинное обучение, сжатие данныхНе так давно в Яндекс приезжал Геннадий Пехименко — профессор Университета Торонто и PhD Университета Карнеги-Меллон. Он прочитал лекцию об алгоритмах кодирования, которые позволяют обходить проблему ограничения памяти GPU при обучении глубоких нейронных сетей.

— Я вхожу в несколько групп Университета Торонто. Одна из них — Computer Systems and Networking Group. Есть еще моя собственная группа — EcoSystem Group. Как видно из названий групп, я не специалист непосредственно в машинном обучении. Но нейронные сети сейчас достаточно популярны, и людям, которые занимаются компьютерной архитектурой и сетями, компьютерными системами, приходится сталкиваться с этими приложениями на постоянной основе. Поэтому последние полтора-два года этой темой я тоже плотно занимаюсь.

Читать полностью »