Рубрика «pytorch» - 3

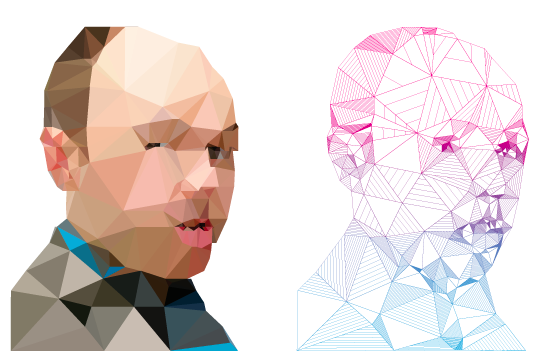

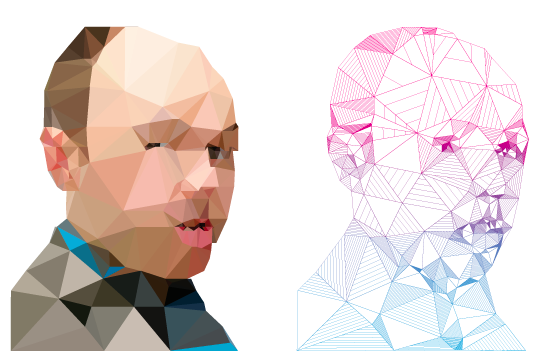

Digital art и искусственный интеллект — симбиоз цифр и искусства

2022-01-29 в 13:48, admin, рубрики: AI, nft, python, pytorch, TensorFlow, искусственный интеллект, картинки, Криптовалюты, машинное обучение, обработка изображений, распознавание изображений, Софт, цифровой арт

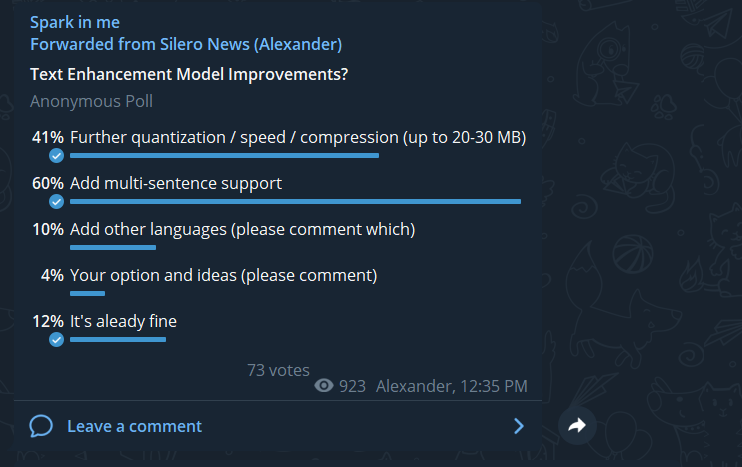

Восстановление знаков пунктуации и заглавных букв — теперь и на длинных текстах

2021-12-09 в 17:06, admin, рубрики: big data, natural language processing, python, pytorch, silero, запятая, знаки препинания, машинное обучение, нейросеть, прописные буквы

После релиза нашей первой модели, расставляющей знаки препинания и большие буквы, было много пожеланий доработать её, чтобы она могла обрабатывать тексты целиком, а не отдельные предложения. Это коллективное пожелание и было осуществлено в нашей новой версии модели.

В целом, архитектура и датасеты остались прежними. Что изменилось:

- обучение теперь производилось не на отдельных предложениях, а на нескольких последовательных предложениях (принимаем во внимание, что конструктивное ограничение модели при обучении — 512 токенов на вход, что позволяет свободно подавать ~150 слов на любом из четырех поддерживаемых языков)

- для ускорения обучения модели сокращение словаря теперь проводилось не только на инференсе, но и на трейне, что позволило увелить размер батча

Как развитие алгоритмов сжатия остановилось 20 лет назад, или о новом конкурсе на 200 тысяч евро

2021-08-02 в 7:02, admin, рубрики: computer science, data science, deep learning, pytorch, TensorFlow, Алгоритмы, алгоритмы сжатия, арифметическое сжатие, искусственный интеллект, машинное обучение, Научно-популярное, нейросети, призы, Программирование, сжатие данных, скорость прогресса, соревнования, теорема Шеннона, трансформеры

В октябре прошлого года я опубликовал статью «О талантах, деньгах и алгоритмах сжатия данных», где с юмором описал, как «изобретают» новые алгоритмы сжатия люди, не имеющие достаточно навыков для реализации своих идей. А заодно рассказал про существующие конкурсы по новым алгоритмам, в том числе двигавшийся тогда к завершению конкурс алгоритмов сжатия с призовым фондом 50 тысяч евро.

Пост набрал 206 «плюсов», вышел на 2 место топа недели и вызвал оживленную дискуссию, в которой мне больше всего понравился комментарий: «Коммерческого интереса эффективность по сжатию алгоритмов сжатия без потерь сегодня не представляет, в силу отсутствия принципиально более эффективных алгоритмов. Деньги сегодня — в сжатии аудио-видео. И там и алгоритмы другие. Тема сжатия без потерь удобна именно лёгкостью верификации алгоритма, и не слегка устарела. Лет на 20.»

Поскольку я сам уже 20 лет в области сжатия видео, с ее бурным развитием мне спорить сложно. А вот что сжатие без потерь развиваться перестало… Хотя логика тут понятна каждому. Я до сих пор пользуюсь ZIP, все мои друзья пользуются ZIP с 1989 года — значит, ничего нового не появляется. Так ведь? Похоже рассуждают сторонники плоской земли. ))) Я не видел, знакомые не видели, и даже некоторые авторитеты утверждают, значит, это так!

О том, как Intel просили меня не прекращать читать курс по сжатию, ибо людей нет новые алгоритмы делать, я в прошлый раз писал. Но тут и Huawei в ту же дуду дует! Вместо того, чтобы раздать призы и должности победителям, а затем успокоиться, поскольку развитие давно встало, эти эксцентричные люди посчитали конкурс крайне успешным и запустили новый с призовым фондом 200 тысяч EUR.

Развивались ли алгоритмы сжатия без потерь в последние 20 лет? Чем закончился прошлый конкурс и на сколько опередили baseline? Сколько денег получили русские таланты, а сколько зарубежные? И есть ли вообще жизнь на Марсе в сжатии без потерь?

Кому интересно — добро пожаловать под кат! Читать полностью »

BERT для классификации русскоязычных текстов

2021-07-10 в 9:09, admin, рубрики: BERT, huggingface, natural language processing, pytorch, Transformers, машинное обучениеЗачем

В интернете полно прекрасных статей про BERT. Но часто они слишком подробны для человека, который хочет просто дообучить модель для своей задачи. Данный туториал поможет максимально быстро и просто зафайнтюнить русскоязычный BERT для задачи классификации. Полный код и описание доступны в репозитории на github, есть возможность запустить все в google colab одной кнопкой.

Workflow

-

Данные для обучения

-

Модель

-

Helpers

-

Train

-

Inference

Данные для обучения

Для обучения использовались очищенные данные русскоязычного твиттера из датасета Читать полностью »

Как экономить память и удваивать размеры моделей PyTorch с новым методом Sharded

2021-01-07 в 15:13, admin, рубрики: big data, data science, deep learning, machine learning, python, pytorch, skillfactory, Блог компании SkillFactory, глубокое обучение, искусственный интеллект, машинное обучениеМодели глубокого обучения улучшаются с увеличением количества данных и параметров. Даже с последней моделью GPT-3 от Open AI, которая использует 175 миллиардов параметров, нам ещё предстоит увидеть плато роста количества параметров.

Для некоторых областей, таких как NLP, рабочей лошадкой был Transformer, который требует огромных объёмов памяти графического процессора. Реалистичные модели просто не помещаются в памяти. Последний метод под названием Sharded [букв. ‘сегментированный’] был представлен в Zero paper Microsoft, в котором они разработали метод, приближающий человечество к 1 триллиону параметров.

Специально к старту нового потока курса по Machine Learning, делюсь с вами статьей о Sharded в которой показывается, как использовать его с PyTorch сегодня для обучения моделей со вдвое большей памятью и всего за несколько минут. Эта возможность в PyTorch теперь доступна благодаря сотрудничеству между командами FairScale Facebook AI Research и PyTorch Lightning.

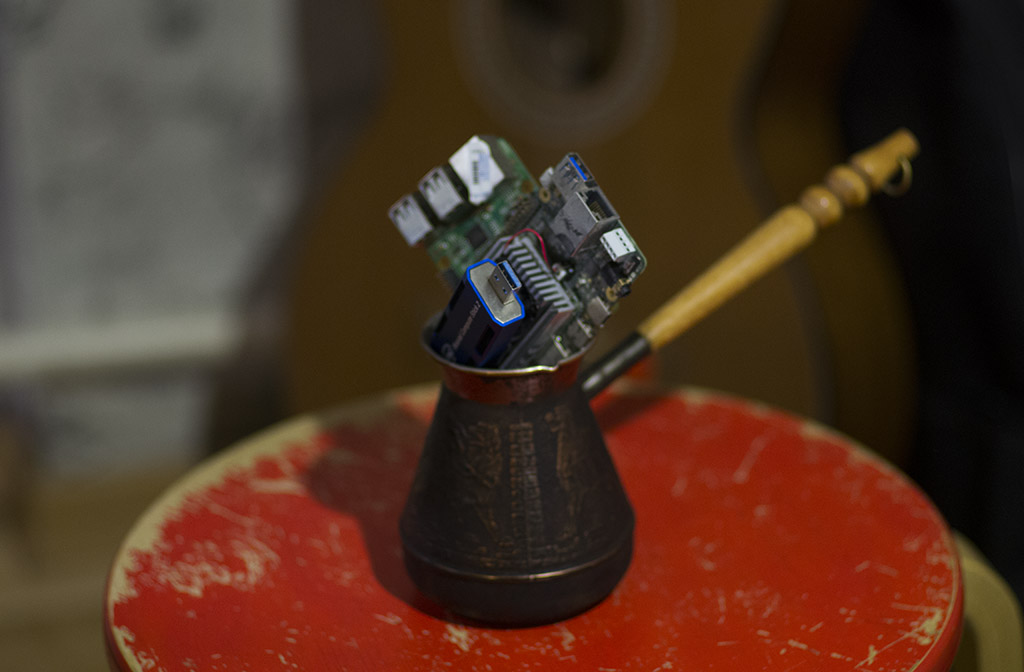

Как запихать нейронку в кофеварку

2020-10-27 в 6:34, admin, рубрики: devops, Edge TPU, Google Edge, Google TPU, gyrfalcon, inference, MNN, myriad, ncnn, ONNX, ONNX runtime, ONNX.js, opencv, OpenVINO, pytorch, Pytorch mobile, Tencent cnn, TensorFlow, Tensorflow lite, tensorrt, TorchScript, triton, Анализ и проектирование систем, Блог компании Recognitor, Компьютерное железо, машинное обучениеМир машинного обучения продолжает стремительно развиваться. Всего за год технология может стать мейнстримом, и разительно измениться, придя в повседневность.

За прошедший год-полтора, одной из таких технологий, стали фреймворки выполнения моделей машинного обучения. Не то, что их не было. Но, за этот год, те которые были — стали сильно проще, удобнее, мощнее.

В статье я попробую осветить всё что повылезало за последнее время. Чтобы вы, решив использовать нейронную сеть в очередном калькуляторе, знали куда смотреть.

Читать полностью »

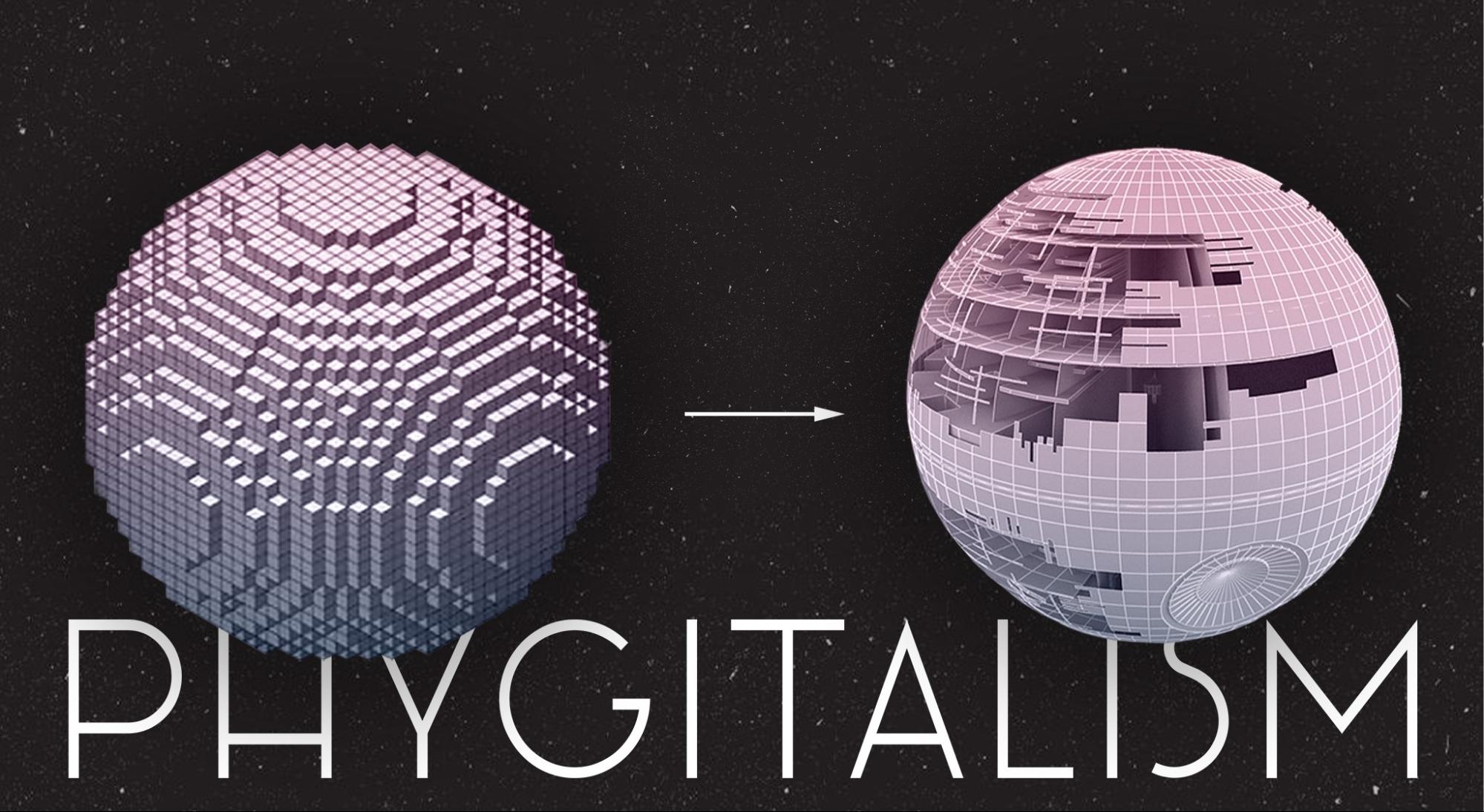

3D ML. Часть 1: формы представления 3D-данных

2020-05-22 в 14:47, admin, рубрики: machine learning, python, pytorch, Блог компании IT-центр МАИ, искусственный интеллект, Работа с 3D-графикой

Сегодня появляется все больше 3D датасетов и задач, связанных с 3D данными. Это связано с развитием робототехники и машинного зрения, технологий виртуальной и дополненной реальности, технологий медицинского и промышленного сканирования. Алгоритмы машинного обучения помогают решать сложные задачи, в которых необходимо классифицировать трехмерные объекты, восстанавливать недостающую информацию о таких объектах, или же порождать новые. Несмотря на достигнутые успехи, в области 3D ML остаются нерешенными еще очень много задач, и эта серия заметок призвана популяризировать направление среди русскоязычного сообщества.

В первой части будут рассмотрены основные формы и форматы представления пространственных данных и их особенности.

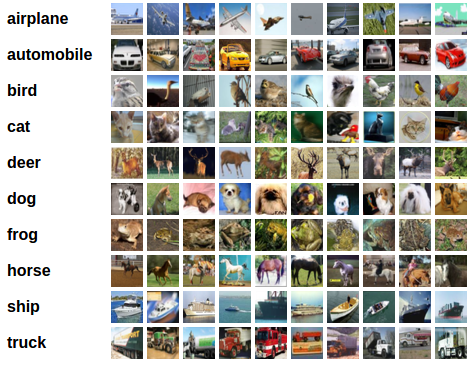

Ваша первая нейронная сеть на графическом процессоре (GPU). Руководство для начинающих

2020-03-16 в 10:10, admin, рубрики: Anaconda Python, ml, Nvidia, python, pytorch, машинное обучение, облачные сервисы, обработка изображений, хостинг

В этой статье я расскажу как за 30 минут настроить среду для машинного обучения, создать нейронную сеть для распознавания изображений a потом запустить ту же сеть на графическом процессоре (GPU).

Для начала определим что такое нейронная сеть.

В нашем случае это математическая модель, а также её программное или аппаратное воплощение, построенная по принципу организации и функционирования биологических нейронных сетей — сетей нервных клеток живого организма. Это понятие возникло при изучении процессов, протекающих в мозге, и при попытке смоделировать эти процессы.

Нейронные сети не программируются в привычном смысле этого слова, они обучаются. Возможность обучения — одно из главных преимуществ нейронных сетей перед традиционными алгоритмами. Технически обучение заключается в нахождении коэффициентов связей между нейронами. В процессе обучения нейронная сеть способна выявлять сложные зависимости между входными данными и выходными, а также выполнять обобщение.

С точки зрения машинного обучения, нейронная сеть представляет собой частный случай методов распознавания образов, дискриминантного анализа, методов кластеризации и прочих методов.

Оборудование

Сначала разберемся с оборудованием. Нам необходим сервер с установленной на нем операционной системой Linux. Оборудование для работы систем машинного обучения требуется достаточно мощное и как следствие дорогое. Тем, у кого нет под рукой хорошей машины, рекомендую обратить внимание на предложение облачных провайдеров. Необходимый сервер можно получить в аренду быстро и платить только за время использования.

Читать полностью »

Детектирование аномалий с помощью автоенкодеров на Python

2020-03-09 в 6:19, admin, рубрики: anomaly detection, autoencoder, machine learning, python, pytorch, sklearn, автоенкодер, автокодировщик, машинное обучение, ПрограммированиеДетектирование аномалий — интересная задача машинного обучения. Не существует какого-то определенного способа ее решения, так как каждый набор данных имеет свои особенности. Но в то же время есть несколько подходов, которые помогают добиться успеха. Я хочу рассказать про один из таких подходов — автоенкодеры.

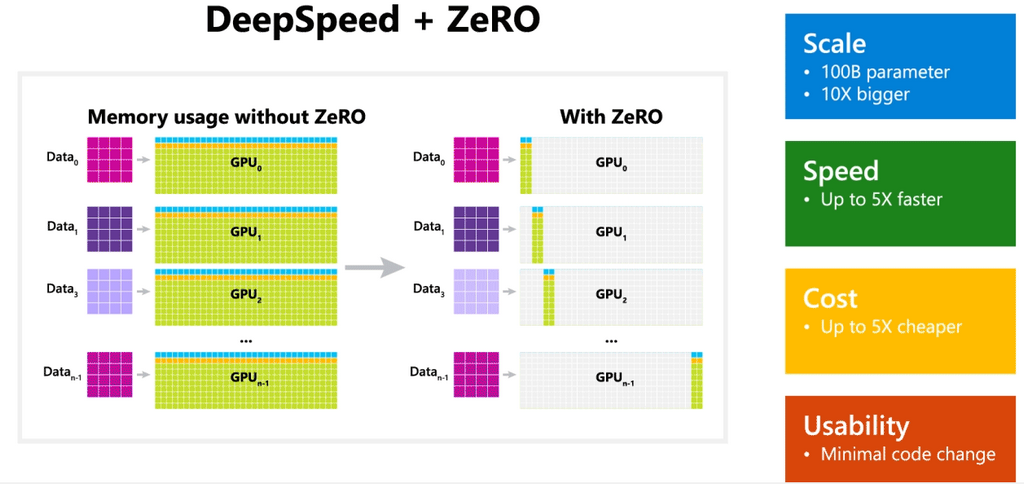

Microsoft представила DeepSpeed для тренировки нейросетей на моделях с >100 млрд параметров

2020-02-11 в 14:01, admin, рубрики: deep learning, microsoft, pytorch, zero, библиотеки, глубокое обучение, искусственный интеллект, нейронные сети, управление разработкой

Microsoft выпускает библиотеку с открытым исходным кодом под названием DeepSpeed, которая значительно расширяет возможности обучения для больших моделей естественного языка. Она дает возможность обучения нейросетей на моделях со 100 млрд параметров и более. DeepSpeed совместима с PyTorch. Читать полностью »