Сводная таблица – один из самых базовых видов аналитики. Многие считают, что создать её средствами SQL невозможно. Конечно же, это не так.

Читать полностью »

Рубрика «pivot tables»

Сводные таблицы в SQL

2020-06-28 в 6:33, admin, рубрики: mysql, oracle database, pivot tables, Pivoting, posgresql, rows to columns, sql, sql server, tricks, сводные таблицыНадстройка для Excel, облегчающая установку фильтров при работе с кубами (VBA)

2019-08-29 в 14:28, admin, рубрики: Analysis Services, big data, data mining, Excel, Microsoft SQL Server, office, olap, olap-кубы, pivot tables, sql server, ssas, vba, кубы, макрос, надстройка, расширение, сводные таблицыКак известно, из коробки Excel не позволяет устанавливать фильтры по списку значений для сводных таблиц, а это ведь такая нужная вещь! Как отфильтровать товары по сотне кодов, а потом по другой сотне? Есть, конечно, способы, но все это не то…

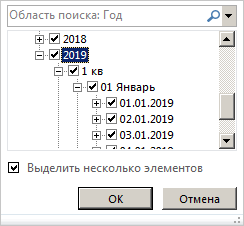

Или, например, установить для куба фильтр по измерению с датами, но не проставлять галочки на каждом дне/месяце/годе, а задать диапазон С… ПО ....

Или, например, установить для куба фильтр по измерению с датами, но не проставлять галочки на каждом дне/месяце/годе, а задать диапазон С… ПО ....

Еще достаточно часто требуются установки периодов по фиксированным шаблонам, типа текущий день/месяц/год. Для этих целей можно добавить наборы (в многомерной модели куба) или добавить специальные атрибуты в измерение (это не очень удобно, но в табличной модели куба наборов нет).

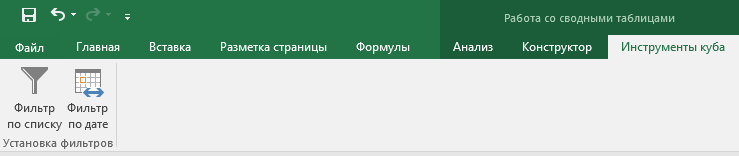

Мы запилили на VBA расширение, добавляющее на ленту панель Инструменты куба с волшебными кнопочками.

Читать полностью »

Открытый курс машинного обучения. Тема 1. Первичный анализ данных с Pandas

2017-02-28 в 9:45, admin, рубрики: churn rate, data analysis, data mining, data science, mlcourse_open, ods, pandas, pivot tables, python, seaborn, Блог компании Open Data Science, визуализация данных, машинное обучение, уроки pythonСтарт открытого курса OpenDataScience

Привет всем, кто ждал запуска открытого курса по практическому анализу данных и машинному обучению!

Первая статья посвящена первичному анализу данных с Pandas.

Пока в серии планируется 7 статей, идущих вместе с тетрадками Jupyter (репозиторий mlcourse_open), соревнованиями и домашними заданиями.

Далее идет список будущих статей, описание курса и собственно, первая тема – введение в Pandas.

Генерация больших объемов полезных данных

2013-09-30 в 4:52, admin, рубрики: pivot tables, regexp, sql, Алгоритмы, Регулярные выражения, метки: pivot tables, regexp, sql, регулярные выражения Хочу поделиться опытом создания механизма генерации большой базы данных товаров. С его помощью наши пользователи могут за несколько минут сгенерировать более миллиона однотипных, но разных записей.

Читать полностью »

Data Mining: Первичная обработка данных при помощи СУБД. Часть 3 (Сводные таблицы)

2013-01-21 в 19:01, admin, рубрики: big data, data mining, kaggle, pivot tables, postgresql, sql, titanik, метки: big data, data mining, kaggle, pivot tables, postgresql, titanik Данная серия посвящена анализу данных для поиска закономерностей. В качестве примера используется одна из обучающих задач сообщества спортивного анализа данных Kaggle. Хотя размеры данных для задачи не большие, методы обработки, которые будут рассматриваться вполне применимы для больших объемов данных.

После выполнения Часть 1 и Части 2 сформировались две таблицы, содержащие преобразованные данные.

titanik_test_3 и titanik_train_3.

Читать полностью »

Немного о Pivot tables в PostgreSQL и Python

2012-12-17 в 15:32, admin, рубрики: pandas, pivot tables, postgresql, python, Песочница, метки: pandas, pivot tables, postgresql, pythonДоброго времени суток.

Работая в институте, мне приходится иметь дело с большим количеством полу-структурированной информации. Здесь приставка «полу» значит, что в целом все данные похожи, но, как правило, распиханы в локальных папках на компьютерах у сотрудников, в .xls, .txt или в бинарном формате. Информация представляет из себя данные полученные с различных приборов( датчиков уровня, температуры, скорости течений, атмосферного давления, влажности и так далее до 20-30 различных параметров). Все приборы выгружают данные каждый в своем формате: либо в ascii либо бинарный формат, который потом обрабатывается, и, на выходе, снова получаются ascii. Ну вообщем все как всегда, вы и сами представляете весь этот хаос.

Захотелось мне все это дело запихнуть в одну общую базу данных, что бы не искать нужные данные нужной версии в нужной папке, что занимает крайне много времени. Опыт разработки различных систем (в основном гео-информационных) имеется. Но то, что делалось раньше, содержало в себе исключительно обработанные данные, и в целом все эти системы делались под заказчика. Никакого комплекса автоматизации для самих себя не было.

Обработка всего этого хозяйства — вполне стандартные вещь, ничего нового и интересного: проверка временных рядов на целостность(если нужна – интерполяция), построение кучи различных графиков, запуск различных моделей на этих данных, обработка вывода моделей(снова куча графиков), вывод статистики. О последней я и расскажу в этой статье.