В последнее время такие компании, как OpenAI и Google, заключают эксклюзивные соглашения об обмене данными с издателями, крупными форумами вроде Reddit и социальными медиаплатформами, что становится для них ещё одним способом сконцентрировать власть.

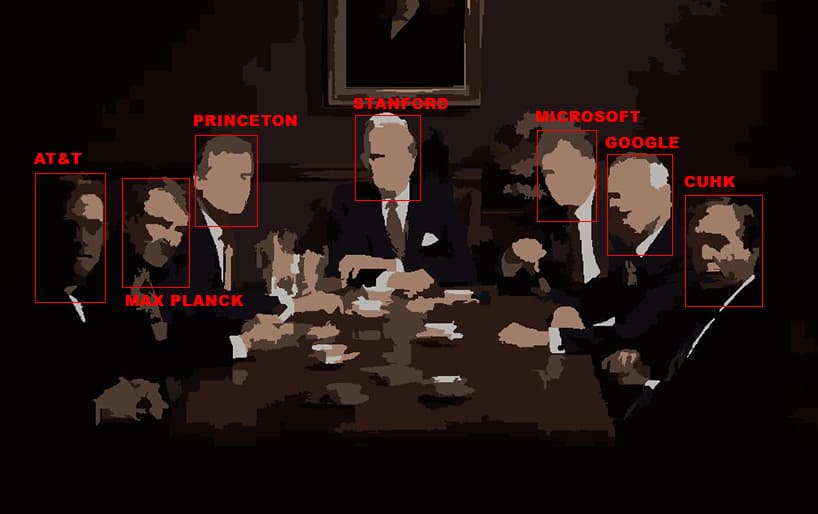

Такая тенденция выгодна крупнейшим игрокам на рынке ИИ, которые могут позволить себе такие сделки, в отличие от исследователей, некоммерческих организаций и небольших компаний. Крупнейшие корпорации располагают лучшими ресурсами для сбора датасетов. В результате эталонные датасеты для бенчмарков (и для обучения) моделей ИИ всё больше концентрируются в руках малого количества корпораций и академических учреждений.

По мнению некоторых исследователей, это «новая волна асимметричного доступа», которой ещё не было в истории открытого интернета в таком масштабе.Читать полностью »