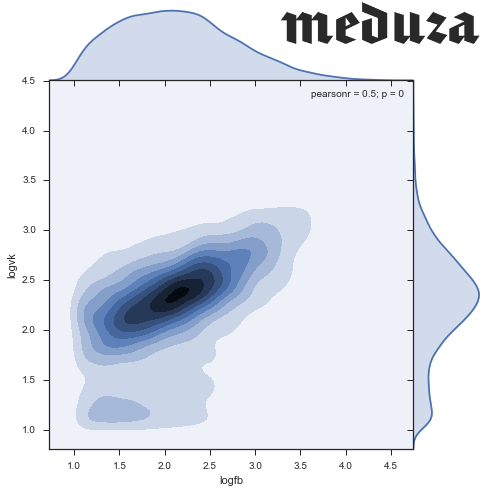

Как-то раз, читая новости на Медузе, я обратил внимание на то, что у разных новостей разное соотношение лайков из Facebook и ВКонтакте. Какие-то новости мегапопулярны на fb, а другими люди делятся только во ВКонтакте. Захотелось присмотреться к этим данным, попытаться найти в них интересные закономерности. Заинтересовавшихся приглашаю под кат!

Рубрика «pandas» - 8

Meduza.io: а как же лайки?

2016-05-06 в 8:52, admin, рубрики: data mining, pandas, python, seaborn, визуализация данныхПарадокс Симпсона и немного Pandas

2016-03-19 в 21:33, admin, рубрики: pandas, python, математика, парадоксыО чем статья?

В этой статье я хочу рассмотреть один из наиболее известных примеров парадокса Симпсона, попутно немного рассказав о MultiIndex в Pandas.

Обо всем по порядку.

Парадокс Симпсона — контринтуитивное явление в Статистике, когда мы видим в каждой из групп данных определенную зависимость, но при объеденении этих групп зависимость исчезает или становится противоположной. Например, если смотреть изменение среднего заработка женщин 25 лет и старше, работающих полный день, между 2000 и 2012 годами с различным уровнем образования, то мы получим следующие цифры (все расчеты проводились с поправкой на инфляцию):

- Less than 9th grade -3.7%

- 9th-12th but didn’t finish -6.7%

- High school graduate -3.3%

- Some college but no degree -3.7%

- Associate’s degree -10.0%

- Bachelor’s degree or more -2.7%

По этим цифрам можно сделать вывод, что заработок женщин за 12 лет снизился. Однако, на самом деле, средний заработок женщин с полной занятостью вырос на 2.8% (подробнее про этот пример можно почитать тут).

Одним из наиболее известных примеров парадокса Симпсона является случай половой дискриминации при поступлении в Калифорнийский унивеситет Berkeley. Его и будем рассматривать далее.

Читать полностью »

Pandasql vs Pandas для решения задач анализа данных

2016-03-14 в 10:40, admin, рубрики: pandas, pandasql, python, анализ данныхО чем речь?

В этой статье я бы хотела рассказать о применении python-библиотеки Pandasql.

Многие люди, сталкивающиеся с задачами анализа данных, уже, скорее всего, знакомы с библиотекой Pandas. Pandas позволяет быстро и удобно работать с табличными данными: фильтровать, группировать, делать join над данными; строить сводные таблицы и даже рисовать графики (для простых визуализации достаточно функции plot(), а если хочется чего-то позаковыристее, то поможет библиотека matplotlib). На Хабре не раз рассказывали о применении этой библиотеки для работы с данными: раз, два, три.

Но по моему опыту далеко не все знают о библиотеке Pandasql, которая позволяет работать с Pandas DataFrames как с таблицами и обращаться к ним, используя язык SQL. В некоторых задачах проще выразить желаемое с помощью декларативного языка SQL, поэтому я считаю, что людям, работающим с данными, полезно знать о наличии такой функциональности. Если говорить о реальных задачах, то я использовала эту библиотеку для решения задачи join'a таблиц по нечетким условиям (необходимо было объединить записи о событиях из разных систем по примерно совпадающему времени, разрыв порядка 5 секунд).

Рассмотрим использование этой библиотеки на конкретных примерах.

Читать полностью »

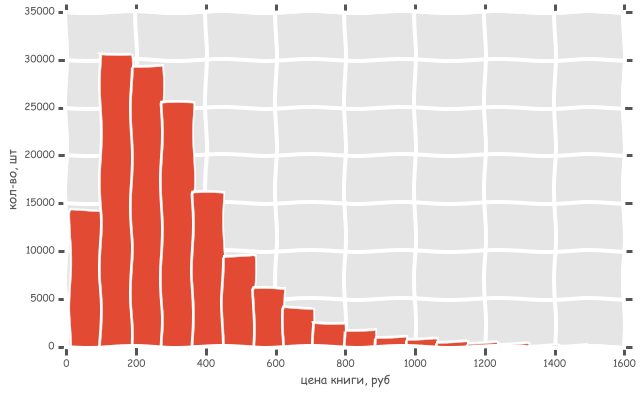

Сравниваем цены в книжных интернет магазинах c помощью python, pandas и matplotlib

2016-02-09 в 7:32, admin, рубрики: data mining, matplotlib, pandas, python Сегодня мы попробуем найти самый дешевый и самый дорогой интернет магазин книг.

Сравнивать будем бумажные книги, которые есть в наличии. В разных магазинах очень разное количество книг. Где-то менее 1000, а где-то более 200 000 книг.

Кстати, гистограмма настоящая. Как она построена и другие интересные закономерности под катом.

Читать полностью »

Python и красивые ножки: как я бы знакомил сына с математикой и программированием

2016-01-26 в 21:25, admin, рубрики: matplotlib, pandas, python, scipy, sympy, дифференцирование, занимательная математика, Занимательные задачки, математика, оптимизация, Программирование, символьные вычисленияРаньше мы уже искали необычные модели Playboy с помощью библиотеки Python Scikit-learn. Теперь мы продемонстрируем некоторые возможности библиотек SymPy, SciPy, Matplotlib и Pandas на живом примере из разряда занимательных школьных задач по математике. Цель — облегчить порог вхождения при изучении Python библиотек для анализа данных.

Kaggle и Titanic — еще одно решение задачи с помощью Python

2015-12-28 в 16:16, admin, рубрики: kaggle, matplotlib, ml, pandas, python, sklearn, titanic, xdboost, машинное обучение, Программирование, Спортивное программированиеХочу поделиться опытом работы с задачей известного конкурса по машинному обучению от Kaggle. Этот конкурс позиционируется как конкурс для начинающих, а у меня как раз не было почти никакого практического опыта в этой области. Я немного знал теорию, но с реальными данными дела почти не имел и с питоном плотно не работал. В итоге, потратив пару предновогодних вечеров, набрал 0.80383 (первая четверть рейтинга).

В общем эта статья для еще начинающих от уже начавшего.

Необычные модели Playboy, или про обнаружение выбросов в данных c помощью Scikit-learn

2015-02-23 в 0:15, admin, рубрики: anomaly detection, data mining, machine learning, outlier detection, pandas, PCA, python, scikit-learn, unsupervised learning, Алгоритмы Мотивированный статьей пользователя BubaVV про предсказание веса модели Playboy по ее формам и росту, автор решил углубиться if you now what I mean в эту будоражащую кровь тему исследования и в тех же данных найти выбросы, то есть особо сисястые модели, выделяющиеся на фоне других своими формами, ростом или весом. А на фоне этой разминки чувства юмора заодно немного рассказать начинающим исследователям данных про обнаружение выбросов (outlier detection) и аномалий (anomaly detection) в данных с помощью реализации одноклассовой машины опорных векторов (One-class Support Vector Machine) в библиотеке Scikit-learn, написанной на языке Python.

Построение модели SARIMA с помощью Python+R

2014-01-27 в 20:10, admin, рубрики: data mining, pandas, python, метки: pandasВведение

Добрый день, уважаемые читатели.

После написания предыдущего поста про анализ временных рядов на Python, я решил исправить замечания, которые были указаны в комментариях, но при их исправлении я столкнулся с рядом проблем, например при построении сезонной модели ARIMA, т.к. подобной функции а пакете statsmodels я не нашел. В итоге я решил использовать для этого функции из R, а поиски привели меня к библиотеке rpy2 которая позволяетиспользовать функции из библиотек упомянутого языка.

У многих может возникнуть вопрос «зачем это нужно?», ведь проще просто взять R и выполнить всю работу в нем. Я полность согласен с этим утверждением, но как мне кажется, если данные требуют предварительной обработки, то ее проще произвести на Python, а возможности R использовать при необходимости именно для анализа.

Кроме этого, будет показано как интегрировать результаты выдачи работы функции R в IPython Notebook.

Читать полностью »

Пример решения задачи множественной регрессии с помощью Python

2013-12-17 в 4:36, admin, рубрики: data mining, pandas, python, метки: pandas, pythonВведение

Добрый день, уважаемые читатели.

В прошлых статьях, на практических примерах, мной были показаны способы решения задач классификации (задача кредитного скоринга) и основ анализа текстовой информации (задача о паспортах). Сегодня же мне бы хотелось коснуться другого класса задач, а именно восстановления регрессии. Задачи данного класса, как правило, используются при прогнозировании.

Для примера решения задачи прогнозирования, я взял набор данных Energy efficiency из крупнейшего репозитория UCI. В качестве инструментов по традиции будем использовать Python c аналитическими пакетами pandas и scikit-learn.

Читать полностью »

Основы анализа данных на python с использованием pandas+sklearn

2013-11-14 в 6:59, admin, рубрики: data mining, pandas, python, метки: data mining, pandas, python Добрый день уважаемые читатели. В сегодняшней посте я продолжу свой цикл статей посвященный анализу данных на python c помощью модуля Pandas и расскажу один из вариантов использования данного модуля в связке с модулем для машинного обучения scikit-learn. Работа данной связки будет показана на примере задачи про спасенных с "Титаника". Данное задание имеет большую популярность среди людей, только начинающих заниматься анализом данных и машинным обучением.

Читать полностью »