Рубрика «OpenAI» - 6

ChatGPT как второй пилот: сильные и слабые стороны с практическими советами

2024-11-08 в 11:15, admin, рубрики: chatgpt-4, fronted development, javascript, OpenAI, React, TypeScript, ИИНемного про Chain-of-Thoughts (Цепочку размышлений)

2024-11-03 в 19:11, admin, рубрики: chatgpt, llm, OpenAIГлавные проблемы БЯМ (Больших языковых моделей):

-

Решение сложных логических проблем (Поиск неявно заданной информации)

-

Безопасность (Противодействие взломам и этичность поведения)

-

Галлюцинации (Генерация новой информации, которая не соответствует действительности)

Поиск жулика: Как понять, что перед вами ChatGPT 4?

2024-11-01 в 14:51, admin, рубрики: chatgpt, chatgpt-4, OpenAI, ИИ, ии чат-бот, чат-ботС момента появления ChatGPT 4, вопрос о том, как отличить ее на практике от старой-доброй 3.5 , волнует многих пользователей, в том числе и пользователей нашего сервиса. Простой запрос “какая версия ChatGPT передо мной?” не всегда даст правильный ответ — модели могут сообщить, что они не те, кем должны быть. И конечно же это насторожит.

Как диалоги с LLM превращаются в танец идей

2024-10-31 в 9:16, admin, рубрики: chatgpt, llm, OpenAI, techtalk, большие языковые модели, ИИ, искусственный интеллект"Вы когда-нибудь задумывались, каково это - органично сочетать технологию с творчеством?"

Привет, меня зовут Ден, и я всегда был на переднем крае технологического прогресса, движимый неутолимым любопытством к технической и творческой сторонам нашего цифрового мира, сегодня мы поговорим о LLM…

Чего на самом деле стоит ждать от ИИ и почему он начнет приносить прибыль раньше, чем кажется

2024-10-29 в 13:07, admin, рубрики: ml, OpenAI, vk cloud, ИИПартнёрство между Microsoft и OpenAI начинает давать трещины

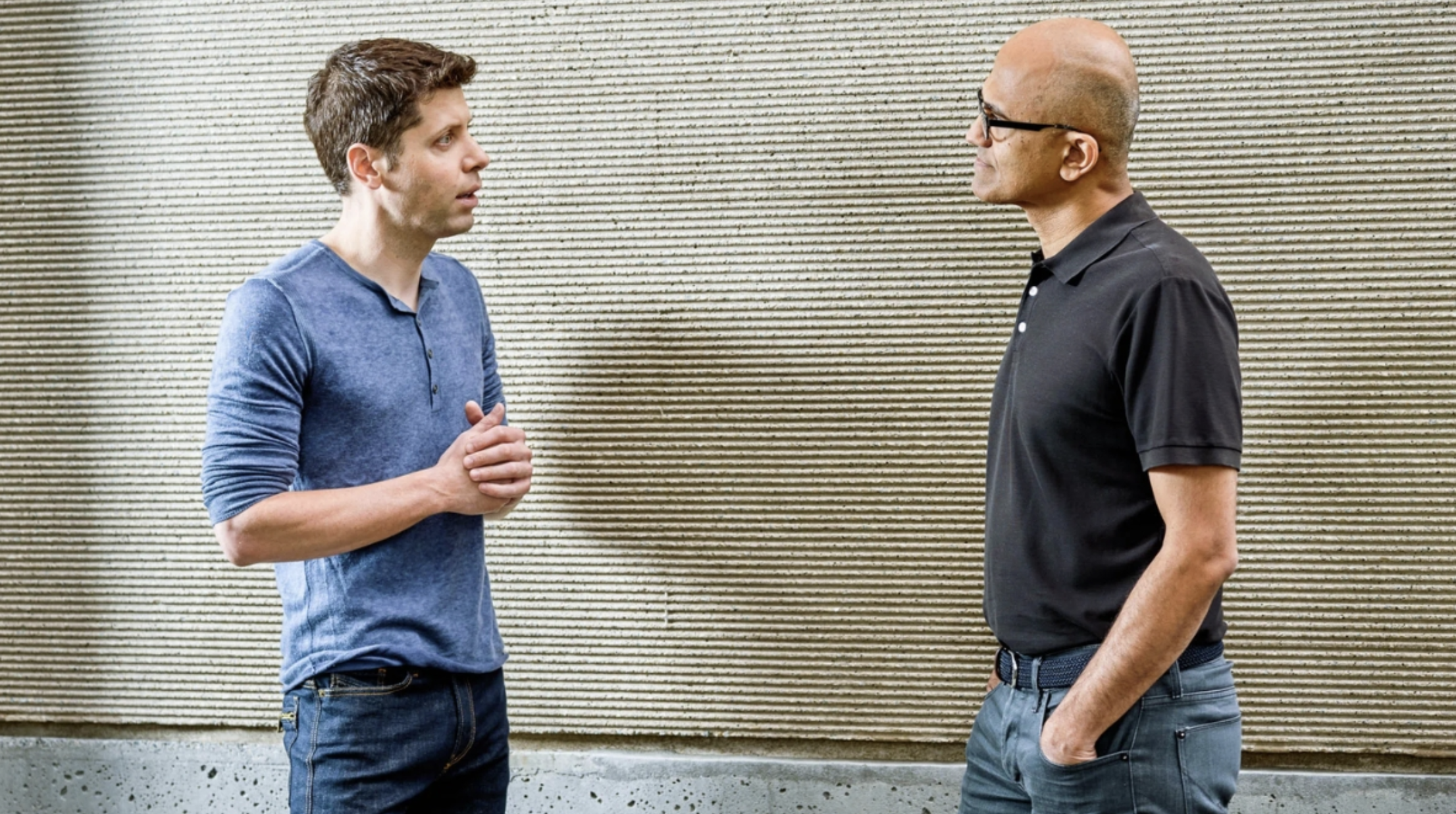

2024-10-25 в 13:05, admin, рубрики: AI, chatgpt, llm, microsoft, OpenAI, ИИ, искусственный интеллект

«Лучшая броманс» в мире технологий столкнулся с суровой реальностью: OpenAI пыталась изменить условия сделки с Microsoft, в то время как софтверный гигант искал способы снизить свои риски в отношении стартапа.

От контекста до юрисдикции: 7 ключевых параметров при выборе LLM для вашего проекта

2024-10-15 в 9:18, admin, рубрики: chatgpt, llm, maas, OpenAI, openai api, qwen, внедрение ai, выбор модели, нейросети, языковые моделиПривет! Я Сергей, продакт направления AI в Битрикс24. Последний год мы активно внедряем нейросети в наш продукт, и я хочу поделиться опытом, который может сэкономить вам время и деньги.

Оказалось, что выбор правильной модели нейросети — это целое искусство. Размеры контекста, лицензии, поддержка языков, способы доступа — от этих параметров голова идет кругом. Но разобраться в них критически важно, если вы не хотите потратить кучу времени и денег впустую.

Чем ChatGPT-4o отличается от OpenAI o1 и для чего на самом деле нужна новая модель

2024-10-15 в 8:53, admin, рубрики: AI, chatgpt, OpenAI, xcom-shop

В середине сентября компания OpenAI представила новую языковую модель со скромным названием o1Читать полностью »

ИИ без иллюзий. Развенчивание мифов

2024-10-13 в 6:20, admin, рубрики: apple, gpt, llm, nlp, OpenAI, генеративный ии, искусственный интеллект, машинное обучение, нейронные сети

В своем подкасте я грозился сам почитать статью GSM-Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models ученых из Apple и разобраться. Почитал. Разобрался. Забавная статья. Забавная не по содержанию, а по выводам, которые можно сделать, если читать между строк и выйти за границы статьи.

Сначала совсем прямой смысл.

«Мы вступаем на неизведанную территорию математики» — Теренс Тао, математик, обладатель Филдсовской премии

2024-10-08 в 10:30, admin, рубрики: AI, chatgpt, OpenAI, ИИ, математика, теренс таоУ Теренса Тао, одного из величайших из ныне живущих математиков, есть свой взгляд на искусственный интеллект.

Дисклеймер 1: это вольный перевод интервью из журнала The Atlantic. Перевод подготовила редакция «Технократии». Чтобы не пропустить анонс новых материалов подпишитесь на «Голос Технократии» — мы регулярно рассказываем о новостях про AI, LLM и RAG, а также делимся полезными мастридами и актуальными событиями.

Обсудить пилот или задать вопрос об LLM можно Читать полностью »