Рисуем Мону Лизу используя глубокое обучение с подкреплением

Пост написан специально для всех любителей искусства (и, возможно, машинного обучения).

На самом деле, специально для лучшего курса по ML.

Пост написан специально для всех любителей искусства (и, возможно, машинного обучения).

На самом деле, специально для лучшего курса по ML.

Обучение с подкреплением молодая и бурно растущая дисциплина. Это обстоятельство привело к тому что информации об этом на русском языке почти нет. Особенно, если дело касается объектно-ориентированного подхода, и практических задач не из арсенала "качалки".

Представляю вам результат простой задачи, которая как я надеюсь, убережет вас от части шишек встречающихся на этом интересном пути.

Предположим задачу, в которой нано робот с антибиотиком должен подобраться к скоплению патогенных бактерий для их уничтожения.

Загрузим Reinforsment Learning от Keras и библиотеку для анимации.

Читать полностью »

В истории о машинах, побеждающих людей, появилась новая глава: ИИ снова победил пилота-человека в виртуальном воздушном бою. Соревнование AlphaDogfight стало финалом испытаний нейросетевых алгоритмов, разработанных для американских вооруженных сил. И наилучшей демонстрацией возможностей интеллектуальных автономных агентов, способных победить вражеские самолеты в воздушном бою. Подробнее — в материале Cloud4Y.Читать полностью »

Компания Deep Mind, занимающаяся разработкой искусственного интеллекта, создала ИИ Agent57 с глубоким обучением, который получил среднюю оценку во всех 57 играх приставки Atari 2600 выше, чем человек, сообщается на сайте Deep Mind. Читать полностью »

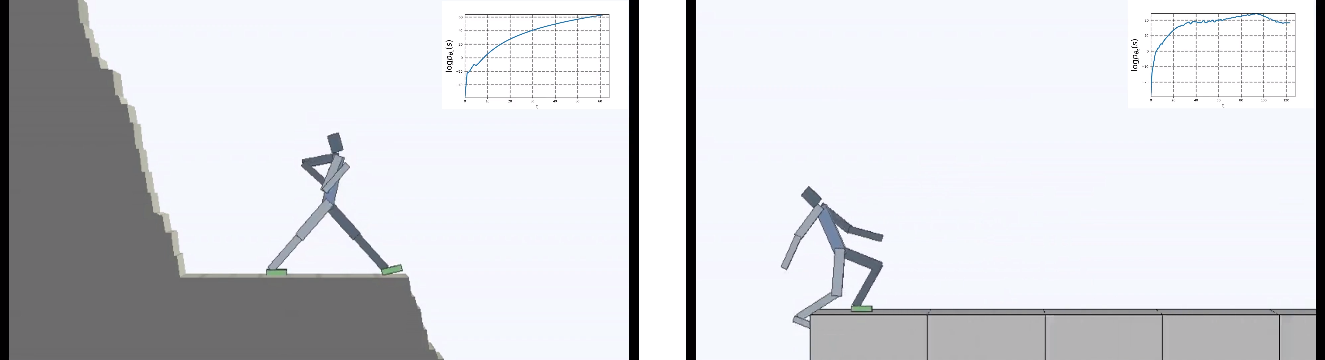

В обучении с подкреплением (Reinforcement Learning) часто используется любопытство в качестве мотивации для ИИ. Заставляющее его искать новые ощущения и исследовать окружающий мир. Но жизнь полна неприятных сюрпризов. Можно упасть с обрыва и с точки зрения любопытства это всегда будут очень новые и интересные ощущения. Но явно не то, к чему надо стремиться.

Разработчики из Berkeley перевернули задачу для виртуального агента с ног на голову: главной мотивирующей силой сделали не любопытство, а наоборот — стремление всеми силами избегать любой новизны. Но "ничего не делать" оказалось сложнее, чем кажется. Будучи помещенным в постоянно меняющийся окружающий мир, ИИ пришлось обучиться сложному поведению, чтобы избегать новых ощущений.

Обучение с подкреплением (Reinforcement Learning) делится на два больших класса: Model-Free и Model-Based. В первом случае действия оптимизируются напрямую по сигналу награды, а во втором нейросеть является только моделью реальности, а оптимальные действия выбираются с помощью внешнего планировщика. У каждого подхода есть свои достоинства и недостатки.

Разработчики из Berkeley и Google Brain представили Model-Based алгоритм PDDM с улучшенным планировщиком, позволяющий эффективно обучаться сложным движениям с большим числом степеней свободы на небольшом числе примеров. Чтобы научиться вращать мячи в роботизированной руке с реалистичными суставами пальцев с 24 степенями свободы, потребовалось всего 4 часа практики на реальном физическом роботе.

С четырьмя параметрами я могу задать слона, а с пятью я могу заставить его шевелить хоботом.

– John Von Neumann

Идея «дифференцируемого программирования» очень популярна в мире машинного обучения. Для многих не ясно, отражает ли этот термин реальный сдвиг в том, как исследователи понимают машинное обучение, или это просто (еще один) ребрендинг «глубокого обучения». В этом посте разъясняется, что нового дает дифференцируемое программирование (или ∂P) в таблице машинного обучения.

Самое главное, дифференцируемое программирование — это сдвиг, противоположный направлению глубокого обучения; от все более сильно параметризованных моделей к более простым, которые в большей степени используют структуру проблемы.

Далее мы пролистаем полотно неинтересного текста, захотим узнать, что такое автодифференцирование и даже популяем из катапульты!

Мы привыкли к тому, что специалисты по машинному обучению огромную часть своего рабочего времени сидят над анализом табличных данных или обучают нейросеть для раскладывания фотографий кошек и собак на две аккуратные кучки. Ибо такова воля бизнеса — чаще всего нужно давать прогнозы, классифицировать данные и строить модели.

Сегодня мы проветрим мозги и разомнем дряблеющие от скуки синапсы с помощью кое-чего интересного — OpenAI Gym.

Привет!

Мы нечасто решаемся размещать здесь переводы текстов двухлетней давности, без кода и явно академической направленности — но сегодня сделаем исключение. Надеемся, что дилемма, вынесенная в заголовок статьи, волнует многих наших читателей, а фундаментальную работу об эволюционных стратегиях, с которой полемизирует этот пост, вы уже читали в оригинале или прочитаете сейчас. Добро пожаловать под кат!

Демис Хассабис основал компанию по созданию самого мощного в мире ИИ. Затем её купила Google

В августе 2010 года в конференц-зале в пригороде Сан-Франциско на сцену вышел 34-летний лондонец по имени Демис Хассабис. Он вышел неторопливой походкой человека, который пытается контролировать нервы, сжал губы в краткой улыбке и начал: «Итак, сегодня мы поговорим о разных подходах к разработке...» — тут запнулся, словно вдруг осознав, что озвучивает потаённые честолюбивые помыслы. Но потом всё-таки сказал: «… сильного ИИ».

Сильный ИИ (artificial general intelligence или AGI) означает универсальный искусственный интеллект — гипотетическую компьютерную программу, способную выполнять интеллектуальные задачи как человек или даже лучше. Сильный ИИ сможет выполнять отдельные задачи, такие как распознавание фотографий или перевод текста, которые являются единственными задачами каждого из слабых ИИ в наших телефонах и компьютерах. Но он также будет играть в шахматы и говорить по-французски. Будет понимать статьи по физике, сочинять романы, разрабатывать инвестиционные стратегии и вести восхитительные беседы с незнакомыми людьми. Он будет следить за ядерными реакциями, управлять электросетями и транспортными потоками и без особых усилий преуспеет во всём остальном. AGI сделает сегодняшний самый продвинутый ИИ похожим на карманный калькулятор.

Читать полностью »