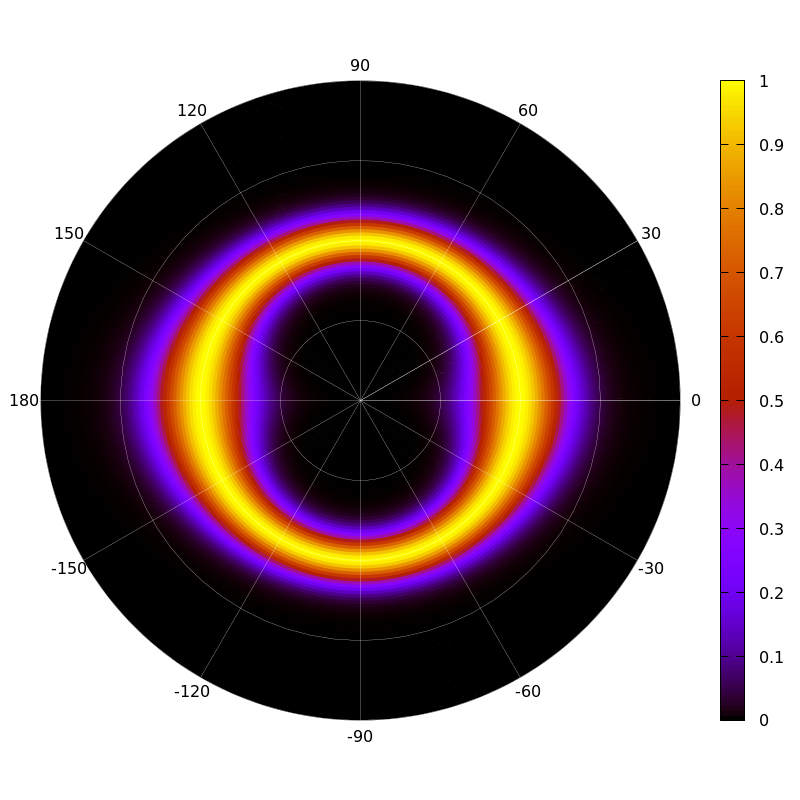

Мы уже писали о том, что NASA и другие космические агентства генерируют огромный объем информации. Данных будет еще больше после запуска в работу сети радиотелескопов и антенн Square Kilometre Array (SKA). Все эти данные нужно где-то хранить и обрабатывать.

Кроме того, NASA приходится еще иметь дело с данными со спутников, которых тоже становится все больше, как и внеземных аппаратов. Их назначение может быть самым разным — от наблюдения за Солнечной системой до изучения метеорологических условий определенного региона Земли. Объединяет их то, что они отправляют информацию на Землю, где для приема и обработки данных установлены специальные станции со специфическим и дорогим оборудованием. Недавно агентство решило сделать ход конем — начать обрабатывать и хранить все это в облаке. Подробности о проектах, которые имеют отношение к этой задаче, — под катом.

Читать полностью »