Предисловие

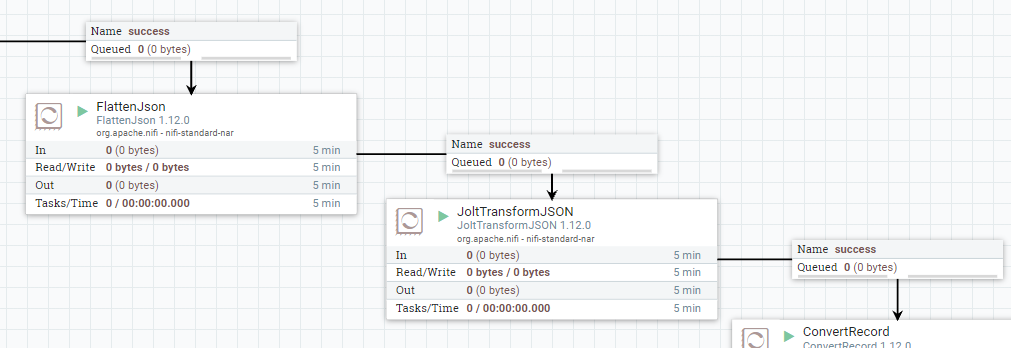

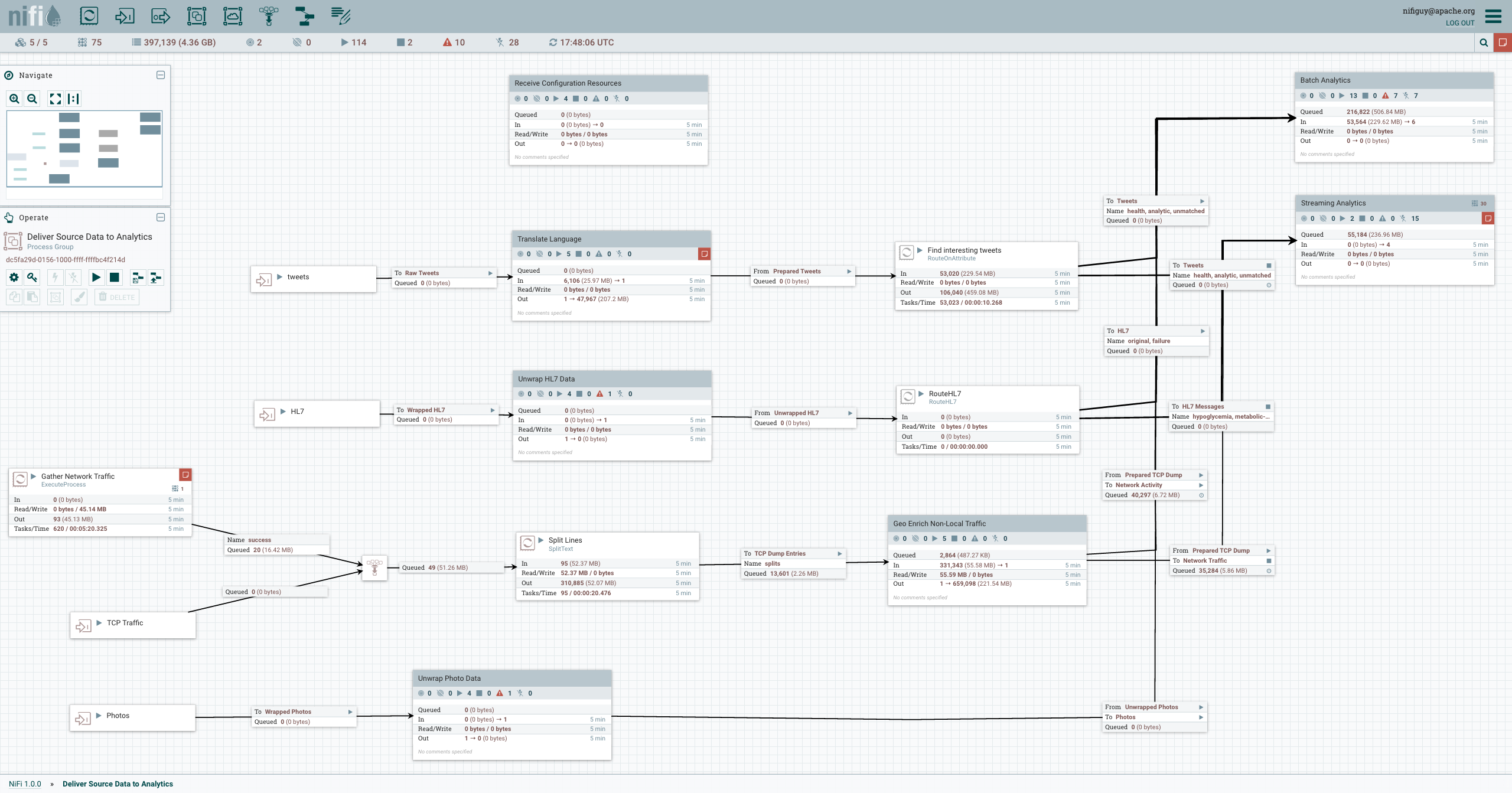

Как быстро протестировать игровую идею без лишней сложности? Я создал текстовую игру в Telegram за выходные на Apache NiFi и Groovy, весь контент для которой генерируют языковые модели.

В итоге — легковесный, почти не требующий поддержки бот, которого не больно обновлять. Идеально для MVP.

Под катом — архитектура, этапы развития и как AI не просто отвечает, а становится движком продукта.

Все началось с желания сделать что-то интересное для подписчиков моего канала в Telegram. Захотелось интерактива — простой текстовой викторины или квеста. Но разворачивать полноценный бэкенд... Не для такого пет-проекта.