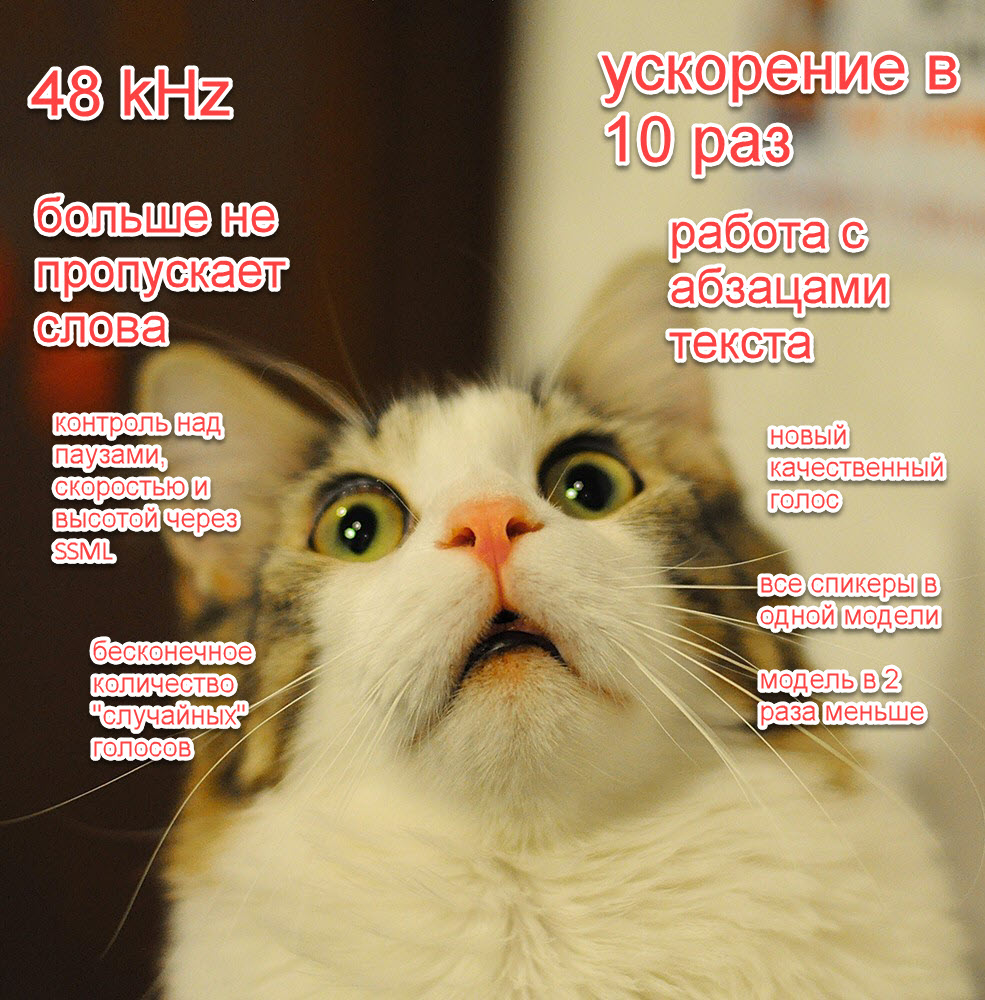

В нашей прошлой статье мы ускорили наши модели в 10 раз, добавили новые высококачественные голоса и управление с помощью SSML, возможность генерировать аудио с разной частотой дискретизации и много других фишек.

В этот раз мы добавили:

- 1 высококачественный голос на русском языке (

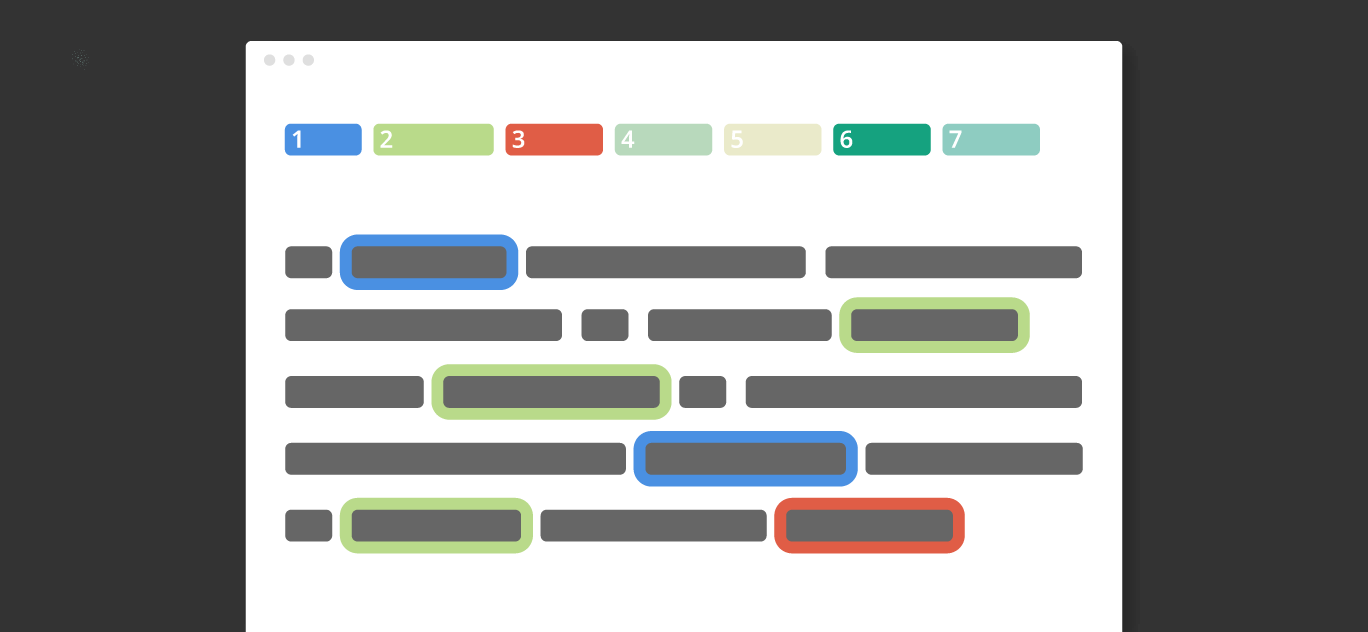

eugeny); - Синтез на 20 языках, 174 голоса;

- В список языков входят 5 языков народов СНГ: калмыцкий, русский, татарский, узбекский и украинский;

- В список языков входят 5 вариаций на тему романо-германских языков: английский, индийский английский, испанский, немецкий, французский;

- Также в список языков входят 10 языков народов Индии;

- Новую значительно улучшенную модель для простановки ударений и буквы

ёсо словарем в 4 миллиона слов и точностью 100% (но естественно с рядом оговорок); - Все модели наследуют все "фишки" прошлого релиза, кроме автоматической простановки ударений для языков отличных от русского;

Пока улучшение интерфейсов мы отложили на некоторое время. Ускорить модели еще в 3+ раза мы тоже смогли, но пока с потерей качества, что не позволило нам обновить их прямо в этом релизе.

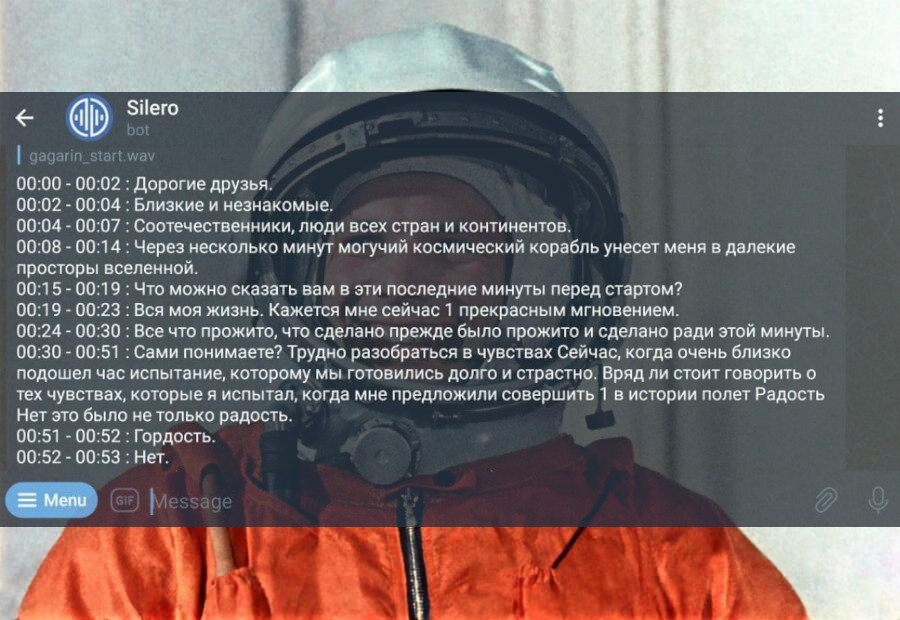

Попробовать модель как обычно можно в нашем репозитории и в колабе.