Две недели назад закончился проходивший в офисе Mail.Ru Group хакатон для студентов SmartMailHack. На хакатоне предлагался выбор из трех задач; статья от победителей во второй задаче уже есть на хабре, я же хочу описать решение нашей команды, победившей в первой задаче. Все примеры кода будут на Python & Keras (популярный фреймворк для deep learning).

Рубрика «machine learning» - 32

SmartMailHack. Решение 1-го места в задаче классификации логотипов

2018-05-06 в 19:29, admin, рубрики: cnn, data mining, deep learning, machine learning, python, классификация изображений, машинное обучение, хакатонНастройка модели машинного обучения: подбор фичей и оптимизация гиперпараметров

2018-05-01 в 12:03, admin, рубрики: data mining, kaggle, machine learning, python, Алгоритмы, математика, машинное обучениеВведение

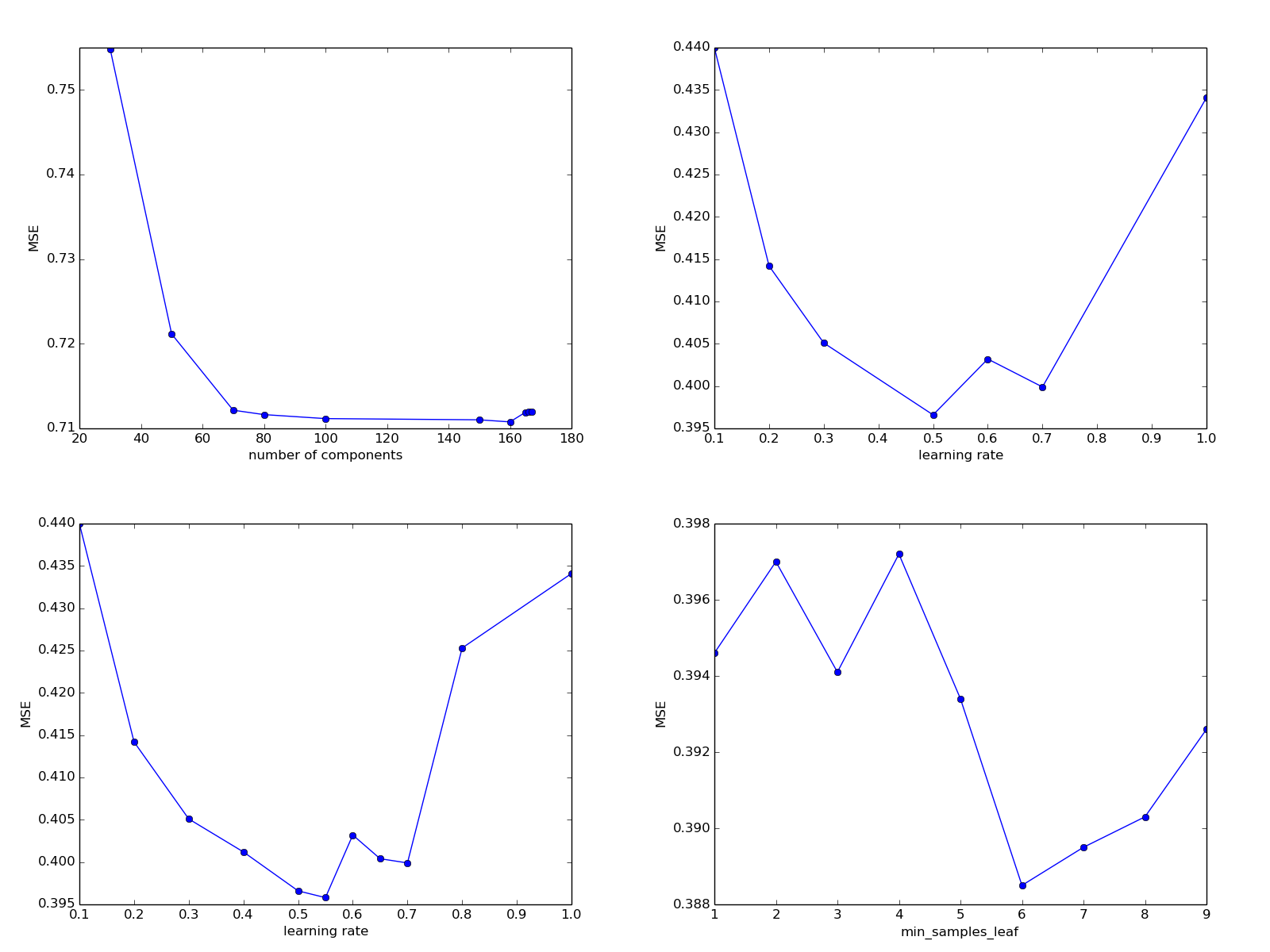

В предыдущей статье цикла мы обсудили постановку задачи анализа данных, сделали первые шаги в настройке модели машинного обучения и написали интерфейс, удобный для использования прикладным программистом. Сегодня мы проведем дальнейшее исследование задачи — поэкспериментируем с новыми фичами, попробуем более сложные модели и варианты их настроечных параметров.

В статье, насколько возможно, используется русскоязычная терминология, выбранная автором на основе буквальных переводов англоязычных терминов и устоявшегося в сообществе сленга. О ней можно почитать здесь.

Читать полностью »

Дайджест интересных материалов для мобильного разработчика #251 (23 апреля — 29 апреля)

2018-04-29 в 14:44, admin, рубрики: App Store, code review, Google Play, kotlin, machine learning, swift, UX, xcode, Блог компании Everyday Tools, интерфейсы, маркетинг мобильных приложений, разработка игр, разработка мобильных приложений, Разработка под android, разработка под iOSВ эти праздники мы входим с материалами про работу игрового техлида, про фичеринг в новом App Store, Мобиусами и Google Play Awards, игровыми движками и лучшими венрсиями себя. Следующий наш выпуск выйдет через две недели. Всем весны!

Как Qlean использует Machine Learning?

2018-04-28 в 12:31, admin, рубрики: assignments, machine learning, ml, qlean, Алгоритмы, бизнес-модели, Блог компании Qlean, градиентный бустинг, задача о назначениях, машинное обучение Каждый день поступает все больше заказов, и их нужно как-то распределять по исполнителям. Вроде ничего сложного: пришёл заказ – отдай его клинеру. Но не всё так просто, как кажется. У наших клинеров нет фиксированного графика работы, они могут работать, когда захотят, отказываться практически от любых заказов (и это клинеры, увы, делают довольно часто). Поэтому распределение заказов – одна из самых сложных задач, над которой мы работаем.

Каждый день поступает все больше заказов, и их нужно как-то распределять по исполнителям. Вроде ничего сложного: пришёл заказ – отдай его клинеру. Но не всё так просто, как кажется. У наших клинеров нет фиксированного графика работы, они могут работать, когда захотят, отказываться практически от любых заказов (и это клинеры, увы, делают довольно часто). Поэтому распределение заказов – одна из самых сложных задач, над которой мы работаем.

Читать полностью »

Mail.Ru Group на пятом московском Data Fest

2018-04-27 в 12:08, admin, рубрики: big data, data fest, data mining, data science, machine learning, mail.ru, mail.ru group, Блог компании Mail.Ru Group, визуализация данных, машинное обучение

Друзья, до самого долгожданного события года в сфере data science остался 1 день! 28 апреля состоится пятый московский Data Fest. Под катом наш рассказ о докладах и активностях Mail.Ru Group на конференции.

Читать полностью »

Splunk 7.1. Что нового? Новый веб интерфейс, интеграция с Apache Kafka и многое другое…

2018-04-27 в 5:13, admin, рубрики: machine learning, splunk, анализ данных, анализ логов, Блог компании TS Solution, кластеризация, логи, машинные данные, метрики, Серверная оптимизация, Серверное администрирование, системное администрированиеНесколько дней назад компания Splunk выпустила новый релиз своей платформы Splunk 7.1 в котором, наверно, произошло самое ожидаемое изменение за последние несколько лет — да, полностью изменился графический интерфейс. В этой статье мы расскажем об основных нововведениях и улучшениях платформы. Что еще нового помимо GUI? Смотрите под кат.

Читать полностью »

Самые страшные ошибки, которые допускают DS. Встреча в офисе Авито 24 апреля

2018-04-20 в 11:22, admin, рубрики: AI Community, data science, machine learning, Блог компании Avito, веб-аналитика, математика, машинное обучение, Учебный процесс в ITПривет! На следующей неделе, в среду, 24 апреля, приглашаем специалистов по Data Science на митап, который мы организуем вместе с AI Community и AI Today. Будем говорить о самых страшных ошибках, которые допускают DS. Подробно обсудим CRISP-DM и Tips&Tricks, которые можно использовать в работе. Вы услышите доклады Ивана Гуза, Игоря Слинько и Станислава Гафарова. Регистрируйтесь на встречу и приглашайте коллег. Под катом — тезисы выступлений, ссылки на регистрацию и видеотрансляцию митапа.

Data Fest 2018: анонс и регистрация

2018-04-19 в 14:19, admin, рубрики: big data, data fest, data mining, data science, machine learning, mail.ru, mail.ru group, Блог компании Mail.Ru Group, визуализация данных, машинное обучение

Друзья, приглашаем вас на пятый московский Data Fest, который состоится 28 апреля на территории дизайн-завода FLACON. Data Fest — крупнейшая бесплатная конференция для исследователей, инженеров и разработчиков, связанных с анализом и обработкой данных, машинным обучением, а также тем, что пресса любит называть AI.

Вы узнаете про AI в продуктах Mail.Ru Group и «умные» ответы в Почте Mail.Ru, как работают рекомендации и компьютерное зрение во ВКонтакте и Одноклассниках, а также машинный перевод в Alibaba и что такое Quantum Machine Learning, а также многое-многое другое!

Читать полностью »

Конференция SMARTRHINO-2018

2018-04-19 в 13:47, admin, рубрики: best practices, kotlin, machine learning, python, Блог компании ИНФОРИОН, машинное обучение, мгту им.баумана, МГТУ имени Баумана, реверс-инжиниринг26 апреля в НОЦ ИБ МГТУ им.Баумана пройдет конференция для студентов SMARTRHINO-2018. Конференция будет посвящена 4 направлениям:

— Kotlin

— Реверс-инжиниринг

— Best Practices

— Machine Learning

Спикеры конференции — ведущие сотрудники Компании ИНФОРИОН. Активные участники получат ценные призы.

Подрорбная информация о спикарах и программе конференции представлена на сайте. Актуальная информация — в группе Telegram.

Пять мифов о Data Science

2018-04-11 в 10:14, admin, рубрики: big data, career, data mining, data science, machine learning, python, Блог компании ID Finance, Карьера в IT-индустрии, машинное обучениеМеня зовут Иван Серов, я работаю в департаменте Data Science финтех-компании ID Finance. Data scientist –довольно молодая, но очень востребованная профессия, которая обросла множеством мифов. В этом посте я расскажу о нескольких заблуждениях, с которыми сталкиваются начинающие дата-саентисты (DS).