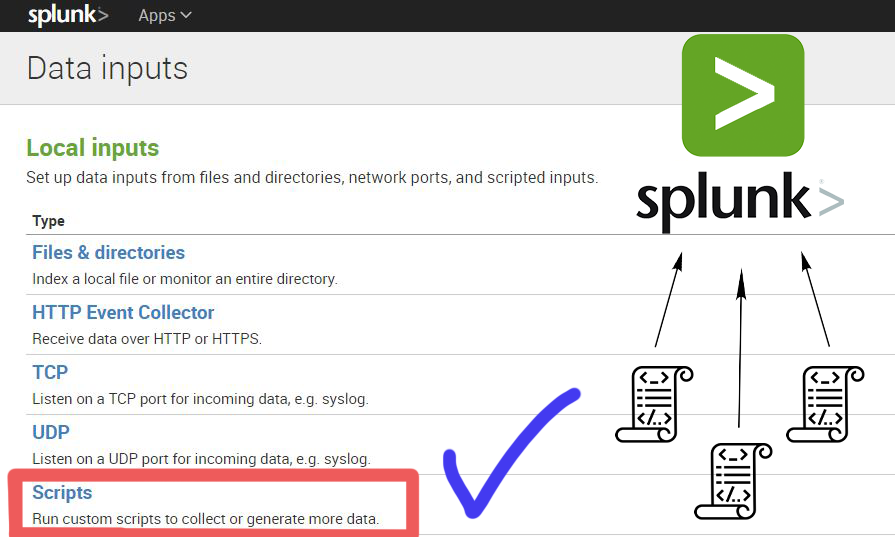

Ранее мы писали, как можно загрузить логи в Splunk из каталога или с помощью syslog, рассказывали как забирать стандартные виндовые и линуксовые события, но что если нам необходимо получать более гранулярную информацию о работе наших систем?

В таком случае на помощь приходят скрипты!

Когда, какие и как можно использовать скрипты в Splunk для получения данных — вы можете узнать под катом.

Читать полностью »