Большой медицинский Machine learning дайджест подготовлен командой телеграм канала Machine Learning Interview.

Модели машинного обучения и бенчмарки

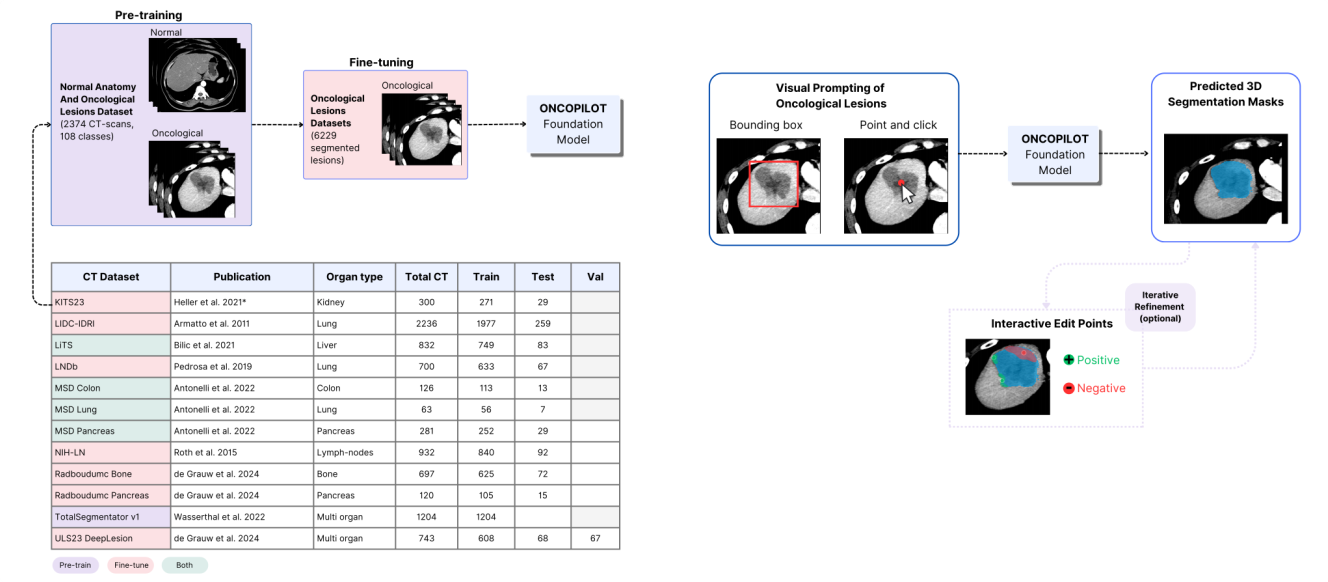

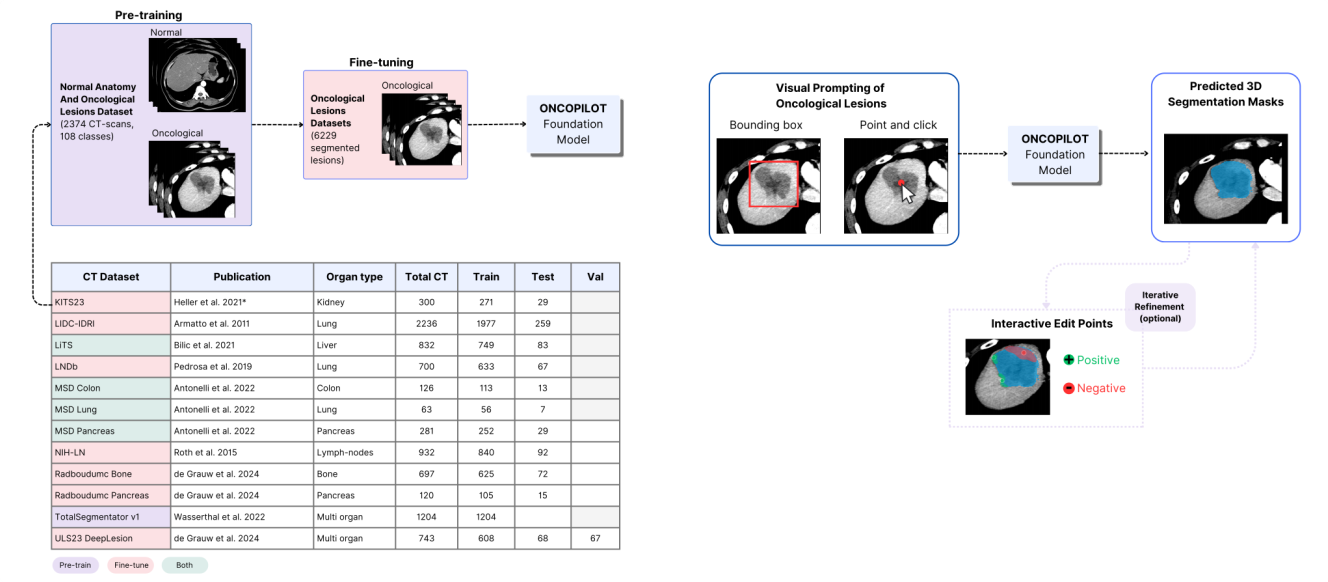

🟩 ONCOPILOT: Интерактивная модель для сегментации опухолей на основе КТ и измерения по RECIST 1.1.

Большой медицинский Machine learning дайджест подготовлен командой телеграм канала Machine Learning Interview.

🟩 ONCOPILOT: Интерактивная модель для сегментации опухолей на основе КТ и измерения по RECIST 1.1.

Когда мы говорим о бенчмаркинге LLM в какой-то предметной области, то имеем в виду две разные концепции: бенчмарки моделей LLM и бенчмарки систем LLM. Бенчмаркинг моделей LLM заключается в сравнении базовых моделей общего назначения (например, GPT, Mistral, Llama, Gemini, Claude и так далее). Нам не следует вкладывать ресурсы в их сравнение, потому что: 1. Для них существуют публикуемые таблицы лидеров, 2. В использовании этих моделей существует множество нюансов (например, изменчивость модели, промт, сценарий использования, качество данных, конфигурация системы), что снижает полезность обсуждения их высокоуровневых параметров, 3. Важнее точности модели могут быть другие факторы: локальность данных, соответствие требованиям защиты конфиденциальности, поставщик облачных услуг, степень возможности кастомизации (например, fine-tuning или повторного обучения).

Что мы должны обсуждать, так это бенчмаркинг систем LLM. Это осмысленный и важный процесс, при котором мы рассматриваем применение конкретных моделей LLM (вместе с промтом и конфигурацией системы) в наших конкретных сценариях использования. Нам следует курировать датасеты из конкретных предметных областей, задействовать в их разметке и людей, и LLM для создания «золотого» датасета, позволяющего оценивать вносимые нами постоянные улучшения. Можно даже рассмотреть возможность публикации «золотых» датасетов бенчмарков.

Читать полностью »

Я работал над созданием инструмента под названием rustsn, который позволяет генерировать, компилировать и тестировать код с использованием LLM (Large Language Models). Изначально идея заключалась в том, чтобы автоматизировать процесс написания небольших фрагментов кода — так называемых сниппетов — для разных языков программирования на основе объяснений, предоставленных пользователем. Этот инструмент стал развиваться и обрастать новыми возможностями, такими как генерация полного кода для приложений и объяснение существующего кода на основе векторных представлений (эмбеддингов).

Когда я только начинал работу над Читать полностью »

Введение

"Мем смешной, ситуация страшная"

Ситуация на меме на самом деле не страшная, но имеет место быть. Большие языковые модели набирают популярность, и компании все чаще смотрят в сторону их использования. Haulmont не стал исключением.

В этой статье я хочу рассказать вам о нашем новом продукте – Читать полностью »

Скорее всего все читатели Хабра слышали про chatGPT и знают как он работает. В этой статье, я повторю GPT и обучу на небольшом датасете, в основном пользуясь материалами из видео Andrej Karpathy. Спасибо за помощь в написании статьи и понимании того, что происходит команде из Школы Высшей Математики - у них одна из самых сильных команд по NLP и LLM с преподавателями из ВШЭ и ШАД.

В своих предыдущих статьях о разработке телеграм-ботов я делился опытом создания базового функционала и работы с командами через аргументы (раз, два). На этапе подготовки третьей статьи передо мной встал вопрос генерации однотипного кода для новых команд, что превратилось в рутинную задачу. Чтобы избежать этого и ускорить процесс, я решил задействовать ChatGPT. К моему удивлению, его помощь оказалась значительно весомее, чем я ожидал.

Привет! Я Сергей, продакт направления AI в Битрикс24. Последний год мы активно внедряем нейросети в наш продукт, и я хочу поделиться опытом, который может сэкономить вам время и деньги.

Оказалось, что выбор правильной модели нейросети — это целое искусство. Размеры контекста, лицензии, поддержка языков, способы доступа — от этих параметров голова идет кругом. Но разобраться в них критически важно, если вы не хотите потратить кучу времени и денег впустую.