Привет, с вами снова ServerFlow. И да, мы потратили 320 тысяч рублей, чтобы проверить, есть ли какой-то толк от Nvlink при развертывания нейросетей? Тесты мы провели на двух видеокартах Nvidia A5000 24GB, сначала объединённые NVLink, а после без него. Для наглядности теста нами была выбрана последняя языковая модель LLaMA 3.2 на 90 миллиардов параметров. Что у нас в итоге вышло – сможете узнать ниже в посте.

Рубрика «llama» - 3

Мы потратили 320 тысяч рублей ради Nvlink для нейросетей. Но был ли в этом смысл?

2024-11-25 в 10:53, admin, рубрики: A5000, llama, Nvidia, NVLink, ServerFlow, Видеокарты, ИИ, искуственный интеллект, машинное обучение, Серверное администрированиеРубрика: VPS на пределе возможностей. LLM на CPU с 12Gb RAM

2024-11-12 в 9:01, admin, рубрики: llama, Ollama, ruvds_статьи, vps, ИИ, искуственный интеллект, машинное обучение, нейронные сети, облако, сервер

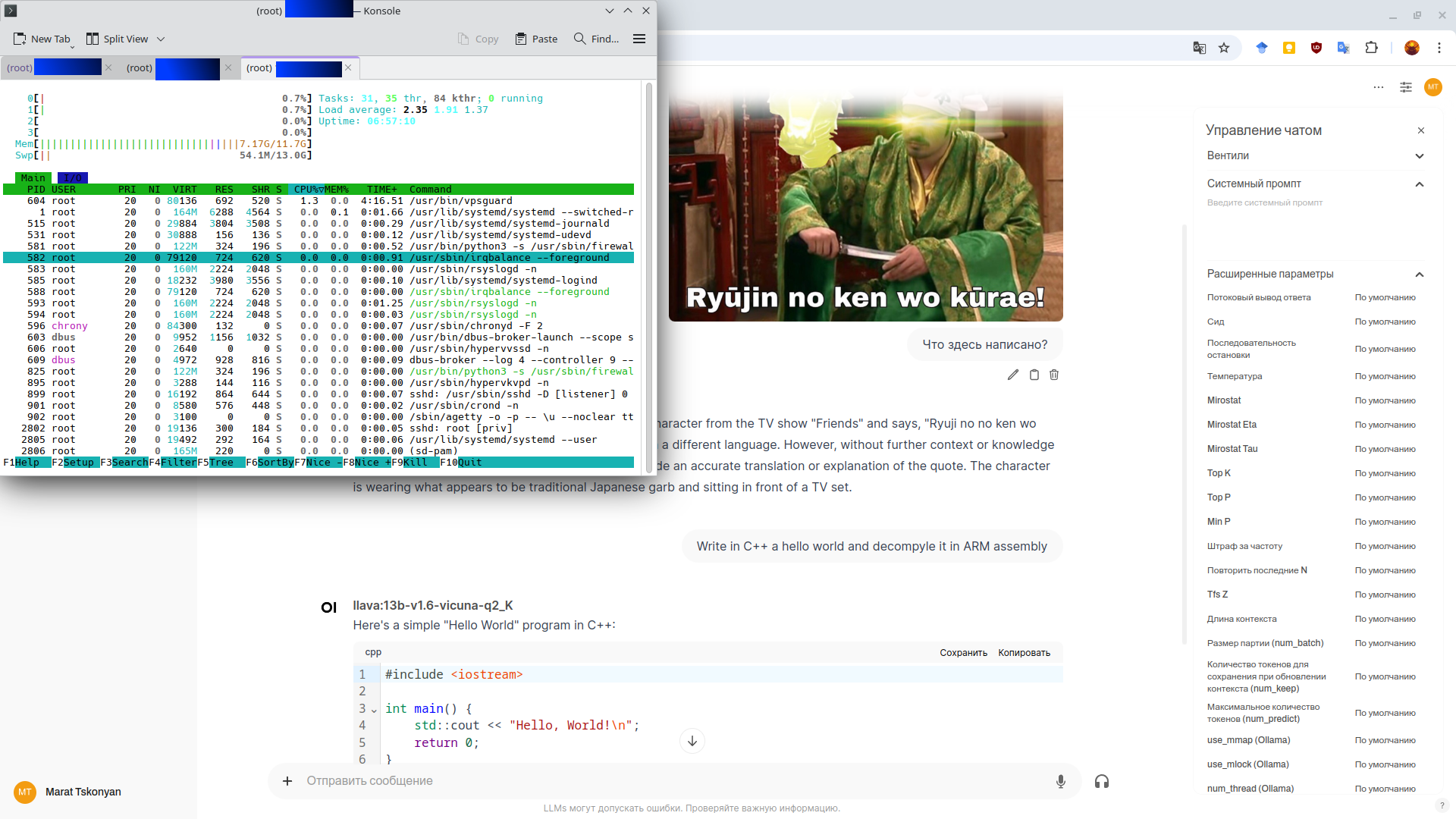

По работе я привык, что если какая-то нейронка не влезает на GPU-сервер, то первое моё действие — проверить, нет ли модели с квантизацией побольше, либо запросить ещё больше VRAM. Однако не все работают на облачных провайдерах, кто-то у нас ещё и заказывает услуги. А тарифы на GPU-серверы порой заставляют серьёзно задуматься о том, так ли они нужны, особенно когда нет потребности в нейронках на сотни миллиардов параметров. Что, если попробовать делать всё на обычном VPS-тарифе с бюджетом в 5000 рублей в месяц? Да и зачем ограничиваться одними лишь нейронками?

Квантизация позволяет запускать Llama 3.2 на мобилках

2024-11-05 в 13:27, admin, рубрики: generative models, llama, llama 3.2, qlora, генеративные модели, нейронные сетиКвантизация помогла портировать последнюю версию LLM Llama 3.2 на мобильные платформы - iOS и Android. Для этого разработчики выпустили квантованные версии Llama 3.2 1B и 3B, которые при тестах на ARM-процессорах показали высокую скорость инференса, по сравнению с несжатыми весами в формате BF16.

Как вообще получилось, что Llama работает на мобильных процессорах, ведь для ее запуска нужен определенный программный стек, чаще всего библиотека Pytorch и CUDA на операционной системе Linux?

Дело в том, что Meta* (признана в России экстремистской организацией) используют ExecuTorchЧитать полностью »

DE-1. DIY ассистент на LLM

2024-10-26 в 17:11, admin, рубрики: AI, assistant, llama, llm, python, WhisperOpenAI o1 — LLM, обученная выполнять сложные логические рассуждения

2024-10-01 в 11:34, admin, рубрики: data engineering, llama, llm, mlops, nlp, reinforcement learning, большие языковые модели, квантизация, машинное обучение, нейронные сетиOpenAI изменили направление развития своих языковых моделей, от просто генерации текста их последняя модель перешла к решению задач с использованием логики и пошагового анализа проблемы.

До сих пор LLM генерировали текст на основе данных, использованных в процессе обучения. Веса модели хранят представление о зависимостях между текстовыми токенами, полученное из исходного корпуса данных. Соответственно, модель просто генерирует наиболее вероятные токены "по памяти", но не выполняет с их помощью никакой по-настоящему интеллектуальной работы.

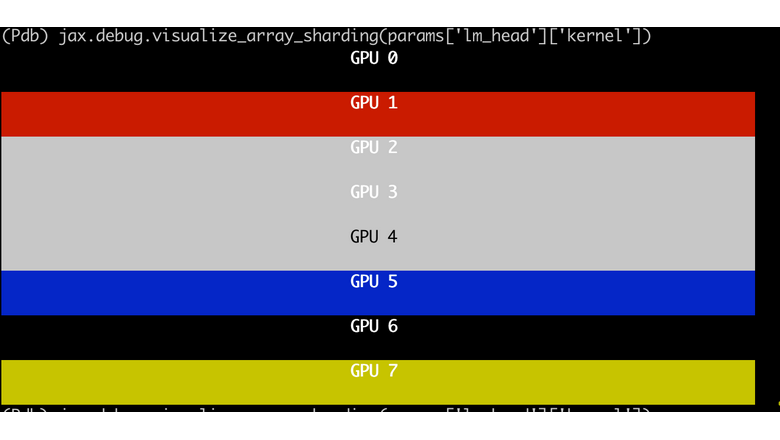

Опыт тюнинга Llama3 405B на AMD MI300x

2024-09-24 в 16:09, admin, рубрики: amd, jax, llama, Nvidia, pytorch, обучение моделей

Введение

Опенсорсные модели становятся всё объёмнее, поэтому потребность в надёжной инфраструктуре для выполнения крупномасштабного обучения ИИ сегодня как никогда высока. Недавно наша компания выполнила fine-tuning модели LLaMA 3.1 405B на GPU AMD, доказав их способность эффективно справляться с крупномасштабными задачами ИИ. Наш опыт был крайне положительным, и мы с радостью выложили всю свою работу на Читать полностью »

Шлепа — Большой Русский Бенчмарк

2024-09-02 в 7:00, admin, рубрики: llama, llm, mistral, бенчмаркинг

Здарова! На связе лаборатория Вихрей, сегодня мы расскажем про наш бенчмарк, Шлёпа — большой русский бенчмарк.

Что есть сейчас для оценки русскоязычных LLM

Mera — бенчмарк от Альянса искусственного интеллекта, использует тесты и генерацию, сабмит через сайт, сайт почти не обновлялся с зимы. Почитать про него можно тут

Простой способ развернуть локальный LLM

2024-08-28 в 19:57, admin, рубрики: anythingllm, llama, localaiДообучаем Llama 3.1 у себя дома

2024-08-28 в 7:07, admin, рубрики: huggingface, llama, llama3.1, supervised fine-tuning, weights & biasesПривет, чемпионы! С каждым днем появляется все больше и больше LLM, их показатели растут с таким же темпом. Но в определенных областях они до сих пор не слишком хороши, так как на этапе предобучения не выгодно охватывать узкие домены - легче модели скормить общие данные, а потом дообучить.

Секунду, слишком много терминов на один пиксель: что такое предобучение и "дообучение"? Практически все современные "чатовые" модели выпускаются не до конца обученные, чтобы в случае неудовлетворенности пользователя результатам генерации, он смог дообучить под свои данные.

ДообучениеЧитать полностью »