Системы искусственного интеллекта (ИИ) получают всё большее распространение. В связи с этим юристы и законодатели обсуждают проблему, каким образом должны регулироваться такие системы, кто будет нести ответственность за их действия. Этот вопрос требует внимательного изучения и взвешенного подхода, потому что системы ИИ способны генерировать огромные массивы данных и применяться в приложениях разной функциональности — от медицинских систем и автопилотов в автомобилях до предсказания преступлений и вычисления потенциальных преступников. При этом учёные стремятся к созданию «сильного ИИ», способного к рассуждениям, и здесь возникает вопрос, как определить наличие умысла в его действиях — или признать действия неумышленными.

Системы искусственного интеллекта (ИИ) получают всё большее распространение. В связи с этим юристы и законодатели обсуждают проблему, каким образом должны регулироваться такие системы, кто будет нести ответственность за их действия. Этот вопрос требует внимательного изучения и взвешенного подхода, потому что системы ИИ способны генерировать огромные массивы данных и применяться в приложениях разной функциональности — от медицинских систем и автопилотов в автомобилях до предсказания преступлений и вычисления потенциальных преступников. При этом учёные стремятся к созданию «сильного ИИ», способного к рассуждениям, и здесь возникает вопрос, как определить наличие умысла в его действиях — или признать действия неумышленными.

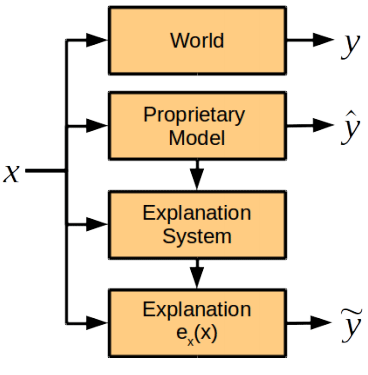

Есть много способов привлечь к отчётности и ответственности систему ИИ, на эту тему опубликовано несколько исследований. В новой научной работе специалисты по компьютерным наукам, когнитивным наукам и юристов из Гарвардского и Кембриджского университетов (США) обсуждают одну составляющую будущей системы подотчётности ИИ, а именно — роль объяснительной записки от ИИ, то есть оценку того, как система искусственного интеллекта объясняет свои действия. Учёные пришли к выводу, что модуль объяснения действий должен быть отделён от общей системы ИИ.

Читать полностью »