Новейшие системы ИИ начинают обучение, ничего не зная об игре, и вырастают до мирового уровня за несколько часов. Но исследователи с трудом справляются с применением таких систем за пределами игрового мира

До недавнего времени машины, способные посрамить людей-чемпионов, хотя бы имели уважение использовать человеческий опыт для обучения играм.

Чтобы выиграть у Гарри Каспарова в шахматы в 1997 году, инженеры IBM воспользовались столетиями шахматной мудрости при создании своего компьютера Deep Blue. В 2016 программа AlphaGo проекта Google DeepMind разгромила чемпиона Ли Седоля в древней настольной игре го, обработав миллионы игровых позиций, собранные с десятков тысяч партий между людьми.

Но сейчас исследователи ИИ переосмысливают то, как их боты должны впитывать человеческое знание. Текущую тенденцию можно описать как «да и бог с ним».

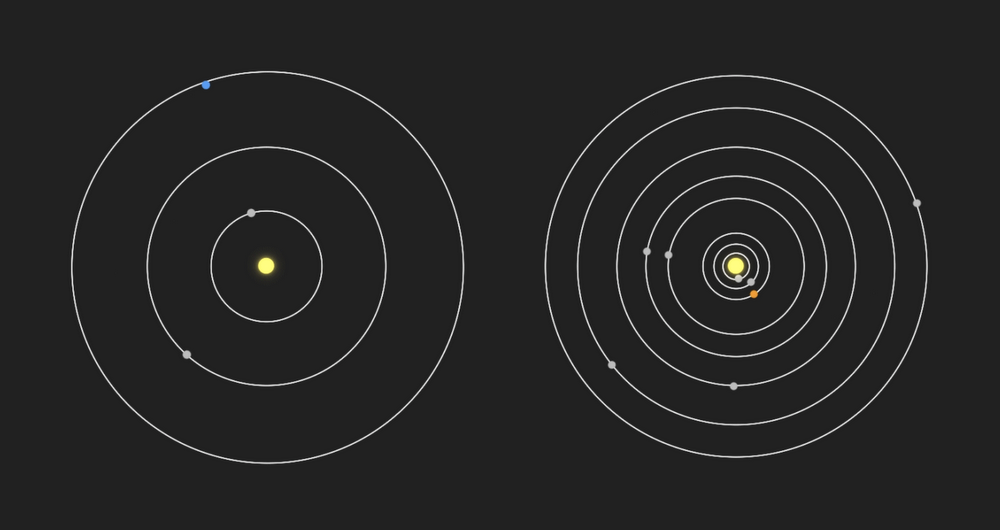

В прошлом октябре команда DeepMind опубликовала подробности новой системы игры в го, AlphaGo Zero, вообще не изучавшей игры людей. Она начала с правил игры и играла сама с собой. Первые ходы были совершенно случайными. После каждой игры она принимала новые знания о том, что привело к победе, а что – нет. После этих матчей AlphaGo Zero стравили с уже сверхчеловеческой версией AlphaGo, победившей Ли Седоля. Первая выиграла у второй со счётом 100:0.

Читать полностью »