Рубрика «huggingface»

Накорми языковую модель документами

2025-04-19 в 11:20, admin, рубрики: Fine-tuning, huggingface, llm, llm-модели, natural language processing, nlp, rag, большие языковые модели, искусственный интеллект, нейросетиFine tuning роя агентов

2025-04-04 в 17:55, admin, рубрики: dataset, Fine-tuning, huggingface, javascript, llm, OpenAI, python, TypeScript, yandexgptИсходный код, разобранный в статье, опубликован в этом репозитории

В вакансиях LLM инженеров присутствует слово RAG. Это подразумевает интеграцию во внешнюю базу данных, например, PostgreSQL с PGVector или MongoDB Atlas Vector Search.

Открываем instruct-версию YandexGPT 5 Lite

2025-03-31 в 5:04, admin, рубрики: huggingface, machine learning, nlp, open source, yandexgpt, яндекс

Недавно мы выложили в открытый доступ pretrain-версию модели YandexGPT 5 Lite, обученную нами с помощью технологий Яндекса и без применения каких-либо сторонних моделей. За прошедший месяц в сообществе её скачали более 15 тысяч раз, на её основе создали больше десятка квантизованных моделей и даже дообучили instruct-версии.

Делаем свой reasoning dataset

2025-03-29 в 17:20, admin, рубрики: dataset, gpt, huggingface, llm, нейросетиПривет!

Туториал будет посвящен подготовке узкоспециализированного русскоязычного медицинского датасета для последующего файнтюнинга (тонкой настройки) открытых языковых моделей.

Описанная методика выверена методом многочисленных проб и ошибок. Русификация тут приведена больше как пример того, как при помощи сырого набора данных, можно сгенерировать качественные данные под узкую задачу с минимальными затратами.

В данном туториале описан процесс создания русского медицинского датасета из англоязычногоЧитать полностью »

На сколько Ollama готова для Production?

2025-03-23 в 18:53, admin, рубрики: gguf, gpt, huggingface, javascript, llama, llm, Ollama, python, TypeScript, yandexgptНекоторое время назад я был в восторге от Ollama: простое скачивание моделей одной консольной командой, наличие SDK для NodeJS и Python, OpenAI-подобное API. Однако, так как отрасль рынка активно развивается, инструмент с каждым днем становится менее конкурентноспособным

Проблемы Ollama

Пункты ниже заставят вас задуматься рассмотреть другой инструмент запуска GGUF, например: LMStudio, LocalAI, KoboldCPP, vLLM или llama-server

-

Модели-шизофреники c тысячами загрузок

Дообучаем Llama 3.1 у себя дома

2024-08-28 в 7:07, admin, рубрики: huggingface, llama, llama3.1, supervised fine-tuning, weights & biasesПривет, чемпионы! С каждым днем появляется все больше и больше LLM, их показатели растут с таким же темпом. Но в определенных областях они до сих пор не слишком хороши, так как на этапе предобучения не выгодно охватывать узкие домены - легче модели скормить общие данные, а потом дообучить.

Секунду, слишком много терминов на один пиксель: что такое предобучение и "дообучение"? Практически все современные "чатовые" модели выпускаются не до конца обученные, чтобы в случае неудовлетворенности пользователя результатам генерации, он смог дообучить под свои данные.

ДообучениеЧитать полностью »

Установка LLM на скромном VPS

2024-07-24 в 9:00, admin, рубрики: Chat Arena, CopilotKit, Cosmopolitan Libc, huggingface, LibreChat, llama.cpp, llamafile, llm, Ollama, OpenCompass, ruvds_статьи, Tabby, vps, языковые модели

«Я тебя завалю, если ещё раз упомянешь AI», — писал автор нашумевшей статьи. В самом деле, хайп вокруг ИИ всем надоел. Но мы всё-таки рискнём поговорить о том, какую LLM поставить на своём сервере и зачем.

Сразу упомянем, что на серверах RUVDS установлены видеокарты NVIDIA Quadro P4000 (на фото). Карты довольно слабенькие, так что подойдут скорее для проектов в образовательных целях и т. д. Тем более что под VPS выделяется максимум 1 ГБ видеопамяти. Но даже в таких спартанских условиях можно запустить LLM.

Кстати, о VPS с видеокартой. Несколько лет назад мы уже писали о сферах их применения и даже проводили тесты. Всё это можно найти здесь.Читать полностью »

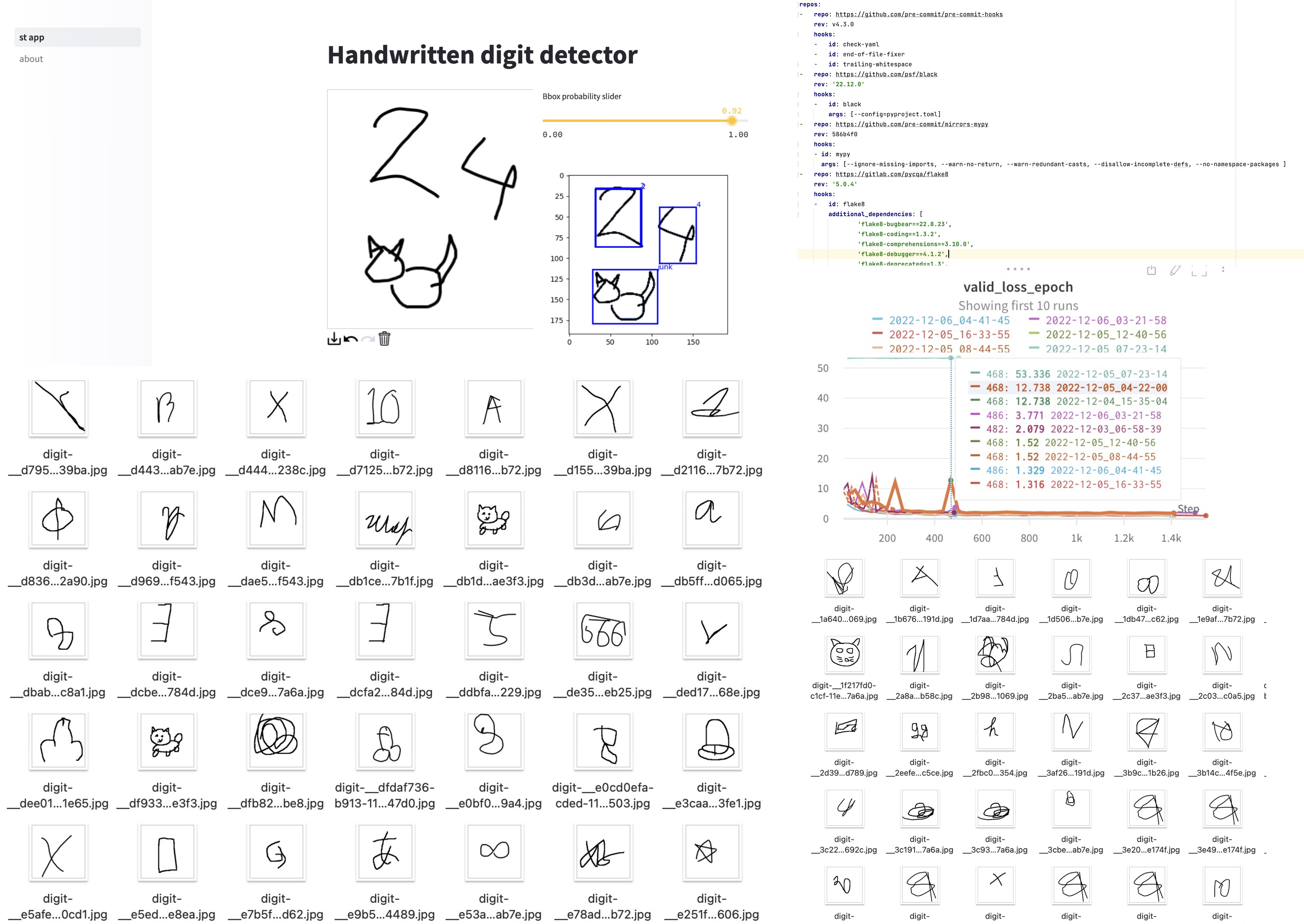

Третья жизнь пет-проекта по распознаванию рукописных цифр

2022-12-23 в 11:23, admin, рубрики: dataScience, detection, huggingface, machinelearning, open source, pet, streamlit, yolo, Блог компании Open Data Science, искусственный интеллект, машинное обучение, обработка изображений

В этом блогпосте я поделюсь историей о том, как я обновлял свой старенький пет-проект по распознаванию цифр, как делал разметку для него, и почему модель предсказывает 12 классов, хотя цифр всего 10.

Вступление

Шерудим под капотом Stable Diffusion

2022-09-14 в 14:11, admin, рубрики: CLIP, dalle, dalle-2, huggingface, natural language processing, OpenAI, stable diffusion, stablediffusion, unet, VAE, искусственный интеллект, машинное обучение, обработка изображенийВероятно вы уже слышали про успехи нейросетей в генерации картинок по текстовому описанию.

Я решил разобраться, и заодно сделать небольшой туториал, по архитектуре Stable Diffusion. Сегодня мы не будем глубоко погружаться в математику и процесс тренировки. Вместо этого сфокусируемся на применении и устройстве основных компонент: UNet, VAE, CLIP.

Telegram бот с языковой моделью, обученной на 2ch

2022-06-11 в 21:52, admin, рубрики: 2ch, data mining, dataset, huggingface, natural language processing, nlp, python, pytorch, telegram, telegrambot, машинное обучениеЕсли вам хочется разбавить общение в telegram чате нелепыми, но зачастую меткими и смешными комментариями, или вы ищете информацию по интеграции языковой модели в бота, или хотите сами обучить языковые модели на данных с 2ch, то в этой статье описаны шаги, как это сделать.

Бот

Запустил бота, которого можно добавлять в чаты, и он будет отвечать на сообщения, как на посты на 2ch.hk/b/.

Для этого:

-

Был собран датасет постов с 2ch

-

Была обучена Читать полностью »