Последних лет двадцать дата-центры появляются как грибы после дождя, оно и понятно. Кроме количественных показателей развиваются и качественные — новые формы, новые подходы к построению среды. Одним из таких новшеств стали модульные ЦОДы. Эффективность решений на базе стандартизированного контейнера впервые смогли оценить военные, именно они стали пионерами в использовании дата-центров построенных по модульному принципу. Быстрое разворачивание вычислительных мощностей и возможность хранения данных в самых отдаленных уголках Земли стали для военных панацеей в мире с ежедневно нарастающим объемом генерируемой информации. Благодаря компании Sun Microsystems, уже в 2006 году модульные дата-центры стали доступными и для гражданских потребителей. Но казалось бы, кто их будет приобретать? В условиях жестокой борьбы участников ИТ-рынка за высокую производительность «железа» плюсы от модульности ЦОДов, в большинстве случаев гражданской жизни, нещадно перечеркиваются целым спектром минусов порождаемых этой самой модульностью. Но как показало время — не все так однозначно в этой теме и продукт нашел своего потребителя. Одним из таких потребителей, как бы это не было удивительно, стал CERN. Детище организации — большой адронный коллайдер, обрастет парой новых модульных дата-центров. Весьма странное решение? Об этом и не только пойдет далее речь.

Рубрика «хранение данных» - 38

Модульный ЦОД на службе у большого адронного коллайдера

2019-01-15 в 11:04, admin, рубрики: ua-hosting.company, Блог компании ua-hosting.company, большой адронный коллайдер, дата-центр, сервер, Сетевое оборудование, хранение данных, хранилища данных, ЦЕРНMicrosoft платит за ваше безлимитное облачное хранилище

2019-01-12 в 17:47, admin, рубрики: api, cloud services, cloud storage, file api, file upload, github, облачные сервисы, хранение данных, хранилища данныхПоявилась возможность превратить ваш GitHub аккаунт в Безлимитное Облачное Хранилище Данных. И это вовсе не миф.

Согласно с информацией, данной GitHub, каждый пользователь может создать бесконечное количество публичных и приватных репозиториев. Мы можем загружать до 1000 Мб в один репозиторий и каждый из файлов не должен превышать размера в 100 Мб. Тут попахивает возможностью создать бесплатное и безлимитное облачное хранилище, не так ли?

Я осознаю что на сегодняшний день уже существует множество вариантов хранения данных в облаке и такие лидирующие компании, как Dropbox, Google Drive или даже Amazon S3 предоставляют свои услуги по очень низким ценам, не уступая при этом и качеством. Но решение, основанное на GitHub CDN может быть крайне полезно если вам нужно максимально быстро и просто загрузить файлы в облако, и в то же время не беспокоится о надежности и доступности ваших валов в любое время. Даже через десятки лет.

Читать полностью »

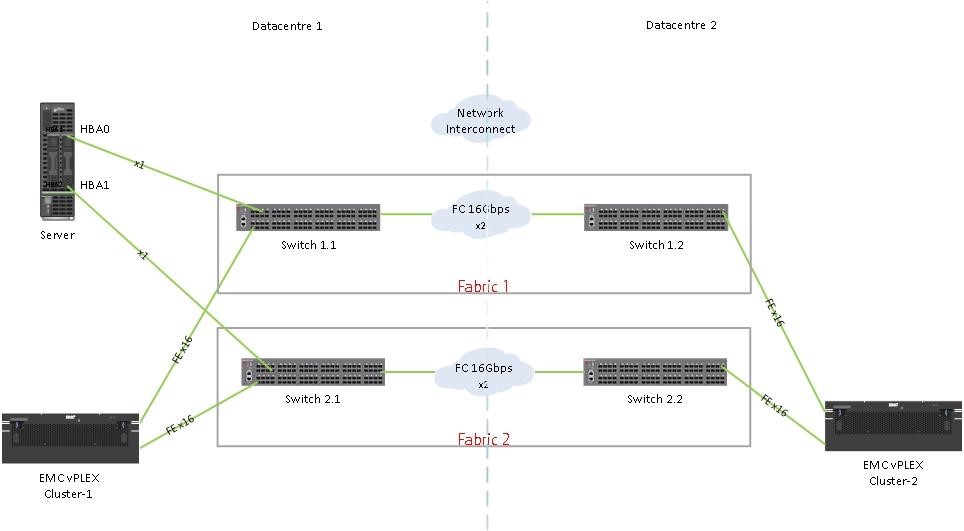

Как Peer Zoning упростил нам жизнь и помог сбалансировать нагрузку EMC VPLEX

2019-01-10 в 12:56, admin, рубрики: member, peer zoning, principal, SAN, ViPR SRM, vplex, VPLEX directors, VPLEX front-end ports, Блог компании ICL Services, Сетевые технологии, системное администрирование, хранение данныхВ нашей storage-инфраструктуре было две проблемы. Во-первых, это 960 «Single initiator — Single target» зон на SAN, что усложняло администрирование SAN-сети. А во-вторых, несбалансированная нагрузка на директорах EMC VPLEX. Благодаря внедрению Peer zoning мы уменьшили количество зон в 120 раз, вдвое сэкономили время инженеров и получили более-менее равномерную загрузку директоров EMC VPLEX. Далее расскажу, как мы это сделали.

В инфраструктуре заказчика:

- по одному EMC VPLEX в каждом дата-центре в конфигурации Metro;

- суммарно 120 серверов, подключенных к ним;

- две SAN-фабрики, в каждой из которых по два SAN-свитча Brocade.

На схеме это выглядит так:

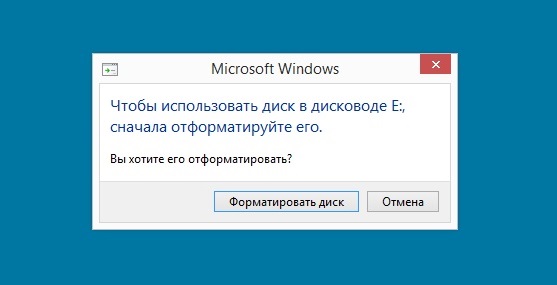

Восстановление данных из пустого места

2019-01-06 в 6:37, admin, рубрики: Windows предлагает отформатировать, Восстановление данных, восстановление данных с флешки, Накопители, хранение данных

В новогодние каникулы появилась возможность написать об интересном случае (хотя подобных кейсов у нас в DATALABS не мало). А интересен он тем, что из полностью обнулённой USB флешки, мы удачно восстановили данные. Если интересно как? Добро пожаловать под кат…

Читать полностью »

Персональное облако

2019-01-05 в 11:14, admin, рубрики: cloud, collabora, diy или сделай сам, libreoffice, NAS, nextcloud, office, onlyoffice, owncloud, pydio, seafile, storage, облако, облачное хранилище, облачные сервисы, персональное облако, Социальные сети и сообщества, хранение данных, хранилища данных

Облачное хранилище позволяет не только хранить данные, но и обеспечивать совместную работу с ними в NAS.

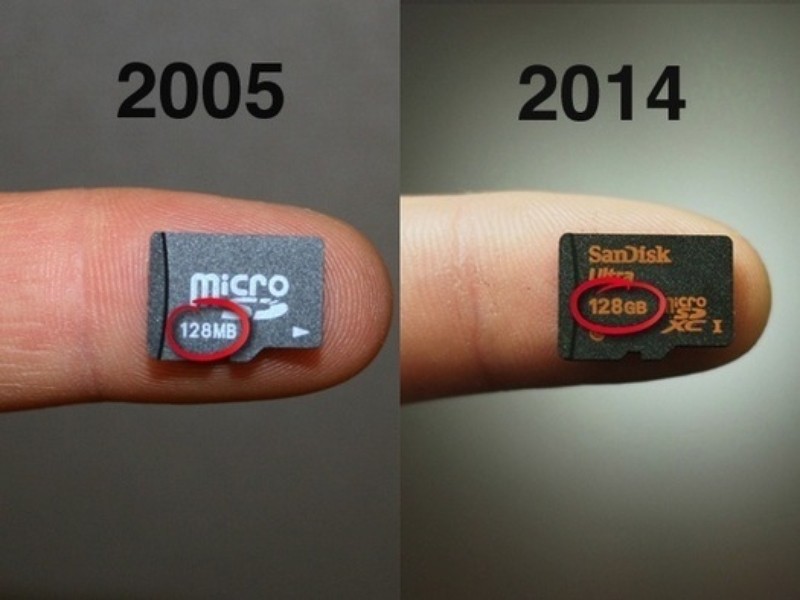

Кажется, памяти устройств, наконец, стало действительно хватать всем

2019-01-03 в 18:43, admin, рубрики: как я к хорошему быстро привык, Накопители, проблемы белых людей, хранение данныхПочти новогодним подарком стало обнаружить на борту моего компактного «походного» ноута хранилище на полтерабайта, когда я думал, что там 256 ГБ максимум; впрочем, «потерявшиеся» 256 гигов тут же обнаружились на большом «стационарном» ноуте, который выглядел на все 512. Разумеется, я принимал во внимание ёмкость накопителей при покупке каждого из них — но после, очевидно, поводов о ней вспоминать больше не было. Вот и забыл — как, кстати, не вспомню вместимость своего нынешнего телефона и его предшественника — вроде бы, 256 и 128. А может, 256 и 64 — уточнять количество гигабайт стало так же неинтересно, как миллиметры, граммы или мегапиксели (ещё один забытый фетиш).

Я помню, как это было важно раньше. Читать полностью »

In-memory базы данных: применение, масштабирование и важные дополнения

2018-12-28 в 14:27, admin, рубрики: in-memory, Администрирование баз данных, базы данных, Блог компании Промсвязьбанк, Промсвязьбанк, хранение данныхМы продолжаем экспериментировать с форматами проведения митапов. Недавно на боксерском ринге мы сталкивали централизованную шину данных и Service Mesh. В этот раз решили попробовать нечто более миролюбивое — StandUp, то бишь открытый микрофон. Темой выбрали in-memory базы данных.

В каких случаях стоит переходить на in-memory? Как и зачем масштабировать? И на что стоит обратить внимание? Ответы в выступлениях спикеров, которые мы осветим в этом посте.

Читать полностью »

FreeBSD планирует перейти на ZFSonLinux

2018-12-28 в 11:31, admin, рубрики: Delphix, OpenZFS, storage, zfs, zfsonlinux, Настройка Linux, Серверное администрирование, хранение данных, хранилища данныхНа прошлой неделе один из разработчиков FreeBSD Matt Macy выдвинул предложение об использовании реализации ZFS от проекта ZFSonLinux. Таким образом все требуемые изменения для FreeBSD будут сразу интегрированы в кодовую базу ZFSonLinux. Предложением это не завершилось, уже создан форк, в котором производятся требуемые доработки, а также получено одобрение core разработчиков ZFSonLinux на включение доработок для FreeBSD в единую кодовую базу.

Положительная ли это новость? Конечно же да! Суть в концентрации всех причастных к проекту OpenZFS разработчиков в одном месте, в одной кодовой базе.

Как я нашёл баг в GNU Tar

2018-12-27 в 19:47, admin, рубрики: tar, Ubuntu, архивирование данных, отладка, системное администрирование, Софт, хранение данныхАвтор статьи — Крис Зибенманн, системный администратор Unix в университете Торонто

Время от времени в моей работе происходит нечто странное, что заставляет задуматься, даже если сразу непонятно, какие следуют выводы. Недавно я упомянул, что мы нашли ошибку в GNU Tar, и история о том, как это произошло, — один из таких случаев.

Для бэкапа файл-серверов мы используем Amanda и GNU Tar. В течение долгого времени у нас периодически возникала довольно редкая проблема, когда tar сходил с ума при резервном копировании файловой системы с каталогом /var/mail, производя огромное количество выходных данных. Обычно этот процесс уходил в бесконечность и приходилось убивать дамп; в других случаях он всё-таки завершался, выдав терабайт(ы) данных, которые вроде бы отлично сжимались. Когда мне в очередной раз попался такой гигантский файл tar, я подверг его проверке — и выяснил, что он частично состоит из нулевых байтов, которые очень не нравятся команде тестирования tar -t, после чего всё возвращается в норму.

(Из-за этого мне стало интересно, появляются ли нулевые байты естественным образом у людей в почтовых ящиках. Оказалось, что поиск нулевых байтов в текстовых файлах не такой простой, и да, они там есть).

Читать полностью »

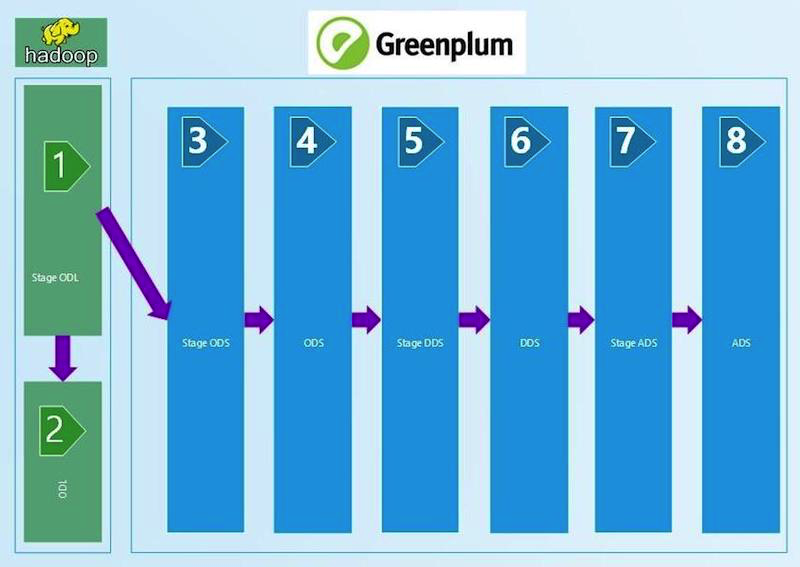

Автоматизация качества данных корпоративного хранилища

2018-12-27 в 13:24, admin, рубрики: oracle, sql, Администрирование баз данных, Блог компании Ростелеком, качество данных (Data Quality), Ростелеком, хранение данныхВ «Ростелекоме», как и в любой крупной компании, имеется корпоративное хранилище данных (ЦХД). Наше ЦХД постоянно разрастается и расширяется, мы строим на нем полезные витрины, отчеты и кубы данных. В какой-то момент мы столкнулись с тем, что некачественные данные мешают нам при построении витрин, получаемые агрегаты не сходятся с агрегатами систем источников и вызывают непонимание бизнеса. Например, данные с Null значениями в внешних ключах (foreign key) не соединяются с данными других таблиц.

Мы понимали, что для обеспечения уверенности в качестве данных нам нужен регулярный процесс сверок. Конечно, автоматизированный и позволяющий каждому из технологических уровней быть уверенным в качестве данных и их сходимости, как по вертикали, так и по горизонтали. В итоге мы параллельно рассмотрели три готовые платформы для управления сверками от различных вендоров и написали свою собственную. Делимся опытом в этом посте.

Читать полностью »