(с)

Путешественники-утописты предрекали, что концепция дома как места, куда хочется возвращаться снова и снова, исчезнет. Дом станет чем-то вроде долговременного склада для хранения вещей, в то время как мы будем находиться в любой точке мира, где есть интернет.

Однако сейчас, при вынужденном переходе на карантин, дом для многих стал единственной отдушиной, дающей силы и снимающей психологическое напряжение. А для тех, кто изначально сделал ставку на домашнюю автоматизацию, нынешние трудные времена воспринимаются как своеобразный экзамен на прочность концепции «цифровой крепости».

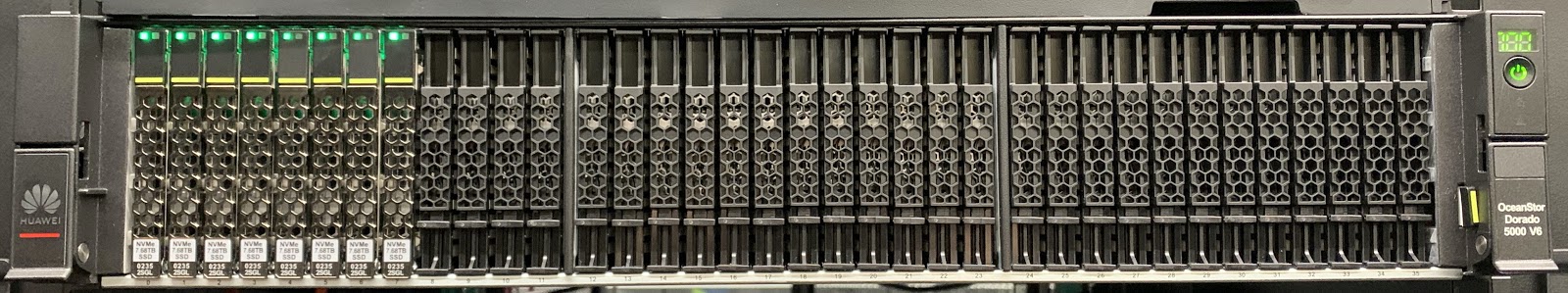

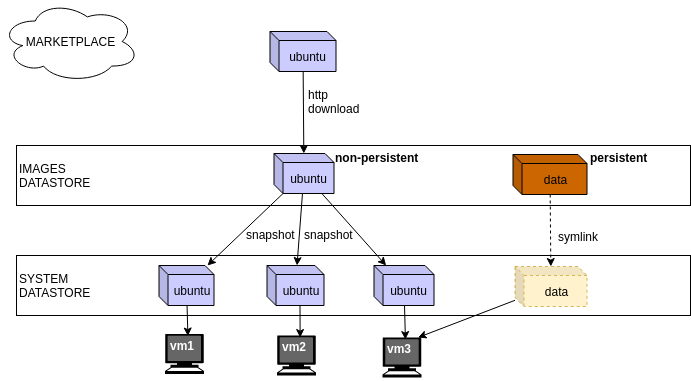

Умный дом — не просто пространство, в котором вы можете управлять шторами, холодильником, лампочками и др. Настоящий умный дом, использующий IoT и достижения Data Science, становится генератором ценных данных, которые напрямую влияют на качество жизни и поведение человека.

Сегодня мы расскажем о влиянии данных IoT на формирование привычек и моделей поведения.

Читать полностью »