В данном примере мы разберем создание и выполнение типового задания MapReduce в облачной реализации Hadoop от Microsoft, которая носит название HDInsight.

В предыдущем примере мы создали 3-узловой кластер Hadoop и загрузили абстрактный журнал слабоструктурированного формата, который сейчас предстоит обработать. Журнал представляет собой в общем случае большой (в нашем конкретном примере маленький, но на принципиальную демонстрацию идеи это не влияет) текстовый файл, содержащий строки с признаками TRACE, DEBUG, INFO, WARN, ERROR, FATAL. Наша элементарная задача будет состоять в том, чтобы подсчитать количество строк с каждым признаком, т.е. сколько раз возникала ситуация WARN, сколько ERROR и т.д.

Читать полностью »

Рубрика «Hadoop» - 11

MapReduce для обработки слабоструктурированных данных в HDInsight

2013-03-18 в 4:18, admin, рубрики: azure, Hadoop, Блог компании Microsoft, метки: azure, HadoopДата-майнинг для информационной безопасности

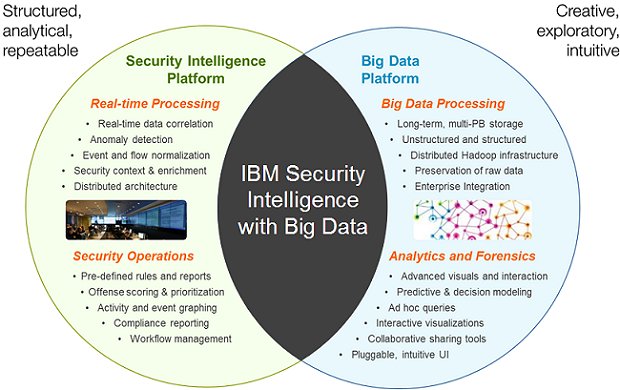

2013-02-02 в 7:07, admin, рубрики: data mining, Hadoop, анализ информации, Блог компании IBM, дата-майнинг, информационная безопасность, метки: Hadoop, анализ информации, дата-майнинг

На Хабре много писали о суперкомпьютере IBM Watson с зачатками искусственного интеллекта. Предполагается, что такая машина должна служить людям: помогать ставить диагнозы и решать другие сложные проблемы путём анализа массивов структурированных и неструктурированных данных. Но можно ли систему дата-майнинга приспособить для нужд информационной безопасности компании?

Читать полностью »

Big Data – почему это так модно?

2012-12-06 в 7:40, admin, рубрики: big data, Hadoop, MapReduce, Большие данные, большие объемы данных, Песочница, СУБД, хранилища данных, метки: big data, Hadoop, MapReduce, Большие данные, большие объемы данных, СУБД, хранилища данныхТехнологии Big Data сегодня очень популярны, о чем говорит хотя бы то, что на текущий момент это наиболее часто встречающийся термин в IT-публикациях. Достаточно посмотреть на статистику таких известных поисковых систем, как Google или Yandex по словосочетанию «Big Data», и становится понятным, что так называемые «Большие Данные» действительно сейчас можно назвать одним из самых востребованных и интересных направлений развития информационных технологий.

Так в чем же секрет популярности этих технологий и что означает термин «Big Data»? Читать полностью »

Хотел с Вами посоветоваться. Нужна ли книга по Hadoop?

На Амазоне эта книга привлекла мое внимание, но нет ясности: надо ли издавать её на русском языке?

Cистема рекомендаций в облаке с помощью Hadoop и Apache Mahout

2012-08-28 в 10:34, admin, рубрики: Apache, apache mahout, Hadoop, machine learning, open source, windows azure, Блог компании Microsoft, Облачные вычисления, облачные сервисы

Apache Mahout™ — это библиотека машинного обучения, созданная для использования в масштабируемых приложениях машинного обучения. Системы рекомендаций — это наиболее узнаваемые приложения машинного обучения, используемые в настоящее время. При выполнении заданий этого руководства мы будем использовать интернет-архив Million Song Dataset, чтобы создать рекомендации по выбору песен для пользователей с учетом их музыкальных предпочтений.

О чем пойдет речь в данном руководстве:

- Как использовать систему рекомендаций

Данное руководство состоит из следующих разделов.

- Изучение и форматирование данных

- Выполнение задания Mahout

Команда Microsoft Research побила мировой рекорд по сортировке

2012-05-22 в 12:00, admin, рубрики: Hadoop, MapReduce, высокая производительность, Облачные вычисления, Поисковые машины и технологии, метки: Hadoop, MapReduce  На сайте sortbenchmark.org ежегодно проводятся конкурсы по сортировке больших наборов данных. Один из видов соревнований — minute sort, в котором необходимо за минуту прочитать с диска и сортировать как можно большее число записей и сохранить результат в файл. Конкурс проходит в двух категориях — Indy, без ограничений на используемое железо, и Daytona — должны использоваться только обычные компьютеры “из магазина”.

На сайте sortbenchmark.org ежегодно проводятся конкурсы по сортировке больших наборов данных. Один из видов соревнований — minute sort, в котором необходимо за минуту прочитать с диска и сортировать как можно большее число записей и сохранить результат в файл. Конкурс проходит в двух категориях — Indy, без ограничений на используемое железо, и Daytona — должны использоваться только обычные компьютеры “из магазина”.

Команде Microsoft Research удалось многократно превысить державшийся с 2009 года рекорд Yahoo в категории Daytona. Их кластер, состоящий из 1033 дисков на 250 машинах, справился с 1401 гигабайтом данных. Это почти втрое лучше результата Yahoo (500 гигабайт), при том, что кластер Yahoo был почти в шесть раз больше (5624 диска на 1406 машинах). Более того, майкрософтовский кластер побил и прошлогодний рекорд в категории Indy (1353 гигабайта).

Читать полностью »