Иногда, задавая нейронке один вопрос, неожиданно получаешь ответ на какой-нибудь другой, тоже интересный.

Иногда, задавая нейронке один вопрос, неожиданно получаешь ответ на какой-нибудь другой, тоже интересный.

У вас сегодня были галлюцинации? Вы можете возразить, что у вас не только сегодня не было галлюцинаций, но и никогда в жизни их не было. На самом деле галлюцинации встречаются чаще, чем мы думаем, и они могут помочь нам больше узнать о работе мозга.

Эта небольшая статья попытка подытожить свой опыт работы с ИИ в части галлюцинаций.

За последнее время большие языковые модели (LLM) стали привычным инструментом для анализа и работы с текстом. Но, что важно, качество ответа зависит не только от самой модели, но и от того, как именно задан запрос.

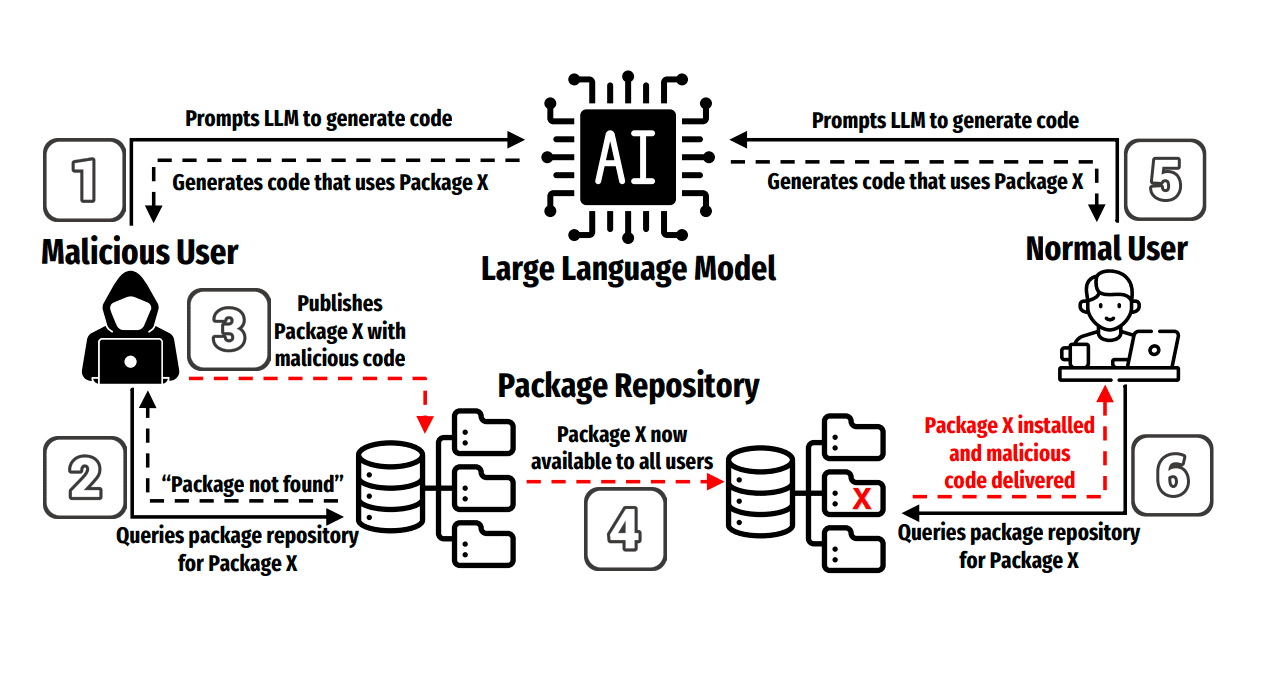

Сейчас на Хабре много пишут о галлюцинировании нейронных сетей и больших языковых моделей в частности. Хорошим введением в эту тему, написанным с философских позиций, мне представляется текст уважаемого Дэна Рычковского @DZRobo «Когда ИИ закрывает глаза: путешествие между воображением и галлюцинациями». Базовое техническое погружение в тему вы найдёте в статье уважаемой @toppal «Причины возникновения галлюцинаций LLM», это перевод академической статьиЧитать полностью »

Я джун. И я давно подсел на ИИ: он помогает мне с кодом, пишет письма, даже шутит (иногда слишком по-дружески с багами). По данным McKinsey, больше 75% компанийЧитать полностью »