Большие языковые модели где только не применяют: генерируют внешний вид автомобилей, домов и кораблей, саммаризируют круглые столы и конференции, придумывают тезисы к статьям, рассылкам и презентациям. Но при всех «плюшках» от внедрения ИИ, не стоит забывать про безопасность. Большие языковые модели атакуют разнообразными изощрёнными способами. В топе новостей о нейросетях — многомиллионные инвестиции в средства защиты от промпт-инъекций. Поэтому поговорим о том, какие угрозы существуют и почему инвесторы платят большие деньги за создание таких бизнесов. А во второй части статьи расскажу, как от них защищаться.

Рубрика «дипфейки»

Обзор уязвимостей для LLM. Часть 1. Атака

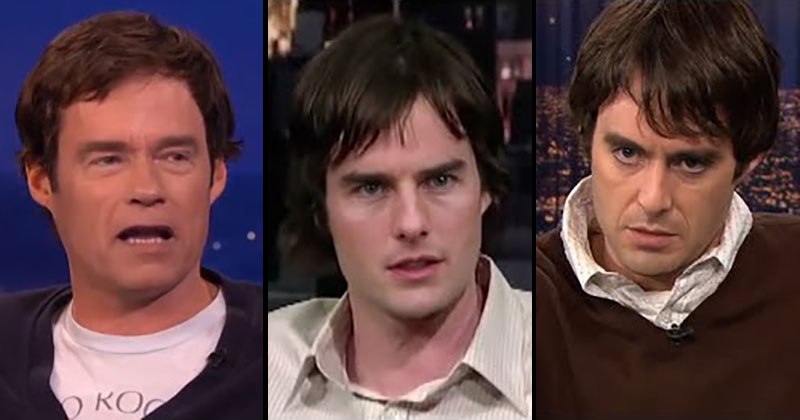

2025-01-05 в 13:55, admin, рубрики: bias, gpt-4, refusal training, sota, атаки, дипфейки, подмена номера, промпт-инъекции, промпты, языковые моделиОбновление FaceFusion v3.0.0 — ультимативной нейросети для дипфейков

2024-11-13 в 8:05, admin, рубрики: Deepfake, timeweb_статьи, будущее здесь, дипфейк, дипфейки, искусственный интеллект, нейросети

Всем привет!

В этой статье взглянем на FaceFusion версии 3.0.0 — мощный инструмент для замены лиц на изображениях и видео!

Для использования понадобится всего лишь фотография в профиль. Также в статье расскажу, как не париться с установкой и запустить FaceFusion в один клик.

Основные возможности FaceFusion:

Поиск по фото и раздетые дипфейки

2024-10-14 в 15:35, admin, рубрики: Deepfake, deepnude, дипфейки, поискпофотоЭти странные, тревожные фото говорят о том, что ИИ умнеет

2020-10-09 в 13:23, admin, рубрики: Madrobots, Блог компании Madrobots, дипфейки, институт аллена, искусственный интеллек, искусственный интеллект

ИИ учится генерировать изображения из подписей и начинает лучше понимать наш мир

Из всех моделей искусственного интеллекта именно GPT-3 разработки OpenAI сильнее всего поразила воображение публики. Она без особых подсказок может извергать стихотворения, короткие рассказы и песни, заставляя думать, что это работы человека. Но красноречие — всего лишь уловка, которую не стоит путать с реальным интеллектом.

Читать полностью »

В Китае публикацию дипфейков отнесли к уголовным преступлениям

2019-12-02 в 11:48, admin, рубрики: Deepfake, дипфейки, законодательство, Законодательство в IT, информационная безопасность, китай

Власти Китая объявили любую публикацию заведомо ложной информации, в том числе дипфейков, уголовным преступлением. Соответствующий закон вступит в силу 1 января 2020 года.

Согласно новым нормам, все дипфейки нужно будет отмечать специальной пометкой, которая будет предупреждать пользователей о том, что это ненастоящая новость. Читать полностью »

Facebook презентовала систему ИИ, которая может обмануть искусственный интеллект на видео

2019-10-27 в 16:00, admin, рубрики: Deepfake, Facebook, Facebook API, Алгоритмы, видео, дипфейки, искусственный интеллект, распознавание лиц

Facebook AI Research заявила о разработке системы машинного обучения, которая не дает искусственному интеллекту определять людей по видео. На этой технологии основаны все современные системы распознавания лиц.

Разработчики утверждают, что ИИ для автоматической модификации видео не требует дополнительного обучения под конкретное видео. Как пояснил инженер-исследователь Facebook AI и профессор Тель-Авивского университета Лиор Вольф, система объединяет состязательный автокодировщик с нейросетью. Алгоритм просто заменяет лицо человека его слегка искаженной версией, а ИИ использует архитектуру кодировщика-декодера и генерирует искаженные и неискаженные изображения лица человека, которые затем можно встроить в видео. Разработка показала на видео, как это работает.Читать полностью »

Исследование показало, что 96% дипфейков в интернете — это порно с известными женщинами или бывшими подругами

2019-10-12 в 6:22, admin, рубрики: Deeptrace, видеотехника, дипфейки, доверие, Законодательство в IT, искусственный интеллект, обработка изображений, порно, травляВ ноябре 2017 года аккаунт Reddit под названием deepfakes опубликовал первые в интернете порнографические видеоролики, в которых программное обеспечение заменяло лица реальных актрис лицами голливудских знаменитостей. Почти два года спустя «дипфейки» стали общим явлением и термином, который описывает любое поддельное видео, сделанное с помощью программ ИИ. Этот метод используют и для смешных видеороликов на YouTube, он также вызывает озабоченность законодателей, опасающихся политической дезинформации. Тем не менее, новое исследование говорит о том, что дипфейки в основном остаются верными своим непристойным корням.

Стартап Deeptrace провел своего рода перепись дипфейков в июне-июле 2019 года, чтобы отрекламировать свои инструменты обнаружения, которые он надеется продать новостным организациям и онлайн-платформам. Всего стартап обнаружил 14 678 видеороликов, открыто представленных в качестве дипфейков: почти в два раза больше, чем семь месяцев назад. Около 96% из них оказались порнографическими.

История дипфейков повторяют историю многих других медиатехнологий, которые получили распространение благодаря порно: от VHS до потокового вещания.

Читать полностью »

Калифорния ввела два закона против дипфейков

2019-10-08 в 13:24, admin, рубрики: Deepfake, deepfakes, дипфейки, Законодательство в IT, искусственный интеллект, машинное обучение, Работа с видео

Губернатор Калифорнии Гэвин Ньюсом подписал два законопроекта, касающихся дипфейков. Первый делает незаконным размещение любых видео с манипуляциями в политических целях — например, замена лица или речи кандидата для его дискредитации. Другой позволит жителям государства подать в суд на любого, кто использует дипфейк в порнографическом видео.

Дипфейки могут быть забавными, однако некоторые могут принести ощутимый вред. Например, дипфейк-видео со спикером палаты представителей конгресса США Нэнси Пелоси, на котором была изменена её речь. Создавалось впечатление, что политик была пьяна и едва выговаривала свои слова. Видео было опубликовано на Facebook, и компания не согласилась удалить его сразу, заявив, что вместо этого разместит статью-опровержение, в которой будет подчеркиваться факт редактирования речи.

Читать полностью »

ИИ не сможет защитить нас от дипфейков, утверждает новый доклад

2019-09-19 в 15:28, admin, рубрики: deepfakes, дипфейки, Законодательство в IT, искусственный интеллект, машинное обучение, машинный интеллект, обработка изображений, Работа с видео

Новый доклад Data and Society ставит под сомнение автоматизированные решения для распознавания видео, созданных с помощью машинного обучения. Авторы исследования — Бритт Пэрис и Джоан Донован — утверждают, что дипфейки, хотя и кажутся относительно новым явлением, на самом деле являются частью долгой истории манипулирования средствами массовой информации.

Чтобы изменить ситуацию, необходимы как социальные, так и технические усовершенствования. Доверие к ИИ, по их мнению, может на самом деле усугубить ситуацию, сконцентрировав больше данных и мощности в руках частных корпораций.

«Отношения между СМИ и правдой никогда не были стабильными, — говорится в отчете. — В 1850-х годах, когда суды начали принимать фото в качестве доказательства, люди не доверяли новой технологии и предпочитали свидетельские и письменные показания. К 1990-м годам медиа-компании были замешаны в искажении событий и избирательной редактуре вечерних трансляций».

Читать полностью »

Facebook и Microsoft запускают конкурс по обнаружению deepfake

2019-09-06 в 13:48, admin, рубрики: Deepfake, deepfakes, дипфейки, искусственный интеллект, машинное обучение, Работа с видео

Facebook совместно с Microsoft и коалицией «Партнёрства по искусственному интеллекту во благо людей и общества» (PAI), а также научными работниками из нескольких университетов анонсировала конкурс на разработку технологии распознавания дипфейков (deepfake).

Как сообщается в блоге Facebook, в рамках проекта, который получил название Deepfake Detection Challenge, Facebook поручит исследователям создавать реалистичные дипфейки. После этого участники конкурса будут прорабатывать алгоритмы обнаружения deepfake. Авторы лучших получат гранты. Призовой фонд проекта — $10 миллионов.

Читать полностью »