Рубрика «DeepEval»

Оценка систем LLM: основные метрики, бенчмарки и лучшие практики

2025-01-22 в 11:34, admin, рубрики: DeepEval, g-eval, llm, Text-SQL, бенчмаркиОценка RAG: Полное руководство по модульному тестированию RAG в CI-CD

2024-12-12 в 9:59, admin, рубрики: DeepEval, llm, rag, RAGA5 лучших фреймворков с открытым исходным кодом для оценки больших языковых моделей (LLM) в 2024 году

2024-12-10 в 9:30, admin, рубрики: arize ai, DeepEval, llm, mlflow, rag, ragas

Коротко о главном

«У меня такое чувство, что решений для оценки LLM больше, чем проблем, связанных с их оценкой», — сказал Дилан, руководитель отдела ИИ в компании из списка Fortune 500.

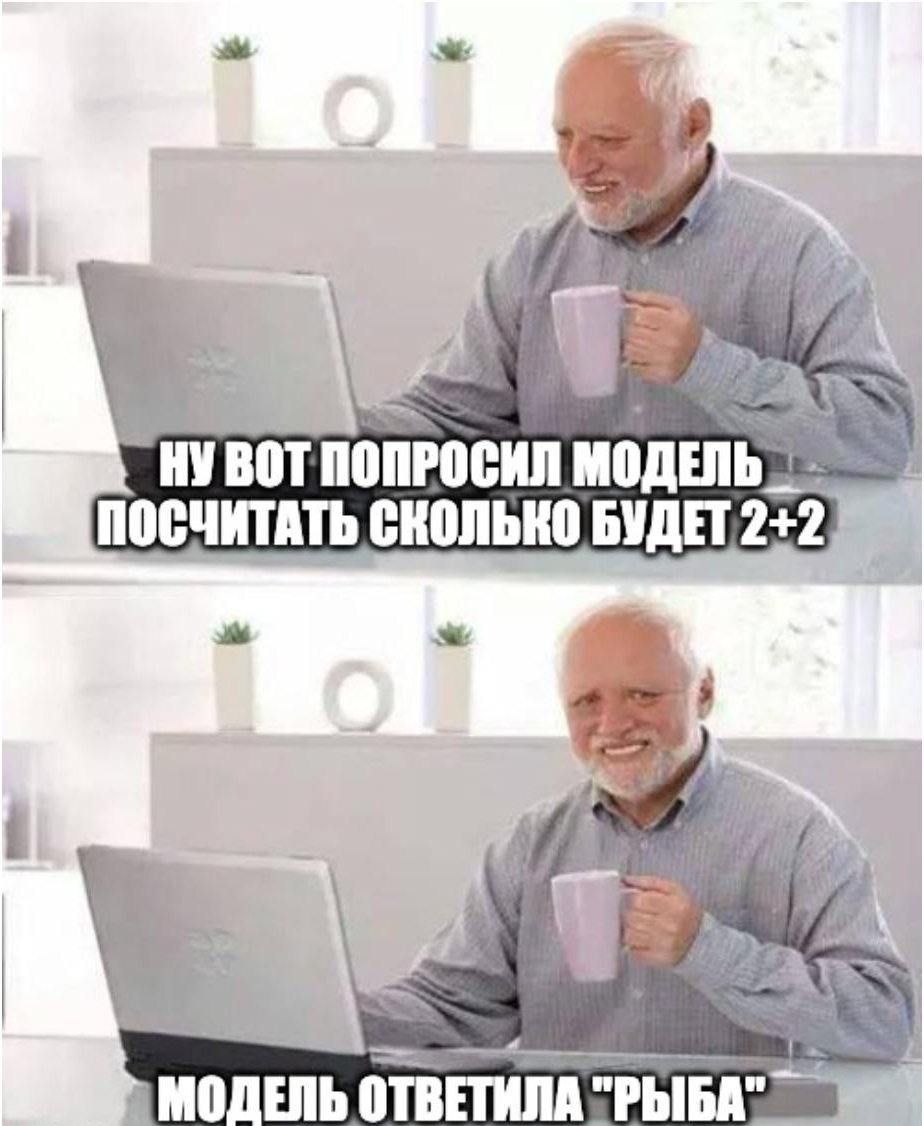

Как ухватить LLM за хвост: эффективные стратегии тестирования AI-моделей

2024-11-26 в 12:32, admin, рубрики: AI метрики, DeepEval, GEval, LangSmith, llm, LLM тестированиеКак убедиться, что ваша LLM не выдаст полную чепуху в самый неподходящий момент? Как проверить, что она действительно понимает контекст, а не просто генерирует красивые, но бессмысленные фразы? И самое главное — как сделать это эффективно, не тратя недели на ручную проверку тысяч ответов?