PUE, довольно спорный, но от того не менее интересный параметр энергоэффективности функционирования ЦОД, недавно получил очередной удар по своему авторитету универсального мерила оптимальности потребления электроэнергии. Компания NGD (Next Generation Data) объявила о достижении их дата-центром коэффициента PUE, равного 1.0! Что это? Фундаментальный прорыв в технологиях, маркетинговая манипуляция не слишком расторопным коэффициентом, или откровенная ложь? Далее в этой статье и попробуем разобраться в столь нетривиальном заявлении о достижении неимоверного PUE, которое сделал на прошлой неделе в Лондоне Ник Разей (Nick Razey), генеральный директор NGD.

Рубрика «дата-центр» - 18

Коварный PUE

2014-11-30 в 21:00, admin, рубрики: IT-стандарты, PUE, дата-центр, Исследования и прогнозы в IT, ит-инфраструктура, серверы, солнечная энергетика, Терминология ITКак согреться за «чужой» счет

2014-11-29 в 13:26, admin, рубрики: высокая производительность, дата-центр, ит-инфраструктура, Облачные вычисления, процессор, сервер, хостинг, цодДата-центры обычно не используют всю тепловую энергию, которую сами вырабатывают, но есть множество способов использовать ее с пользой на все 100%. Например, в своем собственном доме посреди зимы в каком-нибудь уголке планеты, не балующем жителей мягким климатом. Можно, конечно, жить прямо в дата-центре. А если серьезно, достаточно иметь небольшой ЦОДик, производящий необходимое количество тепла, у себя дома или в офисе.

Компания Global Web Index представила статистический отчет о интернет предпочтениях жителей Европы в 2014 году

2014-11-29 в 12:31, admin, рубрики: веб-аналитика, визуализация данных, дата-центр, исследование рынка, Исследования и прогнозы в IT, ит-инфраструктура, статистика интернета, хостинг

Как известно, мировым лидером среди стран по внедрению ИТ-инфраструктуры является США. Именно в Северной Америке сейчас находится наибольшее количество дата-центров, немало из которых являются настоящими гигантами. В тоже время Азия берет количеством, при этом показывая феноменальные темпы роста в регионе как вычислительных мощностей ИТ-инфраструктуры, так и числа пользователей сети. Что же в этом контексте происходит с Европой, скатывание на периферию? Несколько пролить свет на этот вопрос помог опубликованный исследовательской компанией Global Web Index статистический отчет «Европейский цифровой ландшафт 2014» (European Digital Landscape 2014). Исследование затронуло 40 стран Европы. Хотя данные исследования свежие, но даже во время их сбора уже отмечалось, что они претерпевают изменения в сторону количественного и качественного увеличения, и эту тенденцию стоит учитывать для максимально корректного восприятия приведенных результатов исследования в одном из наиболее развитых регионов мира.Читать полностью »

Самый южный дата-центр

2014-11-27 в 9:44, admin, рубрики: астрономия, дата-центр, инфраструктура, Исследования и прогнозы в IT, ит-инфраструктура, охлаждение серверной, Серверное администрирование, хостингКогда мы в разговоре слышим слово «юг», наше сознание непроизвольно рисует солнечные картины, соленый бриз, стаи морских птиц, пальмы. В этой статье пойдет разговор о самом южном дата центре в мире, но, несмотря на сезонное изобилие солнца, Вы не найдете здесь разгуливающих в бикини курортниц. При полярной станции Амундсена-Скота, что разместилась на 89 градусах 59 минутах и 24 секундах южной широты, для поддержания работы нейтринной обсерватории был создан и успешно функционирует дата-центр «Ледяной Куб» (Ice Cube data center). О задачах этого ИТ-узла и о тех условиях, в которых приходится поддерживать работоспособность оборудования, и пойдет речь далее в статье.

Правовые основы защиты данных и бизнеса при размещении серверов в дата-центре

2014-11-25 в 9:02, admin, рубрики: дата-центр, закон, Законодательство и IT-бизнес, право, размещения и аренды серверов, услуги хостингаОчень много статей посвящено информационной безопасности, защите данных на техническом уровне, но люди и бизнес иной раз в желании всех переиграть переигрывают сами себя. Для того, чтобы надежней защитить свои данные, а иной раз по незнанию или нежеланию подумать на несколько ходов вперед, оформляют услуги размещения и аренды серверов в дата-центрах на подставные компании или же третьих лиц. Собственно к написанию данной заметки меня подтолкнул уже сутки длящийся вынос мозга мне и всем нашим сотрудникам. И такая ситуация уже не первый раз возникает.

Одно ООО «Рога и копыта» возможно в целях защиты своих данных оформило договор с нашим дата-центром не на себя, а на своего то ли сотрудника, то ли приходящего системного администратора. Можно ли сделать это в каких-либо других целях мне неизвестно.

Теперь ООО «Рога и копыта» по всей видимости плохо рассталось с человеком, на которого оформлены серверы. Человек этот попросил серверы выключить, и у ООО «Рога и копыта» весь бизнес встал. Мы оказались в крайне неприятной ситуации. Но действовать мы обязаны по закону и отправлять всех в суд, полицию.

Читать полностью »

В любой момент времени около третьей части пользователей сети интернет находятся on-line

2014-11-12 в 11:00, admin, рубрики: дата-центр, Исследования и прогнозы в IT, ит-инфраструктура, нагрузка на каналы, прогнозирование, системное администрирование, хостингАктивность пользователей в сети интернет всегда была очень важным фактором, которому исследовательские организации уделяли особо много внимания. Распределение пользователей по странам, плотность подключений, временные рамки наибольшей/наименьшей активности в течение суток — это все исходные параметры на основе которых проводится работа по оптимизации нагрузок для той или иной территории. Пиковые нагрузки на интернет каналы — это краеугольный камень организации ИТ-инфраструктуры, без статистических данных, без понимания базовых понятий их возникновения невозможно наладить действительно эффективную модель работы сети.

Благодаря всеобщей интернетизации планеты (доступности и дешевизны интернета), а также беспечности рядовых пользователей, стало возможным отследить практически каждый не защищенный от сетевой атаки гаджет (будь это стационарный/мобильный ПК, смартфон, планшет, игровая консоль). Так, нашумевшая в свое время «Интернет перепись IPv4 2012», которая отображает активность незащищенных сетевых устройств по всему миру, стала отличным, многослойным нагромождением информации для анализа, которая до сих пор даёт людям почву для размышления.

CERN планирует увеличение своих вычислительных возможностей до 150 000 ядер

2014-11-11 в 17:30, admin, рубрики: CERN, openstack, БАК, высокая производительность, дата-центр, ит-инфраструктура, облако, серверы, ЦЕРНПариж, 1989 год — начало создания одного из величайших и дорогостоящих творений современности, Большого адронного коллайдера. Это событие несомненно можно назвать подвигом, но установка, образовавшая почти 27-километровое кольцо, вкопанное более чем на 90 метров под землёй на франко-швейцарской границе, бесполезна без огромных вычислительных мощностей и не менее огромного хранилища данных.

Практика эксплуатационщика: 1000 дней без простоя ЦОДа TIER-III

2014-10-16 в 5:49, admin, рубрики: Tier, Uptime Institute, авария, аудит, Блог компании КРОК, дата-центр, ит-инфраструктура, питание, практика, тепловизор, управление проектами, цод

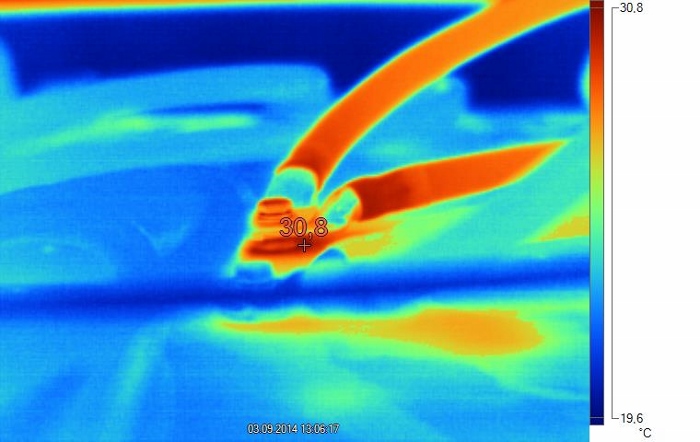

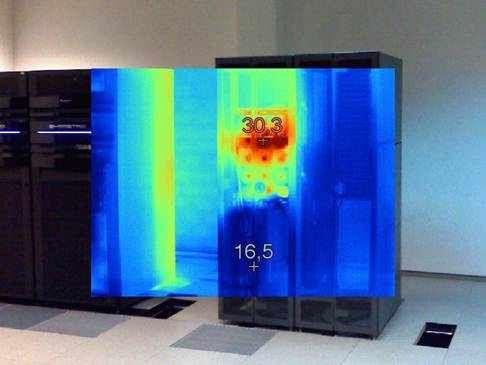

Окисление контактов перемычки аккумулятора вызвало нагрев. При наружном осмотре следов окисления не видно, поскольку оно произошло между клеммой аккумулятора и наконечником перемычки.

Пару недель назад у меня и коллег случился маленький праздник: 1000 дней непрерывной работы ЦОДа без простоя сервиса. В смысле — без влияния на оборудование заказчиков, но со штатными и не очень работами по системам.

Ниже я расскажу о том, как я и мои коллеги обслуживают ЦОД повышенной ответственности, и какие бывают подводные камни.

Читать полностью »

FAQ про охлаждение дата-центров: как сделать дёшево, сердито, надёжно и вписаться в габариты площадки

2014-10-02 в 6:18, admin, рубрики: бескомпрессорный холод, Блог компании КРОК, дата-центр, ит-инфраструктура, охлаждение, управление проектами, фрикулинг, хладоноситель, цод

— Какой обычно есть выбор для охлаждения ЦОДа?

- Фреоновое охлаждение. Проработано, просто, доступно, но главный минус — ограниченные возможности по манёвру в энергоэффективности. Также часто мешают физические ограничения по длине трассы между наружными и внутренними блоками.

- Системы с водой и гликолевыми растворами. То есть хладагентом всё ещё остаётся фреон, а вот хладоносителем уже будет другое вещество. Трасса может быть длиннее, но главное, что открывается многообразие вариантов настройки режимов работы системы.

- Системы комбинированного типа: кондиционер может быть и фреонового, и водяного охлаждения (здесь масса нюансов).

- Охлаждение воздухом с улицы — это различные варианты фрикулинга: роторные теплообменные аппараты, прямые и косвенные охладители и так далее. Общий смысл — либо прямой теплоотвод фильтрованным воздухом, либо замкнутая система, где уличный воздух охлаждает внутренний через теплообменник. Нужно смотреть на возможности площадки, так как возможны внезапные решения.

— Так давайте бахнем классические фреоновые системы, в чём проблема?

Классические фреоновые системы отлично работают в малых серверных и, не часто, средних ЦОДах. Как только машзал переваливает за 500–700 кВт, возникают проблемы с размещением наружных блоков кондиционеров. Для них банально не хватает места. Приходится искать свободные площади подальше от ЦОДов, но тут вмешивается длина трассы (её не хватает). Конечно, можно спроектировать систему на пределе возможностей, но тогда растут потери в контуре, снижается эффективность, усложняется эксплуатация. В итоге для средних и больших ЦОДов сугубо фреоновые системы зачастую невыгодны.Читать полностью »

Дата-центр в домашних условиях

2014-09-09 в 14:05, admin, рубрики: дата-центр, Железо, ит-инфраструктура, обучение, сервер, советы и рекомендацииБывает, что любители и ИТ-специалисты создают центры обработки данных в своих домах, размещая оборудование в импровизированных серверных комнатах, гаражах, подвалах или домашних офисах. Таких людей называют серверофилы («server huggers»). Это люди, стремящиеся быть ближе к оборудованию, которое они используют.

Домашние центры обработки данных, или, как их называют, «пещерные ДЦ», играют немаловажную роль в современной жизни и развитии ИТ-технологий. Данные ДЦ, в противовес крупномасштабным дата-центрам, являются первопроходцами в испытании серверного оборудования. Такого рода энтузиасты питают страсть к ИТ и, как правило, одни из первых начинают использовать новые серверные системы, тестируя их в экстремальных условиях.