Волею судеб в мои руки попал обученный на поисковых запросах Word2Vec. Под катом даны примеры использования с пояснениями.

Читать полностью »

Рубрика «data mining» - 76

Word2Vec в примерах

2015-01-29 в 13:38, admin, рубрики: data mining, word2vec, Поисковые машины и технологии, СемантикаDeep learning и Caffe на новогодних праздниках

2015-01-28 в 11:53, admin, рубрики: big data, data mining, deep learning, инструментарий, нейронные сети, обработка изображенийМотивация

В данной статье вы познакомитесь c применением deep learning на практике. Будет использован фреймворк Caffe на датасете SVHN.

Deep Learning. Этот buzz word уже давно звенит в ушах, но попробовать его на практике никак не удавалось. Подвернулся удобный случай это исправить! На новогодние праздники был назначен контест на kaggle по распознаванию номеров домов в рамках курса по анализу изображений.

Читать полностью »

Кластеризация: расскажи мне, что ты покупаешь, и я скажу кто ты

2015-01-26 в 14:04, admin, рубрики: big data, data mining, retail, Алгоритмы, Блог компании datawiz.io, математика, ритейл

Задача Datawiz.io: провести кластеризацию клиентов программы лояльности в ритейле.

Кластеризация — это метод поиска закономерностей, предназначенный для разбиения совокупности объектов на однородные группы (кластеры) или поиска существующих структур в данных.

Целью кластеризации является получение новых знаний. Это как “найти клад в собственном подвале”.

Для чего это нужно компаниям? Чтобы лучше узнать своих клиентов. Чтобы найти индивидуальный подход к каждому клиенту, а не работать со всеми одинаково.

Читать полностью »

Когда данных действительно много: Vowpal Wabbit

2015-01-25 в 16:59, admin, рубрики: big data, data mining, machine learning, python, разработкаПривет!

В предыдущих двух постах (раз, два) мы расмотрели основные алгоритмы и техники, применяющиеся участниками соревнований Kaggle. Сегодня хотелось бы пойти дальше и поговорить про то, с какими трудностями встречаются исследователи при разработке алгоритмов в случае, когда данных очень много и обучаться приходится на выборках, которые не помещаются в память. Сразу стоит отметить, что это происходит довольно часто, даже на самом Kaggle (в данной задаче обучающая выборка имеет обьем в несколько гигабайт и новичку может быть просто не понятно, что с этим делать). Ниже мы рассмотрим алгоритмы машинного обучения и инструменты, справляющиеся с данной проблемой.

Читать полностью »

Обзор наиболее интересных материалов по анализу данных и машинному обучению №32 (19 — 25 января 2015)

2015-01-25 в 16:14, admin, рубрики: big data, data mining, data science, data science digest, machine learning

Представляю вашему вниманию очередной выпуск обзора наиболее интересных материалов, посвященных теме анализа данных и машинного обучения.

Читать полностью »

Data tidying: Подготовка наборов данных для анализа на конкретных примерах

2015-01-24 в 14:00, admin, рубрики: data mining, анализ данных, подготовка данных к анализуДанная статья возникла в результате переработки и перевода информации на русский язык, взятой из двух источников:

- из статьи «Tidy Data»

- из соответствующего swirl урока по tidyr package

Для профессионалов в области анализа данных это, возможно, выглядит как давно выученная таблица умножения — вряд ли они найдут здесь что-то новое. А тех, кто как и я только знакомится с данной областью и возможностями языка R, приглашаю продолжить чтение.

Читать полностью »

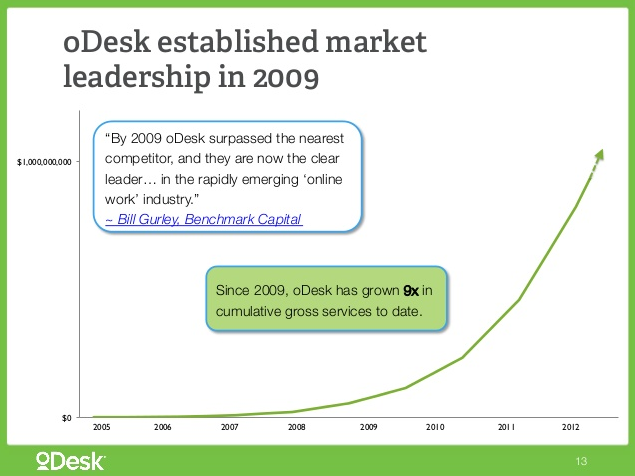

Исследование проектов на фриланс-бирже Odesk глазами веб-разработчика

2015-01-24 в 0:20, admin, рубрики: css, data mining, html, javascript, php, web-разработка, биржи фриланса, Веб-разработка, удаленная работа, фриланс

Воспользовавшись относительно недавно завершившимися новогодними каникулами, я занялся анализом проектов на крупнейшей международной бирже Odesk. Получившиеся результаты вкупе с описанием методики исследования и вспомогательными скриптами, думаю, будут вполне интересны широкой публике. В отличие от предыдущей прекрасной статьи на эту тему, я решил провести исследование немного с другой стороны. В первую очередь я искал ответ на вопрос «за что на odesk больше всего платят по факту и на чем мне будет лучше там зарабатывать»? Во вторую очередь хотелось оценить «с высоты птичьего полета» — что вообще представляет из себя работа на Odesk. Под катом вас ожидают:

+ примеры использованных для работы с Odesk API скриптов и описание нескольких подводных камней

+ анализ более чем 200 000 выполненных проектов на общую сумму свыше $40 000 000 USD

+ знакомство с программой для визуализации отчетов Tibco Spotfire

+ немаленькое количество разных интересных графиков

+ скандалы, интриги, расследования

Читать полностью »

Data-mining в 40 строк или С кем и против кого вы заодно

2015-01-22 в 19:45, admin, рубрики: data mining, drupal, php Находим единомышленников и противников друзей и врагов среди пользователей сайта на Drupal, используя данные votingapi.

Делаем выборку данных

SELECT v1.uid uid1, v2.uid uid2, u.name name2,

v2.entity_id entity_id, v1.value value1, v2.value value2

FROM votingapi_vote v1

JOIN (votingapi_vote v2, users u)

ON (v1.uid != v2.uid AND v1.entity_id=v2.entity_id

AND v1.entity_type=v2.entity_type AND v2.uid=u.uid)

WHERE v1.uid < v2.uid AND v1.uid != 0 AND v2.uid != 0

ORDER BY v1.uid,v2.uid;JOIN таблицы votingapi_vote на себя саму выбирает все пермутации пар пользователей, а условие v1.uid < v2.uid превращает пермутации в комбинации.

Условие v1.entity_type=v2.entity_type AND v2.uid=u.uid позволяет выбрать голоса, которые пользователи отдали за одну и ту же тему или комментарий. Скажем, первая строчка в нашей выборке означает, что администратор и Bob дали 100 очков одной и той же теме или одному и тому же комментарию.

Условие v1.uid != 0 AND v2.uid != 0 исключает анонимные комментарии.

В результате получаем таблицу из пяти колонок:

Читать полностью »

Собираем плохие данные — 2. 1.5 года спустя, про то как не надо публиковать открытые данные

2015-01-22 в 7:06, admin, рубрики: data mining, Opendata, Блог компании «Информационная культура», открытые данные, плохие данныеНе секрет, что российские органы власти в последнее время декларируют высокую степень открытости, публикуют данные и некоторые из них даже бывают полезными, но так было не всегда и далеко не везде.

Полтора года назад я приводил массу примеров неверного толкования открытых данных. В заметке «Собираем плохие данные» есть несколько примеров, когда за машиночитаемые открытые данные выдавали разделы на сайтах или PDF документы.

При том, что мониторить открытость государственных данных в России дело неблагодарное, и что методрекомендации того же Минэкономразвития — это победа формы над содержанием, но даже в таком раскладе можно было сетовать лишь на то, что госорганам облегчили жизнь по публикации данных, а не усложнили.

Надо ли делать полноценное обследование властей на предмет качества открытости данных — вопрос открытый. Рано или поздно это потребуется сделать даже при том, что займёт много времени.

Но самыми выдающимися примерами можно ознакомится сейчас. Ну и конечно — рейтинги фуфло, антирейтинги рулят. Худших надо знать в лицо.

Читать полностью »

Как начать работу в Kaggle: руководство для новичков в Data Science

2015-01-21 в 6:36, admin, рубрики: big data, data mining, kaggle, machine learning, nolearn, python, актуальная проблематика, анализ данных, глубокое обучение, искусственные нейронные сети, искусственный интеллект, новичкам, обучение, Питон, рythonДоброго времени суток, уважаемыее! Сегодня я хотел бы поговорить о том, как не имея особого опыта в машинном обучении, можно попробовать свои силы в соревнованиях, проводимых Kaggle.

Как вам уже, наверное, известно, Kaggle – это платформа для исследователей разных уровней, где они могут опробовать свои модели анализа данных на серьезных и актуальных задачах. Суть такого ресурса – не только в возможности получить неплохой денежный приз в случае, если именно ваша модель окажется лучшей, но и в том (а, это, пожалуй, гораздо важнее), чтобы набраться опыта и стать специалистом в области анализа данных и машинного обучения. Ведь самый важный вопрос, зачастую стоящий перед такого рода специалистами – где найти реальные задачи? Здесь их достаточно.

Мы попробуем поучаствовать в обучающем соревновании, не предусматривающем каких-либо поощрений, кроме опыта.

Читать полностью »