Лог-линейные модели и их представления в виде марковских сетей позволяют показать структуру взаимосвязей между случайными величинами. Однако полученная визуализация может оказаться трудна для восприятия из-за большого числа равнозначных ребер в графе такой модели. При работе с порядковыми и бинарными переменными гауссовы копулы (Gaussian copula graphical models, сокр. GCGM) дают возможность повысить наглядность и упростить интерпретацию модели. В статье приведен краткий обзор теории и построен пример GCGM для European Social Survey данных.

Рубрика «data mining» - 60

Визуализация фото-портфолио. Часть 1: Нестандартное применение deep learning

2016-09-03 в 13:23, admin, рубрики: data mining, data science, deep learning, dimensionality reduction, inceptionV3, keras, sklearn, t-sne, truncatedSVD, визуализация данных, машинное обучение

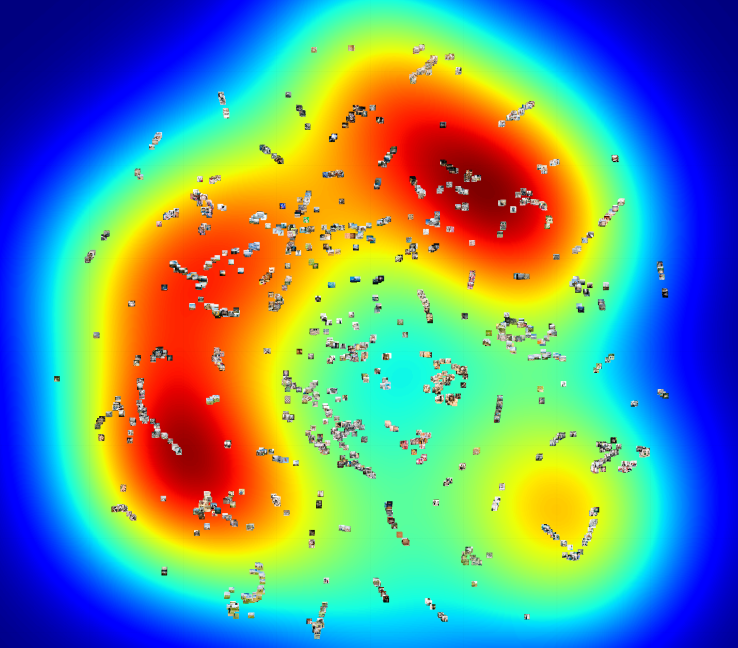

Визуализация портфолио (на данном рисунке, чем краснее область, тем больше фото в этой области, имеющих нулевое количество скачиваний)

Коротко о задаче: есть фото-портфолио с большим количеством фото, хотим узнать список популярных и не популярных тем.

Читать полностью »

В тени случайного леса

2016-08-28 в 12:19, admin, рубрики: data mining, Gradient Boosting, random forest, машинное обучение, Разработка веб-сайтов, стастистика, метки: стастистика1. Вступление

Это небольшой рассказ о практических вопросах использования машинного обучения для масштабных статистических исследований различных данных в Интернет. Также будет затронута тема применения базовых методов математической статистики для анализа данных.

Алгоритм Левенберга — Марквардта для нелинейного метода наименьших квадратов и его реализация на Python

2016-08-26 в 16:16, admin, рубрики: curve-fitting, data mining, Алгоритмы, математика, машинное обучение, метод наименьших квадратов, методы оптимизации

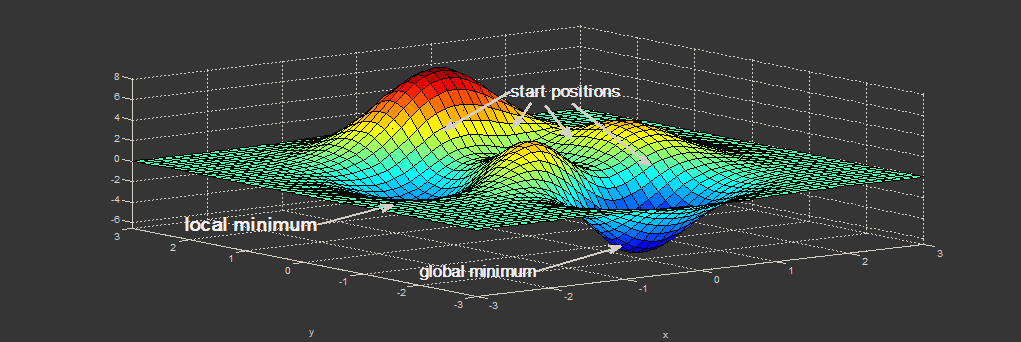

Нахождение экстремума (минимума или максимума) целевой функции является важной задачей в математике и её приложениях (в частности, в машинном обучении есть задача curve-fitting). Наверняка каждый слышал о методе наискорейшего спуска (МНС) и методе Ньютона (МН). К сожалению, эти методы имеют ряд существенных недостатков, в частности — метод наискорейшего спуска может очень долго сходиться в конце оптимизации, а метод Ньютона требует вычисления вторых производных, для чего требуется очень много вычислений.

Для устранения недостатков, как это часто бывает, нужно глубже погрузиться в предметную область и добавить ограничения на входные данные. В частности: МНС и МН имеют дело с произвольными функциями. В статистике и машинном обучении часто приходится иметь дело с методом наименьших квадратов(МНК). Этот метод минимизирует сумму квадрата ошибок, т.е. целевая функция представляется в виде:

Алгоритм Левенберга — Марквардта используется для решения нелинейного метода наименьших квадратов. Статья содержит:

- объяснение алгоритма

- объяснение методов: наискорейшего спуска, Ньтона, Гаусса-Ньютона

- приведена реализация на Python с исходниками на github

- сравнение методов

Что такое большие данные, часть 2

2016-08-26 в 8:12, admin, рубрики: altavista, amazon, Amazon Web Services, big data, data mining, Facebook, Google, pagerank, Yahoo, Большие данные, информация, история

В первой части этой серии статей вы узнали о данных и о том, как можно использовать компьютеры чтобы добывать смысловое значение из крупных блоков таких данных. Вы даже видели что-то похожее на большие данные у Amazon.com середины девяностых, когда компания запустила технологию для наблюдения и записи в реальном времени всего, что многотысячная аудитория клиентов одновременно делала на их сайте. Довольно впечатляюще, но назвать это большими данными можно с натяжкой, пухлые данные — больше подойдёт. Организации вроде Агентства национальной безопасности США (NSA) и Центра правительственной связи Великобритании (GCHQ) уже собирали большие данные в то время в рамках шпионских операций, записывая цифровые сообщения, хотя у них и не было простого способа расшифровать их и найти в них смысл. Библиотеки правительственных записей были переполнены наборами бессвязных данных.

То, что сделал Amazon.com, было проще. Уровень удовлетворённости их клиентов мог быть легко определен, даже если он охватывал все десятки тысяч продуктов и миллионы потребителей. Действий, которые клиент может совершить в магазине, реальный он или виртуальный, не так уж много. Клиент может посмотреть что в доступе, запросить дополнительную информацию, сравнить продукты, положить что-то в корзину, купить или уйти. Всё это было в пределах возможностей реляционных баз данных, где отношения между всеми видами действий возможно задать заранее. И они должны быть заданы заранее, с чем у реляционных баз данных проблема — они не так легко расширяемы.

Заранее знать структуру такой базы данных — как составить список всех потенциальных друзей вашего неродившегося ребенка… на всю жизнь. В нём должны быть перечислены все неродившиеся друзья, потому что как только список будет составлен, любое добавление новой позиции потребует серьезного хирургического вмешательства.Читать полностью »

«Мои друзья потеряли меня из виду на 3 месяца» или как люди учатся у нас big data

2016-08-24 в 13:11, admin, рубрики: big data, data mining, data science, Блог компании New Professions Lab, машинное обучениеВсем привет! 5 октября в New Professions Lab стартует пятый набор программы «Специалист по большим данным», которую на данный момент закончило более 200 человек. Мы уже рассказывали на Хабре (здесь и здесь), чему конкретно мы учим, с какими знаниями и навыками выходят наши выпускники, и совсем скоро напишем, что нового будет в пятой программе. А сегодня хотим поделиться рассказами и отзывами тех, кто уже прошел обучение и на себе испытал все тяготы и невзгоды.

Кого агрегирует Meduza?

2016-08-11 в 6:32, admin, рубрики: big data, data mining, анализ данных, аналитика, визуализация данных, математика, Медиа, МедузаГегель считал, что общество становится современным, когда новости заменяют религию.

The News: A User's Manual, Alain de Botton

Читать все новости стало разительно невозможно. И дело не только в том, что пишет их Стивен Бушеми в перерывах между боулингом с Лебовски, а скорее в том, что их стало слишком много. Тут нам на помощь приходят агрегаторы новостей и естественным образом встаёт вопрос: а кого и как они агрегируют?

Заметив пару интересных статей на Хабре про API и сбор данных популярного новостного сайта Meduza, решил расчехлить щит Персея и продолжить славное дело. Meduza мониторит множество различных новостных сайтов, и сегодня разберемся какие источники в ней преобладают, можно ли их осмысленно сгруппировать и есть ли здесь ядро, составляющее костяк новостной ленты.

Краткое определение того, что такое Meduza:

«Помните, как неумные люди все время называли «Ленту»? Говорили, что «Лента» — агрегатор. А давайте мы и в самом деле сделаем агрегатор» (интервью Forbes)

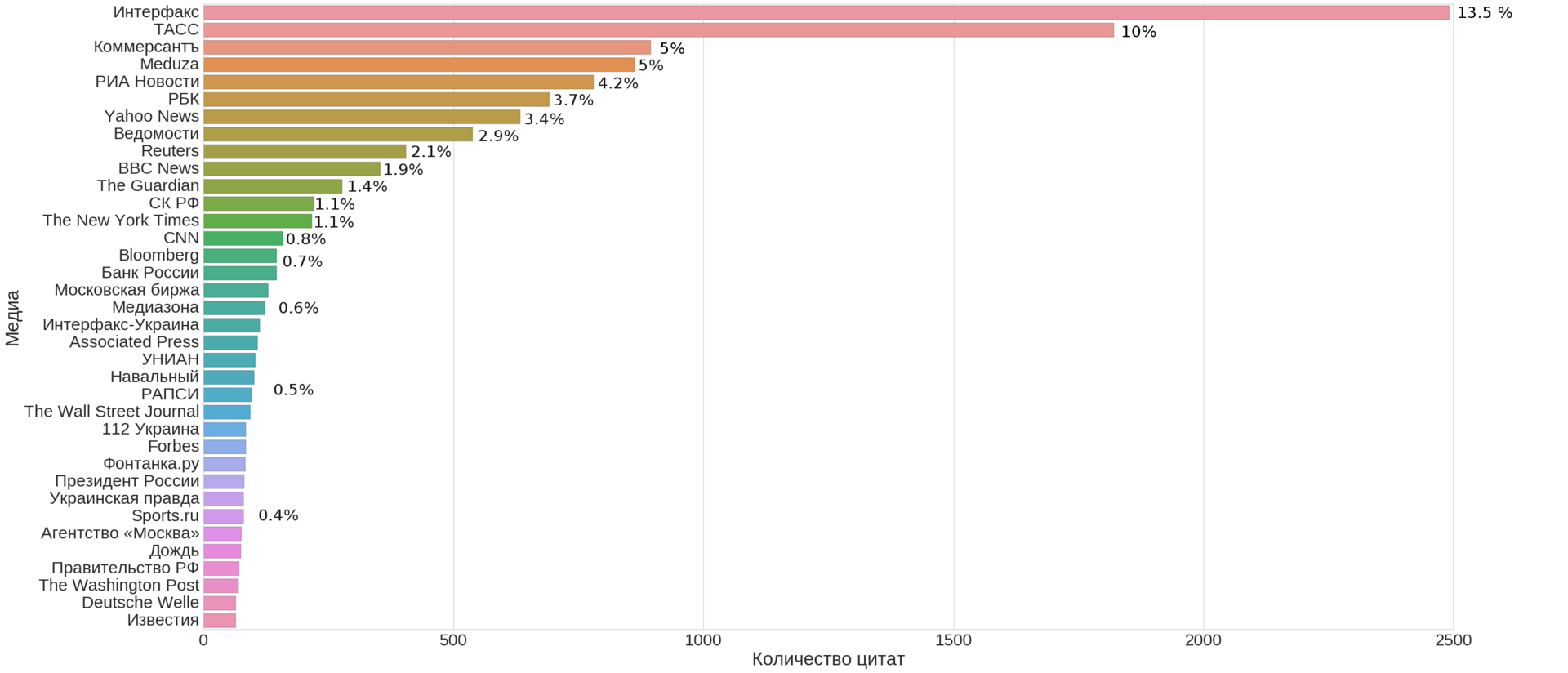

(это не просто КДПВ, а топ-35 медиа по числу новостей указанных в качестве источника на сайте Meduza, включая её саму)

Конкретизируем и формализуем вопросы:

- Q1: Из каких ключевых источников состоит лента новостей?

Иначе говоря, можем ли мы выбрать небольшое число источников достаточно покрывающих всю ленту новостей?

- Q2: Есть ли на них какая-то простая и интерпретируемая структура?

Проще говоря, можем ли мы кластеризовать источники в осмысленные группы?

- Q3: Можно ли по этой структуре определить общие параметры агрегатора?

Пересечение морд доменов топ 1,000,000 по N-граммам

2016-08-06 в 20:12, admin, рубрики: alexa top 1m, big data, data mining, ngram, н-граммы, открытые данные, метки: alexa top 1m, ngram, н-граммыЗадачей исследования является визуализация дуплицированности главных страниц доменов по пятисловным шинглам в рамках общей базы.

Травим краулер

8 лекций, которые помогут разобраться в машинном обучении и нейросетях

2016-08-05 в 14:40, admin, рубрики: data mining, Блог компании Surfingbird, глубинное обучение, лекции, математика, машинное обучение, нейросети

Мы собрали интересные лекции, которые помогут понять, как работает машинное обучение, какие задачи решает и что нам в ближайшем будущем ждать от машин, умеющих учиться. Первая лекция рассчитана скорее на тех, кто вообще не понимает, как работает machine learning, в остальных много интересных кейсов.Читать полностью »