Время необходимое на прочтение 11 минут

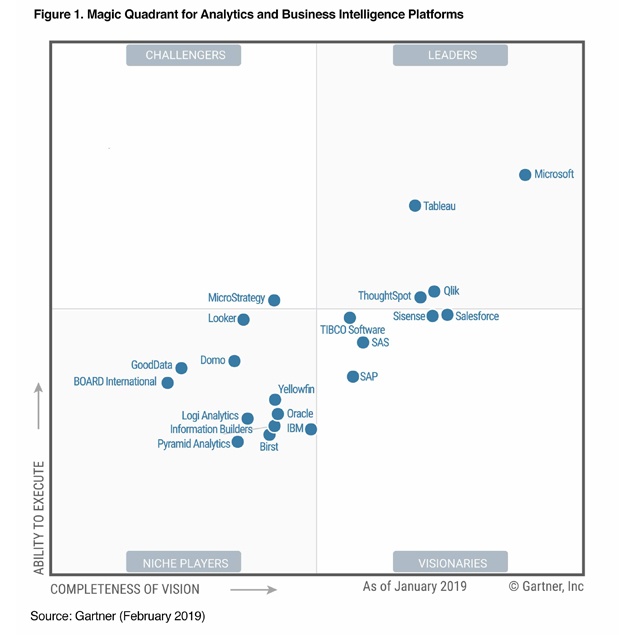

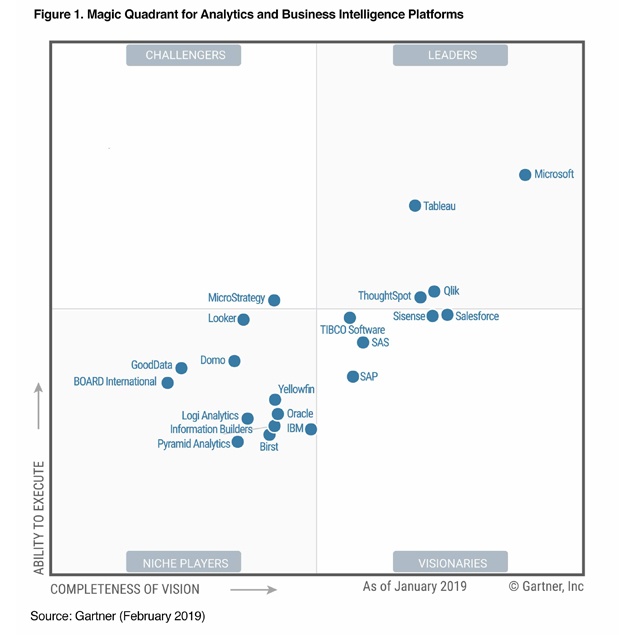

Мы и Квадрат Гартнера 2019 BI :-)

Целью данной статьи является сравнение трёх ведущих BI платформ, которые находятся в лидерах квадранта Gartner:

— Power BI (Microsoft)

— Tableau

— Qlik

Рисунок 1. Gartner BI Magic Quadrant 2019

Меня зовут Жданов Андрей, я руководитель отдела аналитики компании Аналитикс Групп (www.analyticsgroup.ru). Мы строим наглядные отчёты по маркетингу, продажам, финансам, логистике, другими словами занимаемся бизнес аналитикой и визуализацией данных.

Я со своими коллегами уже несколько лет работаем с различными BI платформами. Имеем весьма неплохой опыт проектов, что позволяет нам сравнивать платформы с точки зрения разработчиков, аналитиков, бизнес-пользователей и внедренцев BI систем.

У нас будет отдельная статья по сравнению цен и визуальному оформлению этих BI систем, поэтому тут постараемся оценить эти системы именно с точки зрения аналитика и разработчика.

Выделим несколько направлений для анализа и оценим по 3 бальной системе:

— Порог вхождения и требования к аналитику;

— Источники данных;

— Очистка данных, ETL (Extract, Transform, Load)

— Визуализации и разработка

— Корпоративная среда — сервер, отчеты

— Поддержка мобильных устройств

— Embedded (встроенная) аналитика в сторонние приложения/сайты

Читать полностью »