Привет. Я хочу продолжить тему реализации методов машинного обучения на c#, и в этой статье я расскажу про алгоритм обратного распространения ошибки для обучения нейронной сети прямого распространения, а также приведу его реализацию на языке C#. Особенность данной реализации в том, что реализация алгоритма абстрагирована от реализаций целевой функции (той, которую нейросеть пытается минимизировать) и функции активации нейронов. В итоге получится некий конструктор, с помощью которого можно поиграться с различными параметрами сети и алгоритма обучения, посмотреть и сравнить результат. Предполагается, что вы уже знакомы с тем, что такое искусственная нейросеть (если нет, то настоятельно рекомендую для начала изучить википедию или одну из подобных статей). Интересно? Лезем под кат.

Рубрика «data mining» - 100

Алгоритм обратного распространения ошибки с регуляризацией на c#

2012-10-15 в 11:39, admin, рубрики: .net, data mining, алгоритм, искусственный интеллект, нейронные сети, обратное распространение ошибки, регуляризация, метки: c++, алгоритм, искусственный интеллект, нейронные сети, обратное распространение ошибки, регуляризацияСложности накопления данных для интеллектуального анализа

2012-10-14 в 22:34, admin, рубрики: data mining, анализ, анализ данных, Анализ и проектирование систем, данные, Песочница, метки: data mining, анализ, анализ данных, данные

Аннотация

Данная статья посвящена актуальной на сегодняшний день проблеме сложности накопления данных для проведения интеллектуального анализа. Введены основные понятия: данные и интеллектуальный анализ. Рассмотрены сложности, относящиеся к накоплению данных, при ситуации, когда необходимо разработать базу с нуля и наполнить её данными. Автором предложены рекомендации по снижению риска появления описанных проблем.

Читать полностью »

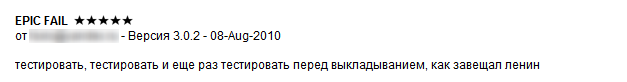

Почему оценкам в App Store не следует доверять

2012-10-09 в 19:25, admin, рубрики: App Store, apple, data mining, анализ, математика, ревью, метки: app store, data mining, анализ, ревью Задумывались ли вы когда-либо над тем, насколько хорошо работает пятизвездочная система оценивания мобильных приложений, скажем, в AppStore? До какой степени количество звезд, полученное тем или иным приложением, является показателем его качества? Почему представленный ниже явно отрицательный отзыв идет с оценкой «5», и насколько часто имеют место подобные случаи «неадекватного» оценивания приложений?

Мы – исследовательское подразделение компании Empatika – сделали попытку ответить на эти вопросы и пришли к неутешительному выводу: пользователи AppStore демонстрируют явно выраженную склонность к более частому выставлению положительных оценок, чем отрицательных, зачастую совершенно не заботясь о соответствии текста своего отзыва выставленному вместе с ним количеству звезд. Этот результат нашего исследования не так давно был опубликован на TechCrunch. О том, как мы пришли к этому выводу – читайте под катом.

Как устроен краткосрочный прогноз на Яндекс.Пробках

2012-10-05 в 7:07, admin, рубрики: data mining, Алгоритмы, Блог компании Яндекс, Геоинформационные сервисы, пробки на дорогах, прогнозирование, яндекс.карты, метки: геоинформационные сервисы, пробки на дорогах, прогнозирование, яндекс карты Информация о пробках появилась на Яндексе в 2006 году. Начинали мы с необходимого — научились строить схему загруженности городских улиц и учитывать текущую ситуацию при прокладывании маршрутов. Автомобилисты, ориентируясь перед выездом на эту информацию, уже могли сэкономить время в пути:

Затем, чтобы помогать водителям непосредственно во время движения, мы добавили в мобильные Яндекс.Карты (и, как следствие, в Яндекс.Навигатор) автоматическое перестроение маршрута. Приложения научились адаптировать маршрут при каждом заметном изменении ситуации в городе.

Собрав на десктопе и в мобильном информацию про «сейчас», мы перешли к решению вопроса «а как будет потом?»:

Первым шагом стала статистическая карта пробок — на ней можно посмотреть, как в среднем стоит и едет город в конкретный час конкретного дня недели. Мы предполагали, что у карты «обычных» пробок может быть полезный побочный эффект — возможность по ним спрогнозировать заторы на ближайшее время. Но практика показала, что усреднённая картина помогает примерно спланировать только, например, завтрашнюю поездку в аэропорт — но не помогает выезжающим сейчас избежать новых пробок. По нашим измерениям, даже в конце часового маршрута картина пробок на момент выезда обычно ближе к фактической, чем усреднение:

Неделю назад на Яндекс.Картах появилась возможность посмотреть изменения пробок в ближайший час — следующий наш шаг в решении вопроса про будущее. Для тех, кто в этом году не смог приехать на Yet another Conference, мы сегодня расскажем, что у нашего прогноза внутри, и как оно там оказалось.

Читать полностью »

Интерактивная HTML5-визуализация по мотивам «Lost»

2012-10-04 в 10:35, admin, рубрики: data mining, html, html5, javascript, визуализация, метки: data mining, html5, визуализация

Поклонник одного из лучших телепроектов последних десяти лет «Затерянные» («Lost») программист Сантьяго Ортиз (Santiago Ortiz) создал прекрасный пример интерактивной визуализации взаимоотношений между главными и второстепенными героями шоу при помощи HTML5.

Сериал создавался силами более 30 сценаристов, которые должны были прорабатывать характеры и взаимоотношения главных героев, создавая при этом реалистичную атмосферу с точки зрения перемещения героев во времени, следить за непротиворечивостью событий, и при этом давать намёки на всевозможные загадки (например, почему Кейт видела в джунглях тёмную лошадь); при этом wiki-проект по мотивам шоу содержит более 7000 статей.

Читать полностью »

NLPub — каталог лингвистических решений

2012-10-01 в 4:37, admin, рубрики: data mining, nlpub, искусственный интеллект, Компьютерная лингвистика, обработка естественного языка, образование, Поисковые машины и технологии, русский язык, сообщество, метки: nlpub, Компьютерная лингвистика, обработка естественного языка, образование, русский язык, сообществоЯ хочу представить NLPub — небольшую базу знаний, посвящённую компьютерной лингвистике в России.

Сейчас никого не удивить устройствами и приложениями, способными понимать и говорить на человеческом языке. В основе таких приложений лежат методы обработки естественного языка, образующие общее направление на стыке лингвистики и искусственного интеллекта.

Почему подавляющее большинство устройств, приложений и сервисов не работает с русским языком?

Читать полностью »

Оптимизация размещения купюр в банкоматах

2012-09-28 в 8:23, admin, рубрики: data mining, банк, банкомат, Блог компании КРОК, деньги, Клиентская оптимизация, логистика, оптимизация, управление проектами, метки: data mining, банк, банкомат, деньги, логистика, оптимизация  Внутри у среднего банкомата лежит от 1 до 3 миллионов рублей. Они разложены по 4 кассетам, в каждой из которых – купюры своего номинала. Замена кассет похожа на замену картриджей в принтере: модуль вынимается (и неважно, сколько там осталось денег — инкассаторы этого даже не знают по правилам безопасности), а на его место вставляется другой модуль точно по стрелке, указывающей, какой стороной и как это делать.

Внутри у среднего банкомата лежит от 1 до 3 миллионов рублей. Они разложены по 4 кассетам, в каждой из которых – купюры своего номинала. Замена кассет похожа на замену картриджей в принтере: модуль вынимается (и неважно, сколько там осталось денег — инкассаторы этого даже не знают по правилам безопасности), а на его место вставляется другой модуль точно по стрелке, указывающей, какой стороной и как это делать.

Инкассация — дорогая и достаточно рискованная с точки зрения безопасности процедура, поэтому любое обслуживание банкомата обходится довольно дорого. Естественное желание банка – уменьшить количество инкассаций. Получается классическая задача распределения ресурсов: с одной стороны, в банкомате всегда должны быть деньги для клиентов, с другой — в идеале банк хочет, чтобы ровно перед инкассацией из ящика уходила последняя купюра. Читать полностью »

Вторая встреча Kharkov AI Club

2012-09-25 в 12:56, admin, рубрики: ciklum, data mining, event, искусственный интеллект, метки: ciklum, data mining, eventВсем привет!

Приглашаем всех на вторую встречу Kharkov AI Club, которую мы планируем провести в несколько необычном формате.

Сначала мы послушаем доклад Андрея Бабия “Машинное обучение. Распознавание рукописных цифр”. Доклад будет посвящен одному из методов машинного обучения распознаванию цифр. Для примера будет использовано одно из соревнований по интеллектуальному анализу данных сайта Kaggle www.kaggle.com/c/digit-recognizer. В докладе будут рассмотрены особенности подготовки данных, метод распознавания и идеи по его улучшению.

Стоит ли платить за Apache Hadoop?

2012-09-07 в 12:42, admin, рубрики: apache hadoop, big data, data mining, java, метки: apache hadoop

В 2010 году Apache Hadoop, MapReduce и ассоциированные с ними технологии привели к распространению нового явления в сфере информационных технологий, названного «большими данными» или «Big Data». Понимание того, что из себя представляет платформа Apache Hadoop, зачем она нужна и для чего её можно использовать потихоньку проникает в умы специалистов по всему миру. Зарожденный, как идея одного человека, и быстро выросший до промышленных масштабов, Apache Hadoop стал одной из самых широко обсуждаемых платформ для распределенных вычислений, а также платформой для хранения неструктурированной или слабо структурированной информации. В этой статье я хотел бы подробнее остановиться на самой платформе Apache Hadoop и рассмотреть коммерческие реализации, предоставляемые сторонними компаниями, и их отличия от свободно распространяемой версии Apache Hadoop.Читать полностью »

Коллаборативная фильтрация

2012-08-28 в 18:41, admin, рубрики: big data, collaborative filtering, data mining, python, Алгоритмы, метки: collaborative filtering, data mining, pythonВ современном мире часто приходится сталкиваться с проблемой рекомендации товаров или услуг пользователям какой-либо информационной системы. В старые времена для формирования рекомендаций обходились сводкой наиболее популярных продуктов: это можно наблюдать и сейчас, открыв тот же Google Play. Но со временем такие рекомендации стали вытесняться таргетированными (целевыми) предложениями: пользователям рекомендуются не просто популярные продукты, а те продукты, которые наверняка понравятся именно им. Не так давно компания Netflix проводила конкурс с призовым фондом в 1 миллион долларов, задачей которого стояло улучшение алгоритма рекомендации фильмов (подробнее). Как же работают подобные алгоритмы?

В данной статье рассматривается алгоритм коллаборативной фильтрации по схожести пользователей, определяемой с использованием косинусной меры, а также его реализация на python.