Три года я был эстонским пивоваром: придумывал рецепты и сам варил. Когда начал изучать Python, SQL и анализ данных, понял, что между подготовкой данных и подготовкой сусла много общего: оказывается, в цеху я занимался DS, но не подозревал об этом. Меня зовут Алексей Гаврилов, я сеньор дата-аналитик в ретейле. В этой статье расскажу, чем пивоварение и аналитика данных похожи изнутри.

Рубрика «data engineering» - 2

Анализировать данные — это как варить пиво. Почему дата-анализ и пивоварение — одно и то же с техноизнанки

2023-06-23 в 7:53, admin, рубрики: big data, data engineering, data mining, анализ данных, Блог компании IT-guide, пивоварениеНовые инструменты для работы c ML-моделями и обзор MLOps от CERN

2023-05-26 в 10:19, admin, рубрики: big data, data engineering, mlops, Блог компании Selectel, ит-инфраструктура, машинное обучение

Привет всем, кто работает с ML-моделями и занимается аналитикой данных! В новом дайджесте для вас много интересных обзоров по инструментам — как говорится, ни ClearML и Airflow едиными. Рынок решений стремительно развивается, и наши подборки помогут вам держать руку на пульсе. Еще больше полезных текстов по DataOps и MLOps публикуем в Telegram-сообществе «MLечный путь».

Как вам, кстати, ренессансная GPU на обложке, которую сгенерила нейросеть для блога Andreesen and Horowitz? Что тут сказать — просто поделитесь промтом.

Читать полностью »

Консолидация баз данных: этапы, методы и примеры

2023-05-02 в 9:00, admin, рубрики: data engineering, etl, ruvds_статьи, Администрирование баз данных, базы данных, Блог компании RUVDS.com, виртуализация данных, консолидация баз данных, хранение данных, хранилище данных

Сейчас во всём мире объёмы данных растут с невероятной скоростью, и чтобы эффективно использовать их потенциал, требуется правильное хранение и управление информацией. Одним из наиболее эффективных способов решения этой проблемы является консолидация баз данных. Но что это такое и как её правильно реализовать? В этой статье мы разберёмся, какую пользу может принести консолидация баз данных и как её провести на практике. Если вы хотите оптимизировать свою работу с данными, то эта статья для вас!Читать полностью »

Как упростить анализ данных? Запуск и сценарии использования готовой виртуальной машины для аналитики

2023-03-31 в 10:30, admin, рубрики: big data, data engineering, mlops, анализ данных, Блог компании Selectel, машинное обучение

Походы — вещь непредсказуемая. Обычно полезная нагрузка распределяется между всеми участниками, но всегда вмешивается элемент случайности или забывчивости. В таких ситуациях выручает швейцарский нож, который гарантирует, что минимальные потребности группы будут удовлетворены. С помощью такого ножа можно и консервы открыть, и бинт разрезать, но главное — он экономит место в рюкзаке.

Небольшой команде, которая работает с ML-моделями и анализом данных, тоже хочется иметь готовое решение базовых задач. Собирать его самостоятельно из отдельных компонентов не всегда удобно, а еще это бывает дорого. Вот бы существовало какое-то компактное решение, в котором сразу был бы весь набор инструментов и настроек. Что ж, усаживайтесь у костра поудобнее, пришло время рассказать про Data Analytics Virtual Machine (DAVM).

Читать полностью »

«Midjourney на коленке». Как развернуть нейросеть в облаке за 5 минут, или начало работы с Diffusers

2023-03-24 в 13:01, admin, рубрики: dalle, data engineering, data science, jupiter, machine learning, midjourney, selectel, stable diffusion, Блог компании Selectel, будущее здесь, искусственный интеллект, машинное обучение

Построить свою конвейерную ленту по разработке нейронок не так сложно. Нужен «всего лишь» сервер с GPU и настроенное окружение с библиотекой Diffusers. Если вам интересно, что это такое, как создать свою «Midjourney на коленке» и генерировать вайф в режиме 24/7, добро пожаловать под кат!

Читать полностью »

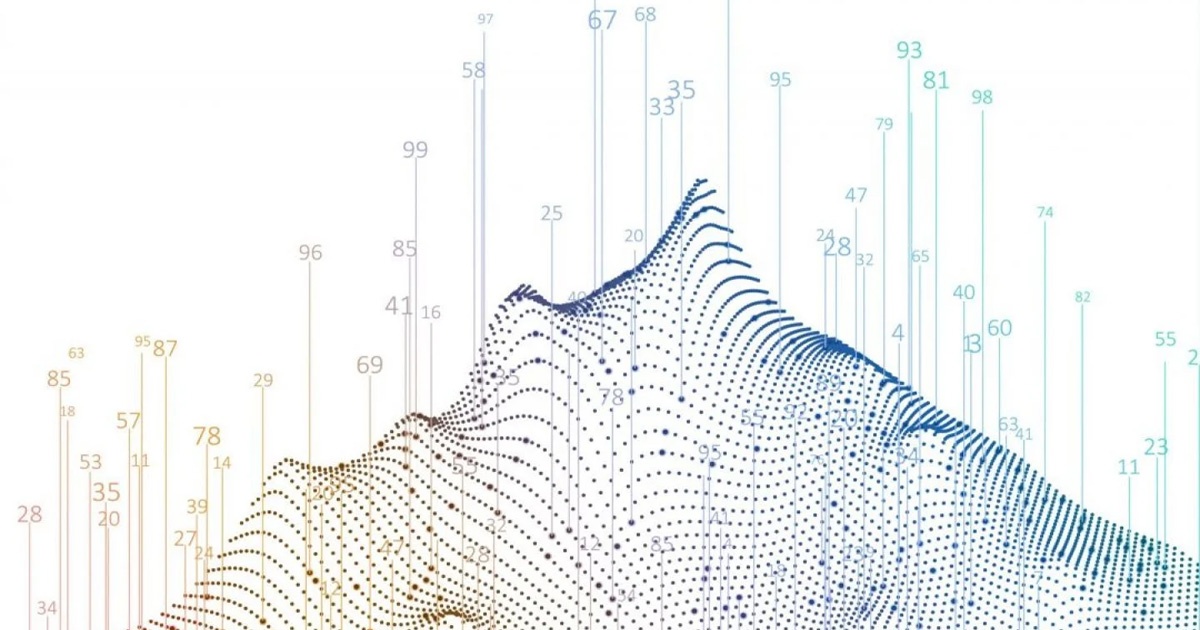

Полезные материалы по Data Science и машинному обучению, которые помогут пройти сквозь джунгли из терминов

2023-03-21 в 14:21, admin, рубрики: data engineering, data science, selectel, аналитика данных, Блог компании Selectel, искусственный интеллект, математика, машинное обучение, подборка

Привет! Меня зовут Ефим, я MLOps-инженер в Selectel. В прошлом был автоматизатором, ML-инженером, дата-аналитиком и дата-инженером — и уже несколько лет падаю в пропасть машинного обучения и Data Science. Это буквально необъятная сфера, в которой почти нет ориентиров. Основная проблема в том, что разделов математики довольно много и все они, на первый взгляд, нужны в том же машинном обучении.

В этой статье делюсь полезными материалами, которые помогут найти и заполнить теоретические и практические проблемы и основательно подойти к своему профессиональному развитию. Добро пожаловать под кат!

Читать полностью »

Большие данные мертвы. Это нужно принять

2023-03-02 в 14:02, admin, рубрики: big data, data engineering, firstvds, Google, базы данных, Блог компании FirstVDS, вычисления, Облачные вычисления, хранилищаПрощай, Data Science

2022-12-14 в 5:15, admin, рубрики: data engineering, data science, дата-инженер, Карьера в IT-индустрии, карьера ИТ-специалиста, математика

Это по большей мере личный пост, а не какое-то глубокое исследование. Если вам нужны какие-то выводы, то здесь вы их не найдёте. Откровенно говоря, я даже не знаю, кто его целевая аудитория (возможно «дата-саентисты, которые себя ненавидят»?).

Последние несколько лет я был дата-саентистом, но в 2022 году получил новую должность дата-инженера, и пока я ею вполне доволен.

Я по-прежнему работаю вместе с «дата-саентистами» и немного продолжаю заниматься этой сферой, но вся моя работа по «data science» заключается в руководстве и консультировании по чужой работе. Я в большей степени занимаюсь реализацией data science (MLOps) и дата-инжинирингом.

Основная причина разочарования в data science заключалась в том, что работа казалась несущественной, во многих смыслах этого слова «неважной»:

- Работа — это непрекращающийся поток разработки, продукта и офисной политики, поэтому часто так бывает, что работа хороша настолько, насколько хорошо самое слабое звено в цепи.

- Никто не знал, в чём заключается разница между плохой и хорошей работой в data science, да никого это и не волновало. Это значит, что вы можете быть абсолютным неудачником или гением в ней, но в любом случае получите примерно одинаковое признание.

- Работа часто приносила очень малую пользу бизнесу (часто компенсируя некомпетентность выше по цепочке управления).

- Когда польза от работы превышала затраты на оплату труда, часто это не давало внутренней отдачи (например, настройка параметра, чтобы бизнес зарабатывал больше денег).

Превью профессии «говорящий с нейросетями»

2022-12-04 в 14:26, admin, рубрики: C, c++, data engineering, будущее, будущее наступило, нейросеть, ненормальное программирование, Программирование, С++Все уже слышали, что openAI выпустили в свет свою новую нейросеть-асистента, так что я решил попробовать на что она способна и описать свой опыт взаимодействия с этим.. Этой... Сущностью.

Разговор будет вестись как с человеком в вежливой форме, так как оказалось, что нейросеть очень хорошо запоминает = )

Начнём с чего-то простого, попросим сгенерировать на языке CMake простую программу

2003–2023: Краткая история Big Data

2022-12-04 в 10:00, admin, рубрики: Apache, AWS, big data, data engineering, GCP, Hadoop, Microsoft Azure, ruvds_перевод, spark, sql, Блог компании RUVDS.com, Большие данные, хранилища данных

Когда, играя в ту или иную RPG, я оказываюсь в библиотеке, то обязательно перечитываю все книги на полках, чтобы лучше вникнуть во вселенную игры. Помнит кто-нибудь «Краткую историю империи» в Morrowind?

Большие данные (Big Data) и, в частности, экосистема Hadoop появились немногим более 15 лет назад и развились к сегодняшнему дню так, как мало кто мог тогда предположить.

Ещё только появившись, опенсорсный Hadoop сразу стал популярным инструментом для хранения и управления петабайтами данных. Вокруг него сформировалась обширная и яркая экосистема с сотнями проектов, и он до сих пор используется многими крупными компаниями, даже на фоне современных облачных платформ. В текущей статье я опишу все эти 15 лет1 эволюции экосистемы Hadoop, расскажу о её росте в течение последнего десятилетия, а также о последних шагах в развитии сферы больших данных за последние годы.

Так что пристегнитесь и настройтесь на путешествие во времени вглубь 20 последних лет, поскольку наша история начинается в 2003 году в маленьком городке к югу от Сан-Франциско…

Дисклеймер: изначально я планировал оформить статью логотипами упоминаемых в ней компаний и программ, но на TDS запрещено обширное использование логотипов, поэтому я решил украсить содержание случайными изображениями и справочной информацией. Весело вспоминать, где мы в те времена находились и чем занимались.