Большинство ПО кластерных систем предполагает наличие файловой системы доступной со всех узлов кластера. Эта файловая система используется для хранения ПО, данных, для организации работы некоторых кластерных подсистем и т.д. Требования на производительность такой FS могут сильно отличаться для разных задач, однако, чем она выше, тем считается, что кластер более устойчив и универсален. NFS сервер на мастер-узле является минимальным вариантом такой FS. Для больших кластеров NFS дополняется развертыванием LustreFS — высокопроизводительной специализированной распределенной файловой системы, использующей несколько серверов в качестве хранилища файлов и несколько метаинформационных серверов. Однако такая конфигурация обладает рядом свойств, которые сильно затрудняют работу с ней в случае, когда клиенты используют независимые виртуализированные кластера. В системе HPC HUB vSC для создания разделяемой FS используется широко известное решение CEPH и файловая система GFS2.

Читать полностью »

Рубрика «ceph» - 4

Создание разделяемого хранилища на базе CEPH RBD и GFS2

2016-10-14 в 9:33, admin, рубрики: big data, ceph, gfs2, HPC, lustrefs, nfs, open source, openstack, storage, Блог компании HPC HUB, высокая производительность, параллельное программированиеВиртуальный суперкомпьютер по требованию

2016-09-18 в 12:37, admin, рубрики: big data, ceph, cloud, HPC, openstack, высокая производительность, Геоинформационные сервисы, параллельное программирование

Виртуальный суперкомпьютер (vSC) — это современная альтернатива для наукоемкого бизнеса и научных групп при решении ресурсоемких задач. В процессе бурного развития облачных технологий клаудизация все активнее проникает в наиболее консервативные и сложные IT-сферы, например, суперкомпьютинг и распределенные вычисления. Один из таких подходов в области клаудизации HPC реализован компанией HPC HUB.

Геораспределенный s3-кластер в режиме active-active

2016-05-24 в 9:52, admin, рубрики: ceph, rados gateway, администрирование, гайд, кластеризация, облачные хранилище, руководство, системное администрирование, хранение данных

Предисловие

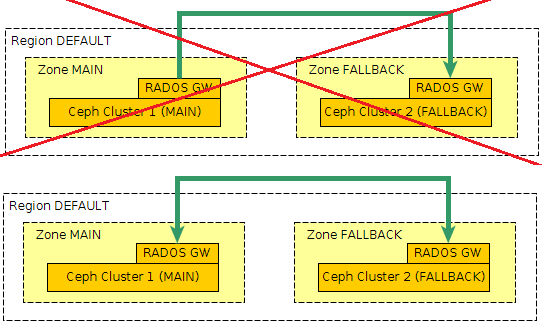

Начав настраивать в rados геораспределенную репликацию, столкнулся с проблемой, что официальная документация немного не подходит под новый мажорный релиз jewel, да и в интернете пока еще нет актуальных инструкций. Данный мануал сбережет много времени тем, кто захочет себе небольшое, свое геораспределенное s3-облако.

Читать полностью »

Объектное хранилище NetApp StorageGrid

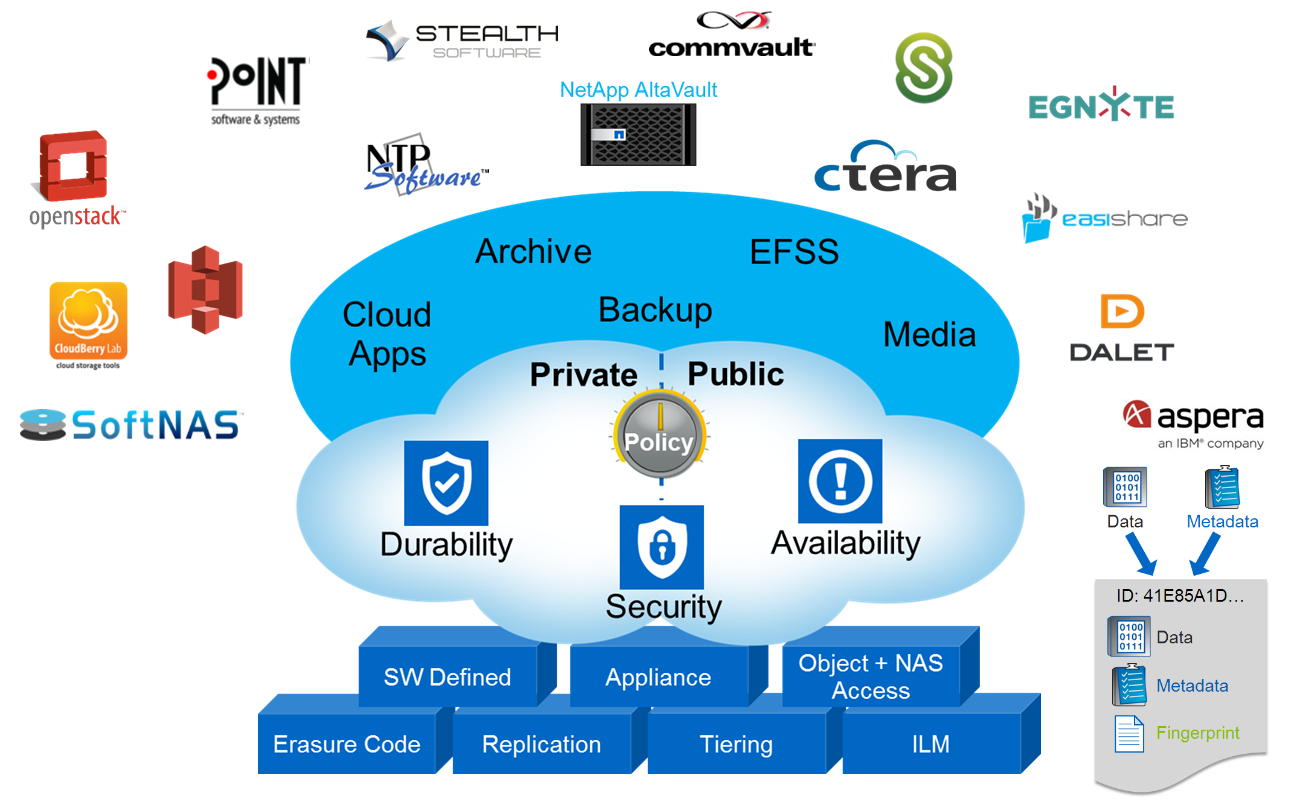

2016-05-10 в 13:18, admin, рубрики: AltaVault, amazon, Amazon CloudFront, amazon s3, archive, backup, big data, blob, CDMI, ceph, CIFS, cinder, Citrix Sharefile, cloudfront, Commvault, Ctera, DDP, docker, Dynamic Disk Pools, E-Series, Egnyte, Erasure Coding, File share, File sync, Geo-EC, glance, Inktank, Inktank Ceph, kilo, kvm, NAS, NetApp, NetApp AltaVault, NetApp E-Series, NetApp StorageGrid, nfs, NTP software, object storage, OpenStack Heat, OpenStack Kilo, raid, RESTful HTTP, s3, SCSI, SGAPI, smb, SoftNAS, stealth, StorageGrid, swift, Swift API, Symantec Enterprise Vault, Анализ и проектирование систем, ит-инфраструктура, системное администрирование, хранение данных В этой статье я отклонюсь от традиционной для меня темы систем хранения FAS и подниму тему объектного хранения данных в системах NetApp StorageGrid WebScale. Если кратко, то объектное хранение — это третий тип хранения наряду с NAS и SAN. Представьте себе, что каждый файл состоит из данных и метаинформации (владелец, права, время модификации и т.д.), так вот объектное хранение позволяет разъединить эти части и хранить их в виде «ключ/значение». Такой подход хранения информации открывает возможности децентрализованного, распределённого хранения данных огромных масштабов с прозрачной миграцией данных, репликацией и прозрачным переключением конечных потребителей между нодами объектного кластера. В широком смысле объектное хранилище может быть реализовано как на уровне устройства (жесткого диска), при помощи специализированных SCSI команд (Object-based Storage Device Commands), так и на уровне протокола доступа к системе хранения, которая состоит из нескольких дисков (которые, в свою очередь, вовсе не обязаны быть объектными). В обоих случаях используется Ethernet для подключения и IP протокол для передачи данных. Примером реализации объектного хранилища на уровне устройства являются жесткие диски линейки Seagate Kinetic Open Storage platform. Примером систем хранения данных в облаке может быть Microsoft Azure BLOB, Amazon S3. В этой статье я остановлюсь на объектных СХД, которые можно развернуть у себя на сайте и при необходимости подключить к облаку.

Читать полностью »

CEPH-кластер: хронология работ по апгрейду нашего файлового хранилища на новую архитектуру (56Gb-s IB)

2016-02-11 в 6:36, admin, рубрики: ceph, s3, SDS, Блог компании КРОК, виртуализация, высокая производительность, ит-инфраструктура, кластер, облако, СХД, хранение, хранение данных

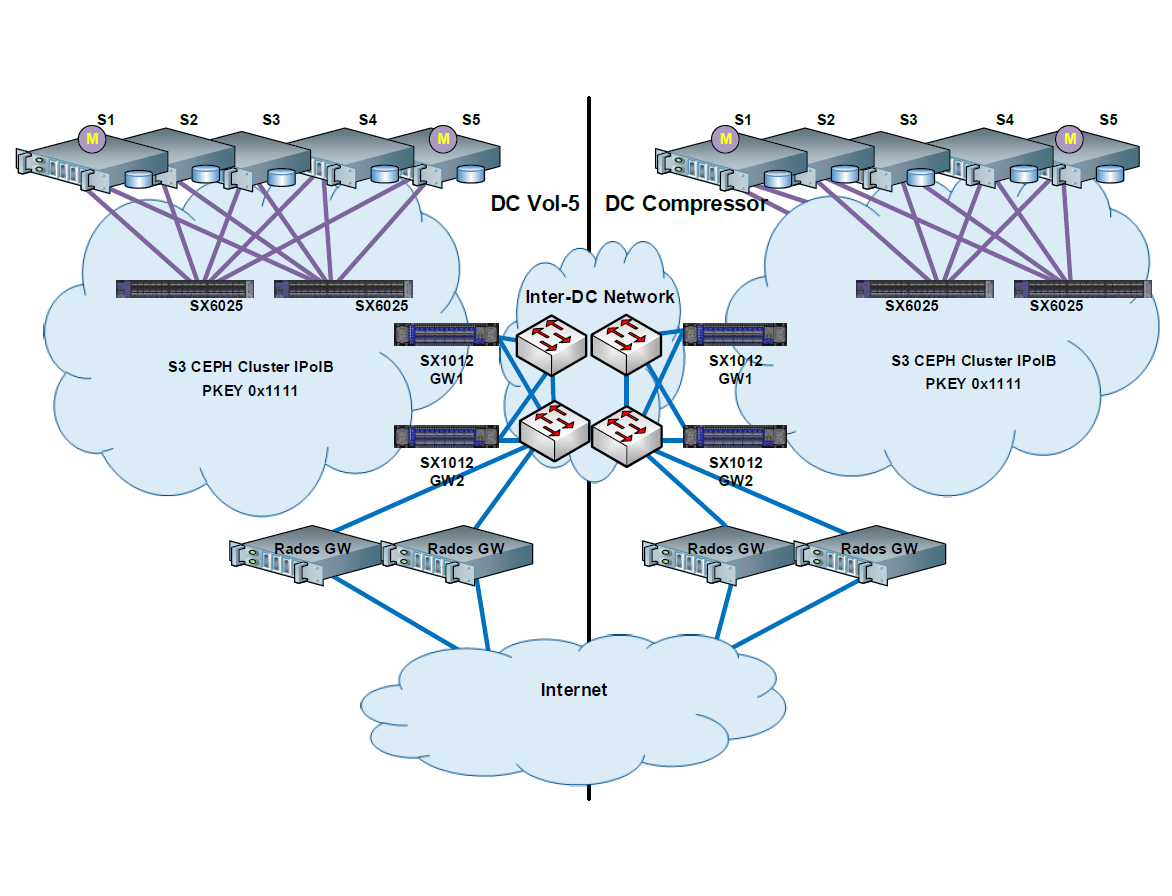

Запустив наше облако, мы стали предоставлять сервис хранения, аналогичный S3 Амазона (с совместимым API, чтобы российские заказчики могли использовать стандартные клиенты для работы с S3, изменив только endpoint для подключения). Основная задача сервиса — хранение снапшотов виртуальных машин и различных файлов клиентов. Амазон был взят за образец, куда надо развиваться, и в начале 2014 года стало понятно, что имеющееся файловое хранилище устарело, заказчики требовали современных фичей, недоступных у нас и так нравящихся им у AWS. Но доработка существующего решения светила огромными трудозатратами, поэтому было принято решение построить новое S3-совместимое хранилище с нуля.

Дальше — долгий процесс поиска и сравнений имеющихся решений, потом тесты на производительность и отказоустойчивость решения, написание кипы бумаг, затем — несколько неудачных тестовых миграций, исправления багов в архитектуре, работа над полученными ошибками и итоговая фоновая онлайн-миграция всех данных через два месяца работы.

Это было чертовски долго, но всё прошло спокойно.Читать полностью »

Fujitsu ETERNUS CD10000: Ceph без забот

2015-02-26 в 12:32, admin, рубрики: CD10000, ceph, crush, ETERNUS, ETERNUS CD10k, Fujitsu, openstack, RADOS, Блог компании Fujitsu, ит-инфраструктура, Серверное администрирование, СХДСегодня многие компании работают с огромным количеством данных. Нет, я сейчас не о паттернах BigData, а просто о том, что удивить десятком-другим терабайт данных на серверах отдельно взятой компании никого уже нельзя. Но многие идут дальше – сотни терабайт, петабайты, десятки петабайт… Конечно, хорошо, когда ваши данные и задачи по их обработке попадают под идеологию mapreduce, но намного чаще все эти данные представляют собой либо «просто файлы», либо тома виртуальных машин, либо уже структурированные и шардированные своим образом данные. В таких случаях компания приходит к идее необходимости развертывания системы хранения данных.

Добавляет популярности СХД сегодня и системы, подобные OpenStack – ведь приятно управлять своими серверами не заботясь о том, что в одном сервере не работает диск, что одна из стоек обесточена. Не заботиться о том, что железо на одном Самом Важном Сервере устарело и для его апгрейда необходимо деградировать ваши сервисы до минимального уровня. Конечно, такие случаи могут быть ошибкой проектирования, но будем честны – все мы можем допустить такие ошибки.

В итоге компания встаёт перед непростым выбором: создать СХД самостоятельно на основе открытого ПО (Ceph, MuseFS, hdfs – есть из чего выбрать с минимальными затратами на интеграцию, но придется потратить время на дизайн и развертывание) или купить готовую проприетарную СХД и потратить время и силы на её интеграцию (с риском того что СХД со временем достигнет лимита своей ёмкости или производительности).

Но что если взять за основу Ceph, для которого сложно придумать невыполнимую задачу в области хранения данных, заручиться поддержкой какого-нибудь Ceph-вендора (например Inktank, которые его и создали), взять современные серверы с большим количеством SAS-дисков, написать web-интерфейс для управления, добавить дополнительные возможности для эффективного развертывания и мониторинга… Звучит заманчиво, но сложно для среднестатистической компании, тем более, если это не IT-компания.

К счастью, обо всём этом уже позаботились в компании Fujitsu, в лице продукта ETERNUS CD10000 – первой enterprise-СХД, основанной на Inktank Ceph Enterprise, с которой мы вас сегодня и познакомим.

Читать полностью »

Сборка и установка пакетов системы мониторинга Calamari для распределенного хранилища CEPH 0.87 на Ubuntu 14.04.1 (Trusty Tahr)

2014-12-19 в 8:19, admin, рубрики: calamari, ceph, ubuntu 14.04 lts, Настройка Linux, сборка пакетов, системное администрированиеДано: существующий кластер CEPH 0.87. Задача: обеспечить мониторинг. Задача № 2: Написать инструкцию (попроще).

Я погуглил и нашел Calamari. Покопал дальше и нашел несколько статей на английском по сборке и установке. Попробовал поставить, наступил на несколько «граблей». В результате пришел к написанию этой статьи.

Отмечу, что пакеты, собранные в результате, вряд ли полностью соответствует debian-policy по сборке deb-пакетов. Обеспечить мониторинг важнее.

Читать полностью »

Пять дней + двенадцать авторов + один книжный спринт = одна отличная книга по архитектуре OpenStack

2014-08-14 в 11:39, admin, рубрики: ceph, openstack, virtualbox, VMware, мирантисАвтор: Ник Чейз

Отличительной особенностью OpenStack является то, что можно найти много информации о том, как выполнять конкретные действия, например, запустить инстанс или установить тестовое облако на VirtualBox. Однако информации, которая даст вам общее представление, например, о том, как спроектировать массово масштабируемое облако на базе OpenStack или облако, оптимизированное под предоставление потокового контента, не так много. Читать полностью »

Автоматизация тестовой инфраструктуры в Поиске

2014-03-13 в 13:22, admin, рубрики: ceph, chef, openstack, vagrant, veewee, Блог компании Mail.Ru Group, визуализация данных, тестирование, метки: ceph, chef, openstack, vagrant, veewee Не секрет, что задачи тестирования, как ручного, так и автоматизированного, постоянно требуют создания новых тестовых стендов.

Для того чтобы автотесты Поиска Mail.Ru выполнялись быстро и во всех необходимых окружениях, нам потребовалось научиться быстро разворачивать новые виртуальные машины с определенной конфигурацией.

Большое количество виртуальных машин в нашем облаке используется браузерной фермой WebDriver, масштабируя её, мы ускоряем выполнение тестов web-интерфейса Поиска.

Кроме этого, на виртуалках мы запускаем инструменты для сбора метрик качества кода и измерения покрытия, а также инструменты для тестирования Поиска, разработанные нами.

Интервью с Джульеном Данжу, руководителем проекта OpenStack Ceilometer

2013-08-09 в 19:10, admin, рубрики: ceilometer, ceph, Debian, havana, iaas, open source, openstack, python, Quantum, Блог компании Mirantis/OpenStack, мирантисМы представляем пятое из серии интервью с техническими руководителями проекта OpenStack в блоге Mirantis. Наша цель — обучить более широкое сообщество технических специалистов и помочь людям понять, как они могут внести вклад в проект OpenStack и извлечь из него выгоду. Естественно, ниже изложена точка зрения интервьюируемого, а не компании Mirantis.

Ниже мы представляем интервью Джульена Данжу (Julien Danjou), технического руководителя проекта OpenStack Ceilometer.Читать полностью »