В процессе настройки нового кластера на Ceph Luminous появилась задача разнести разные S3 бакеты по разным устройствам хранения (в моем случае SSD и HDD). В интернете много инструкций как это сделать в Ceph Jewel, но в случае с Luminous процесс претерпел большие изменения и старые инструкции больше не работают. Вместе с тем, что в офф документации этот сценарий не описан, процесс настройки становится не слишком тривиальным.

Читать полностью »

Рубрика «ceph» - 3

Разносим S3 бакеты по разным пулам в Ceph Luminous

2018-03-23 в 15:45, admin, рубрики: ceph, luminous, object storage, radosgw, s3, Настройка Linux, системное администрирование, хранение данных, хранилища данныхТем временем Proxmox VE обновился до версии 5.0

2017-07-06 в 9:42, admin, рубрики: ceph, kvm, lxc, proxmox, proxmox 5, proxmox ve, zfs, виртуализация, системное администрирование, хранение данных Громкой эту новость не назвать, но парни, который год «пилящие» Proxmox VE, два дня назад выпустили новую версию своего детища — 5.0.

Громкой эту новость не назвать, но парни, который год «пилящие» Proxmox VE, два дня назад выпустили новую версию своего детища — 5.0.

Нас, конечно, интересуют изменения — тянут ли они на новую major версию. На мой взгляд, вполне, а подробности, по традиции, под катом.

(Для тех, кому слова Proxmox VE не знакомы, приведу пару слов описания: «Proxmox Virtual Environment (Proxmox VE) — система виртуализации с открытым исходным кодом, основанная на Debian GNU/Linux. В качестве гипервизоров использует KVM и LXC. Управление виртуальными машинами и администрирование самого сервера производятся через веб-интерфейс либо через стандартный интерфейс командной строки Linux.»)

Читать полностью »

Распределённые вычисления поверх Ceph RADOS и AsyncMessenger

2017-06-14 в 15:14, admin, рубрики: AcyncMessenger, BlueFS, BlueStore, ceph, ConnectedSocket, epoll, librados, Lua, NetworkStack, RADOS, rocksdb, ServerSocket, высокая производительность, Разработка под Linux, системное программирование, Системы обмена сообщениямиПеремещение вычислений в сторону данных может приводить к снижению временных затрат на порядки за счёт исключения необходимости перемещения самих данных в сетевой среде. Этой цели служит класс RADOS, вызовы к которому могут выполняться функциями librados.

Асинхронная система сообщений существенно снижает накладные расходы сетевого уровня Ceph, а применение абстракций NetworkStack делает возможной реализацию различных протоколов стека (POSIX/ SPDK/ DPDK/ RDMA).

Читать полностью »

Создаём постоянное хранилище с provisioning в Kubernetes на базе Ceph

2017-05-29 в 6:45, admin, рубрики: ceph, devops, kubernetes, linux, provisioning, rbd, Блог компании Флант, Серверное администрирование, системное администрирование, хранилища, хранилища данных

Предисловие переводчика: Когда мы собрались наконец-то подготовить свой материал по разворачиванию Ceph в Kubernetes, нашли уже готовую и, что немаловажно, свежую (от апреля 2017 года) инструкцию от компании Cron (из Боснии и Герцеговины) на английском языке. Убедившись в её простоте и практичности, решили поделиться с другими системными администраторами и DevOps-инженерами в формате «как есть», лишь добавив в листинги один небольшой недостающий фрагмент.

Программно-определяемые хранилища данных набирают популярность последние несколько лет, особенно с масштабным распространением частных облачных инфраструктур. Такие хранилища являются критической частью Docker-контейнеров, а самое популярное из них — Ceph. Если хранилище Ceph уже используется у вас, то благодаря его полной поддержке в Kubernetes легко настроить динамическое создание томов для хранения (volume provisioning) по запросу пользователей. Автоматизация их создания реализуется использованием Kubernetes StorageClasses. В этой инструкции показано, как в кластере Kubernetes реализуется хранилище Ceph.Читать полностью »

CEPH на прокачку

2017-03-20 в 11:50, admin, рубрики: ceph, Блог компании AT Consulting, Серверное администрирование

Примерно так выглядит первая инсталляция CEPH на реальном железе.

Вы установили цеф, но он тормозит и падает непонятно почему? Тогда вы пришли по адресу! Я прокачаю ваш CEPH.

Читать полностью »

Кластер хранилища Ceph на VMWare за 10 минут

2017-03-17 в 5:00, admin, рубрики: ceph, linux, SAN, децентрализованные сети, Облачные вычисления, облачные хранилища, системное администрирование, СХД, хранение данных

Этот мануал написан для желающих попробовать гибкость и удобство распределенного файлового хранилища Ceph в виртуальной среде на домашнем ПК. Сразу поясню, что 10 минут — это время на разворачивание самого кластера (установка и настройка Ceph на виртуальных машинах). Но на создание и клонирование виртуальных машин и на установку ОС потребуется отдельное время.

К концу статьи у нас будет виртуальный кластер из трех машин, и сам ПК с Windows в качестве клиента хранилища. Следом мы скинем туда фотографии котиков, уроним одну ноду, потом поднимем, уроним другую, скачаем обратно фотографии котиков, обрадуемся.

Кто еще не в теме Ceph, можно прочитать вводную статью Знакомство с Ceph в картинках и посмотреть модное промо от производителя.

Оптимизация OSD Ceph на SSD- NVMe

2017-03-15 в 12:59, admin, рубрики: ceph, crush, NVMe, OSD, proxmox ve, SAN, ssd, децентрализованные сети, Облачные вычисления, хранилища данных, метки: OSDЧтобы полностью использовать полосу пропускания SAS/SATA SSD или NVMe, они должны расщепляться примерно между 5 (для SAS SSD).

Для включения такой возможности вам необходимо удалить OSD, созданные на этих SSD при установке, разделить каждый SSD на пять разделов и создать на них OSD.

Рассмотрим случай с 4мя хостами, каждый из которых имеет 6 дисков Intel s3610 1.6ТБ SSD. Последовательность действий такова:

Читать полностью »

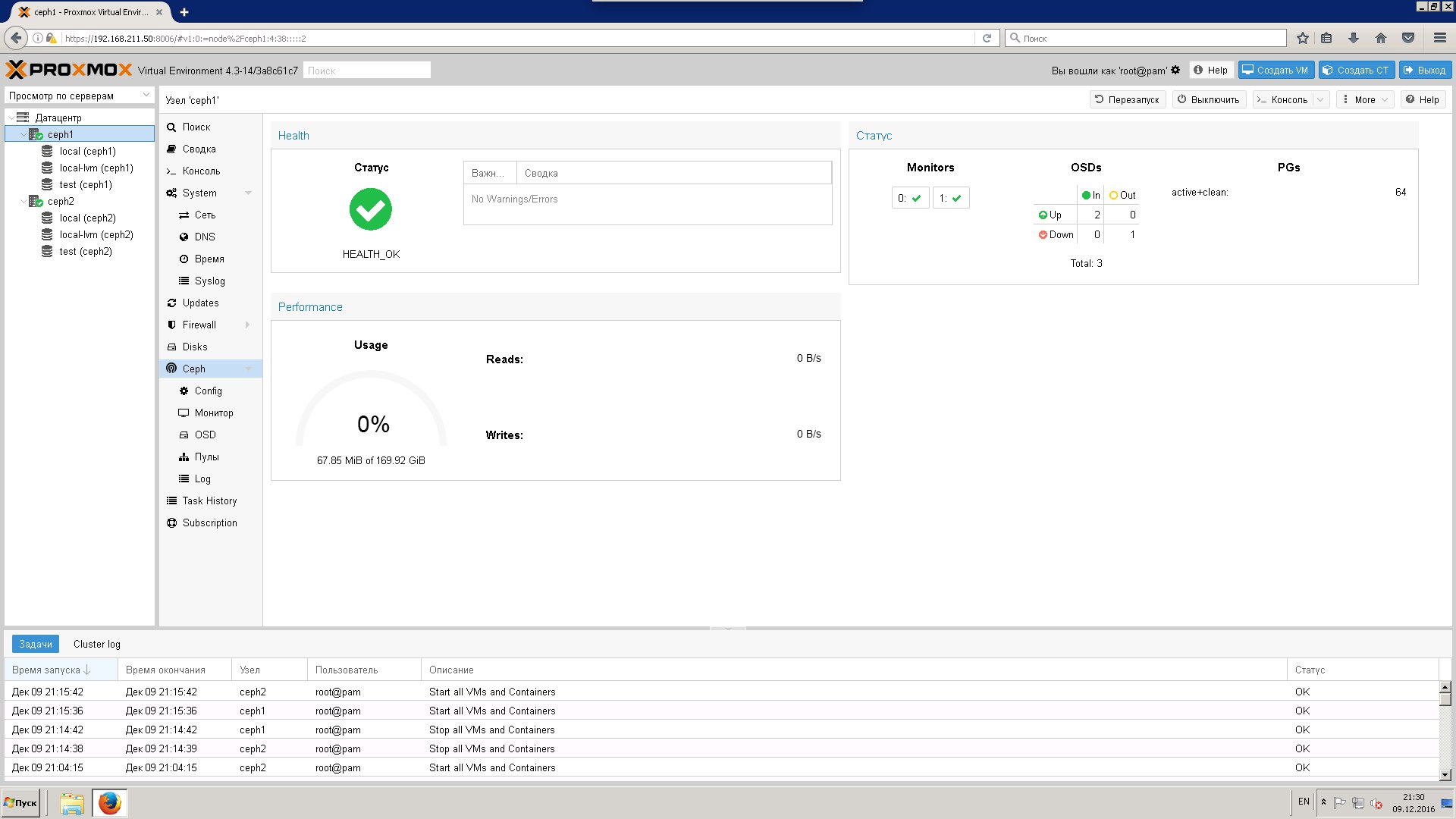

Ceph в ProxMox на ZFS

2016-12-27 в 8:53, admin, рубрики: ceph, linux, proxmox, zfs, виртуализация, ит-инфраструктура, Серверное администрирование, хранилища данныхВ своей работе (системный администратор) приходится всегда искать вещи и знания, уникальные для своего региона. Одной из таких вещей в нашей конторе является ProxMox, поставленный на файловой системе ZFS, позволяющей использовать неплохой raid массив без использования железных контроллеров. Однажды, думая, чем можно еще удивить и порадовать клиентов, мы решили всё это водрузить на распределенную файловую систему Ceph. Не знаю уж, насколько было такое решение адекватным, но я решил воплотить желание в жизнь. И тут понеслась… Я перелопатил горы статей и форумов, но так и не нашел одного адекватного мануала, описывающего в подробностях что и как делать, поэтому, справившись со всем, родилась эта статья, кому интересно, добро пожаловать под кат.

Знакомство с хранилищем Ceph в картинках

2016-11-03 в 4:10, admin, рубрики: ceph, linux, SAN, децентрализованные сети, Облачные вычисления, облачные хранилища, системное администрирование, СХД, хранение данныхОблачные файловые хранилища продолжают набирать популярность, и требования к ним продолжают расти. Современные системы уже не в состоянии полностью удовлетворить все эти требования без значительных затрат ресурсов на поддержку и масштабирование этих систем. Под системой я подразумеваю кластер с тем или иным уровнем доступа к данным. Для пользователя важна надежность хранения и высокая доступность, чтобы файлы можно было всегда легко и быстро получить, а риск потери данных стремился к нулю. В свою очередь для поставщиков и администраторов таких хранилищ важна простота поддержки, масштабируемость и низкая стоимость аппаратных и программных компонентов.

Знакомьтесь: Ceph

Ceph — это программно определяемая распределенная файловая система с открытым исходным кодом, лишенная узких мест и единых точек отказа, которая представляет из себя легко масштабируемый до петабайтных размеров кластер узлов, выполняющих различные функции, обеспечивая хранение и репликацию данных, а также распределение нагрузки, что гарантирует высокую доступность и надежность. Система бесплатная, хотя разработчики могут предоставить платную поддержку. Никакого специального оборудования не требуется.

При выходе любого диска, узла или группы узлов из строя Ceph не только обеспечит сохранность данных, но и сам восстановит утраченные копии на других узлах до тех пор, пока вышедшие из строя узлы или диски не заменят на рабочие. При этом ребилд происходит без секунды простоя и прозрачно для клиентов.

Как мы отказоустойчивый кластер запускали

2016-11-01 в 6:57, admin, рубрики: ceph, vmmanager cloud, виртуализация, ит-инфраструктура, кластер, Облачные вычисления, хостинг

Ошибки и сложности, с которыми мы столкнулись, запуская собственный кластер на базе VMmanager Cloud + Ceph. Читать полностью »