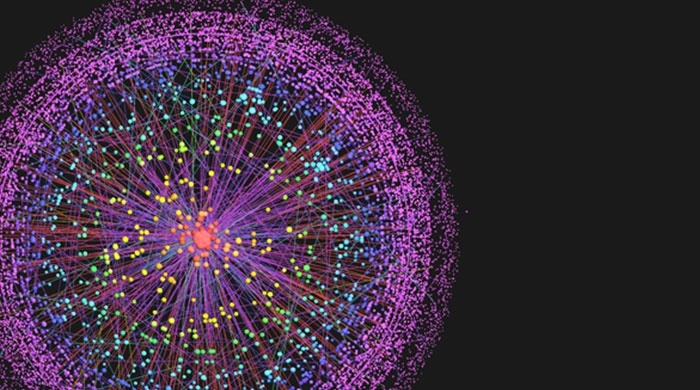

Немного о двойных стандартах: когда Сергей Стиллавин требует от учёных остановить запуск Большого адронного коллайдера, потому что слышал, что существует риск возникновения чёрной дыры, над ним все смеются. Когда Стивен Хокинг предупреждает, что искусственный интеллект может поработить человечество — все напрягаются. Результат, впрочем, в обоих случаях одинаковый — БАК запускается, нейронные сети развиваются наперегонки с квантовыми компьютерами. Вы можете меня упрекнуть в том, что сравнивать суеверный ужас средней руки радиоведущего с осторожным предупреждением мирового учёного не совсем корректно — но в обоих случаях это как минимум повод задуматься, что нам прогресс готовит.

Можно понять, почему предупреждение Хокинга не оказало существенного воздействия на заинтересованных в разработке АИ. Дело не только в обычной инерции процессов — когда цели намечены, планы составлены и бюджеты выделены, нужно что-то большее, чем глас обеспокоенной общественности, чтобы остановить разгоняющийся состав. На стороне исследователей и программистов здравый смысл и весь человеческий опыт: предсказания алармистов ещё ни разу не сбылись, а страхи луддитов сделали их в исторической перспективе посмешищем. Города Европы не были покрыты конским навозом, паровозный дым не убил посевы и не отравил лошадей, трудовые мигранты не уничтожили ещё ни одну экономику, 7 миллиардов человек не умерли с голоду и даже не погрязли в грязи и тотальной войне за ресурсы, ядерное оружие не привело к апокалипсису, 2000 год не уничтожил компьютерные системы, а БАК не привёл к созданию чёрной дыры.

Читать полностью »