Джил Лепор, профессор истории Гараварда, рассуждает о том, какими могут быть критерии определения правды и лжи в эпоху интернета, мобильных технологий, "больших данных" и "диктатуры масс-медиа". Оригинальная статья в журнале The New Yorker. Редакция Roem.ru благодарит Полину Пилюгину и Кирилла Чернякова из сообщества Newочём за помощь в подготовке материала.

Рубрика «big data» - 96

Почему разумные люди не смогут остановить распространение лжи в интернете

2016-05-13 в 14:53, admin, рубрики: big data, Доверие к соцсетям, Достойная журналистика, колонка, Медиа, онлайн-медиа, перевод, СМИ, советы, метки: big data, Доверие к соцсетям, Достойная журналистика, колонка, медиа, Онлайн-медиа, перевод, СМИ, советыОжидания направлений развития в сфере хранения и обработки данных до 2020 года. Основные тренды

2016-05-11 в 15:27, admin, рубрики: big data, switch supernap, Блог компании ua-hosting.company, дата-центр, ит-инфраструктура, оптимизация, сервер, хостинг

Развитие ИТ-инфраструктуры — это неуклонный процесс, который был, есть и непременно будет, набирая все только большие обороты. Взяв очередную высоту стандартов осуществления своей деятельности, перед сетевыми инженерами открываются новые горизонты, достижение которых становится для них очередным вызовом и основой их повседневных трудов. Для успешного функционирования ИТ-компаний всегда было очень важным точно определить цели, направления развития, самые актуальные тренды ведь как можно наблюдать именно ИТ-сфера находится на самом острие технологического прогресса и особо подвержена внедрению нововведений. В древности, за возможностью заглянуть в день грядущий, люди обращались к оракулам и вещунам, сейчас же эту столь вакантную деятельность «окучивают» профессиональные ассоциации, проводя всевозможные опросы и создавая на их основе самые разносторонне направленные отчеты.

Именно таким отчетом, совсем недавно, порадовала ИТ-сообщество AFCOM(Association for Computer Operation Management). Предметом полномасштабного исследования стало функционирование дата-центров. Со слов представителей AFCOM представленный отчет является настоящим событием, поскольку охватил самые широкие слои специалистов задействованных в работе ЦОД(Центр Оброботки Данных). Сетевые инженеры, менеджеры, программисты и владельцы компаний-провайдеров в представленном докладе дадут нам более четкое виденье той ситуации, в которой отрасль находится сейчас и где она окажется в ближайшие 3-4 года. Далее в статье будут представлены основные акценты на которых базируется вышеупомянутый отчет, что претендует быть наиболее репрезентативным и наиболее актуальным среди всех аналогичных проведеных в 2015 году.

Big Data от A до Я. Часть 5.1: Hive — SQL-движок над MapReduce

2016-05-11 в 9:40, admin, рубрики: Apache Hive, big data, Hadoop, Hive, MapReduce, sql, Блог компании DCA (Data-Centric Alliance)Привет! Мы продолжаем наш цикл статьей, посвященный инструментам и методам анализа данных. Следующие 2 статьи нашего цикла будут посвящены Hive — инструменту для любителей SQL. В предыдущих статьях мы рассматривали парадигму MapReduce, и приемы и стратегии работы с ней. Возможно многим читателям некоторые решения задач при помощи MapReduce показались несколько громоздкими. Действительно, спустя почти 50 лет после изобретения SQL, кажется довольно странным писать больше одной строчки кода для решения задач вроде «посчитай мне сумму транзакций в разбивке по регионам».

С другой стороны, классические СУБД, такие как Postgres, MySQL или Oracle не имеют такой гибкости в масштабировании при обработке больших массивов данных и при достижении объема большего дальнейшая поддержка становится большой головоной болью.

Собственно, Apache Hive был придуман для того чтобы объеденить два этих достоинства:

- Масштабируемость MapReduce

- Удобство использования SQL для выборок из данных.

Под катом мы расскажем каким образом это достигается, каким образом начать работать с Hive, и какие есть ограничения на его применения.

Читать полностью »

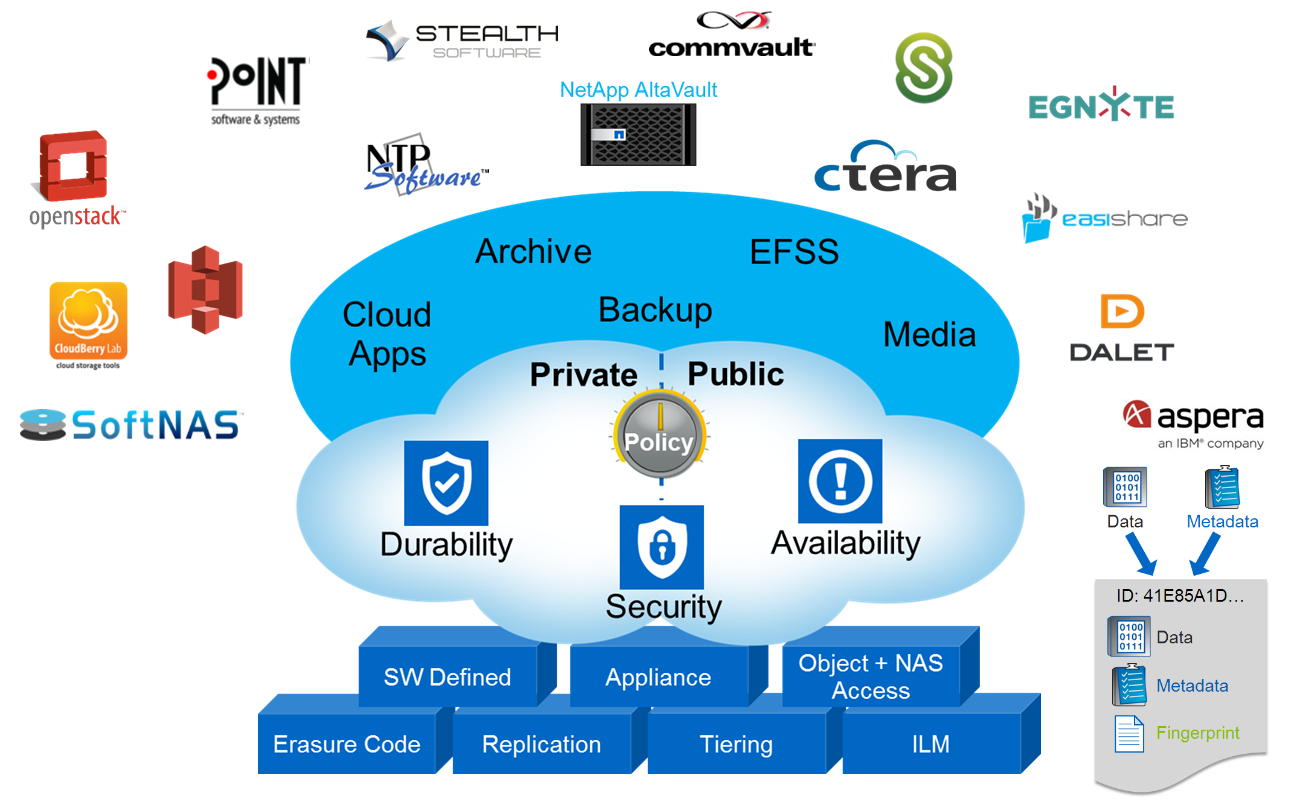

Объектное хранилище NetApp StorageGrid

2016-05-10 в 13:18, admin, рубрики: AltaVault, amazon, Amazon CloudFront, amazon s3, archive, backup, big data, blob, CDMI, ceph, CIFS, cinder, Citrix Sharefile, cloudfront, Commvault, Ctera, DDP, docker, Dynamic Disk Pools, E-Series, Egnyte, Erasure Coding, File share, File sync, Geo-EC, glance, Inktank, Inktank Ceph, kilo, kvm, NAS, NetApp, NetApp AltaVault, NetApp E-Series, NetApp StorageGrid, nfs, NTP software, object storage, OpenStack Heat, OpenStack Kilo, raid, RESTful HTTP, s3, SCSI, SGAPI, smb, SoftNAS, stealth, StorageGrid, swift, Swift API, Symantec Enterprise Vault, Анализ и проектирование систем, ит-инфраструктура, системное администрирование, хранение данных В этой статье я отклонюсь от традиционной для меня темы систем хранения FAS и подниму тему объектного хранения данных в системах NetApp StorageGrid WebScale. Если кратко, то объектное хранение — это третий тип хранения наряду с NAS и SAN. Представьте себе, что каждый файл состоит из данных и метаинформации (владелец, права, время модификации и т.д.), так вот объектное хранение позволяет разъединить эти части и хранить их в виде «ключ/значение». Такой подход хранения информации открывает возможности децентрализованного, распределённого хранения данных огромных масштабов с прозрачной миграцией данных, репликацией и прозрачным переключением конечных потребителей между нодами объектного кластера. В широком смысле объектное хранилище может быть реализовано как на уровне устройства (жесткого диска), при помощи специализированных SCSI команд (Object-based Storage Device Commands), так и на уровне протокола доступа к системе хранения, которая состоит из нескольких дисков (которые, в свою очередь, вовсе не обязаны быть объектными). В обоих случаях используется Ethernet для подключения и IP протокол для передачи данных. Примером реализации объектного хранилища на уровне устройства являются жесткие диски линейки Seagate Kinetic Open Storage platform. Примером систем хранения данных в облаке может быть Microsoft Azure BLOB, Amazon S3. В этой статье я остановлюсь на объектных СХД, которые можно развернуть у себя на сайте и при необходимости подключить к облаку.

Читать полностью »

Укрощаем слона или что такое HUE

2016-05-10 в 12:46, admin, рубрики: Apache, apache hadoop, big data, cloudera, javaПост будет о том, как сделать работу на Хадупе немного комфортнее.

В данной статье я хочу рассмотреть один из компонентов экосистемы Hadoop – HUE. Произносим правильно «Хьюи» или «Эйч Ю И», но не другими, созвучными с широко известным русским словом, вариантами.

Читать полностью »

Интернет пчел, или Зеленое будущее M2M приложений

2016-05-04 в 7:00, admin, рубрики: big data, IoT, безопасность, безопасность в сети, Беспроводные технологии, Блог компании Gemalto Russia, Геоинформационные сервисы, Интернет вещей, информационная безопасность, экологияВсе обсуждение вокруг феномена Интернета вещей обычно сводится к тем потенциальным преимуществам для бизнеса и к тем удобствам для пользователей, которые предлагают наши интеллектуальные устройства и объекты, окружающие нас в повседневной жизни. При этом многие аналитики не исключают вероятности того, что мы находимся на пороге второй цифровой революции.

Однако недавно прошедший День Земли натолкнул нас на идею рассмотреть вопрос шире – это был отличный повод изучить, каким образом Интернет вещей, и даже скорее индустриальный Интернет вещей (M2M – machine-to-machine), то есть беспроводная передача данных и информации между устройствами и объектами, сможет оказать благотворное влияние на нашу жизнь и будет способствовать устойчивому развитию и защите окружающей среды на нашей взаимосвязанной планете.

BlackBox Challenge: Что внутри черного ящика?

2016-04-30 в 10:39, admin, рубрики: artificial intelligence, big data, blackbox challenge, cython, deep learning, machine learning, reinforcement learning, искусственный интеллект, машинное обучение, нейронные сети, обучение с подкреплением, Спортивное программирование, метки: blackbox challengeВсем привет!

Сегодня речь пойдет о состязании, в области машинного обучения, BlackBox Challenge, а также о самом черном ящике, механизмах его работы, изменения состояний, начисления вознаграждений и конечно о том, что же там внутри.

Чуть ниже я опубликую решение, входящее, на момент публикации, в 5-ку лучших.

Уверен оно поможет другим участникам улучшить свои результаты, а возможно и отыскать новый подход.

Во что превратятся большие данные

2016-04-28 в 14:42, admin, рубрики: big data, Большие данные, добыча данных, интеллект бизнеса, Исследования и прогнозы в IT, управление информацией, управление проектами Big data – это большой потенциал для бизнеса.

Их сбор, хранение, обработка, аналитика требуют внушительных усилий и расхода ресурсов. И это нужно для того, чтобы делать меньше ошибок, и чтобы минимизировать последствия сделанных ошибок.

Иными словами, управление большими данными имеет главной целью принятие качественных решений.

Кадр из к/ф «Особое мнение» (Minority Report) Стивена Спилберга по повести Филипа Дика (2002 — 20th Century Fox, DreamWorks SKG).

Читать полностью »

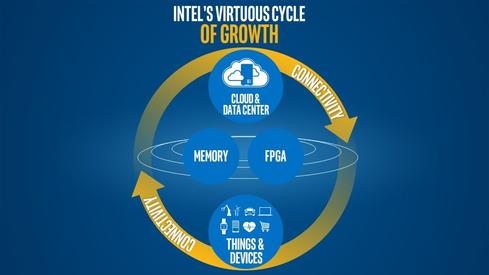

«Спасательный круг» Intel: глава компании официально объявил о смене бизнес-модели

2016-04-28 в 6:09, admin, рубрики: big data, intel, аналитика, бизнес-модели, Монетизация IT-систем, облачные технологии, реструктуризация бизнеса, смена стратегии

Источник: informationweek.com

Генеральный директор Intel Брайан Крзанич изложил новую стратегию развития компании в своем послании. Специалисты компании решили, что необходимо отказаться от парадигмы, в рамках которой главным драйвером развития бизнеса были продажи ПК. По оценке IDC, в 2014 году глобальные продажи компьютеров упали на 2,1%, в 2015 году сокращение оценивается в 6,2%. Вместо этого CEO предлагает сосредоточиться на поставках решений для дата-центров и инфраструктуры интернета вещей.

В последнее время все сильнее распространяются облачные технологии. Поэтому одной из стратегических задач компании станет адаптация архитектуры под виртуализированные среды и программно-определяемые технологии.

Отдельное внимание Брайан Крзанич планирует уделить аналитическим системам и большим данным: «Мы повысим мощность и ценность аналитики за счет продолжающихся инноваций в области производительности, больших данных и способностей машин к обучению».Читать полностью »

Big Data: «Серебряная пуля» или еще один инструмент

2016-04-27 в 7:50, admin, рубрики: 1cloud, big data, Блог компании 1cloud.ru, Большие данные, виртуальная инфраструктура, Разработка под e-commerceТермин «Большие данные» появился не так давно — впервые его использовали в журнале Nature в 2008 году. В том номере (от 3 сентября) большими данными читателям было предложено называть набор специальных методов и инструментов для обработки огромных объемов информации и представления её в виде, понятном пользователю.

Очень скоро исследователи новоявленной области пришли к выводу, что большие данные не просто годятся для анализа, а могут оказаться полезными в целом ряде областей: от предсказания вспышек гриппа по результатам анализа запросов в Google до определения выгодной стоимости билетов на самолет на основе огромного массива авиационных данных.

Апологеты этого направления утверждают даже, что тандем мощных современных технологий и «мощных» объемов информации, доступных в цифровую эпоху, обещает стать грозным инструментом для решения практически любой проблемы: расследования преступлений, охраны здоровья, образования, автомобильной промышленности и так далее. «Нужно лишь собрать и проанализировать данные».Читать полностью »