Всем привет!

Меня зовут Александр, я руковожу отделом Data Team в Badoo. Сегодня я расскажу вам о том, как мы выбирали оптимальный алгоритм для вычисления квантилей в нашей распределённой системе обработки событий.

Всем привет!

Меня зовут Александр, я руковожу отделом Data Team в Badoo. Сегодня я расскажу вам о том, как мы выбирали оптимальный алгоритм для вычисления квантилей в нашей распределённой системе обработки событий.

Как мы и обещали, наше мероприятие становится регулярным – 27 июля состоится Moscow Spark #2! Moscow Spark #1, организованный группой компаний Rambler&Co, собрал больше 200 участников, и мы надеемся, что жаркая погода, которая когда-нибудь установится в московском регионе, не помешает нам собрать столько же (и даже больше) участников в этот раз. Тем более, что мы нашли новых, интересных докладчиков.

Читать полностью »

Сегодня многие организации начинают передавать свои IoT-данные сторонним компаниям. Зачастую это делается ради монетизации, иногда — для соблюдения требований регуляторов. И все эти инициативы выдвигают на передний план проблемы владения данными и их лицензирования.

Любопытно, что не существует установленной схемы определения, как присваивается право собственности, и ещё хуже обстоят дела с правильным лицензированием IoT-данных. Давайте рассмотрим ситуацию чуть подробнее.Читать полностью »

Всем привет!

В этой статье мы расскажем про Big Data в Райффайзенбанке.

Но прежде чем перейти к сути, хотелось бы внести ясность по поводу самого определения Big Data. Действительно, в последние несколько лет этот термин употреблялся во множестве контекстов, что привело к размытию границ самого термина и потере содержательной части. Мы в Райффайзенбанке выделили три направления, которые мы относим к Big Data:

Читать полностью »

Всем привет! Я тимлид проекта Рамблер/топ-100. Это лонгрид о том, как мы проектировали архитектуру обновлённого сервиса веб-аналитики, с какими сложностями столкнулись по пути и как с ними боролись. Если вам интересны такие базворды как Clickhouse, Aerospike, Spark, добро пожаловать под кат.Читать полностью »

Привет! Не так давно я имел удовольствие посетить встречу PyData Moscow на площадке Яндекса. Я не могу назвать себя python разрабочиком, но имею интересы в области аналитики и анализа данных. Посетив данное мероприятие, я узнал о существовании СУБД ClickHouse, разработанной в Яндексе и выложенной на GitHub под открытой лицензией. Колоночная SQL СУБД с отечественными корнями пробудила во мне интерес. В этой статье я поделюсь опытом установки и настройки ClickHouse, а также попыткой доступа к ней из Spring приложения с помощью Hibernate.

Читать полностью »

В наше время термин “BIG DATA” у всех на слуху. После появления в сети и в прессе многочисленных публикаций, связанных с обработкой «больших данных», интерес к этой теме постоянно растет. Все более широким спросом пользуются системы управления базами данных с

использованием технологии NoSQL. Всем понятно, что для построения систем “BIG DATA” необходимо располагать внушительными аппаратными ресурсами. Еще более важно уметь оптимально использовать вычислительные ресурсы системы и эффективно их масштабировать. Это неизбежно меняет подходы к построению систем обработки данных. Читать полностью »

21 октября в Петербурге мы проводим новую конференцию по большим и умным данным SmartData 2017 Piter.

О Big Data в последнее время говорят все: от школьников до Германа Грефа. И вот тут возникает некоторый диалектический дуализм: о проблемах работы с большими данными говорят много, вот только все разговоры — это переливание из пустого в порожнее или какой-нибудь махровый маркетинговый вздор. Больше всего пугает, что люди начинают верить в то, что где-то лежит несколько петабайт «больших данных», и их можно взять и «отбольшеданнить». За советом я обратился к Виталию Худобахшову из «Одноклассников», и я придерживаюсь схожей точки зрения, судите сами:

Большие данные – это не свойства объема или времени. То, что считается «много данных» сейчас, влезет на флешку через 10 лет. То, для чего сейчас нужен Hadoop-кластер в десятки или даже сотни узлов, можно будет решить на телефоне через те же самые 10 лет. Большие данные – это прежде всего новое качество, т.е. что-то, что нельзя получить с помощью меньшего набора данных. На самом деле таких примеров не так уж много, но их количество с нарастанием объема данных и улучшением их качества непрерывно увеличивается.

Иногда большие данные настолько облегчают жизнь, что для решения конкретной проблемы отпадает необходимость использовать продвинутую технику машинного обучения. Рассмотрим пример: пользователь вводит свой пол в социальной сети неправильно, и получается, либо мы имеем неизвестный пол или какой-нибудь пол по умолчанию, что тоже плохо. Здесь кат. Читать полностью »

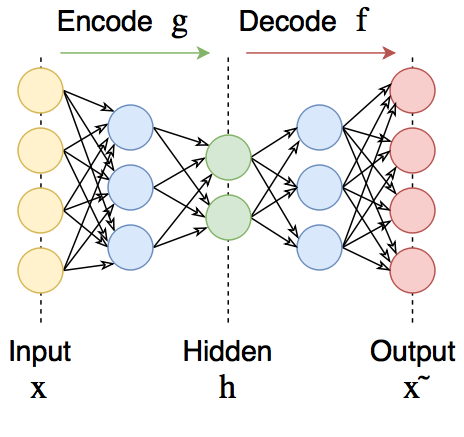

Для того, чтобы лучше понимать, как работают автоэнкодеры, а также чтобы в последствии генерировать из кодов что-то новое, стоит разобраться в том, что такое коды и как их можно интерпретировать.

Читать полностью »

Во время погружения в Deep Learning зацепила меня тема автоэнкодеров, особенно с точки зрения генерации новых объектов. Стремясь улучшить качество генерации, читал различные блоги и литературу на тему генеративных подходов. В результате набравшийся опыт решил облечь в небольшую серию статей, в которой постарался кратко и с примерами описать все те проблемные места с которыми сталкивался сам, заодно вводя в синтаксис Keras.

Автоэнкодеры — это нейронные сети прямого распространения, которые восстанавливают входной сигнал на выходе. Внутри у них имеется скрытый слой, который представляет собой код, описывающий модель. Автоэнкодеры конструируются таким образом, чтобы не иметь возможность точно скопировать вход на выходе. Обычно их ограничивают в размерности кода (он меньше, чем размерность сигнала) или штрафуют за активации в коде. Входной сигнал восстанавливается с ошибками из-за потерь при кодировании, но, чтобы их минимизировать, сеть вынуждена учиться отбирать наиболее важные признаки.

Кому интересно, добро пожаловать под кат

Читать полностью »