Поймал себя на ощущении, что очень хочется поделиться своим опытом работы с интеловской энергонезависимой памятью (Intel Optane memory или Intel PMem = persistent memory). Я буду для краткости называть ее ПМем. Думаю, что несмотря на объем продаж в сотни миллионов долларов, пока мало кто с ней сталкивался и знает ее специфику. Я же по долгу службы занимаюсь ей уже довольно продолжительное время и гонял на ней различные приложения и микро-бенчмарки. А также добивался ее эффективного использования модифицируя под нее клиентские коды.

Рубрика «big data» - 7

Кратко, но по делу про энергонезависимую память Intel Optane

2022-01-31 в 11:50, admin, рубрики: big data, Анализ и проектирование систем, высокая производительность, Клиентская оптимизация, конфигурация, производительность, сервер, хранение данных, энергонезависимая память5 грязных трюков в соревновательном Data Science, о которых тебе не расскажут в приличном обществе

2022-01-11 в 6:19, admin, рубрики: big data, data mining, data science, kaggle competition, python, tricksПривет, чемпион! Возможно, ты сейчас участвуешь в соревновании по анализу данных или просто решил погрузиться в мира Data Science. Тогда эта статья будет тебе очень полезна!

Сражу скажу, что трюки, о которых мы сегодня поговорим, я не просто так назвал "грязными". Речь пойдет о вещах, которые в каком-то смысле нечестные или просто вводят в заблуждение других участников соревнований. Долго думал, стоит ли про эти техники вообще рассказывать, ведь в борьбе за призовые всегда велик соблазн начать хитрить. Решил, что все-таки расскажу про некоторые приемы, дабы вооружить честных людей, которые играют по правилам.

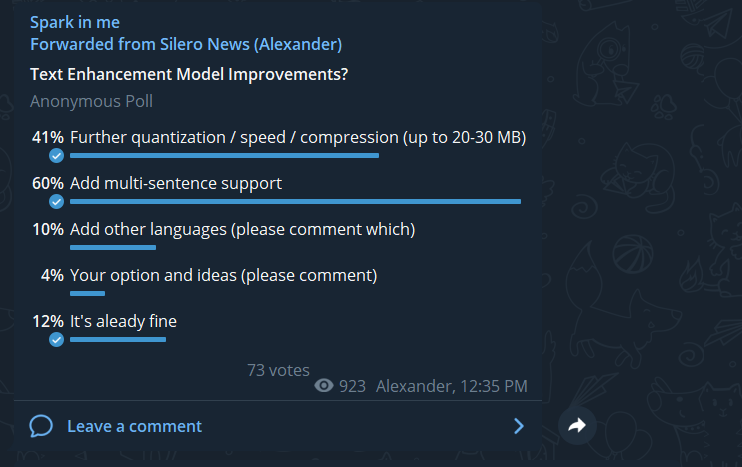

Восстановление знаков пунктуации и заглавных букв — теперь и на длинных текстах

2021-12-09 в 17:06, admin, рубрики: big data, natural language processing, python, pytorch, silero, запятая, знаки препинания, машинное обучение, нейросеть, прописные буквы

После релиза нашей первой модели, расставляющей знаки препинания и большие буквы, было много пожеланий доработать её, чтобы она могла обрабатывать тексты целиком, а не отдельные предложения. Это коллективное пожелание и было осуществлено в нашей новой версии модели.

В целом, архитектура и датасеты остались прежними. Что изменилось:

- обучение теперь производилось не на отдельных предложениях, а на нескольких последовательных предложениях (принимаем во внимание, что конструктивное ограничение модели при обучении — 512 токенов на вход, что позволяет свободно подавать ~150 слов на любом из четырех поддерживаемых языков)

- для ускорения обучения модели сокращение словаря теперь проводилось не только на инференсе, но и на трейне, что позволило увелить размер батча

Восстанавливаем результаты выборов в Государственную думу 2021 года с помощью машинного обучения

2021-11-13 в 15:29, admin, рубрики: big data, data science, pandas, plotly, python, scikit-learn, Алгоритмы, визуализация данных, выборы, Государственная дума, Инфографика, искусственный интеллект, кластеризация, машинное обучение

Результаты выборов в государственную думу, которые проходили 17-19 сентября 2021 вызывают сомнения у многих экспертов. Независимый электоральный аналитик Читать полностью »

Классификация кассовых чеков

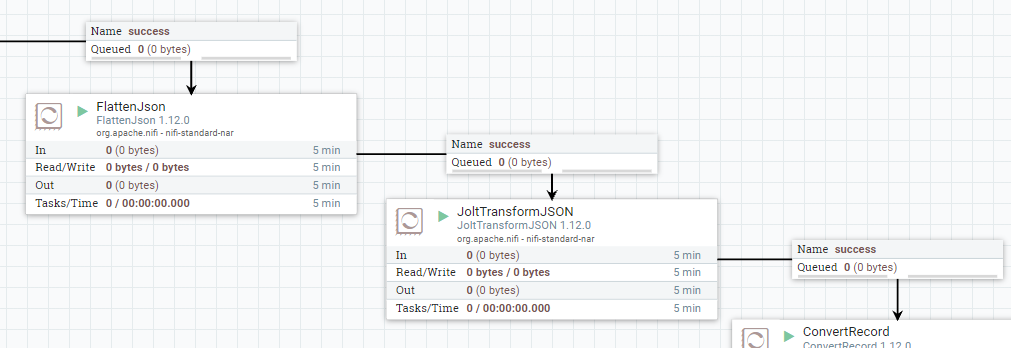

2021-11-01 в 8:15, admin, рубрики: big data, deeplearning, FastText, machinelearning, nlp, python, искусственный интеллект, машинное обучение, ОФД, Хакатоны, чекиГотовим Json в Apache NiFi или снова Jolt Transform

2021-10-24 в 13:33, admin, рубрики: apache nifi, big data, data engineering, jolt, json, NiFi

На текущем проекте у нас начинает активно использоваться Apache NiFi в качестве основного ETL/ELT-инструмента. NiFi используется для получения данных из различных источников (Kafka, REST, HDFS) и подготовки данных для их последующей загрузки в основное хранилище на базе GreenplumЧитать полностью »

Как спарсить любой сайт?

2021-09-22 в 10:40, admin, рубрики: BeautifulSoup4, big data, data mining, headlessbrowser, javascript, linkedin, Puppeteer, scrapy, selenium, selenoid, открытые данные, парсинг, Тестирование веб-сервисов

Меня зовут Даниил Охлопков, и я расскажу про свой подход к написанию скриптов, извлекающих данные из интернета: с чего начать, куда смотреть и что использовать.

Написав тонну парсеров, я придумал алгоритм действий, который не только минимизирует затраченное время на разработку, но и увеличивает их живучесть, робастность, масштабируемость.

TL;DR

ClickHouse: путь джедая, искавшего дом для своих данных

2021-09-07 в 7:12, admin, рубрики: big data, clickhouse, data lake, Блог компании Туту.ру, хранение данных, хранилище данных

Каждый пятый абонент «Билайна» уехал из Москвы, каждый десятый — из Санкт-Петербурга

2021-08-20 в 6:21, admin, рубрики: big data, билайн, Вымпелком / VEON, интервью, Текучка, метки: big data, билайн, Вымпелком / VEON, интервью, ТекучкаДиректор по Digital-продуктам группы Veon Джордж Хелд ушёл в Veon из принадлежащего ей же «Вымпелкома» и рассказал о пандемийных изменениях в поведении абонентов и взглядах компании на этичное применение новых технологий. В Билайне заметили, что благодаря удалёнке люди активно уезжают из больших городов (в основном в область того же города):

Из Москвы в соседние регионы уехало 21,8% клиентов «Читать полностью »

UUID версии 7, или как не потеряться во времени при создании идентификатора

2021-08-12 в 23:30, admin, рубрики: Bender Bending Rodriguez, big data, GUID, uuid, UUIDv6, UUIDv7, UUIDv8, Администрирование баз данных, идентификатор, инженерные системы, Новый, Новый UUID, системное программирование, Уникальный идентификатор, хранение данных