Привет! Сегодня делимся интервью с директором по цифровым технологиям компании РТС-Тендер, которая занимается организацией электронных торгов с использованием блокчейна, машинного обучения и анализа больших данных. Расспросим про все аспекты бизнеса, а главное — о технической части. Присоединяйтесь. Ну а под катом — текстовая версия.

Рубрика «big data» - 55

Будущий единый B2B-маркет или игра в технологии?

2018-04-24 в 6:29, admin, рубрики: azure batch, big data, microsoft, Блог компании Microsoft, блокчейн, интервью, машинное обучение, РТС-тендер, торгиРешаем загадку круглых чисел на графике выборов 2018

2018-04-23 в 22:04, admin, рубрики: big data, data mining, анализ данных, визуализация данных, открытые данные, статистика

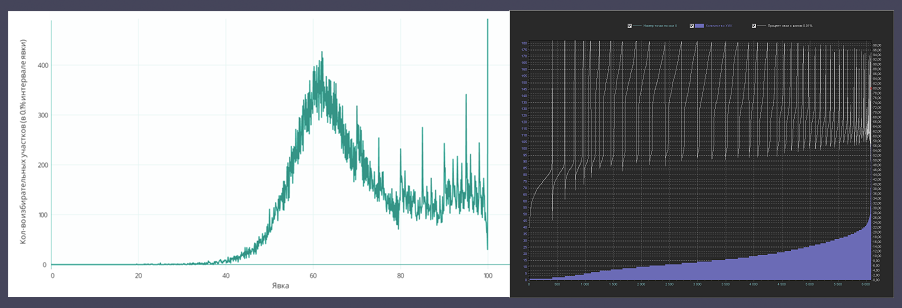

Данная статья является ответом на вот эту статью (Анализ результатов президентских выборов 2018 года. На федеральном и региональном уровне).

В той статье меня удивила фраза автора:

Вместо нормального или логнормального распределения мы видим интересную кривую, с очень странными пиками на круглых значениях (70%, 75%, 80% и т.д.), возрастающую на около-100% явке и уходящей далеко вверх на 100%.

Сразу возникают вопросы:

Почему автор считает, что вместо «странных» пиков должно быть нормальное или логнормальное распределение?

Почему вообще пики считаются «странными»?

Откуда могут появиться «естественные» пики на круглых значениях?

Та статья сильно политизирована и комментарии в ней соответствующие. В этой статье мы будем обсуждать только математику, поэтому политические взгляды попрошу держать при себе.

А в качестве бонуса, в конце статьи будет выложен ключ к решению загадки «круглых чисел» на графике выборов 2018.

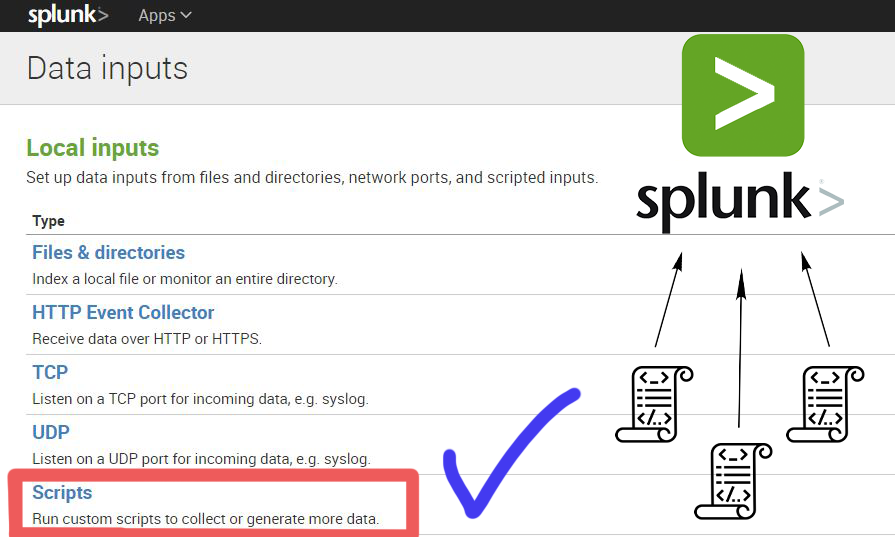

Splunk Scripted Input. Или как использовать скрипты для получения данных о работе систем и анализировать их в Splunk

2018-04-20 в 8:09, admin, рубрики: alerting, big data, machine data, script, splunk, Блог компании TS Solution, загрузка данных, логи, Серверное администрирование, системное администрированиеРанее мы писали, как можно загрузить логи в Splunk из каталога или с помощью syslog, рассказывали как забирать стандартные виндовые и линуксовые события, но что если нам необходимо получать более гранулярную информацию о работе наших систем?

В таком случае на помощь приходят скрипты!

Когда, какие и как можно использовать скрипты в Splunk для получения данных — вы можете узнать под катом.

Читать полностью »

Data Fest 2018: анонс и регистрация

2018-04-19 в 14:19, admin, рубрики: big data, data fest, data mining, data science, machine learning, mail.ru, mail.ru group, Блог компании Mail.Ru Group, визуализация данных, машинное обучение

Друзья, приглашаем вас на пятый московский Data Fest, который состоится 28 апреля на территории дизайн-завода FLACON. Data Fest — крупнейшая бесплатная конференция для исследователей, инженеров и разработчиков, связанных с анализом и обработкой данных, машинным обучением, а также тем, что пресса любит называть AI.

Вы узнаете про AI в продуктах Mail.Ru Group и «умные» ответы в Почте Mail.Ru, как работают рекомендации и компьютерное зрение во ВКонтакте и Одноклассниках, а также машинный перевод в Alibaba и что такое Quantum Machine Learning, а также многое-многое другое!

Читать полностью »

Как загрузить нестандартный лог в Splunk + логи Fortinet

2018-04-13 в 7:40, admin, рубрики: big data, fortinet, splunk, Блог компании TS Solution, загрузка данных, логи, Серверное администрирование, системное администрированиеМного ли мы генерируем данных, используя информационные системы каждый день? Огромное количество! Но знаем ли мы все возможности по работе с такими данными? Определенно, нет! В рамках этой статьи мы расскажем какие типы данных мы можем загружать для дальнейшего операционного анализа в Splunk, а также покажем как подключить загрузку логов Fortinet и логов нестандартной структуры, которые необходимо разделять на поля вручную.

Пять мифов о Data Science

2018-04-11 в 10:14, admin, рубрики: big data, career, data mining, data science, machine learning, python, Блог компании ID Finance, Карьера в IT-индустрии, машинное обучениеМеня зовут Иван Серов, я работаю в департаменте Data Science финтех-компании ID Finance. Data scientist –довольно молодая, но очень востребованная профессия, которая обросла множеством мифов. В этом посте я расскажу о нескольких заблуждениях, с которыми сталкиваются начинающие дата-саентисты (DS).

О стримах и таблицах в Kafka и Stream Processing, часть 1

2018-04-11 в 8:07, admin, рубрики: apache kafka, big data, java, scala, stream processing, Блог компании Контур, потоковая обработка данных, Программирование, стримы* Michael G. Noll — активный контрибьютор в Open Source проекты, в том числе в Apache Kafka и Apache Storm.

Статья будет полезна в первую очередь тем, кто только знакомится с Apache Kafka и/или потоковой обработкой [Stream Processing].

В этой статье, возможно, в первой из мини-серии, я хочу объяснить концепции Стримов [Streams] и Таблиц [Tables] в потоковой обработке и, в частности, в Apache Kafka. Надеюсь, у вас появится лучшее теоретическое представление и идеи, которые помогут вам решать ваши текущие и будущие задачи лучше и/или быстрее.

Содержание:

* Мотивация

* Стримы и Таблицы простым языком

* Иллюстрированные примеры

* Стримы и Таблицы в Kafka простым языком

* Пристальный взгляд на Kafka Streams, KSQL и аналоги в Scala

* Таблицы стоят на плечах гигантов (на стримах)

* Turning the Database Inside-Out

* Заключение

Читать полностью »

Достижимость нижней границы времени исполнения коммита распределенных отказоустойчивых транзакций

2018-04-11 в 6:36, admin, рубрики: big data, raft, Алгоритмы, Анализ и проектирование систем, высокая производительность, консенсус, параллельное программирование, распределенные системы, транзакцииПредисловие

Недавно прочитал очередную статью из серии: "мы лучше двухфазного коммита". Здесь я не буду анализировать содержания этой статьи (хотя, подумываю о том, чтобы дать развернутый анализ). Задача моего опуса — предложить самый эффективный вариант распределенного коммита с точки зрения временных задержек. Конечно, такой коммит дается высокой ценой. Однако цель — дать оценку и показать, что двухфазный коммит не является тормозным, как многие считают.

Стоит также отметить, что здесь не будет натурных экспериментов и фейковых сравнений. Будут просто даны алгоритмы и теоретический анализ. При желании, можно самостоятельно реализовать и проверить на практике. Конечно, было бы куда лучше, чтобы это было описано в текущей статье, но все упирается в свободное время и мотивацию. На мой взгляд, описать алгоритмы более важно, чем привести графики, т.к. графики по алгоритмам может нарисовать почти каждый, обратное же не верно.

Анализ данных — основы и терминология

2018-04-08 в 13:05, admin, рубрики: algorithms, big data, data mining, data science, machine learning, Алгоритмы, математика, машинное обучениеВ этой статье я бы хотел обсудить базовые принципы построения практического проекта по (т. н. «интеллектуальному») анализу данных, а также зафиксировать необходимую терминологию, в том числе русскоязычную.

Согласно википедии,

Анализ данных — это область математики и информатики, занимающаяся построением и исследованием наиболее общих математических методов и вычислительных алгоритмов извлечения знаний из экспериментальных (в широком смысле) данных; процесс исследования, фильтрации, преобразования и моделирования данных с целью извлечения полезной информации и принятия решений.

Говоря чуть более простым языком, я бы предложил понимать под анализом данных совокупность методов и приложений, связанных с алгоритмами обработки данных и не имеющих четко зафиксированного ответа на каждый входящий объект. Это будет отличать их от классических алгоритмов, например реализующих сортировку или словарь. Читать полностью »

Обзор кейсов интересных внедрений Big Data в компаниях финансового сектора

2018-04-07 в 12:37, admin, рубрики: big data, cloudera, Hadoop, банки, кейсы, перевод с английского, управление проектами, финансовый секторКейсы практического применения Больших данных

в компаниях финансового сектора

Зачем эта статья?

Зачем эта статья?

В данном обзоре рассматриваются случаи внедрения и применения Больших данных в реальной жизни на примере «живых» проектов. По некоторым, особенно интересным, во всех смыслах, кейсам осмелюсь дать свои комментарии.

Диапазон рассмотренных кейсов ограничивается примерами, представленными в открытом доступе на сайте компании Cloudera.

Что такое «Большие данные»

Есть в технических кругах шутках, что «Большие данные» это данные, для обработки которых недостаточно Excel 2010 на мощном ноутбуке. То есть если для решения задачи вам надо оперировать 1 миллионом строк на листе и более или 16 тысяч столбцов и более, то поздравляем, ваша данные относятся к разряду «Больших».

Есть в технических кругах шутках, что «Большие данные» это данные, для обработки которых недостаточно Excel 2010 на мощном ноутбуке. То есть если для решения задачи вам надо оперировать 1 миллионом строк на листе и более или 16 тысяч столбцов и более, то поздравляем, ваша данные относятся к разряду «Больших».

Среди множества более строгих определений приведем, например следующее: «Большие данные» — наборы данных, которые настолько объемны и сложны, что использование традиционных средств обработки невозможно. Термин обычно характеризует данные, над которыми применяются методы предиктивной аналитики или иные методы извлечения ценности из данных и редко соотносится только с объемом данных.

Читать полностью »