«Это не радует. Мы и так соревнуемся с Kobalt, AWAL и Caroline — только Spotify не хватало», — прокомментировал директор одного из независимых лейблов планы Spotify на прямое лицензирование музыки. Ранее Spotify пообещал платить значительные суммы за прямую передачу прав на записи, напомнил Mooscle. Независимые артисты (и лейблы), при некоторых условиях, Читать полностью »

Рубрика «big data» - 51

Лейблы испугались плана Spotify платить музыкантам напрямую и потребовали равный доступ к статистике

2018-06-26 в 14:32, admin, рубрики: big data, Spotify, аналитика, Инди-лейблы, кейсы, Медиа, музыкальные сервисы, Правообладатели, статистика, США, Текучка, эффективность бизнеса, яндекс.музыка, метки: big data, Spotify, аналитика, Инди-лейблы, кейсы, медиа, музыкальные сервисы, Правообладатели, статистика, США, Текучка, эффективность бизнеса, яндекс.музыкаШкола Данных: как совместить математику и бизнес

2018-06-26 в 4:44, admin, рубрики: big data, data mining, kaggle, sna, Алгоритмы, алгоритмы обработки данных, анализ данных, анализ социальных сетей, Блог компании Школа Данных, искусственный интеллект, математика, машинное обучение, рекомендательные системы, школа данных

Что мешает успешно совместить математику и бизнес?

Этот текст — первая из серии статей о том, как корректно встроить инструменты big data с выгодой для бизнеса.

Маленький спойлер: все получится, если помнить о самом бизнесе.

Еще 5 лет назад крупные компании хотели внедрить у себя новомодную “бигдату”. Но настоящих экспериментаторов было мало. Исключениями стали те, кто точно обладал массой данных: телеком, банковский сектор, интернет-компании. А в 2018 году за экспертизой в больших данных бизнесы приходят сами, причем из самых неожиданных отраслей: металлургия, страхование, авиаиндустрия.Читать полностью »

Новый чемпионат ML Boot Camp VI. Прогноз отклика аудитории на интернет-опрос

2018-06-25 в 15:09, admin, рубрики: big data, data mining, machine learning, Machine Learning Boot Camp, mail.ru, ML Boot Camp, Блог компании Mail.Ru Group, машинное обучение

Сегодня, 25 июня, стартует ML Boot Camp VI с задачей «Прогноз отклика аудитории на интернет-опрос» (если вы вдруг впервые слышите, что такое ML Boot Camp, заходите под спойлер).

Читать полностью »

А нам все «вертикально» — СУБД Vertica

2018-06-25 в 6:48, admin, рубрики: big data, Vertica, Администрирование баз данных, Блог компании Сбербанк, СУБД, хранение данных, хранилища данныхПривет! Меня зовут Сергей, я работаю главным инженером в Сбертехе. В ИТ-сфере я примерно 10 лет, из которых 6 занимаюсь базами данных, ETL-процессами, DWH и всем, что связано с данными. В этом материале я расскажу о Vertica — аналитической и по-настоящему колоночной СУБД, которая эффективно сжимает, хранит, быстро отдает данные и отлично подходит в качестве big data решения.

Анализ блокчейн, или почему сломался миксер?

2018-06-20 в 14:44, admin, рубрики: big data, clickhouse, data mining, ERC721, Ethereum, аналитика, блокчейн, визуализация данных, децентрализованные сети, Криптовалюты, миксерПо материалам моего доклада на конференции «Цифровая трансформация» в Москве 16 апреля 2018 г

Мне интересно, как работает блокчейн. Не только какие там алгоритмы, криптография, платформы и криптовалюты. Для меня блокчейн — не только технология, но и новый вид жизни, новая вселенная. Если вы в этом сомневаетесь, посмотрите на этот граф распродажи токенов Aragon:

Все эти адреса, смарт-контракты, токены постоянно взаимодействуют друг с другом, и за ними стоят действия людей, организаций и роботов. Без этого взаимодействия блокчейн и криптовалюты не имели бы никакого смысла и ценности.

Как работают бизнесы в блокчейн, что там делают люди и роботы — эти вопросы заставили меня заняться исследованием блокчейна.

Соревнование Kaggle Home Credit Default Risk — анализ данных и простые предсказательные модели

2018-06-19 в 20:12, admin, рубрики: big data, data mining, kaggle, LightGBM, python, scikit-learn, машинное обучение, переводНа датафесте 2 в Минске Владимир Игловиков, инженер по машинному зрению в Lyft, совершенно замечательно объяснил, что лучший способ научиться Data Science — это участвовать в соревнованиях, запускать чужие решения, комбинировать их, добиваться результата и показывать свою работу. Собственно в рамках этой парадигмы я и решил посмотреть внимательнее на соревнование по оценке кредитного риска от Home Credit и объяснить (начинающим дата саентистам и прежде всего самому себе), как правильно анализировать подобные датасеты и строить под них модели.

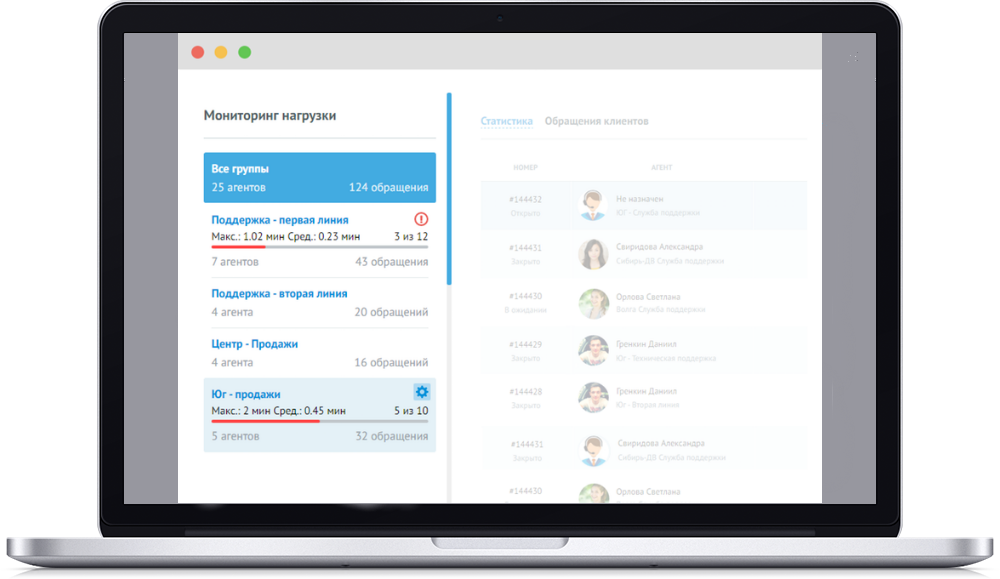

Как мы переводим 36 млн клиентов на цифровой сервис техподдержки

2018-06-19 в 13:56, admin, рубрики: big data, service desk, Блог компании Ростелеком, Омничат, поддержка, Ростелеком, Системы обмена сообщениями, Статистика в ITМы в «Ростелекоме» давно задумывались о том, чтобы переводить голосовой клиентский сервис в digital-каналы текстового общения. Для небольших компаний задача выглядит несложно, но когда речь идет о службе из сотен, а в перспективе даже тысяч операторов поддержки, есть над чем задуматься. В этом посте мы расскажем, какое решение для этого нашли, что оно вообще собой представляет и позволяет делать. Спойлер: много чего.

GNMT, epic fail или тонкости машинного перевода

2018-06-18 в 18:11, admin, рубрики: big data, data mining, ebmt, epic fail, Google API, Google Translate, nmt, искусственный интеллект, машинное обучениеПосле прочтения статьи "Нейронный машинный перевод Google" вспомнился курсирующий последнее время в интернет очередной epic-fail машинного перевода от Google. Кому сильно не терпится сразу мотаем в низ статьи.

Ну а для начала немного теории:

GNMT есть система нейронного машинного перевода (NMT) компании Google, которая использует нейросеть (ANN) для повышения точности и скорости перевода, и в частности для создания лучших, более естественных вариантов перевода текста в Google Translate.

В случае GNMT речь идет о так называемом методе перевода на основе примеров (EBMT), т.е. ANN, лежащая в основе метода, обучается на миллионах примеров перевода, причем в отличии от других систем этот метод позволяет выполнять так называемый zero-shot перевод, т. е. переводить с одного языка на другой, не имея явные примеры для этой пары конкретных языков в процессе обучения (в обучающей выборке).

Рис. 1. Zero-Shot Translation

Читать полностью »

Нейронный машинный перевод Google

2018-06-17 в 14:21, admin, рубрики: big data, машинное обучение, машинный перевод, нейронные сети, переводчикОтчет написан в декабре 2017.

It's not who has the best algorithm that wins. It's who has the most data. Побеждает не тот, у кого лучше алгоритм, а тот, у кого больше данных. Эндрю Нг, преподаватель курса по машинному обучению на Coursera.

If you scale up both the size of the model and the amount of data you train it with, you can learn finer distinctions or more complex features. …These models can typically take a lot more context. Jeff Dean, an engineer helping lead the research at Google. Если увеличить размер модели и дать ей больше данных для обучения, она начнет различать более тонкие и сложные особенности. …Эти модели обычно воспринимают более широкий контекст. Джеф Дин, инженер, помогающий в управлении исследованиями в Google.

Я тестировала Google Translate на одних и тех же текстах в марте и декабре 2011, январе 2016 и декабре 2017 года. Брала одни и те же отрывки на английском, русском, немецком, французском, украинском и польском языках и переводила каждый на остальные пять языков из выборки. Кроме того, в декабре 2017 дополнительно взяла новые тексты и протестировала во всех направлениях перевода. Результаты cross-verification в целом совпали с тенденциями в первоначальной выборке. В итоге получился срез работы переводчика Google за 2011 — 2017 годы, и на основе этих материалов можно сделать выводы об эволюции сервиса и прокомментировать маркетинговые заявления компании (цитаты планируется опубликовать отдельно).Читать полностью »

Великобритания потратила £6 млн на data scientist’ов

2018-06-16 в 17:34, admin, рубрики: big data, data scientist, Блог компании ИТ-ГРАД, британские ученые, Исследования и прогнозы в IT, ИТ-ГРАДВ мае 2018 года коллектив британских ученых провел тематическое исследование и выяснил, что траты на data scientist’ов (или экспертов по аналитическим данным) в Великобритании значительно увеличились. Мы решили разобраться в ситуации и дать краткий обзор.