Сегодня мы начинаем публиковать серию постов о том, как в Яндексе построена работа над улучшением так волнующей всех формулой релевантности, и более широко — качеством ранжирования. Мы сосредоточимся на наших инструментах, которые избавили разработчиков поисковой системы от рутинных действий и помогли сфокусироваться на главном — изобретении новых подходов к улучшению поиска. Почти вся работа в этой области связана с машинным обучением, поэтому о его месте в Яндексе мы тоже немного расскажем.

Читать полностью »

Читать полностью »

Рубрика «big data» - 141

Ранжирование в Яндексе: как поставить машинное обучение на поток (пост #1)

2013-03-26 в 9:06, admin, рубрики: big data, data mining, FML, learning to rank, machine learning, Блог компании Яндекс, машинное обучение, обучение ранжированию, факторы ранжирования, метки: FML, learning to rank, machine learning, машинное обучение, обучение ранжированию, факторы ранжированияОбновление Windows Azure: Hadoop, Dropbox, Mercurial, PhoneGap

2013-03-25 в 10:12, admin, рубрики: big data, DropBox, Hadoop, hdinsight, html5, Mercurial, phonegap, windows azure, метки: DropBox, Hadoop, hdinsight, html5, mercurial, phonegap, windows azure18 марта Скотт Гатри в своем блоге анонсировал очередные нововведения в облачную платформу Windows Azure. Представленный новый функционал включает в себя:

- HTML5-клиенты (CORS) для Windows Azure Mobile Services, включая доступ из поппулярной библиотеки PhoneGap;

- улучшенная поддержка Windows Phone 7.5, новые библиотеки и пакет Nuget;

- поддержка размещения веб-сайтов из Mercurial (Bitbucket, Codeplex) и Dropbox;

- новые шаблоны в Web Sites;

- публичный доступ к сервису HDInsight – облачной платформе Hadoop как сервис.

Ниже о этих нововведениях чуть подробнее.

Поддержка HTML5/JS-клиентов и PhoneGap в Mobile Services

Windows Azure Mobile Services предлагает облачную инфраструктуру для всех популярных мобильных платформ: Windows 8, Windows Phone, iOS и Android. В текущем обновлении к поддержке мобильных платформ добавилась поддержка веб-клиентов на HTML5/JS, в частности популярной библиотеки PhoneGap. Теперь вы можете получить доступ ко всем данным сохраненным из мобильных клиентов через код написанный на HTML5/JS.

Читать полностью »

Новое в СУБД Caché 2013.1: добавление и генерация индексов на «живых» классах

2013-03-22 в 6:01, admin, рубрики: big data, cache, dbms cache, index, intersystems cache, performance, Блог компании InterSystems, высокая производительность, субд Caché, метки: big data, cache, dbms cache, index, InterSystems cache, performance, субд CachéПредположим, что у вас есть таблица с большим количеством записей и в неё нужно добавить один или несколько индексов со следующими условиями:

- их генерация должна быть максимально быстрой

- чтобы генерацию можно было производить порциями.

К примеру, если есть таблица на 300М записей и работы с ней можно производить только в нерабочее время, то чтобы можно было разбить весь процесс на три ночи по 100М записей - появление новых индексов и сам процесс их генерации не должны мешать текущей работе с классом/таблицей

Для этого можно было бы воспользоваться уже известным методом %BuildIndices(), но в таком случае это не будет удовлетворять нашим условиям.

Каков же выход?

Читать полностью »

Диалоги о Big Data

2013-03-21 в 14:04, admin, рубрики: big data, болтология, Чулан, метки: big data, болтология-Привет!

-Здоров. Как ты? Жив?

-Держусь. Можно даже сказать, что бодр и весел. Ну что, будем делать заказ? Какие нынче предпочтенья – дорада на гриле или «Биф фингер мит»?

-Даже не знаю. Скорее второе. А как продвигаются дела на фронте продажи решений в сфере ИТ? Успеваете подвозить «железо» на склад? Или уже образовался дефицит, и приходиться давать не больше двух в одни руки?

-Практически. Скоро будем работать в две смены – с утра продаем, вечером грузим (смеется). Был на форуме «Big Data 2013», который проводили «Открытые системы»?

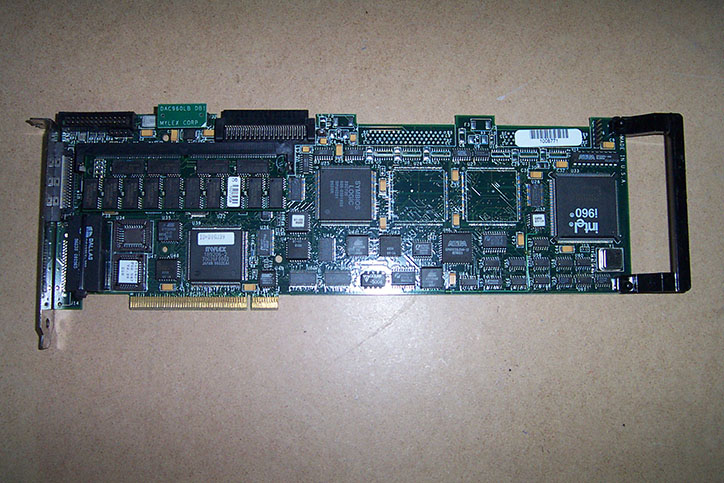

Живучий SCSI

2013-03-20 в 14:47, admin, рубрики: big data, LSI, SCSI, История ИТ, ит-инфраструктура, метки: LSI, SCSI, история ITРаз уж мы начали рассматривать историю хранения данных — познакомимся поближе с одной из технологий, которую мы в прошлой статье упомянули только вскользь. Удивительно в этой технологии то, что, появившись в самом начале 80-х, она с разными изменениями дожила до современности, и не собирается уступать позиции. Речь пойдет о SCSI.

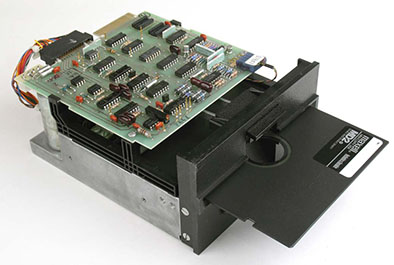

«Отцами-основателями» SCSI можно считать компанию Shugart Associates, стандарт из которого родился впоследствии SCSI изначально носил слегка неблагозвучное для русского уха название SASI (Shugart Associates System Interface). Компания эта, ныне не так широко известная, в конце 70-х практически доминировала на рынке дисководов, и именно эта компания предложила популярный формат 5¼ дюймов. Контроллеры SASI обычно были размером в половину диска и подключались 50-пиновым плоским кабелем, который впоследствии стал коннектором SCSI-1.

За переименованием стандарта стоял ANSI, к 1982 году разработавший стандарт этого интерфейса. Дело в том, что политика ANSI не разрешает использовать названия компаний названии стандартов, поэтому SASI был переименован в «Small Computer System Interface», что и дало знакомую нам аббревиатуру. «Отец» стандарта Ларри Бушер (Larry Boucher) хотел, чтоб эта аббревиатура читалась как «сэкси», но прочтение от Дал Аллана (Dal Allan) «сказзи» прижилось больше.

Несмотря на то, что в основном SCSI ассоциируется с жесткими дисками, этот стандарт позволяет создавать практически любые устройства, подключаемые по данному интерфейсу. Со SCSI выпускалась масса устройств: жесткие диски, магнитооптические накопители, CD и DVD приводы, стриммеры, принтеры и даже сканеры (LPT порт был слишком медленным для работы цветных сканеров высокого разрешения).

Несмотря на то, что в большинстве «простых компьютеров» SCSI как интерфейс не встречается, набор команд этого стандарта широко используется. Например, набор команд SCSI программно реализован в едином стеке Windows для поддержки устройств хранения данных. Так же, практически стандартом стала реализация команд SCSI поверх IDA/ATA и SATA интерфейсов, используемых для работы с CD/DVD и BlueRay, названная ATAPI. Так же эта система команд, реализованная поверх USB, стала частью стандарта Mass Storage Device, что позволяет использовать любые внешние USB хранилища данных.

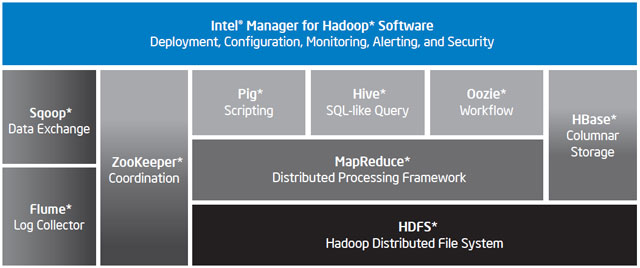

Intel Distribution for Apache Hadoop: чтобы «большим данным» было комфортно

2013-03-15 в 9:30, admin, рубрики: apache hadoop, big data, Блог компании Intel, Облачные вычисления, метки: apache hadoop

Хабражителям, интересующимся «большими данными», наверное, не имеет смысла рассказывать о проекте Apache Hadoop. В последнее время этот фреймворк стал особенным популярным и часто упоминаемым на Хабре – так, совсем недавно специалисты Mail.ru рассказали о миграции своей поисковой машины на Hadoop.

А как сделать хорошую программную систему еще лучше? Например, добавить в нее аппаратные компоненты. Именно таким путем пошла компания Intel, выпустив Intel Distribution for Apache Hadoop – «локализацию» Hadoop под платформу Intel Xeon, снабженную многими полезными функциями для облегчения ее управления и эксплуатации.

Читать полностью »

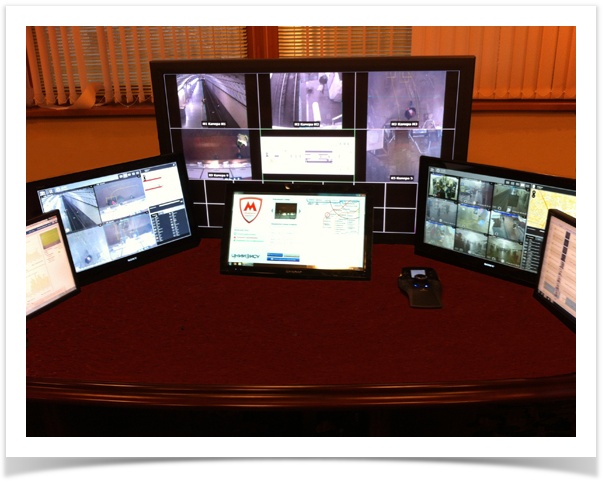

Видеоаналитика для общественного транспорта: Big Data — подводная часть айсберга

2013-03-14 в 7:58, admin, рубрики: big data, Блог компании Синезис, видеоаналитика, Синезис, метки: видеоаналитика, СинезисИнтеллектуализация видеонаблюдения на транспорте – одно из самых перспективных направлений отрасли ввиду масштабного строительства общественной инфраструктуры. Так, только в Москве планируется переоснастить 188 существующие станции метро, построить 64 новые подземные станции, 31 наземную станцию на Малом кольце железной дороги и 5 линий скоростного трамвая с оплатной проезда на станции. Каждая подземная станция будет содержать не менее 50 камер, на которых будет работать ситуационная и биометрическая видеоаналитика, оптимизированная для мест массового скопления людей.

Важно, что внедрение технических средств интеллектуального видеонаблюдения является обязательным на уровне федерального закона о транспортной безопасности, распоряжений Правительства РФ об утверждении Комплексной программы обеспечения безопасности населения на транспорте и приказов Минтраса об утверждении требований по обеспечению транспортной безопасности категорированных объектов (подробнее о нормативной базе на транспорте).

Читать полностью »

Суперкомпьютер своими руками

2013-02-22 в 11:30, admin, рубрики: big data, nvidia tesla, supermicro, xeon, высокая производительность, Железо, серверы, суперкомпьютер, метки: nvidia tesla, supermicro, xeon, серверы, суперкомпьютерНа сегодняшний день возможно построение домашнего суперкомпьютера, о чем и пойдет речь.

В статье рассмотрены способы аппаратного построения высокопроизводительных вычислительных комплексов. Одно из интересных применений – криптография. Например, благодаря современным технологиям, любому стал доступен взлом MD5 или WPA. Если постараться (информацию быстро выпиливают), в Интернете можно найти способ взлома алгоритма A5/2, используемого в GSM. Другое применение – инженерные, финансовые, медицинские расчеты, биткойнмайнинг.

Читать полностью »

NoSQL и Big Data – обман трудящихся?

2013-02-19 в 10:50, admin, рубрики: big data, cassandra, cloud, cloud computing, cloud hosting, leveldb, mariadb, mysql, nosql, paas, platform as a service, sql, twitter, Блог компании Jelastic, метки: big data, cassandra, cloud, cloud computing, cloud hosting, leveldb, mariadb, mysql, nosql, paas, platform as a service, sql, twitter  Недавно нам удалось пообщаться с великим Монти — Майклом Видениусом, автором оригинальной версии открытой СУБД MySQL, который в настоящее время работает над ее ответвлением, MariaDB. (Кстати, обе эти базы поддерживаются в Jelastic.)

Недавно нам удалось пообщаться с великим Монти — Майклом Видениусом, автором оригинальной версии открытой СУБД MySQL, который в настоящее время работает над ее ответвлением, MariaDB. (Кстати, обе эти базы поддерживаются в Jelastic.)

Как известно, мир производит и обрабатывает все больше данных (так называемый феномен «Big Data»). Общепринято мнение, что данных теперь так много, что обрабатывать их с помощью традиционных баз данных и программных методов трудно или невозможно. Это вызвало волну нереляционных баз данных (NoSQL), в которых упор делается на высокую масштабируемость. Эксперт в области баз данных, Монти, поделился с нами своими мыслями о текущем и будущем состоянии SQL, NoSQL и Big Data. Некоторые его ответы были несколько неожиданными, так что мы с радостью приводим здесь русский перевод расшифровки нашей беседы:Читать полностью »

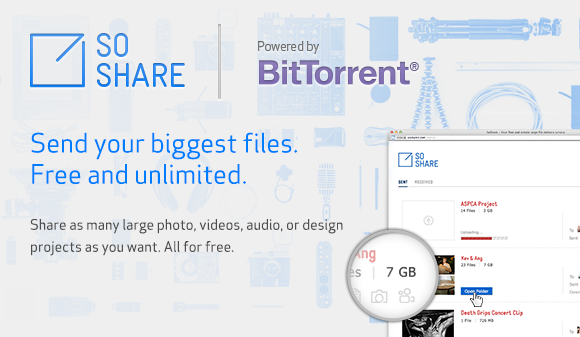

SoShare — 1 терабайт бесплатно от BitTorrent

2013-02-16 в 23:44, admin, рубрики: big data, bittorrent, cloud storage, Peer-to-Peer, Облачные вычисления, метки: bittorrent, cloud storageВ пятницу BitTorrent анонсировал старт публичной беты SoShare, сервиса, который переплюнет сервисы, подобные YouSendIt, DropBox и другим, разрешая передавать до 1TB. Компания позиционирует сервис для использования людьми креативных профессий — дизайнерам, фотографами, музыкантами и так далее — теми, кто работает с большими объёмами данных, но испытывает сложности с пересылкой их друг другу из-за ограничений почтовых служб и сервисов синхронизации и пересылки.