Пути «романтики потребления” новых версий программного обеспечения у всех свои, но финал один – “Если работает, не трогай!”…

Читать полностью »

Пути «романтики потребления” новых версий программного обеспечения у всех свои, но финал один – “Если работает, не трогай!”…

Читать полностью »

Как часто бывает, сначала ты ищешь решение на рынке и, не найдя его, делаешь самостоятельно и под себя. А потом получается настолько хорошо, что ты отдаешь это другим. Так было и с OpenSOC, open source решением для управления большими объемами данных в области кибербезопасности, которое было разработано в Cisco для своих собственных нужд, а потом было выложено на GitHub для всеобщего доступа.

Пост будет о том, как сделать работу на Хадупе немного комфортнее.

В данной статье я хочу рассмотреть один из компонентов экосистемы Hadoop – HUE. Произносим правильно «Хьюи» или «Эйч Ю И», но не другими, созвучными с широко известным русским словом, вариантами.

Читать полностью »

Примечание переводчика:

Изначально статья задумывалась как вольный перевод текста Дона Дрейка (@dondrake) для Cloudera Engineering Blog об опыте сравнения Apache Avro и Apache Parquet при использовании Apache Spark. Однако в процессе перевода я углубился в детали и нашел в тестах массу спорных моментов. Я добавил к статье подзаголовок, а текст снабдил комментариями со злорадным указанием неточностей.

В последнее время в курилках часто возникали дискуссии на тему сравнения производительности различных форматов хранения данных в Apache Hadoop — включая CSV, JSON, Apache Avro и Apache Parquet. Большинство участников сразу отметают текстовые форматы как очевидных аутсайдеров, оставляя главную интригу состязанию между Avro и Parquet.

Господствующие мнения представляли собой неподтвержденные слухи о том, что один формат выглядит "лучше" при работе со всем датасетом, а второй "лучше" справляется с запросами к подмножеству столбцов.

Как любой уважающий себя инженер, я подумал, что было бы неплохо провести полноценные performance-тесты, чтобы наконец проверить, на чьей стороне правда. Результат сравнения — под катом.

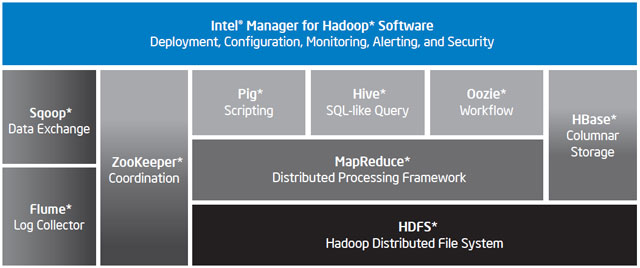

Хабражителям, интересующимся «большими данными», наверное, не имеет смысла рассказывать о проекте Apache Hadoop. В последнее время этот фреймворк стал особенным популярным и часто упоминаемым на Хабре – так, совсем недавно специалисты Mail.ru рассказали о миграции своей поисковой машины на Hadoop.

А как сделать хорошую программную систему еще лучше? Например, добавить в нее аппаратные компоненты. Именно таким путем пошла компания Intel, выпустив Intel Distribution for Apache Hadoop – «локализацию» Hadoop под платформу Intel Xeon, снабженную многими полезными функциями для облегчения ее управления и эксплуатации.

Читать полностью »

В данном руководстве описаны процедуры запроса, изучения и анализа данных Twitter с помощью служб на базе Apache Hadoop для Windows Azure, а также Hive-запрос в Excel. Социальные сети — это главный источник больших данных. Поэтому общедоступные API таких социальных медиа, как Twitter, служат источником полезной информации и помогают лучше понять сетевые тренды.

Руководство состоит из следующих разделов.

В 2010 году Apache Hadoop, MapReduce и ассоциированные с ними технологии привели к распространению нового явления в сфере информационных технологий, названного «большими данными» или «Big Data». Понимание того, что из себя представляет платформа Apache Hadoop, зачем она нужна и для чего её можно использовать потихоньку проникает в умы специалистов по всему миру. Зарожденный, как идея одного человека, и быстро выросший до промышленных масштабов, Apache Hadoop стал одной из самых широко обсуждаемых платформ для распределенных вычислений, а также платформой для хранения неструктурированной или слабо структурированной информации. В этой статье я хотел бы подробнее остановиться на самой платформе Apache Hadoop и рассмотреть коммерческие реализации, предоставляемые сторонними компаниями, и их отличия от свободно распространяемой версии Apache Hadoop.Читать полностью »